Hadoop2.X/YARN环境搭建--CentOS7.0系统配置

一、我缘何选择CentOS7.0

14年7月7日17:39:42发布了CentOS 7.0.1406正式版,我曾使用过多款Linux,对于Hadoop2.X/YARN的环境配置缘何选择CentOS7.0,其原因有:

1、界面采用RHEL7.0新的GNOME界面风,这可不是CentOS6.5/RHEL6.5所能比的!(当然,Fedora早就采用这种风格的了,但是现在的Fedora缺包已然不成样子了)

2、曾经,我也用了RHEL7.0,它最大的问题就是YUM没法用,而且总会有Warning提示注册购买!为此,必须去修改YUM源,还有修改其他的文件使之不提示才能用,看了这么麻烦,想必有很多童鞋滴心就已经凉了4/7了吧!

3、当然,Ubuntu系列我用过Ubuntu14.04/12.04和elementaryOS,不知为何,一用Ubuntu14.04就觉得好丑呀!!但是有很多人都说CentOS和RHEL更丑,但殊不知哪个才是企业级的,那个才是霸主。

另一方面,要求视觉效果的话,建议去装个elementaryOS试试,当然,elementaryOS也有缺陷:它已经许久没有提供更新了,12年推出的,已逾2年未曾发布新版本的系统,也未曾更新网站,与此同时,elementaryOS的模型Ubuntu早就更新换代了,所以,暴露了不少问题,其中麻烦的是不要随意更新系统,否则黑屏,那就真的纯命令行了,漂亮的系统突然被打回原型,那心铁定疤凉疤凉的,而且它更新后的apt-get是无法安装某些匹配某些,所以elementaryOS只供欣赏把玩!

4、也有人用过openSUSE,据说是最华丽的系统,在我看来,花哨的KDE打开文件/软件时显示的一跳一跳的,我心里就痒痒的,没事儿你弄个没用又难看的东东干嘛??干嘛??另外,最新的openSUSE对中文的设计的确无法令人满意。另外,就是openSUSE的环境不怎么熟悉,欧洲人设计的GNU/Linux还有些难适应,当然,我也不打算改旗易帜向欧洲SUSE倒戈。

其实,GNU/Linux版本众多,选择一个适合自己的一款一直玩下去、用下去就足够了,Linux版本众多,设计各有千秋,但使用大同小异,了解“异”点即可!当然,还是奉劝一句:初学者仅仅跑跑虚拟机看看效果就好,莫要将每款都用会了!毕竟,体验也是学习的动力之一!

二、体验CentOS7与之前版本的“异”

初次启动

装完机后,开机进系统的界面换了,乍一看以为是两个内核,原来有一个是rescue选择,而且按e后,会发现所有的grub.conf的信息全出来了,好不容易找到内核启动的地方,写了个 1(要进单用户模式),然后进了rescue模式。

字符界面

进系统后,是图形界面,想进字符界面,结果找到/etc/inittab,发现几乎是个空文件,文件中提示想改runlevel的话,可以把/lib/systemd/system/runlevel*.target 软连到 /etc/systemd/system/default.target下(当然考过来,覆盖也行),试了一下还行,能改到字符界面runlevel3。

配置网络和主机名

然后,想配置网络,进/etc/sysconfig/network-script/一看,我靠,网卡改名了enp1s5,好有趣,配置完网络后改主机名, 到/etc/sysconfig/network去改名字,发现这个文件也是空的,按原6版本的去修改,重启后没效果,man了一下hostname, 发现7中改名要到/etc/hostname去改名字。

本地yum源和挂载

接着,想配置一个本地yum源,配上后要挂光盘,手动挂上了,然后直接echo“mount ......”到rc.local中,毕竟是启动执行脚本,重启之后竟然没挂上,进去rc.local中看了一下,7中竟然要手动的把chmod +x rc.local, 是的,要手动加执行权限,难道我之前装的6以前的系统中这个都要手动加执行权限,我不记得啊!!!! 当然,加了权限后,开机后启动执行了rc.local的mount命令。

LVM和xfs

后来,想着装一个lvm玩玩,于是啊就分区,格式化(特意格式化为了xfs),pv,vg,lv一步一步,都没问题,然后想着放大,缩小,这时出问题了,执行resize2fs时,怎么一直报superblock什么的出错,这是怎么回事,然后man resize2fs一下,发现这命令只支持ext的文件系统,我艹,那我装系统是怎么是lvm的,这个问题我还没解决,应该有解决方法。

dhcp和服务

接着,想着装一个dhcp玩玩,惊奇的发现所有dhcp的包装上之后,不能service dhcpd start,然后发现/etc/init.d/中竟然没一个dhcp类似的东西,毕竟6之前有dhcpd,dhcpd6,dhcrelay的,然后发现 /sbin/dhcpd有启动文件,难道,难道,以后的服务想service启,都要手动自己编?错了,是在/usr/lib/systemd/system/dhcpd.service,还要修改好多,然后加权限,执行service 服务 restart/stop。。。。。。可以,但是指向了systemctl restart/start/stop 服务.service

iptables

又发现iptables这次也不是作为一个服务在/etc/init.d/下面了,/sbin下有;

防火墙由iptables更换成了firewalld

三、系统配置之关闭防火墙

systemctl stop firewalld.service #停止firewall

systemctl disable firewalld.service #禁止firewall开机启动

systemctl命令的基本操作格式是:

systemctl 动作 服务名.service动作:start,stop,restart,status,enable,disable,is-enabled

四、配置Linux网络

1、修改hostname

CentOS 7.0的hostname在/etc/hostname中用root用户修改:

[root@hadoop1 ~]# vim /etc/hostname #编辑/etc/hostname[root@hadoop1 ~]# cat /etc/hostname #查看/etc/hostnamehadoop1[root@hadoop1 ~]#

以前版本的CentOS在/etc/sysconfig/network中用root用户修改:

[root@hadoop1 ~]# vim /etcsysconfig/network

"/etc/sysconfig/network"的设定项目如下:

NETWORKING 是否利用网络GATEWAY 默认网关与接下来配置IP的属性文件中默认网关一致IPGATEWAYDEV 默认网关的接口名HOSTNAME 主机名DOMAIN 域名

reboot后hostname生效

2、修改当前机器的IP

Step1:进入配置文件目录

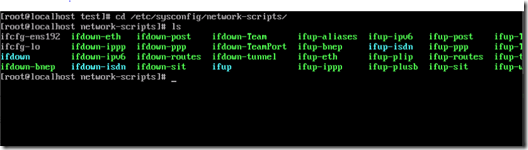

现在已经是root权限了,我们cd到网络配置文件的目录,并列出目录下的文件。

Step2:修改配置文件

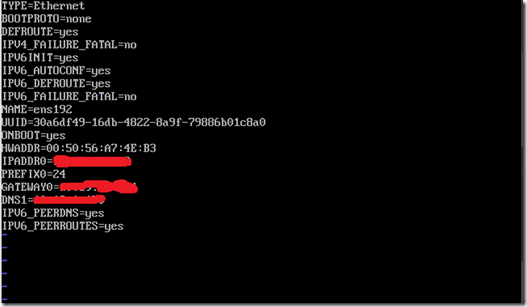

该目录下,文件名“ifcfg-ens192”文件就是网络配置的主文件。vi它!

修改或添加一下:

ONBOOT=yes BOOTPROTO=static IPADDR=IP地址 NETMASK=255.255.255.0 #子网掩码 GATEWAY=192.168.30.1 #网关地址

Step3:重启网络服务

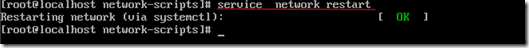

修改完配置文件后,:wq!保存退出!然后重启网络。

Step4:测试

通过ifconfig命令查看ip是否设置成功,然后ping一下网络。这个时候应该成功了!

3、修改DNS(看情况,非必选)

若网络环境有DNS要求,则配置,否则,勿配!

格式:

nameserver DNS地址

[root@hadoop1 ~]# vi /etc/resolv.conf nameserver 202.131.80.1 #依需求而定 nameserver 202.131.80.5 #依需求而定

4、配置hosts文件

"/etc/hosts"这个文件是用来配置主机将用的DNS服务器信息,是记载LAN内接续的各主机的对应[HostName和IP]用的。当用户在进行网络连接时,首先查找该文件,寻找对应主机名(或域名)对应的IP地址。

我们要测试两台机器之间知否连通,一般用"ping 机器的IP",如果想用"ping 机器的主机名"发现找不见该名称的机器,解决的办法就是修改"/etc/hosts"这个文件,通过把LAN内的各主机的IP地址和HostName的一一对应写入这个文件的时候,就可以解决问题。

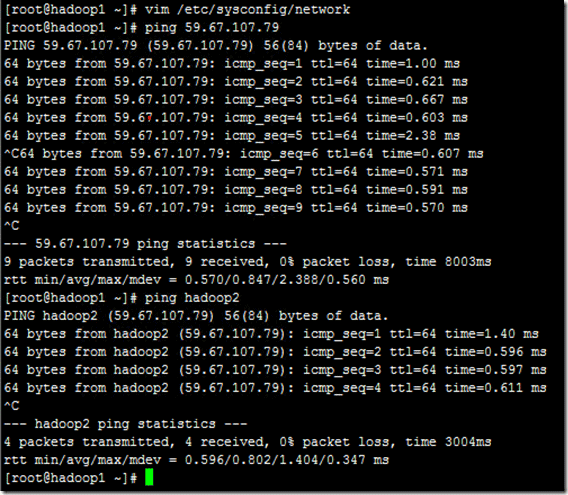

例如:机器为"hadoop1:59.67.107.80"对机器为"hadoop2:59.67.107.79"用命令"ping"记性连接测试。测试结果如下:

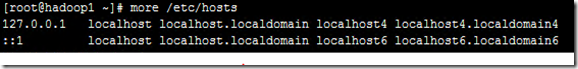

从上图中的值,直接对IP地址进行测试,能够ping通,但是对主机名进行测试,若没有ping通,提示"unknown host——未知主机",这时查看"hadoop1"的"/etc/hosts"文件内容。

若ping hadoop1不通则显示:

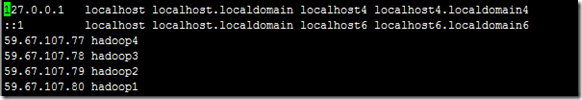

若ping hadoop1通则显示:

若发现里面没有"59.67.107.79 hadoop2"内容,故而本机器是无法对机器的主机名为"hadoop2" 解析。

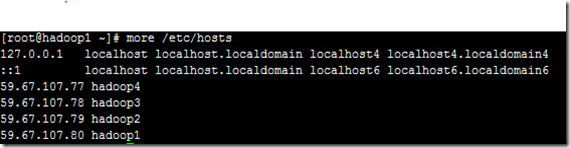

在进行Hadoop集群配置中,需要在"/etc/hosts"文件中添加集群中所有机器的IP与主机名,这样Master与所有的Slave机器之间不仅可以通过IP进行通信,而且还可以通过主机名进行通信。所以在所有的机器上的"/etc/hosts"文件末尾中都要添加如下内容:

因为本文以已经配置好的环境说明,所以我的/etc/hosts显示:

一般处于内网下,照此添加(192.168.1.1为网关):

192.168.1.2 hadoop1 192.168.1.3 hadoop2 192.168.1.4 hadoop3 192.168.1.5 hadoop4

用以下命令进行添加:

vim /etc/hosts

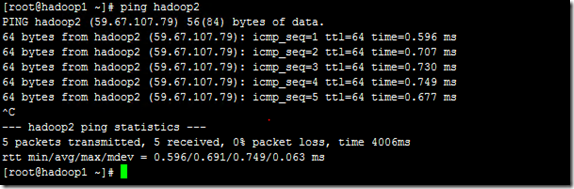

现在我们在进行对机器为"hadoop2"的主机名进行ping通测试,看是否能测试成功。

从上图中我们已经能用主机名进行ping通了,说明我们刚才添加的内容,在局域网内能进行DNS解析了,那么现在剩下的事儿就是在其余的Slave机器上进行相同的配置。然后进行测试。