Pytorch 如何训练网络时调整学习率

为了得到更好的网络,学习率通常是要调整的,即刚开始用较大的学习率来加快网络的训练,之后为了提高精确度,需要将学习率调低一点。

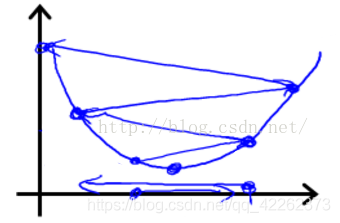

如图所示,步长(学习率)太大容易跨过最优解。

代码如下:

表示每20个epoch学习率调整为之前的10%

optimizer = optim.SGD(gan.parameters(),

lr=0.1,

momentum=0.9,

weight_decay=0.0005)

lr = optimizer.param_groups[0]['lr'] * (0.1 ** (epoch // 20))

for param_group in optimizer.param_groups:

param_group['lr'] = lr

print(optimizer.param_groups[0]['lr'])

补充:Pytorch 在训练过程中实现学习率衰减

在网络的训练过程中,学习率是一个非常重要的超参数,它直接影响了网络的训练效果。

但过大的学习率将会导致网络无法达到局部最小点,使得训练结果震荡,准确率无法提升,而过小的学习率将会导致拟合速度过慢,浪费大量的时间和算力。

因此我们希望在训练之初能够有较大的学习率加快拟合的速率,之后降低学习率,使得网络能够更好的达到局部最小,提高网络的效率。

torch.optim.lr_scheduler.LambdaLR()

torch.optim.lr_scheduler.LambdaLR(optimizer, lr_lambda, last_epoch=-1)

其中optimizer就是包装好的优化器, lr_lambda即为操作学习率的函数。

将每个参数组的学习速率设置为初始的lr乘以一个给定的函数。

当last_epoch=-1时,将初始lr设置为lr。

torch.optim.lr_scheduler.StepLR()

torch.optim.lr_scheduler.StepLR(optimizer, step_size, gamma=0.1, last_epoch=-1)

其中optimizer就是包装好的优化器,step_size (int) 为学习率衰减期,指几个epoch衰减一次。gamma为学习率衰减的乘积因子。 默认为0.1 。当last_epoch=-1时,将初始lr设置为lr。

以上为个人经验,希望能给大家一个参考,也希望大家多多支持我们。

相关推荐

-

pytorch 实现模型不同层设置不同的学习率方式

在目标检测的模型训练中, 我们通常都会有一个特征提取网络backbone, 例如YOLO使用的darknet SSD使用的VGG-16. 为了达到比较好的训练效果, 往往会加载预训练的backbone模型参数, 然后在此基础上训练检测网络, 并对backbone进行微调, 这时候就需要为backbone设置一个较小的lr. class net(torch.nn.Module): def __init__(self): super(net, self).__init__() # backbone

-

在pytorch中动态调整优化器的学习率方式

在深度学习中,经常需要动态调整学习率,以达到更好地训练效果,本文纪录在pytorch中的实现方法,其优化器实例为SGD优化器,其他如Adam优化器同样适用. 一般来说,在以SGD优化器作为基本优化器,然后根据epoch实现学习率指数下降,代码如下: step = [10,20,30,40] base_lr = 1e-4 sgd_opt = torch.optim.SGD(model.parameters(), lr=base_lr, nesterov=True, momentum=0.9) de

-

pytorch 优化器(optim)不同参数组,不同学习率设置的操作

optim 的基本使用 for do: 1. 计算loss 2. 清空梯度 3. 反传梯度 4. 更新参数 optim的完整流程 cifiron = nn.MSELoss() optimiter = torch.optim.SGD(net.parameters(),lr=0.01,momentum=0.9) for i in range(iters): out = net(inputs) loss = cifiron(out,label) optimiter.zero_grad() # 清空之前

-

pytorch实现查看当前学习率

在pytorch训练过程中可以通过下面这一句代码来打印当前学习率 print(net.optimizer.state_dict()['param_groups'][0]['lr']) 补充知识:Pytorch:代码实现不同层设置不同的学习率,选择性学习某些层参数 1,如何动态调整学习率 在使用pytorch进行模型训练时,经常需要随着训练的进行逐渐降低学习率,在pytorch中给出了非常方面的方法: 假设我们定义了一个优化器: import torch import torch.nn as nn

-

Pytorch 如何训练网络时调整学习率

为了得到更好的网络,学习率通常是要调整的,即刚开始用较大的学习率来加快网络的训练,之后为了提高精确度,需要将学习率调低一点. 如图所示,步长(学习率)太大容易跨过最优解. 代码如下: 表示每20个epoch学习率调整为之前的10% optimizer = optim.SGD(gan.parameters(), lr=0.1, momentum=0.9, weight_decay=0.0005) lr = optimizer.param_groups[0]['lr'] * (0.1 ** (epo

-

详解利用Pytorch实现ResNet网络

目录 正文 评估模型 训练 ResNet50 模型 正文 每个 batch 前清空梯度,否则会将不同 batch 的梯度累加在一块,导致模型参数错误. 然后我们将输入和目标张量都移动到所需的设备上,并将模型的梯度设置为零.我们调用model(inputs)来计算模型的输出,并使用损失函数(在此处为交叉熵)来计算输出和目标之间的误差.然后我们通过调用loss.backward()来计算梯度,最后调用optimizer.step()来更新模型的参数. 在训练过程中,我们还计算了准确率和平均损失.我们

-

加速 PyTorch 模型训练的 9 个技巧(收藏)

目录 Pytorch-Lightning 1.DataLoaders 2.DataLoaders中的workers的数量 3.Batchsize 4.梯度累加 5.保留的计算图 6.单个GPU训练 7.16-bit精度 8.移动到多个GPUs中 9.多节点GPU训练 10.福利!在单个节点上多GPU更快的训练 对模型加速的思考 让我们面对现实吧,你的模型可能还停留在石器时代.我敢打赌你仍然使用32位精度或GASP甚至只在一个GPU上训练. 我明白,网上都是各种神经网络加速指南,但是一个check

-

Pytorch自定义CNN网络实现猫狗分类详解过程

目录 前言 一. 数据预处理 二. 定义网络 三. 训练模型 前言 数据集下载地址: 链接: https://pan.baidu.com/s/17aglKyKFvMvcug0xrOqJdQ?pwd=6i7m Dogs vs. Cats(猫狗大战)来源Kaggle上的一个竞赛题,任务为给定一个数据集,设计一种算法中的猫狗图片进行判别. 数据集包括25000张带标签的训练集图片,猫和狗各125000张,标签都是以cat or dog命名的.图像为RGB格式jpg图片,size不一样.截图如下: 一.

-

详解PyTorch批训练及优化器比较

一.PyTorch批训练 1. 概述 PyTorch提供了一种将数据包装起来进行批训练的工具--DataLoader.使用的时候,只需要将我们的数据首先转换为torch的tensor形式,再转换成torch可以识别的Dataset格式,然后将Dataset放入DataLoader中就可以啦. import torch import torch.utils.data as Data torch.manual_seed(1) # 设定随机数种子 BATCH_SIZE = 5 x = torch.li

-

解决Pytorch修改预训练模型时遇到key不匹配的情况

一.Pytorch修改预训练模型时遇到key不匹配 最近想着修改网络的预训练模型vgg.pth,但是发现当我加载预训练模型权重到新建的模型并保存之后. 在我使用新赋值的网络模型时出现了key不匹配的问题 #加载后保存(未修改网络) base_weights = torch.load(args.save_folder + args.basenet) ssd_net.vgg.load_state_dict(base_weights) torch.save(ssd_net.state_dict(),

-

pytorch 预训练层的使用方法

pytorch 预训练层的使用方法 将其他地方训练好的网络,用到新的网络里面 加载预训练网络 1.原先已经训练好一个网络 AutoEncoder_FC() 2.首先加载该网络,读取其存储的参数 3.设置一个参数集 cnnpre = AutoEncoder_FC() cnnpre.load_state_dict(torch.load('autoencoder_FC.pkl')['state_dict']) cnnpre_dict =cnnpre.state_dict() 加载新网络 1.设置新的网

-

pytorch 实现查看网络中的参数

可以通过model.state_dict()或者model.named_parameters()函数查看现在的全部可训练参数(包括通过继承得到的父类中的参数) 可示例代码如下: params = list(model.named_parameters()) (name, param) = params[28] print(name) print(param.grad) print('-------------------------------------------------') (name

-

pytorch教程之网络的构建流程笔记

目录 构建网络 定义一个网络 loss Function Backprop 更新权值 参考网址 构建网络 我们可以通过torch.nn包来构建网络,现在你已经看过了autograd,nn在autograd的基础上定义模型和求微分.一个nn.Module包括很多层,forward方法返回output. 一个典型的训练过程包括这么几步: 1.定义一个网络结构包含一些可训练的额参数 2.为数据集制定输入iterata 3.通过网络计算Output 4.计算loss 5.反向传播计算梯度 6.更新权值

-

Android中检查网络连接状态的变化无网络时跳转到设置界面

在AndroidManifest.xml中加一个权限 <uses-permission android:name="android.permission.ACCESS_NETWORK_STATE" /> <intent-filter> <action android:name="android.net.conn.CONNECTIVITY_CHANGE" /> </intent-filter> 主代码中实现: @Over

随机推荐

- Angular.js实现多个checkbox只能选择一个的方法示例

- 详解iOS App中UISwitch开关组件的基本创建及使用方法

- Erlang的一些编程技巧分享

- 基于JS代码实现实时显示系统时间

- 原生 JS Ajax,GET和POST 请求实例代码

- java synchronized同步静态方法和同步非静态方法的异同

- 让你的PHP7更快之Hugepage用法分析

- PHP异常处理Exception类

- PHP中文件缓存转内存缓存的方法

- 如何以及何时使用sIFR

- IE中JS跳转丢失referrer问题的2个解决方法

- C#基于COM方式读取Excel表格的方法

- 解析php DOMElement 操作xml 文档的实现代码

- Android自定义View实现圆环交替效果

- 搞笑50句

- 微信小程序通过api接口将json数据展现到小程序示例

- Redis安装教程图解

- JS图片预加载 JS实现图片预加载应用

- 图解Java线程的生命周期

- Spring Boot高级教程之使用Redis实现session共享