pytorch 实现在测试的时候启用dropout

我们知道,dropout一般都在训练的时候使用,那么测试的时候如何也开启dropout呢?

在pytorch中,网络有train和eval两种模式,在train模式下,dropout和batch normalization会生效,而val模式下,dropout不生效,bn固定参数。

想要在测试的时候使用dropout,可以把dropout单独设为train模式,这里可以使用apply函数:

def apply_dropout(m):

if type(m) == nn.Dropout:

m.train()

下面是完整demo代码:

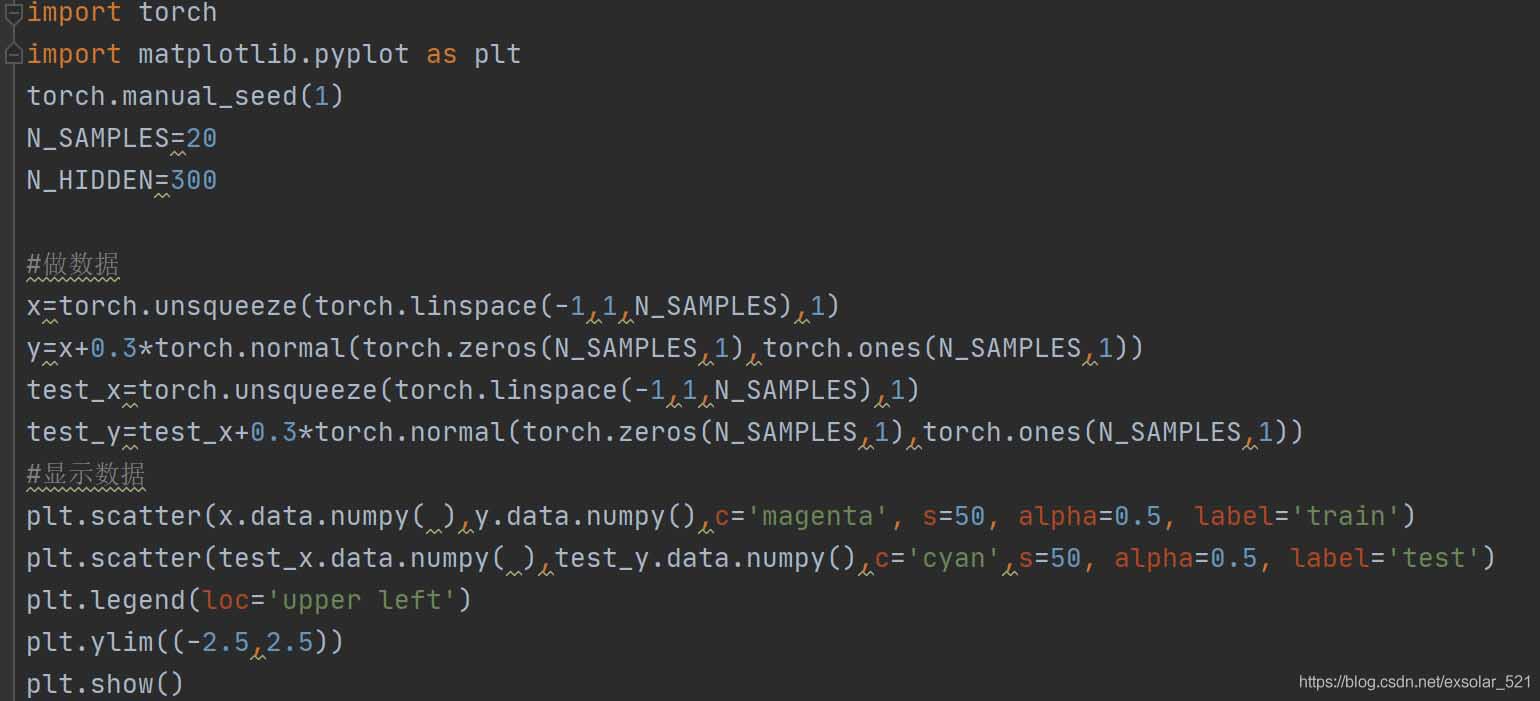

# coding: utf-8

import torch

import torch.nn as nn

import numpy as np

class SimpleNet(nn.Module):

def __init__(self):

super(SimpleNet, self).__init__()

self.fc = nn.Linear(8, 8)

self.dropout = nn.Dropout(0.5)

def forward(self, x):

x = self.fc(x)

x = self.dropout(x)

return x

net = SimpleNet()

x = torch.FloatTensor([1]*8)

net.train()

y = net(x)

print('train mode result: ', y)

net.eval()

y = net(x)

print('eval mode result: ', y)

net.eval()

y = net(x)

print('eval2 mode result: ', y)

def apply_dropout(m):

if type(m) == nn.Dropout:

m.train()

net.eval()

net.apply(apply_dropout)

y = net(x)

print('apply eval result:', y)

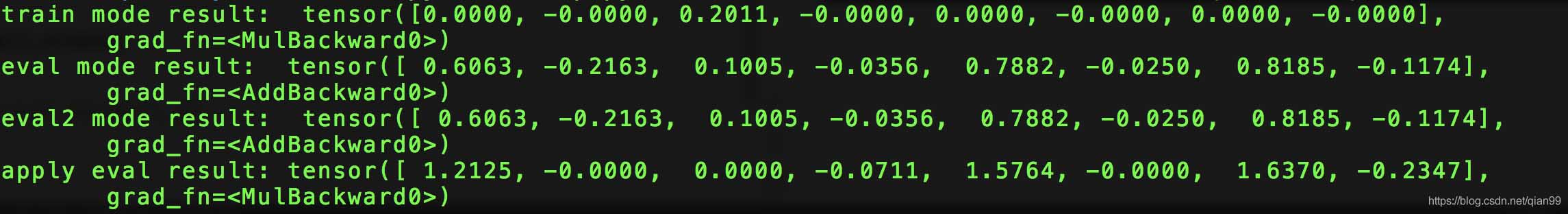

运行结果:

可以看到,在eval模式下,由于dropout未生效,每次跑的结果不同,利用apply函数,将Dropout单独设为train模式,dropout就生效了。

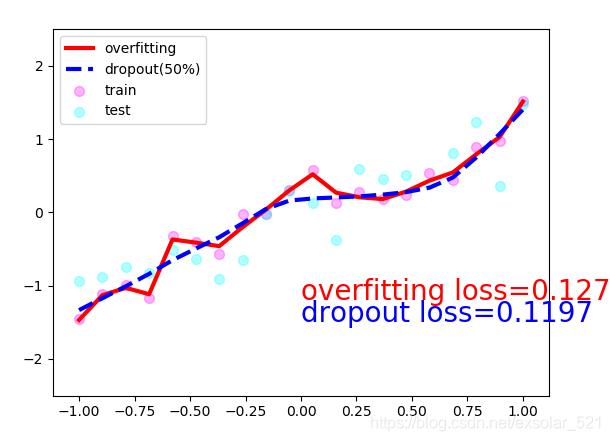

补充:Pytorch之dropout避免过拟合测试

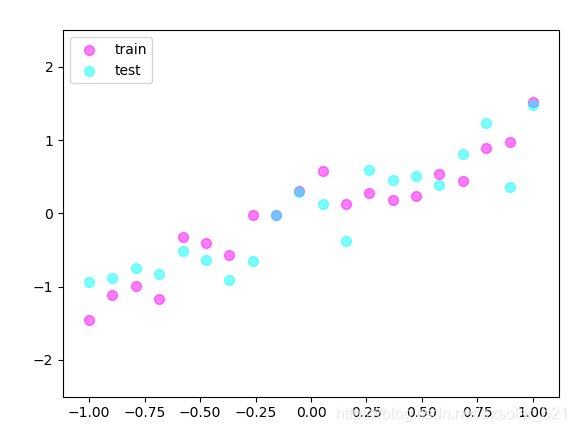

一.做数据

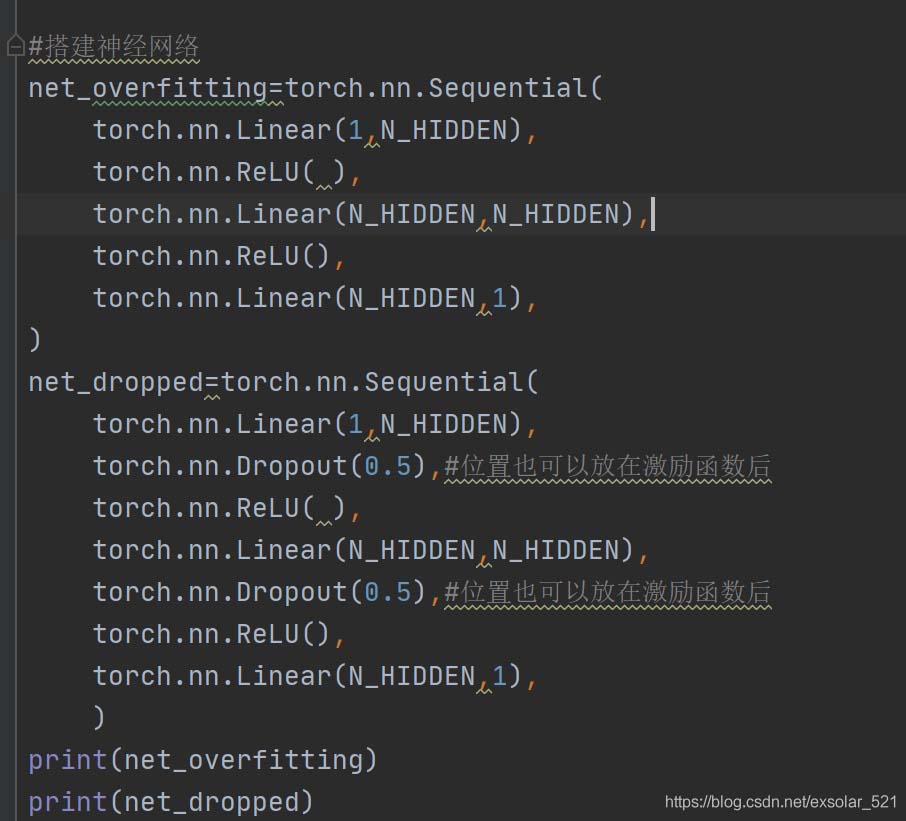

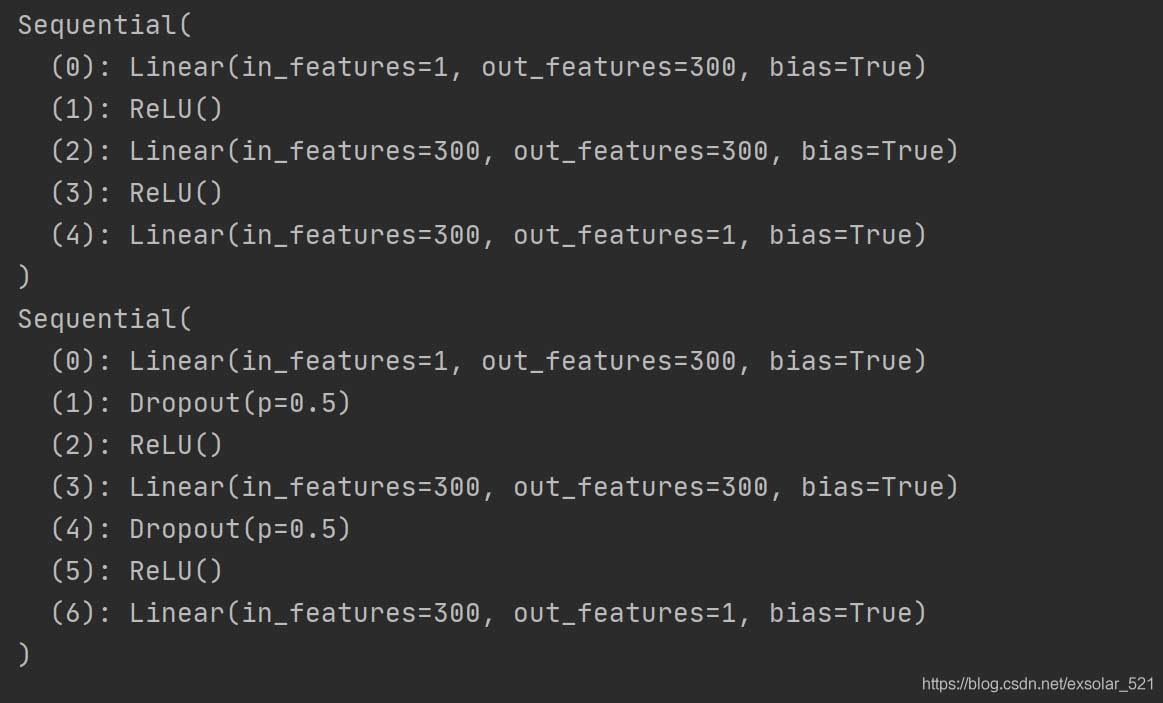

二.搭建神经网络

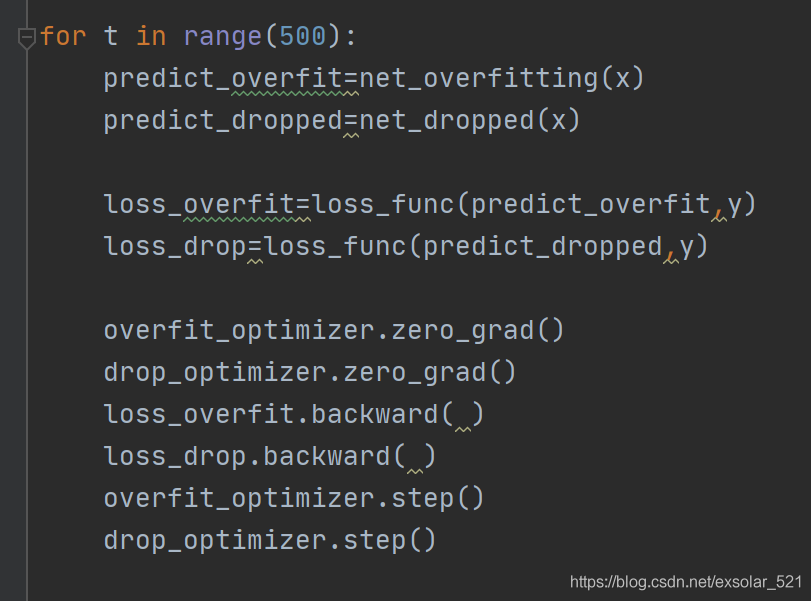

三.训练

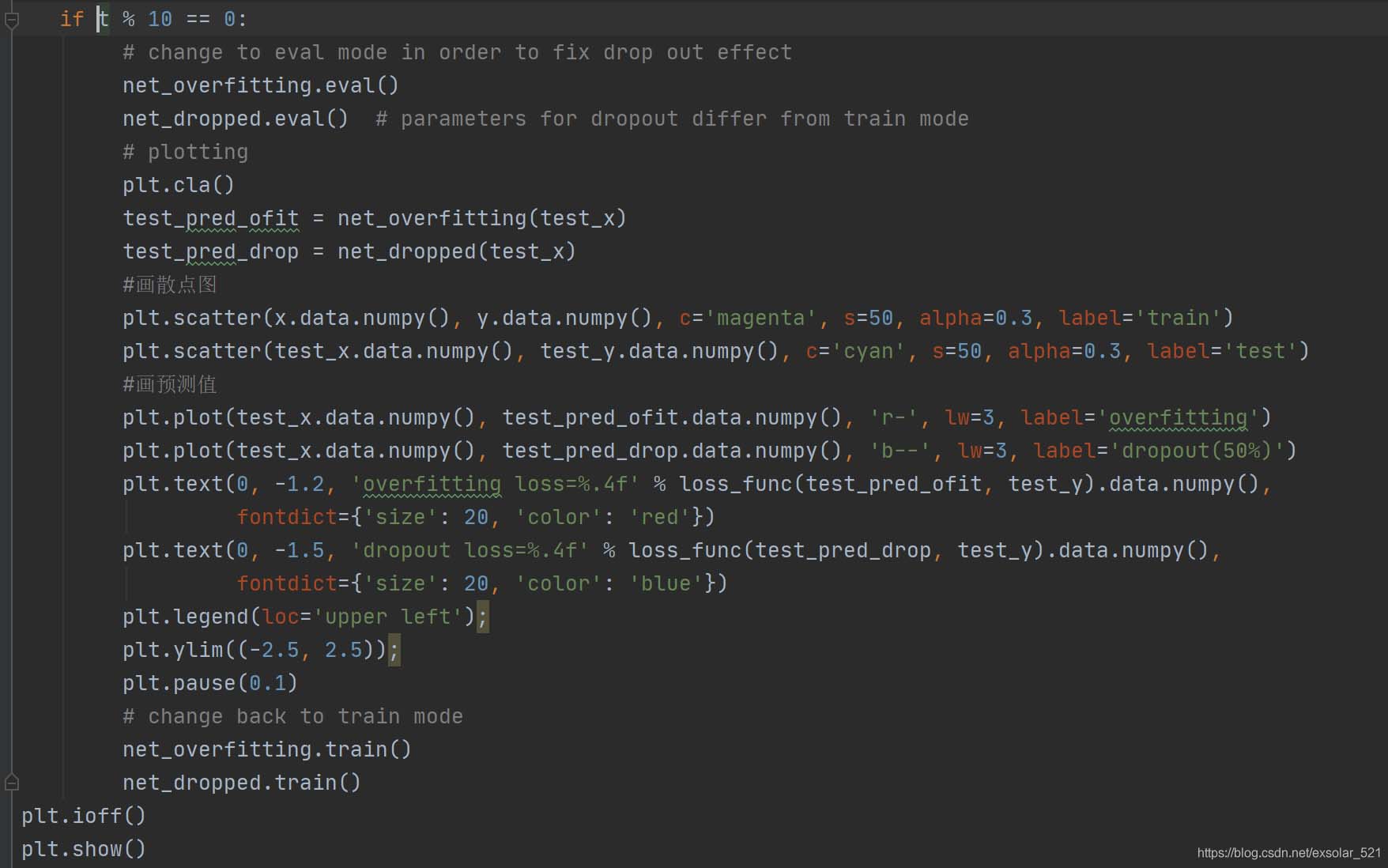

四.对比测试结果

注意:测试过程中,一定要注意模式切换

以上为个人经验,希望能给大家一个参考,也希望大家多多支持我们。

相关推荐

-

解决Pytorch中的神坑:关于model.eval的问题

有时候使用Pytorch训练完模型,在测试数据上面得到的结果令人大跌眼镜. 这个时候需要检查一下定义的Model类中有没有 BN 或 Dropout 层,如果有任何一个存在 那么在测试之前需要加入一行代码: #model是实例化的模型对象 model = model.eval() 表示将模型转变为evaluation(测试)模式,这样就可以排除BN和Dropout对测试的干扰. 因为BN和Dropout在训练和测试时是不同的: 对于BN,训练时通常采用mini-batch,所以每一批中的mean

-

聊聊pytorch测试的时候为何要加上model.eval()

Do need to use model.eval() when I test? Sure, Dropout works as a regularization for preventing overfitting during training. It randomly zeros the elements of inputs in Dropout layer on forward call. It should be disabled during testing since you may

-

pytorch 中nn.Dropout的使用说明

看代码吧~ Class USeDropout(nn.Module): def __init__(self): super(DropoutFC, self).__init__() self.fc = nn.Linear(100,20) self.dropout = nn.Dropout(p=0.5) def forward(self, input): out = self.fc(input) out = self.dropout(out) return out Net = USeDropout()

-

pytorch 实现在测试的时候启用dropout

我们知道,dropout一般都在训练的时候使用,那么测试的时候如何也开启dropout呢? 在pytorch中,网络有train和eval两种模式,在train模式下,dropout和batch normalization会生效,而val模式下,dropout不生效,bn固定参数. 想要在测试的时候使用dropout,可以把dropout单独设为train模式,这里可以使用apply函数: def apply_dropout(m): if type(m) == nn.Dropout: m.tra

-

解决Pytorch 训练与测试时爆显存(out of memory)的问题

Pytorch 训练时有时候会因为加载的东西过多而爆显存,有些时候这种情况还可以使用cuda的清理技术进行修整,当然如果模型实在太大,那也没办法. 使用torch.cuda.empty_cache()删除一些不需要的变量代码示例如下: try: output = model(input) except RuntimeError as exception: if "out of memory" in str(exception): print("WARNING: out of

-

浅谈pytorch中的dropout的概率p

最近需要训练一个模型,在优化模型时用了dropout函数,为了减少过拟合. 训练的时候用dropout,测试的时候不用dropout.刚开始以为p是保留神经元的比率,训练设置0.5,测试设置1,loss根本没减小过,全设置成1也是一样的效果,后来就考虑到是不是p设置错了. 上网一搜,果然是的!!!p的含义理解错了!不是保留的,而是不保留的! 具体的代码为: x2 = F.dropout(x1, p) x1是上一层网络的输出,p是需要删除的神经元的比例. 当p=0时,保留全部神经元更新.当p=1时

-

Python深度学习pytorch神经网络Dropout应用详解解

目录 扰动的鲁棒性 实践中的dropout 简洁实现 扰动的鲁棒性 在之前我们讨论权重衰减(L2正则化)时看到的那样,参数的范数也代表了一种有用的简单性度量.简单性的另一个有用角度是平滑性,即函数不应该对其输入的微笑变化敏感.例如,当我们对图像进行分类时,我们预计向像素添加一些随机噪声应该是基本无影响的. dropout在正向传播过程中,计算每一内部层同时注入噪声,这已经成为训练神经网络的标准技术.这种方法之所以被称为dropout,因为我们从表面上看是在训练过程中丢弃(drop out)一些

-

Pytorch中的数据集划分&正则化方法

1.训练集&验证集&测试集 训练集:训练数据 验证集:验证不同算法(比如利用网格搜索对超参数进行调整等),检验哪种更有效 测试集:正确评估分类器的性能 正常流程:验证集会记录每个时间戳的参数,在加载test数据前会加载那个最好的参数,再来评估.比方说训练完6000个epoch后,发现在第3520个epoch的validation表现最好,测试时会加载第3520个epoch的参数. import torch import torch.nn as nn import torch.nn.func

-

IIS启用GZip压缩的详细教程(图文)

IIS启用GZip压缩,是提高网站速度和减轻服务器负载的一个优化手段和方法,经测试,网站启用GZip压缩后,速度快了3倍!而配置起来也相当的简单,因此被广大网站管理员使用.本文将详细介绍如何在IIS启用GZip压缩,同时解决可能遇到的一些问题. IIS启用GZip压缩的步骤: 1.打开IIS,右键点击"网站",选择"属性" 2.在打开的窗口里,切换到"服务"标签,然后选中"HTTP压缩"下面的两个选项,临时目录可以自己新建一个

-

pytorch中with torch.no_grad():的用法实例

目录 1.关于with 2.关于withtorch.no_grad(): 附:pytorch使用模型测试使用withtorch.no_grad(): 总结 1.关于with with是python中上下文管理器,简单理解,当要进行固定的进入,返回操作时,可以将对应需要的操作,放在with所需要的语句中.比如文件的写入(需要打开关闭文件)等. 以下为一个文件写入使用with的例子. with open (filename,'w') as sh: sh.write("#!/bin/bash\n&qu

-

python tensorflow基于cnn实现手写数字识别

一份基于cnn的手写数字自识别的代码,供大家参考,具体内容如下 # -*- coding: utf-8 -*- import tensorflow as tf from tensorflow.examples.tutorials.mnist import input_data # 加载数据集 mnist = input_data.read_data_sets('MNIST_data', one_hot=True) # 以交互式方式启动session # 如果不使用交互式session,则在启动s

-

Tensorflow实现卷积神经网络的详细代码

本文实例为大家分享了Tensorflow实现卷积神经网络的具体代码,供大家参考,具体内容如下 1.概述 定义: 卷积神经网络(Convolutional Neural Network,CNN)是一种前馈神经网络,它的人工神经元可以响应一部分覆盖范围内的周围单元,对于大型图像处理有出色表现.它包括卷积层(alternating convolutional layer)和池层(pooling layer). 卷积层(convolutional layer): 对输入数据应用若干过滤器,一个输入参数被

-

keras的三种模型实现与区别说明

前言 一.keras提供了三种定义模型的方式 1. 序列式(Sequential) API 序贯(sequential)API允许你为大多数问题逐层堆叠创建模型.虽然说对很多的应用来说,这样的一个手法很简单也解决了很多深度学习网络结构的构建,但是它也有限制-它不允许你创建模型有共享层或有多个输入或输出的网络. 2. 函数式(Functional) API Keras函数式(functional)API为构建网络模型提供了更为灵活的方式. 它允许你定义多个输入或输出模型以及共享图层的模型.除此之外

随机推荐

- AngularJS使用ngMessages进行表单验证

- Swift编程中用以管理内存的自动引用计数详解

- SQL Server 2005安装实例环境图解第1/2页

- 10道典型的JavaScript面试题

- js获取图片长和宽度的代码

- dedecms系统的广告设置代码 基础版本

- javascript中的altKey 和 Event属性大全

- 从零学python系列之新版本导入httplib模块报ImportError解决方案

- Python中的条件判断语句与循环语句用法小结

- javascript身份证验证代码

- JavaScript实现多种排序算法

- 全面解析Bootstrap中transition、affix的使用方法

- Windows消息传递机制详解

- animate 实现滑动切换效果【实例代码】

- php中foreach结合curl实现多线程的方法分析

- liunx肉鸡上建立VPN的图文方法

- 深入c#绘制验证码的详解

- PHP生成不同颜色、不同大小的tag标签函数

- 深度辨析Python的eval()与exec()的方法

- 关于JavaScript 数组你应该知道的事情(推荐)