PyTorch学习之软件准备与基本操作总结

一、概述

PyTorch可以认为是一个Python库,可以像NumPy、Pandas一样被调用。PyTorch和NumPy功能是类似的,可以将PyTorch看作用在神经网络(深度学习)里的NumPy,并且加入了GPU支持的NumPy(原生NumPy不支持GPU)。

目前,应用最广、热度最高的深度学习框架为PyTorch和TensorFlow。本系列先从PyTorch开始,后面有机会再去弄TersonFlow,还有时间的话,就再去系统回顾下之前学习的Caffe框架。

小结:PyTorch为深度学习框架,为NumPy的替代品,支持GPU,可以用来搭建和训练深度神经网络。

二、工具准备

暂时确定:Anaconda、Jupyter Notebook。

1、Anaconda。

为了降低WSL在C盘下的负担,深度学习这块,准备在Windows下安装各种环境。Anaconda集成了许多优秀的开发工具。例如:Anaconda Navigator和Anaconda Prompt。前者是一个桌面图形界面,内部集成了很多开发工具,如Jupyter Notebook,VSCode。如果要启动某个软件,直接在界面的软件下Launch就行了。后者是Anaconda的终端,可在其中使用conda命令来管理Python库。conda是一个开源的软件包管理系统和环境管理系统,可以方便地管理Python的库函数以及创建虚拟环境。如果要启动该功能,直接在“开始”菜单找到就行了。

如何完成安装?

1.去这里下载对应版本的Anaconda包。

如果进去之后是一个Buy Now的购买界面,那很有可能就是因为挂了代理,速度跟不上,下载没成功,关掉就好。

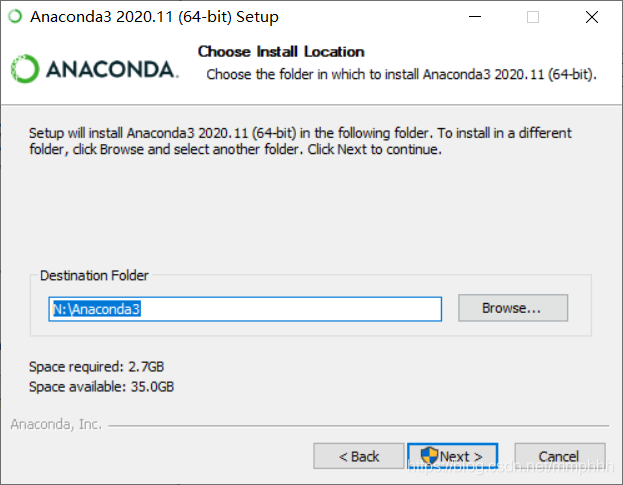

2.下载好后双击exe程序。Next、I Agree、All Users操作后,选择安装的路径。装的时候提示路径有警告,我觉得是没啥问题的,但保险起见,还是装在没空格的地方。

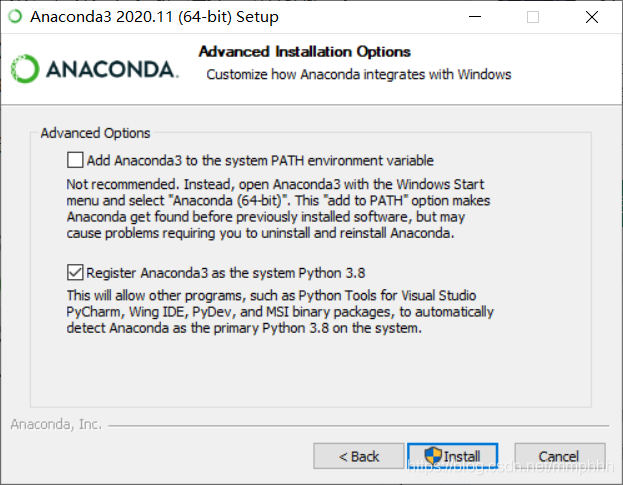

3.Next后出现下面这个情况。这一步是非常重要的!!!需要理解下,不然后面使用Anaconda容易出现问题。

首先关于这段话:

Not recommended.Instead , open Anaconda3 with the Windows startmenu and select “Anaconda (64-bit)”. This “add to PATH” option makesAnaconda get found before previously installed software, but maycause problems requiring you to uninstall and reinstall Anaconda. 不推荐。相反,用Windows开始菜单打开Anaconda3,选择“Anaconda(64位)”。这个“添加到PATH”选项会让你在之前安装的软件之前找到Anaconda,但可能会导致问题,需要你卸载并重新安装Anaconda。

按软件默认的推荐,是不要选中框1内容,将Anaconda添加到路径中。如果选中的话,会将Anaconda添加到系统路径中,这样,就得使用“开始”菜单的Anaconda Navigator或Anaconda命令提示符,来启动Anaconda,不然环境变量是错误的。但如果不选中,以后是可以随时将Anaconda添加到您的PATH中。这里选择不勾选,如果要在命令提示符下使用Anaconda,那就选中该框。由于电脑中没有Python的其他版本,这里直接默认3.8的。next、next并Finish后,完成安装。

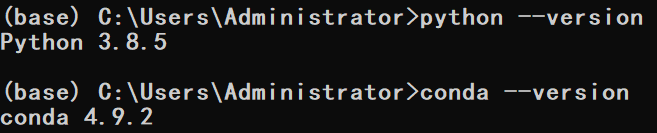

如何测试安装?

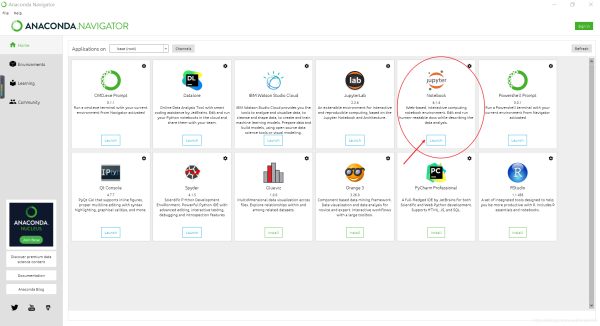

测试安装的一种好方法是打开Jupyter Notebook。可通过Anaconda Prompt或Anaconda Navigator执行此操作。

1.找到Anaconda Navigator,然后单击Anaconda Navigator。

2.在Jupyter Notebook下,单击Launch。

3.为了在Windows下使用Anaconda中的软件,需要添加下环境变量。

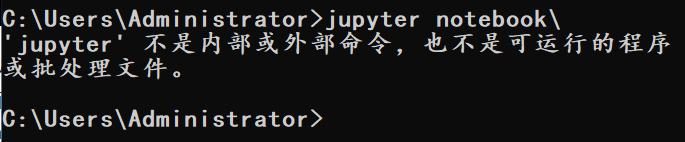

打开命令提示符。运行jupyter notebook,如果出现这个问题,需要配置下路径。

只需要将之前安装时的路径,放到环境变量里的path中去。

三、conda命令

几个非常有用的conda命令。

conda list 列出所有已安装的包 conda install pandas 安装包(比如这里安装Python的Pandas库) conda uninstall pandas 卸载包 conda update pandas

四、PyTorch的安装

在项目开发过程中,由于需求不同,得下载各种不同的框架和库,版本间的差异也会不同,需要不断更新或卸载对应的库,管理非常麻烦。需要创建虚拟环境,来为不同的项目创建独立的空间,这个空间里安装的任何库和框架都是独立的,不会影响到外部环境。这时,就需要上面安装的Anaconda了。

1.打开Anaconda Prompt。在命令行中输入:

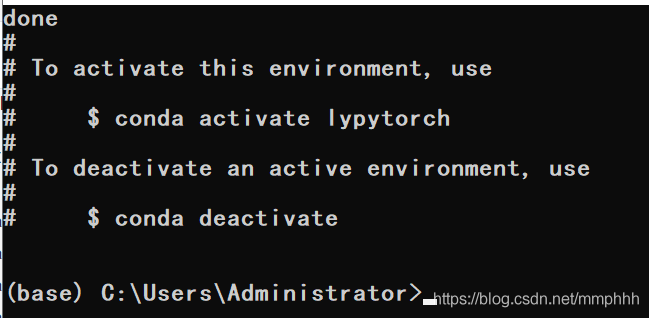

conda create --name lypytorch python=3.8

lypytorch是我的虚拟环境名称,可以自由命名。虚拟环境的运行需要一些库,安装完后,返回下面结果。

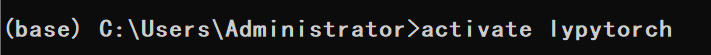

2.输入activate lypytorch进入虚拟环境。如果不想使用虚拟环境了,可以输入conda.bat deactivate来关闭当前虚拟环境(直接使用deactivate lypytorch不太行,会提示错误,一个坑点)。

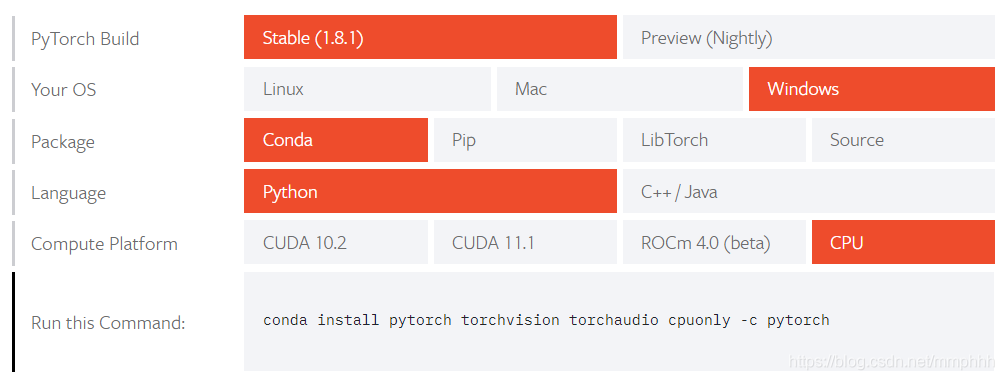

3.浏览器中进入这个页面,进入Pytorch的官网后,点击Get Started进入下载页面。

在Compute Platform中,如果想用GPU计算,得选CUDA等来安装GPU版本的PyTorch。安装GPU版本的PyTorch,得先有块NVIDIA的GPU并且安装了显卡的驱动,并且在安装前,需要提前安装CUDA和CUDNN,这里我自己的电脑,虽然有显卡,但也不是很好的那种,就用CPU版本的。安装GPU版本的PyTorch需要硬件支持,而且准备工作非常多,推荐先使用CPU版本的PyTorch。其实,小规模的神经网络,PyTorch的运行速度并无比较大的区别。

在虚拟环境PyTorch中输入下面命令,就可以开始PyTorch的安装了。

conda install pytorch torchvision torchaudio cpuonly -c pytorch

4.新建的虚拟环境是没有Jupyter的,需要运行下面的指令来安装。

conda install jupyter

运行后的输出。

当然,除了Jupyter外,还可以根据需要使用conda命令安装其他的Python库。

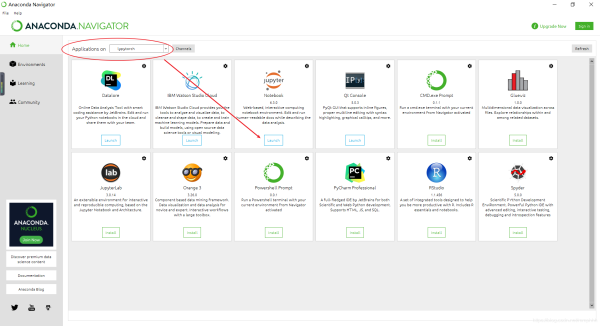

5.安装完后进行测试。打开Anaconda Navigator,由于PyTorch安装在虚拟环境lypytorch中的,可以在Anaconda Navigator界面中的Applications on下拉列表框中选择lypytorch,然后,可以启动该环境下的Jupyter Notebook。

6.打开Jupyter Notebook后,输入import等指令来导入库。

import torch import torchvision torch.__version__

这里的torch是PyTorch的核心库,torchvision包是服务于PyTorch深度学习框架的,用来产生图片、视频数据集、一些流行的模型类和预训练模型。简言之,torchvision由torchvision.datasets、torchvision.models、torchvision.transforms和torchvision.utils四个模块组成。安装的时候,会同时安装了PyTorch和torchvision。结果如下面所示,表示运行成功。

五、Jupyter修改默认路径

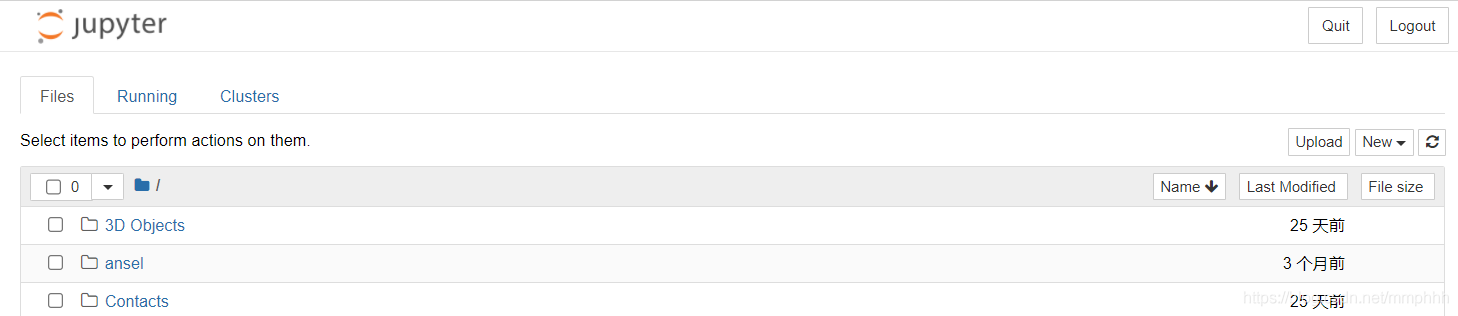

Jupyter默认打开的路径不知跑到哪去了,需要修改下默认的启动路径。

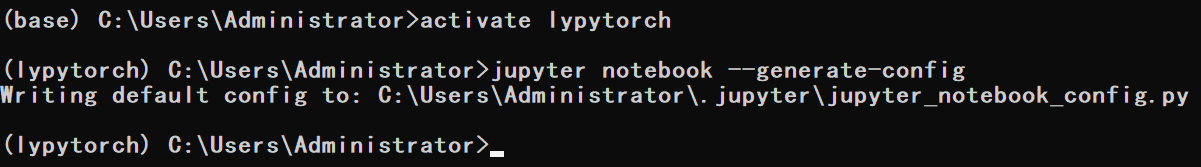

1.虚拟环境下,运行下面指令查看配置文件路径。

jupyter notebook --generate-config

得到下面结果:

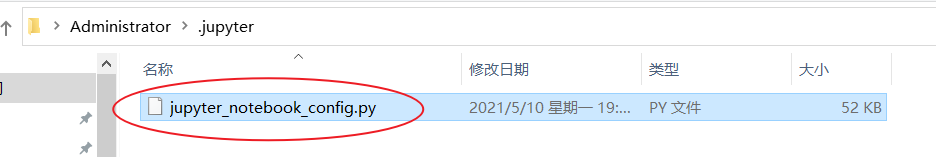

2.在Windows系统下,找到对应的文件。

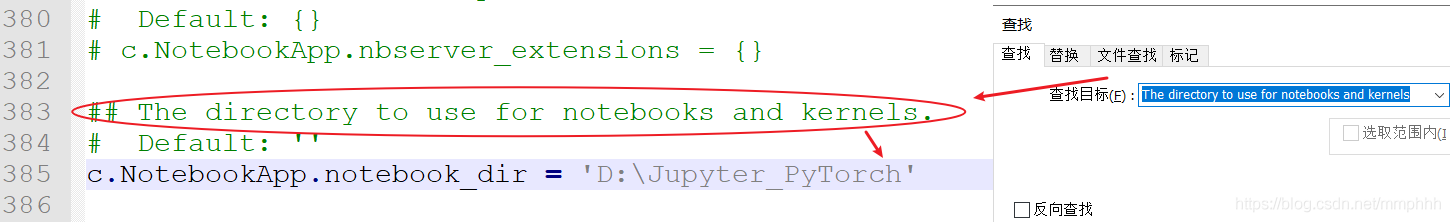

3.打开后搜索到下面的代码,把注释去掉后,选择默认的工作路径。

## The directory to use for notebooks and kernels. #c.NotebookApp.notebook_dir = ''

这里D:\Jupyter_PyTorch是我的工作路径,可以修改成自己的。还得注意,指令前面是不能留空格的。同时自己的工作文件夹需要提前新建,否则Jupyter Notebook会找不到这个文件,会产生闪退现象。

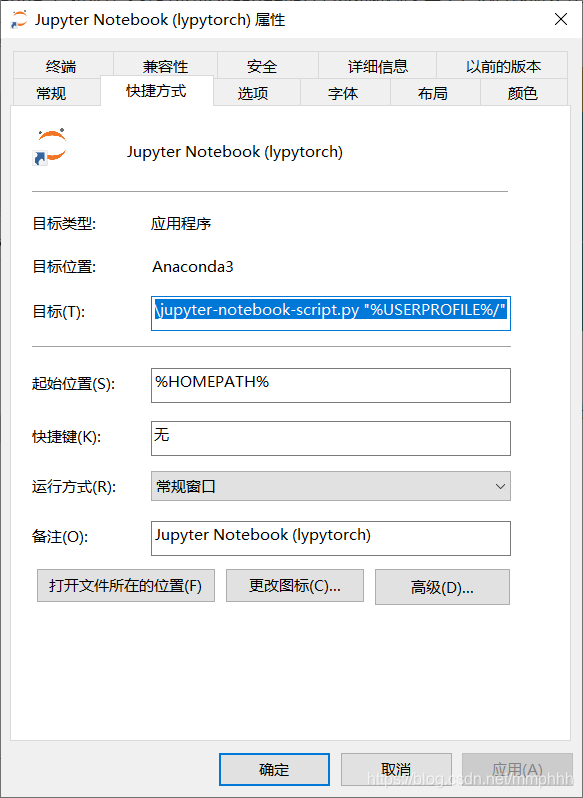

4.更改完,再右键自己虚拟环境下的Jupyter快捷方式,点击属性,将“%USERPROFILE%”删除保存。

右键属性打开后删除对应的路径,并应用下。

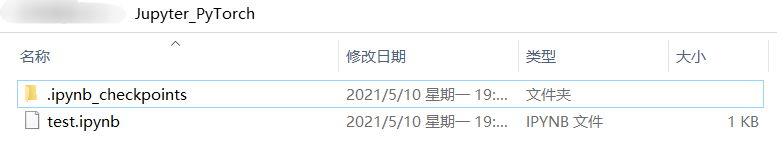

5.修改完,可以直接点击程序运行,默认是打开虚拟环境下Jupyter,打开后,新建一个文件,导入一下PyTorch,保存一下,可以看到在之前的工作空间下,已经产生了保存的文件。

Note:

如果命令“jupyter notebook --generate-config”执行有错误,大多是因为没有配置环境变量导致的,需要先进行设置下。

到此这篇关于PyTorch学习之软件准备与基本操作总结的文章就介绍到这了,更多相关PyTorch软件准备与基本操作内容请搜索我们以前的文章或继续浏览下面的相关文章希望大家以后多多支持我们!