python爬虫模拟登录之图片验证码实现详解

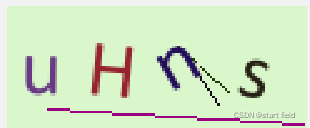

我们在用爬虫对门户网站进行模拟登录是总会有输入图片验证码的,例如这种

那我们怎么解决这个问题实现全自动的模拟登录呢?只要思想不滑坡,办法总比困难多。我这里使用的是百度智能云里面的文字识别功能,每天好像可以免费使用个几百次,识别效果也还行,对一般人而言是够用了。

接下来说说,怎么使用。

首先,打开百度智能云(https://cloud.baidu.com/)进行登入,再进入人工智能->文字识别里创建应用。

在使用名称和底下应用描述随便写写,然后点立即创建。

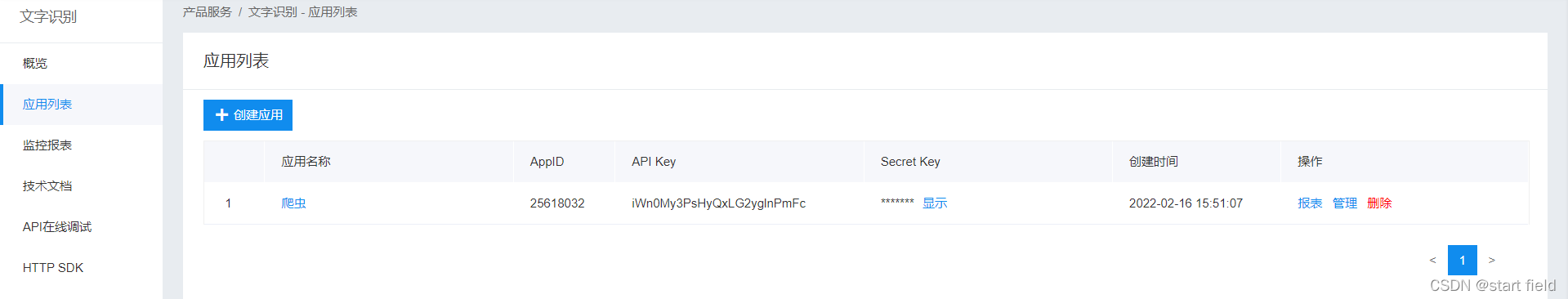

创建完成,就可以拿到 AppID 、API Key 、Secret Key

之后要在pycharm下载baidu-aip,然后导入AipOcr包。

from aip import AipOcr #aip在baidu-aip中

再然后就是初始化百度API

#百度API APP_ID = '你的之前拿到的AppID' API_KEY = '你的之前拿到的API Key' Secret_Key = '你的之前拿到的Secret Key'

我们先要把 图片验证码下载下来进行二值化处理,这样识别的准确率高一些。

这里要下载pillow库,然后导入Image包

from PIL import Image #PIL在pillow库中

#图片处理

# 二值化处理 灰度阈值设为127,高于这个值的点全部填白色

img_old = Image.open('code.jpg')

img_old = img_old.convert('L') # 灰度图 模式“L” 每个像素用8个bit表示,0表示黑,255表示白

threshld = 127 #设置阈值,图片的像素范围(0,255)

table = []

for i in range(256):

if i <threshld:

table.append(0)

else:

table.append(1)

img_old = img_old.point(table,'1') # 对图像像素操作 模式“1” 为二值图像,非黑即白。但是它每个像素用8个bit表示,0表示黑,255表示白

img_old.save('code.jpg')

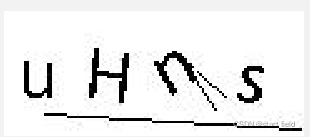

对于那些有干扰线,特别还是明暗交替的图片验证码来说,这样很好的避免了被干扰。

这里的图片中没有太多干扰线且也没有明暗交替所以看起来不明显,只是想让大家看看对比。

处理前 处理后

后面就是调用baidu_aip来读取图片中的内容。baidu_aip.handwriting

#读取处理后的验证码

with open('code.jpg','rb') as fp:

img_new = fp.read()

baidu_aip = AipOcr(APP_ID,API_KEY,Secret_Key)

result = baidu_aip.handwriting(img_new) #使用的是识别手写文字,返回一个字典,其中words_result是一个列表,里面有识别结果也是一个字典

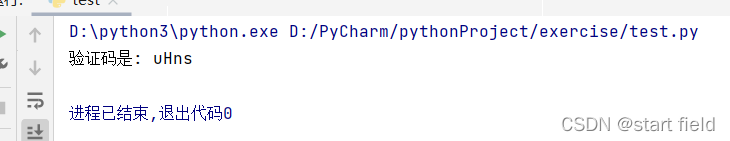

print('验证码是:',result['words_result'][0]['words'])

baidu_aip.handwriting这里面有很多识别文字的方法,我用的是识别手写文字,如果大家使用这个方法感觉效果不好可以选择其他方法。

最后是完整的代码。

# -- coding:UTF-8 --

import requests

from PIL import Image

from aip import AipOcr

if __name__ == "__main__":

#百度API

APP_ID = '你的之前拿到的AppID'

API_KEY = '你的之前拿到的API Key'

Secret_Key = '你的之前拿到的Secret Key'

headers = {

"user-agent": "Mozilla / 5.0(Windows NT 10.0;Win64;x64) AppleWebKit / 537.36(KHTML, likeGecko) Chrome / 97.0.4692.71Safari / 537.36Edg / 97.0.1072.55"

}

url = 'http://www.hyocr.com/captcha.php'

#下载验证码图片

session = requests.session()

img_data = session.get(url=url,headers=headers).content

with open('./code.jpg','wb') as fp:

fp.write(img_data)

#图片处理

# 二值化处理 灰度阈值设为127,高于这个值的点全部填白色

img_old = Image.open('code.jpg')

img_old = img_old.convert('L') # 灰度图 模式“L” 每个像素用8个bit表示,0表示黑,255表示白

threshld = 127 #设置阈值,图片的像素范围(0,255)

table = []

for i in range(256):

if i <threshld:

table.append(0)

else:

table.append(1)

img_old = img_old.point(table,'1') # 对图像像素操作 模式“1” 为二值图像,非黑即白。但是它每个像素用8个bit表示,0表示黑,255表示白

img_old.save('code.jpg')

#读取处理后的验证码

with open('code.jpg','rb') as fp:

img_new = fp.read()

baidu_aip = AipOcr(APP_ID,API_KEY,Secret_Key)

result = baidu_aip.handwriting(img_new) #使用的是识别手写文字,返回一个字典,其中words_result是一个列表,里面有识别结果也是一个字典

print('验证码是:',result['words_result'][0]['words'])

这只是百度智能云里面的一个小功能,还有很多其他的功能,大家感兴趣可以去看看百度智能云里面的官方文档 ,还有视频教程。

总结

到此这篇关于python爬虫模拟登录之图片验证码实现的文章就介绍到这了,更多相关python爬虫图片验证码内容请搜索我们以前的文章或继续浏览下面的相关文章希望大家以后多多支持我们!