用Python爬取618当天某东热门商品销量数据,看看大家喜欢什么!

前言

本文结构如下:

1、爬取某东畅销商品数据

2、清洗数据并并进行简单分析

3、将数据进行可视化展示

数据的字段如下:

一共爬取了243条某东畅销商品数据

一、获取数据

1. 分析网页

在编写代码之前,先来分析一波网页。

上面是某东的畅销商品,通过辰哥分析分析,该网页有异步加载(前面10个商品是静态加载,剩下的是动态异步加载),因此我们需要写了个请求去获取数据。

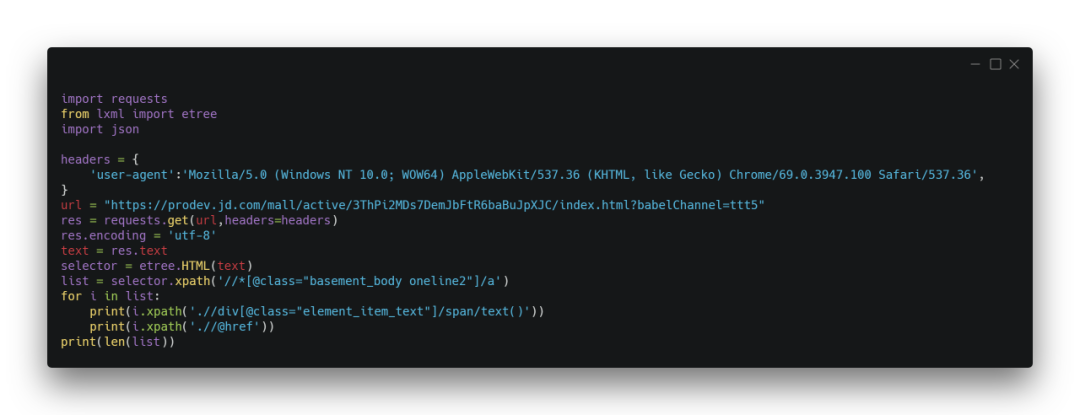

2. 获取静态网页商品链接

商品的销售、评论等数据在商品详情页,这里先获取商品详情页链接

结果如下:

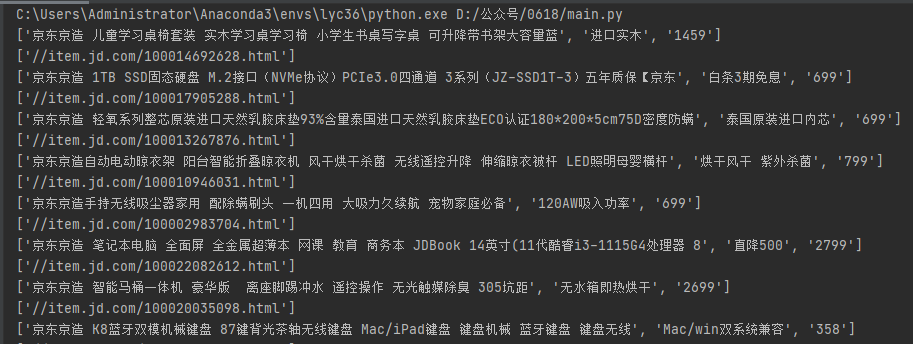

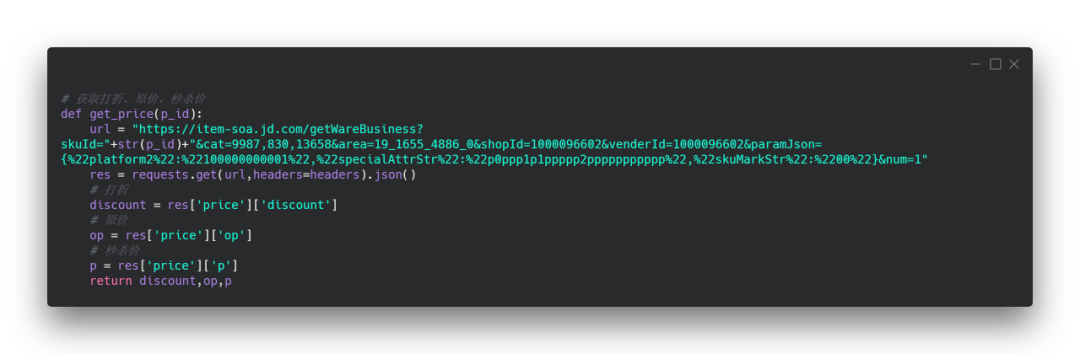

3. 获取动态网页商品链接

通过抓包可以获取到动态加载链接,并获取到商品标题和商品id(这里的商品id可以用于后面拼接商品详情页链接)

获取json数据后,提取出商品标题和商品ID

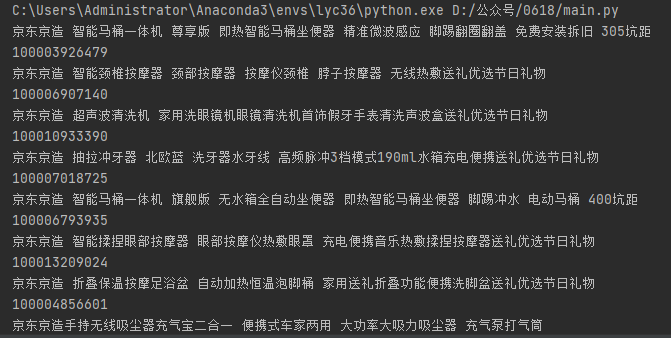

4. 获取打折、原价、秒杀价

通过商品ID可以获取到商品打折、原价、秒杀价(这里有接口,接口是通过抓包获取的,感兴趣的可以去自己去尝试,不明白的可以直接使用)

这里将该功能封装成函数,通过传入商品ID就可以获取该商品的商品打折、原价、秒杀价

结果如下:

5. 获取评论数、好评数、中评数、差评数、好评率

通过商品ID可以获取到评论数、好评数、中评数、差评数、好评率(同样这里有接口,接口是通过抓包获取的,感兴趣的可以去自己去尝试,不明白的可以直接使用)

结果如下:

6. 保存到excel

接着开始遍历商品,并通过ID去获取商品的销售情况(步骤4和步骤5的函数),最后把数据保存到execl

定义表头

写入数据

其中的get_price和CommentCount是步骤4和步骤5的函数。count是excel中行数,因此在循环中count+1,依次写入下一行。

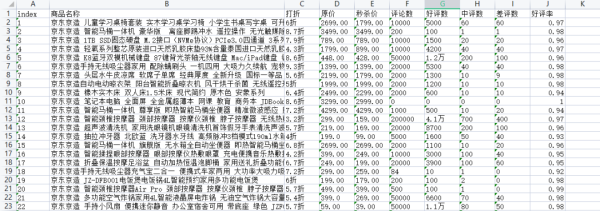

最终保存结果

一共爬取了243条某东畅销商品数据

二、数据分析&可视化

1.数据清洗

需要清洗的内容,主要有图中这三列(标题、打折、好评数)。

清洗目标:

标题过长(长度控制在10内),不方便后面的画图

打折字段中含有折字,在进行排序时不能直接转数值型。

好评数中的万,转为具体数值,如1.2万转为12000

清洗结果:

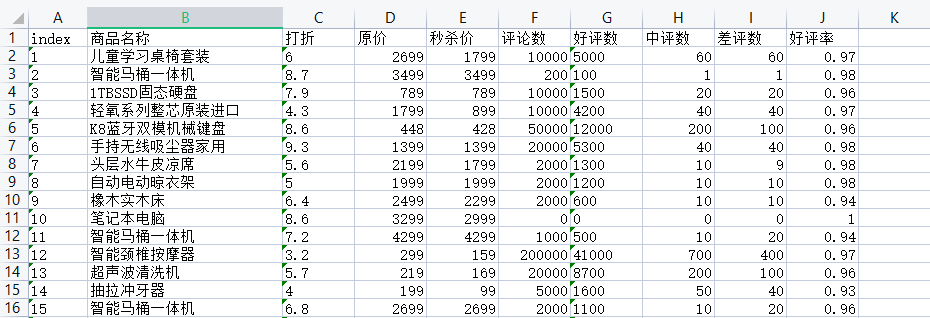

2.可视化-商品打折力度

从清洗后数据中取出:商品名称和打折这两列,进行【排序】从打折最大到打折最小。最后取出前15名进行可视化

核心代码****如下:

可视化效果:

3.可视化-好评率统计

从数据中取出:好评率这列,对不同的好评率进行统计,如好评率是100%(1)的商品多少件,好评率99%(0.99)的商品多少件等。

核心代码****如下:

可视化效果:

3.可视化-畅销商品销量排行

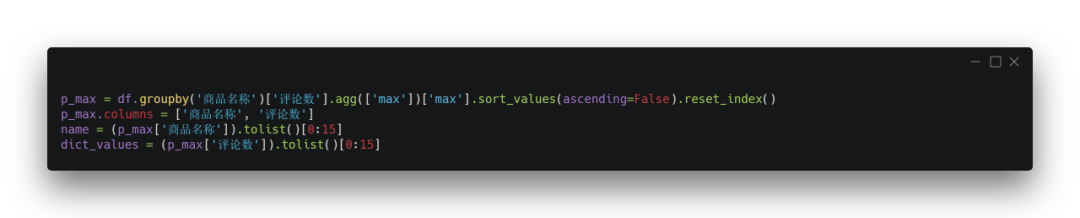

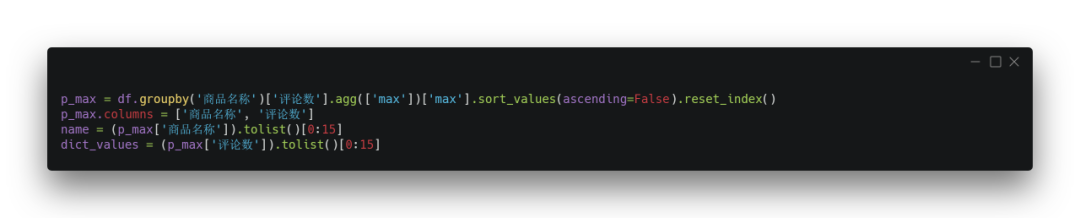

从数据中取出:商品名称和评论数这两列,这里根据评论数去作为销售依据,对商品的销量进行排序(高到低),并取出前15名进行可视化。

核心代码****如下:

可视化效果:

4.可视化-畅销商品前15名原价与秒杀价对比

在上面的分析中可以知道畅销商品的销量前15名,这里将这15件商品的原价和秒杀价进行可视化对比。

核心代码****如下:

可视化效果:

到此这篇关于用Python爬取618当天某东热门商品销量数据,看看大家喜欢什么!的文章就介绍到这了,更多相关Python爬取商品销量数据内容请搜索我们以前的文章或继续浏览下面的相关文章希望大家以后多多支持我们!

相关推荐

-

Python 爬取淘宝商品信息栏目的实现

一.相关知识点 1.1.Selenium Selenium是一个强大的开源Web功能测试工具系列,可进行读入测试套件.执行测试和记录测试结果,模拟真实用户操作,包括浏览页面.点击链接.输入文字.提交表单.触发鼠标事件等操作,并且能够对页面结果进行种种验证.也就是说,只要在测试用例中把预期的用户行为与结果都描述出来,我们就得到了一个可以自动化运行的功能测试套件. 1.2.ActionChains Actionchains是selenium里面专门处理鼠标相关的操作如:鼠标移动,鼠标按钮操作,按键和

-

Python爬虫实战之爬取京东商品数据并实实现数据可视化

一.开发工具 Python版本:3.6.4 相关模块: DecryptLogin模块: argparse模块: 以及一些python自带的模块. 二.环境搭建 安装Python并添加到环境变量,pip安装需要的相关模块即可. 三.原理简介 原理其实挺简单的,首先,我们利用之前开源的DecryptLogin库来实现一下微博的模拟登录操作: '''模拟登录京东''' @staticmethod def login(): lg = login.Login() infos_return, session

-

Python实现数据可视化看如何监控你的爬虫状态【推荐】

今天主要是来说一下怎么可视化来监控你的爬虫的状态. 相信大家在跑爬虫的过程中,也会好奇自己养的爬虫一分钟可以爬多少页面,多大的数据量,当然查询的方式多种多样.今天我来讲一种可视化的方法. 关于爬虫数据在mongodb里的版本我写了一个可以热更新配置的版本,即添加了新的爬虫配置以后,不用重启程序,即可获取刚刚添加的爬虫的状态数据. 1.成品图 这个是监控服务器网速的最后成果,显示的是下载与上传的网速,单位为M.爬虫的原理都是一样的,只不过将数据存到InfluxDB的方式不一样而已, 如下图. 可以

-

Python通过正则库爬取淘宝商品信息代码实例

使用正则库爬取淘宝商品的商品信息,首先我们需要确定想要爬取的对象 我们在淘宝里搜索"python",出来的结果 从url连接中可以得到搜索商品的关键字是"q=",所以我们要用的起始url为:https://s.taobao.com/search?q=python 然后翻页,经过对比发现,翻页后,变化的关键字是s,每次翻页,s便以44的倍数增长(可以数一下每页显示的商品数量,刚好是44) 所以可以根据关键字"s=",来设置爬取的深度(爬取多少页)

-

基于Python爬取京东双十一商品价格曲线

一年一度的双十一就快到了,各种砍价.盖楼.挖现金的口令将在未来一个月内充斥朋友圈.微信群中.玩过多次双十一活动的小编表示一顿操作猛如虎,一看结果2毛5.浪费时间不说而且未必得到真正的优惠,双十一电商的"明降暗升"已经是默认的潜规则了.打破这种规则很简单,可以用 Python 写一个定时监控商品价格的小工具. 思路第一步抓取商品的价格存入 Python 自带的 SQLite 数据库每天定时抓取商品价格使用 pyecharts 模块绘制价格折线图,让低价一目了然 抓取京东价格 从商品详情的

-

用Python爬取618当天某东热门商品销量数据,看看大家喜欢什么!

前言 本文结构如下: 1.爬取某东畅销商品数据 2.清洗数据并并进行简单分析 3.将数据进行可视化展示 数据的字段如下: 一共爬取了243条某东畅销商品数据 一.获取数据 1. 分析网页 在编写代码之前,先来分析一波网页. 上面是某东的畅销商品,通过辰哥分析分析,该网页有异步加载(前面10个商品是静态加载,剩下的是动态异步加载),因此我们需要写了个请求去获取数据. 2. 获取静态网页商品链接 商品的销售.评论等数据在商品详情页,这里先获取商品详情页链接 结果如下: 3. 获取动态网页商品链接 通

-

python爬取安居客二手房网站数据(实例讲解)

是小打小闹 哈哈,现在开始正式进行爬虫书写首先,需要分析一下要爬取的网站的结构:作为一名河南的学生,那就看看郑州的二手房信息吧! 在上面这个页面中,我们可以看到一条条的房源信息,从中我们发现了什么,发现了连郑州的二手房都是这么的贵,作为即将毕业的学生狗惹不起啊惹不起 还是正文吧!!!由上可以看到网页一条条的房源信息,点击进去后就会发现: 房源的详细信息.OK!那么我们要干嘛呢,就是把郑州这个地区的二手房房源信息都能拿到手,可以保存到数据库中,用来干嘛呢,作为一个地理人,还是有点用处的,这次就不说

-

浅谈Python爬取网页的编码处理

背景 中秋的时候,一个朋友给我发了一封邮件,说他在爬链家的时候,发现网页返回的代码都是乱码,让我帮他参谋参谋(中秋加班,真是敬业= =!),其实这个问题我很早就遇到过,之前在爬小说的时候稍微看了一下,不过没当回事,其实这个问题就是对编码的理解不到位导致的. 问题 很普通的一个爬虫代码,代码是这样的: # ecoding=utf-8 import re import requests import sys reload(sys) sys.setdefaultencoding('utf8') url

-

详解Python爬取并下载《电影天堂》3千多部电影

不知不觉,玩爬虫玩了一个多月了. 我愈发觉得,爬虫其实并不是什么特别高深的技术,它的价值不在于你使用了什么特别牛的框架,用了多么了不起的技术,它不需要.它只是以一种自动化搜集数据的小工具,能够获取到想要的数据,就是它最大的价值. 我的爬虫课老师也常跟我们强调,学习爬虫最重要的,不是学习里面的技术,因为前端技术在不断的发展,爬虫的技术便会随着改变.学习爬虫最重要的是,学习它的原理,万变不离其宗. 爬虫说白了是为了解决需要,方便生活的.如果能够在日常生活中,想到并应用爬虫去解决实际的问题,那么爬虫的

-

python爬取哈尔滨天气信息

本文实例为大家分享了python爬取哈尔滨天气信息的具体代码,供大家参考,具体内容如下 环境: windows7 python3.4(pip install requests:pip install BeautifulSoup4) 代码: (亲测可以正确执行) # coding:utf-8 """ 总结一下,从网页上抓取内容大致分3步: 1.模拟浏览器访问,获取html源代码 2.通过正则匹配,获取指定标签中的内容 3.将获取到的内容写到文件中 ""&qu

-

基于Python爬取51cto博客页面信息过程解析

介绍 提到爬虫,互联网的朋友应该都不陌生,现在使用Python爬取网站数据是非常常见的手段,好多朋友都是爬取豆瓣信息为案例,我不想重复,就使用了爬取51cto博客网站信息为案例,这里以我的博客页面为教程,编写的Python代码! 实验环境 1.安装Python 3.7 2.安装requests, bs4模块 实验步骤 1.安装Python3.7环境 2.安装requests,bs4 模块 打开cmd,输入:pip install requests -i https://pypi.tuna.tsi

-

python 爬取京东指定商品评论并进行情感分析

项目地址 https://github.com/DA1YAYUAN/JD-comments-sentiment-analysis 爬取京东商城中指定商品下的用户评论,对数据预处理后基于SnowNLP的sentiment模块对文本进行情感分析. 运行环境 Mac OS X Python3.7 requirements.txt Pycharm 运行方法 数据爬取(jd.comment.py) 启动jd_comment.py,建议修改jd_comment.py中变量user-agent为自己浏览器用户

-

python 爬取天气网卫星图片

项目地址: https://github.com/MrWayneLee/weather-demo 代码部分 下载生成文件功能 # 下载并生成文件 def downloadImg(imgDate, imgURLs, pathName): a,s,f = 0,0,0 timeStart = time.time() while a < len(imgURLs): req = requests.get(imgURLs[a]) imgName = str(imgURLs[a])[-13:-9] print

-

Python爬取国外天气预报网站的方法

本文实例讲述了Python爬取国外天气预报网站的方法.分享给大家供大家参考.具体如下: crawl_weather.py如下: #encoding=utf-8 import httplib import urllib2 import time from threading import Thread import threading from Queue import Queue from time import sleep import re import copy lang = "fr&qu

-

python爬取51job中hr的邮箱

本文实例为大家分享了python爬取51job中hr的邮箱具体代码,供大家参考,具体内容如下 #encoding=utf8 import urllib2 import cookielib import re import lxml.html from _ast import TryExcept from warnings import catch_warnings f = open('/root/Desktop/51-01.txt','a+') def read(city): url = 'ht

随机推荐

- JQuery Tips(4) 一些关于提高JQuery性能的Tips

- JQuery.dataTables表格插件添加跳转到指定页

- JS判断两个时间大小的示例代码

- Java实现的读取资源文件工具类ResourcesUtil实例【可动态更改值的内容】

- Java JDK 二分法 分析demo(推荐)

- js游戏人物上下左右跑步效果代码分享

- 详解JavaScript常量定义

- .net非托管资源的回收方法

- 页面乱码问题的根源及其分析

- ip138中各种客户端验证js代码

- 使用PYTHON创建XML文档

- Android LayoutInflater.inflate()详解及分析

- php中实现可以返回多个值的函数实例

- 利用HTML5+Socket.io实现摇一摇控制PC端歌曲切换

- dos批量替换当前目录后缀名的实现代码

- mysql字符串的‘123’转换为数字的123的实例

- JavaScript中的原型prototype完全解析

- jquery.validate[.unobtrusive]和Bootstrap实现tooltip错误提示问题分析

- Python中用Descriptor实现类级属性(Property)详解

- Android开发实现查询远程服务器的工具类QueryUtils完整实例