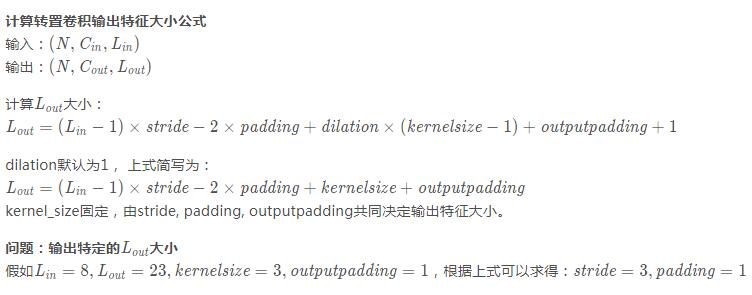

pytorch 计算ConvTranspose1d输出特征大小方式

问题:如何经过convTransposed1d输出指定大小的特征?

import torch from torch import nn import torch.nn.functional as F conv1 = nn.Conv1d(1, 2, 3, padding=1) conv2 = nn.Conv1d(in_channels=2, out_channels=4, kernel_size=3, padding=1) #转置卷积 dconv1 = nn.ConvTranspose1d(4, 1, kernel_size=3, stride=2, padding=1, output_padding=1) x = torch.randn(16, 1, 8) print(x.size()) x1 = conv1(x) x2 = conv2(x1) print(x2.size()) x3 = dconv1(x2) print(x3.size()) ''' torch.Size([16, 1, 8]) torch.Size([16, 4, 8]) #conv2输出特征图大小 torch.Size([16, 1, 16]) #转置卷积输出特征图大小 '''

#转置卷积 dconv1 = nn.ConvTranspose1d(1, 1, kernel_size=3, stride=3, padding=1, output_padding=1) x = torch.randn(16, 1, 8) print(x.size()) #torch.Size([16, 1, 23]) x3 = dconv1(x) print(x3.size()) #torch.Size([16, 1, 23])

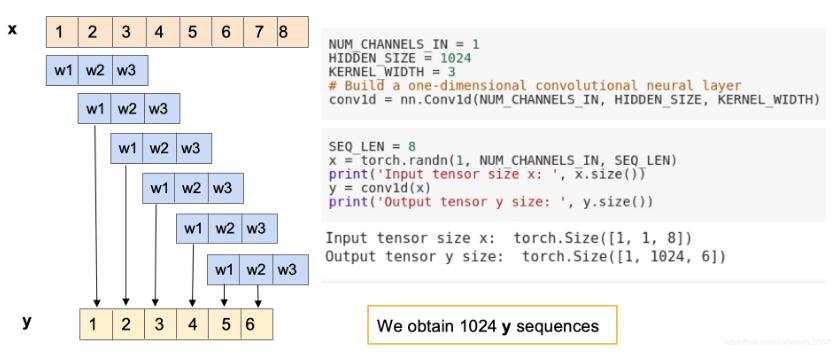

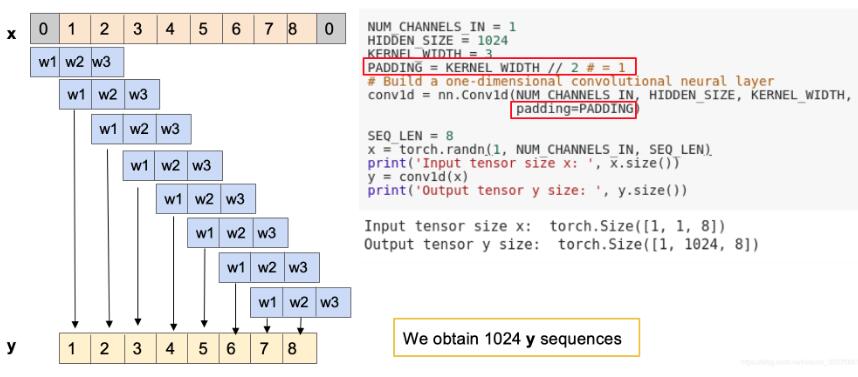

下面两图为演示conv1d,在padding和不padding下的输出特征图大小

不带padding

带padding

补充知识:判断pytorch是否支持GPU加速

如下所示:

print torch.cuda.is_available()

以上这篇pytorch 计算ConvTranspose1d输出特征大小方式就是小编分享给大家的全部内容了,希望能给大家一个参考,也希望大家多多支持我们。

相关推荐

-

pytorch nn.Conv2d()中的padding以及输出大小方式

我就废话不多说了,直接上代码吧! conv1=nn.Conv2d(1,2,kernel_size=3,padding=1) conv2=nn.Conv2d(1,2,kernel_size=3) inputs=torch.Tensor([[[[1,2,3], [4,5,6], [7,8,9]]]]) print("input size: ",inputs.shape) outputs1=conv1(inputs) print("output1 size: ",outp

-

pytorch1.0中torch.nn.Conv2d用法详解

Conv2d的简单使用 torch 包 nn 中 Conv2d 的用法与 tensorflow 中类似,但不完全一样. 在 torch 中,Conv2d 有几个基本的参数,分别是 in_channels 输入图像的深度 out_channels 输出图像的深度 kernel_size 卷积核大小,正方形卷积只为单个数字 stride 卷积步长,默认为1 padding 卷积是否造成尺寸丢失,1为不丢失 与tensorflow不一样的是,pytorch中的使用更加清晰化,我们可以使用这种方法定义输

-

pytorch中nn.Conv1d的用法详解

先粘贴一段official guide:nn.conv1d官方 我一开始被in_channels.out_channels卡住了很久,结果发现就和conv2d是一毛一样的.话不多说,先粘代码(菜鸡的自我修养) class CNN1d(nn.Module): def __init__(self): super(CNN1d,self).__init__() self.layer1 = nn.Sequential( nn.Conv1d(1,100,2), nn.BatchNorm1d(100), nn

-

关于keras.layers.Conv1D的kernel_size参数使用介绍

今天在用keras添加卷积层的时候,发现了kernel_size这个参数不知怎么理解,keras中文文档是这样描述的: kernel_size: 一个整数,或者单个整数表示的元组或列表, 指明 1D 卷积窗口的长度. 又经过多方查找,大体理解如下: 因为是添加一维卷积层Conv1D(),一维卷积一般会处理时序数据,所以,卷积核的宽度为1,而kernel_size就是卷积核的长度了,这样的意思就是这个卷积核是一个长方形的卷积核. 补充知识:tf.layers.conv1d函数解析(一维卷积) 一维

-

pytorch 计算ConvTranspose1d输出特征大小方式

问题:如何经过convTransposed1d输出指定大小的特征? import torch from torch import nn import torch.nn.functional as F conv1 = nn.Conv1d(1, 2, 3, padding=1) conv2 = nn.Conv1d(in_channels=2, out_channels=4, kernel_size=3, padding=1) #转置卷积 dconv1 = nn.ConvTranspose1d(4,

-

pytorch查看通道数 维数 尺寸大小方式

查看tensor x.shape # 尺寸 x.size() # 形状 x.ndim # 维数 例如 import torch parser = argparse.ArgumentParser(description='PyTorch') parser.add_argument('--img_w', default=144, type=int, metavar='imgw', help='img width') parser.add_argument('--img_h', default=288

-

在Pytorch中计算自己模型的FLOPs方式

https://github.com/Lyken17/pytorch-OpCounter 安装方法很简单: pip install thop 基本用法: from torchvision.models import resnet50from thop import profile model = resnet50() flops, params = profile(model, input_size=(1, 3, 224,224)) 对自己的module进行特别的计算: class YourMo

-

使用pytorch完成kaggle猫狗图像识别方式

kaggle是一个为开发商和数据科学家提供举办机器学习竞赛.托管数据库.编写和分享代码的平台,在这上面有非常多的好项目.好资源可供机器学习.深度学习爱好者学习之用. 碰巧最近入门了一门非常的深度学习框架:pytorch,所以今天我和大家一起用pytorch实现一个图像识别领域的入门项目:猫狗图像识别. 深度学习的基础就是数据,咱们先从数据谈起.此次使用的猫狗分类图像一共25000张,猫狗分别有12500张,我们先来简单的瞅瞅都是一些什么图片. 我们从下载文件里可以看到有两个文件夹:train和t

-

pytorch查看模型weight与grad方式

在用pdb debug的时候,有时候需要看一下特定layer的权重以及相应的梯度信息,如何查看呢? 1. 首先把你的模型打印出来,像这样 2. 然后观察到model下面有module的key,module下面有features的key, features下面有(0)的key,这样就可以直接打印出weight了,在pdb debug界面输入p model.module.features[0].weight,就可以看到weight,输入 p model.module.features[0].weig

-

opencv3/C++ FLANN特征匹配方式

使用函数detectAndCompute()检测关键点并计算描述符 函数detectAndCompute()参数说明: void detectAndCompute( InputArray image, //图像 InputArray mask, //掩模 CV_OUT std::vector<KeyPoint>& keypoints,//输出关键点的集合 OutputArray descriptors,//计算描述符(descriptors[i]是为keypoints[i]的计算描述符

-

Python OpenCV特征检测之特征匹配方式详解

目录 前言 一.暴力匹配器 二.FLANN匹配器 前言 获得图像的关键点后,可通过计算得到关键点的描述符.关键点描述符可用于图像的特征匹配.通常,在计算图A是否包含图B的特征区域时,将图A称做训练图像,将图B称为查询图像.图A的关键点描述符称为训练描述符,图B的关键点描述符称为查询描述符. 一.暴力匹配器 暴力匹配器使用描述符进行特征比较.在比较时,暴力匹配器首先在查询描述符中取一个关键点的描述符,将其与训练描述符中的所有关键点描述符进行比较,每次比较后会给出一个距离值,距离最小的值对应最佳

-

pytorch逐元素比较tensor大小实例

如下所示: import torch a = torch.tensor([[0.01, 0.011], [0.009, 0.9]]) mask = a.gt(0.01) print(mask) tensor比较大小可以用tensor.gt属性.上面比较了a中每个元素和0.01的大小,大于0.01的元素输出True.输出结果: tensor([[False, True], [False, True]]) 我们取出tenor a中对应的大于0.01的值: a[mask] 将对应满足条件的元素输出并自

-

pytorch 计算Parameter和FLOP的操作

深度学习中,模型训练完后,查看模型的参数量和浮点计算量,在此记录下: 1 THOP 在pytorch中有现成的包thop用于计算参数数量和FLOP,首先安装thop: pip install thop 注意安装thop时可能出现如下错误: 解决方法: pip install --upgrade git+https://github.com/Lyken17/pytorch-OpCounter.git # 下载源码安装 使用方法如下: from torchvision.models import r

随机推荐

- React-intl 实现多语言的示例代码

- WCF配置心得

- java图形界面编程之模拟血压计

- PHP实现在线阅读PDF文件的方法

- C++ STL入门教程(1) vector向量容器使用方法

- C语言实现运筹学中的马氏决策算法实例

- 解析C++编程中的#include和条件编译

- JQuery 国际象棋棋盘 实现代码

- Lua性能优化技巧(二):基本事实

- Shell脚本实现自动检测修改最快的Ubuntu软件源

- Python安装Imaging报错:The _imaging C module is not installed问题解决方法

- 使用Dreamhost空间下Shell命令的使用方法

- 用“替换法”“对照法”处理电脑黑屏两例

- 重启或杀掉Nginx进程后丢失nginx.pid的解决办法

- java统计字符串中重复字符出现次数的方法

- Java中JDom解析XML_动力节点Java学院整理

- 微信小程序 视图层(xx.xml)和逻辑层(xx.js)详细介绍

- Java线程同步Lock同步锁代码示例

- Java编程实现获取mp3时长及播放mp3文件的方法

- Java单例模式下的MongoDB数据库操作工具类