用Python爬取英雄联盟的皮肤详细示例

目录

- 一、推理原理

- 二、推理代码

- 第一步:获取js字典

- 第二步:从 js字典中提取到key值生成url列表

- 第三步:从 js字典中提取到value值生成name列表

- 第四步:下载并保存数据

- 第五步:执行主程序

一、推理原理

1.先去《英雄联盟》官网找到英雄及皮肤图片的网址:

2.从上面网址可以看到所有英雄都在,按下F12查看源代码,发现英雄及皮肤图片并没有直接给出,而是隐藏在JS文件中。

这时候需要点开Network,找到js窗口,刷新网页,就看到一个champion.js的选项,点击可以看到一个字典——里面就包含了所有英雄的名字(英文)以及对应的编号。

3.但是只有英雄的名字(英文)以及对应的编号并不能找到图片地址,于是回到网页,随便点开一个英雄,跳转页面后发现英雄及皮肤的图片都在,但要下载还需要找到原地址,这是鼠标右击选择“在新标签页中打开”,新的网页才是图片的原地址。

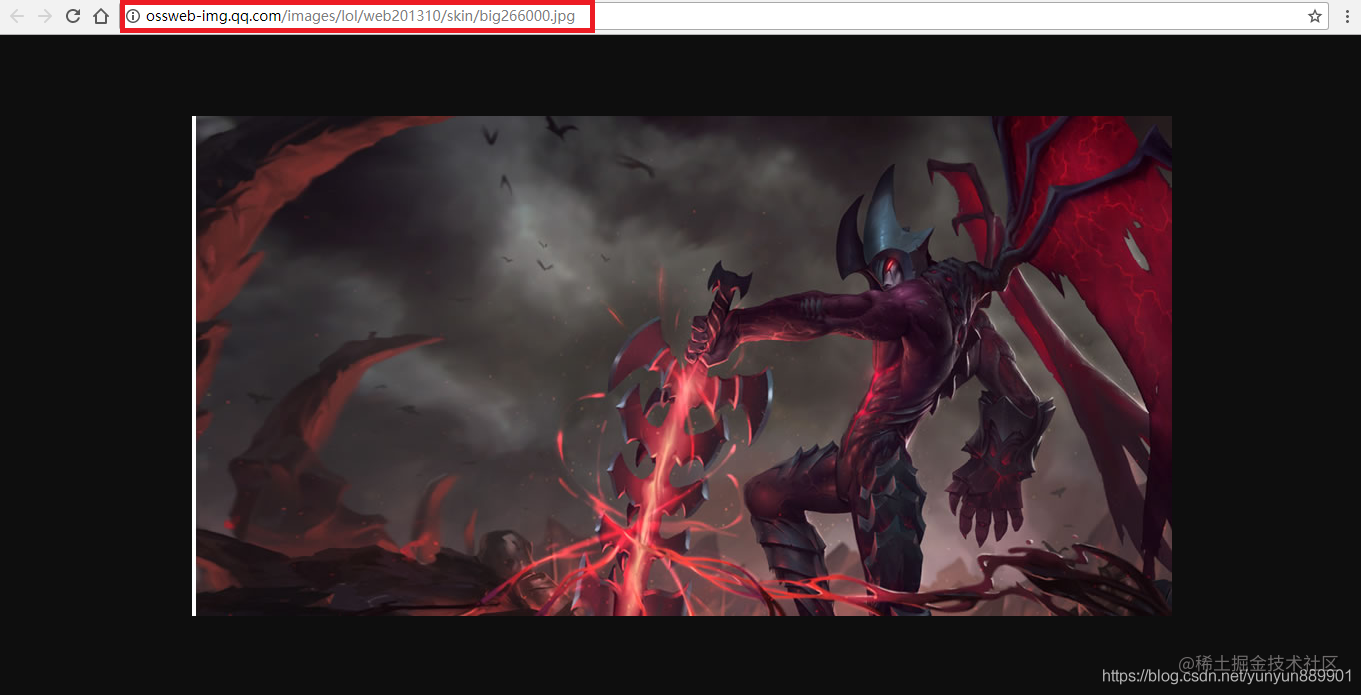

4.图中红色框就是我们需要的图片地址,经过分析知道:每一个英雄及皮肤的地址只有编号不一样

二、推理代码

第一步:获取js字典

def path_js(url_js):

res_js = requests.get(url_js, verify = False).content

html_js = res_js.decode("gbk")

pat_js = r'"keys":(.*?),"data"'

enc = re.compile(pat_js)

list_js = enc.findall(html_js)

dict_js = eval(list_js[0])

return dict_js

第二步:从 js字典中提取到key值生成url列表

def path_url(dict_js):

pic_list = []

for key in dict_js:

for i in range(20):

xuhao = str(i)

if len(xuhao) == 1:

num_houxu = "00" + xuhao

elif len(xuhao) == 2:

num_houxu = "0" + xuhao

numStr = key+num_houxu

url = r'http://ossweb-img.qq.com/images/lol/web201310/skin/big'+numStr+'.jpg'

pic_list.append(url)

print(pic_list)

return pic_list

第三步:从 js字典中提取到value值生成name列表

def name_pic(dict_js, path):

list_filePath = []

for name in dict_js.values():

for i in range(20):

file_path = path + name + str(i) + '.jpg'

list_filePath.append(file_path)

return list_filePath

第四步:下载并保存数据

def writing(url_list, list_filePath):

try:

for i in range(len(url_list)):

res = requests.get(url_list[i], verify = False).content

with open(list_filePath[i], "wb") as f:

f.write(res)

except Exception as e:

print("下载图片出错,%s" %(e))

return False

第五步:执行主程序

if __name__ == '__main__':

url_js = r'http://lol.qq.com/biz/hero/champion.js'

path = r'./data/' #图片存在的文件夹

dict_js = path_js(url_js)

url_list = path_url(dict_js)

list_filePath = name_pic(dict_js, path)

writing(url_list, list_filePath)

运行后会在控制台打印出每一张图片的网址:

在文件夹中可以看到图片已经下载好 如图:

到此这篇关于用Python爬取英雄联盟的皮肤详细示例的文章就介绍到这了,更多相关Python爬英雄联盟皮肤图片内容请搜索我们以前的文章或继续浏览下面的相关文章希望大家以后多多支持我们!

赞 (0)