python没有gpu,如何改用cpu跑代码

目录

- 没有gpu,改用cpu跑代码

- 只需要将device设置为以下即可

- Tensorflow-gpu禁用gpu设置(cpu与gpu速度对比)

- 禁用gpu设置

- cpu与gpu对比

- cpu

- gpu

没有gpu,改用cpu跑代码

以为很麻烦的修改,很大动干戈的改动,以及无止尽的报错,结果,就改动代码中的device就OK了,惊不惊喜,意不意外!?

也就是说,

只需要将device设置为以下即可

device=torch.device("cuda:0" if torch.cuda.is_available() else "cpu"))

另外也不需要全如此设置,只需查看报错处调用device的来源,在修改torch.device()括号里面的内容就可。

Tensorflow-gpu禁用gpu设置(cpu与gpu速度对比)

禁用gpu设置

# 在import tensorflow之前 import os os.environ['CUDA_VISIBLE_DEVICES'] = '-1'

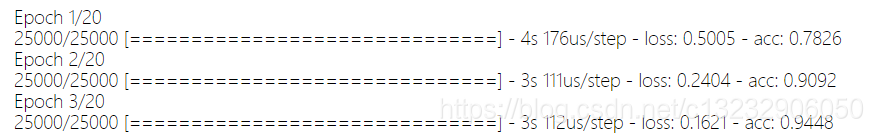

cpu与gpu对比

显卡:GTX 1066

cpu

gpu

简单测试:gpu比cpu快5秒

以上为个人经验,希望能给大家一个参考,也希望大家多多支持我们。

相关推荐

-

用gpu训练好的神经网络,用tensorflow-cpu跑出错的原因及解决方案

训练的时候当然用gpu,速度快呀. 我想用cpu版的tensorflow跑一下,结果报错,这个错误不太容易看懂. 大概意思是没找到一些节点. 后来发现原因,用gpu和cpu保存的pb模型不太一样,但是checkpoints文件是通用的. 使用tensorflow-cpu再把checkpoints文件重新转换一下pb文件就可以了. 完美解决! 补充:tensflow-gpu版的无数坑坑坑!(tf坑大总结) 自己的小本本,之前预装有的pycharm+win10+anaconda3+python3的环

-

将Pytorch模型从CPU转换成GPU的实现方法

最近将Pytorch程序迁移到GPU上去的一些工作和思考 环境:Ubuntu 16.04.3 Python版本:3.5.2 Pytorch版本:0.4.0 0. 序言 大家知道,在深度学习中使用GPU来对模型进行训练是可以通过并行化其计算来提高运行效率,这里就不多谈了. 最近申请到了实验室的服务器来跑程序,成功将我简陋的程序改成了"高大上"GPU版本. 看到网上总体来说少了很多介绍,这里决定将我的一些思考和工作记录下来. 1. 如何进行迁移 由于我使用的是Pytorch写的模型,网上给

-

Pytorch如何切换 cpu和gpu的使用详解

前言,在pytorch中,当服务器上的gpu被占用时,很多时候我们想先用cpu调试下代码,那么就需要进行gpu和cpu的切换. 方法1:x.to(device) 把 device 作为一个可变参数,推荐使用argparse进行加载: 使用gpu时: device='cuda' x.to(device) # x是一个tensor,传到cuda上去 使用cpu时: device='cpu' x.to(device) 方法2:使用x.cuda()+CUDA_VISIBLE_DEVICES 很多贴子中说

-

基于Tensorflow使用CPU而不用GPU问题的解决

之前的文章讲过用Tensorflow的object detection api训练MobileNetV2-SSDLite,然后发现训练的时候没有利用到GPU,反而CPU占用率贼高(可能会有Could not dlopen library 'libcudart.so.10.0'之类的警告).经调查应该是Tensorflow的GPU版本跟服务器所用的cuda及cudnn版本不匹配引起的.知道问题所在之后就好办了. 检查cuda和cudnn版本 首先查看cuda版本: cat /usr/local/

-

python没有gpu,如何改用cpu跑代码

目录 没有gpu,改用cpu跑代码 只需要将device设置为以下即可 Tensorflow-gpu禁用gpu设置(cpu与gpu速度对比) 禁用gpu设置 cpu与gpu对比 cpu gpu 没有gpu,改用cpu跑代码 以为很麻烦的修改,很大动干戈的改动,以及无止尽的报错,结果,就改动代码中的device就OK了,惊不惊喜,意不意外!? 也就是说, 只需要将device设置为以下即可 device=torch.device("cuda:0" if torch.cuda.is_ava

-

Python服务器创建虚拟环境跑代码

目录 一.前言 二.创建虚拟环境用来跑代码 一.前言 最近忙着在服务器上跑代码 学习积累了一些经验技巧 这里用来记录分享给大家 二.创建虚拟环境用来跑代码 下面我会以一个实例为模板,学习完之后,再删掉 不会占用大家的服务器 1.连接上服务器 比如我的连接方式为:ssh -p 你的编号 username-host 2.创建虚拟环境 这里我以一篇代码为例 创建虚拟环境 conda create -n KDDocRE python==3.7.4 3.进入虚拟环境 conda activate KDDo

-

Linux下使用python调用top命令获得CPU利用率

本文定位:想通过python调用top命令获取cpu使用率但暂时没有思路的情况. 如果单纯为了获得cpu的利用率,通过top命令重定向可以轻松实现,命令如下: 复制代码 代码如下: top -bi > cpuHistory.log 或 复制代码 代码如下: top -bi | tee cpuHistory.log 这个就不解释了,不懂的朋友查询下top的帮助文档.这里要实现的是通过python调用top命令,并获得cpu的利用率信息. 用过popen的朋友很快就能想到类似如下的代码(这个是我第

-

详解python中GPU版本的opencv常用方法介绍

引言 本篇是以python的视角介绍相关的函数还有自我使用中的一些问题,本想在这篇之前总结一下opencv编译的全过程,但遇到了太多坑,暂时不太想回看做过的笔记,所以这里主要总结python下GPU版本的opencv. 主要函数说明 threshold():二值化,但要指定设定阈值 blendLinear():两幅图片的线形混合 calcHist() createBoxFilter ():创建一个规范化的2D框过滤器 canny边缘检测 createGaussianFilter():创建一个Ga

-

关于Python的GPU编程实例近邻表计算的讲解

目录 技术背景 加速场景 基于Numba的GPU加速 总结概要 技术背景 GPU加速是现代工业各种场景中非常常用的一种技术,这得益于GPU计算的高度并行化.在Python中存在有多种GPU并行优化的解决方案,包括之前的博客中提到的cupy.pycuda和numba.cuda,都是GPU加速的标志性Python库.这里我们重点推numba.cuda这一解决方案,因为cupy的优势在于实现好了的众多的函数,在算法实现的灵活性上还比较欠缺:而pycuda虽然提供了很好的灵活性和相当高的性能,但是这要求

-

Python写的一个定时重跑获取数据库数据

做大数据的童鞋经常会写定时任务跑数据,由于任务之间的依赖(一般都是下游依赖上游的数据产出),所以经常会导致数据获取失败,因为很多人发现数据失败后 都会去查看日志,然后手动去执行自己的任务.下面我实现了一个自动重复执行去数据库取数,如果失败后自动重新去获取,直到把数据获取到. 建数据表: CREATE TABLE `testtable` ( 2 `id` int(11) unsigned NOT NULL AUTO_INCREMENT, 3 `name` varchar(20) NOT NULL,

-

Python批量发送post请求的实现代码

昨天学了一天的Python(我的生产语言是java,也可以写一些shell脚本,算有一点点基础),今天有一个应用场景,就正好练手了. 这个功能之前再java里写过,比较粗糙,原来是在我本机跑的,今天老大要求要随时保持请求,就用Python改写了下,省的又把一个有跟多杂项的jar包传到服务器,省空间又不乱,而且好读. 先附上java代码: package xxxxxx.base; import java.util.Random; import org.apache.commons.lang3.St

-

Python爬虫爬取百度搜索内容代码实例

这篇文章主要介绍了Python爬虫爬取百度搜索内容代码实例,文中通过示例代码介绍的非常详细,对大家的学习或者工作具有一定的参考学习价值,需要的朋友可以参考下 搜索引擎用的很频繁,现在利用Python爬虫提取百度搜索内容,同时再进一步提取内容分析就可以简便搜索过程.详细案例如下: 代码如下 # coding=utf8 import urllib2 import string import urllib import re import random #设置多个user_agents,防止百度限制I

-

python tqdm实现进度条的示例代码

一.前言 \quad \quad 有时候在使用Python处理比较耗时操作的时候,为了便于观察处理进度,这时候就需要通过进度条将处理情况进行可视化展示,以便我们能够及时了解情况.这对于第三方库非常丰富的Python来说,想要实现这一功能并不是什么难事. \quad \quad tqdm就能非常完美的支持和解决这些问题,可以实时输出处理进度而且占用的CPU资源非常少,支持循环处理.多进程.递归处理.还可以结合linux的命令来查看处理情况,等进度展示. 我们先来看一下进度条的效果. from tq

-

使用Python建立RNN实现二进制加法的示例代码

只有一百行左右代码,应该还是比较好理解的. 首先看一下结果, The end error is:[0.05344101] 发现还是不错的.如果不想看讲解,就直接跳到文末,有所有的代码,安装numpy库就能够跑. 二进制加法 这个没啥好说的,就是逢二进一,不知道的就看看计算机组成原理的相关内容吧. RNN主要学两件事,一个是前一位的进位,一个是当前位的加法操作.只告诉当前阶段和前一阶段的计算结果,让网络自己学习加法和进位操作. 具体代码 既然是神经网络,肯定就非线性的,首先是sigmoid函数,这

随机推荐

- nginx服务器通过配置来解决API的跨域问题

- Mysql 5.7.18安装方法及启动MySQL服务的过程详解

- jdbc 数据库的连接(sqlserver oracle)

- Python中多线程thread与threading的实现方法

- php读取文件内容至字符串中,同时去除换行、空行、行首行尾空格(Zjmainstay原创)

- javascript禁用键盘功能键让右击及其他键无效

- 定时自动备份IIS的WWW日志的vbs脚本

- 浅析Java中String与StringBuffer拼接的区别

- jQuery实现花式轮播之圣诞节礼物传送效果

- jQuery使用之标记元素属性用法实例

- 微信小程序下拉刷新界面的实现

- java 获取字节码文件的几种方法总结

- Java对日期Date类进行加减运算、年份加减月份加减、时间差等等

- C#计算代码执行时间的方法

- 贪吃蛇游戏C++命令行版实例代码

- CentOS7服务器环境下vsftpd安装及配置方法

- Shiro集成Spring之注解示例详解

- python 读写excel文件操作示例【附源码下载】

- 阿里的一道Java并发面试题详解

- 用python打印菱形的实操方法和代码