盘点Python 爬虫中的常见加密算法

目录

- 前言

- 1. 基础常识

- 2. Base64伪加密

- 3. MD5加密

- 4. AES/DES对称加密

- 1.密钥

- 2.填充

- 3.模式

前言

今天小编就带着大家来盘点一下数据抓取过程中这些主流的加密算法,它们有什么特征、加密的方式有哪些等等,知道了这些之后对于我们逆向破解这些加密的参数会起到不少的帮助!

相信大家在数据抓取的时候,会碰到很多加密的参数,例如像是"token"、"sign"等等,今天小编就带着大家来盘点一下数据抓取过程中这些主流的加密算法,它们有什么特征、加密的方式有哪些等等,知道了这些之后对于我们逆向破解这些加密的参数会起到不少的帮助!

1. 基础常识

首先我们需要明白的是,什么是加密和解密?顾名思义

- 加密(Encryption): 将明文数据变换为密文的过程

- 解密(Decryption): 加密的逆过程,即由密文恢复出原明文的过程。

加密和解密算法的操作通常都是在一组密钥的控制下进行的,分别成为是加密密钥(Encryption Key)和解密密钥(Decryption Key),

如下图所示:

而加密算法当中又分为是对称加密和非对称加密以及散列算法,其中

- 对称加密:即加密与解密时使用的是相同的密钥,例如RC4、AES、DES等加密算法

- 非对称加密:即加密与解密时使用不相同的密钥,例如RSA加密算法等

- 散列算法:又称为是哈希函数。对不同长度的输入消息产生固定的输出,该输出值就是散列值

2. Base64伪加密

Base64严格意义上来说不算做事加密的算法,只是一种编码的方式,它是一种用64个字符,分别是A-Z、a-z、0-9、+、/这64个字符,实现对数据的编码,可用于在HTTP环境下传递较长的标识信息。采用Base64编码具有不可读性,需要解码后才能阅读。我们使用Python来对任意网址进行Base64的编码操作,代码如下:

import base64

# 想将字符串转编码成base64,要先将字符串转换成二进制数据

url = "www.baidu.com"

bytes_url = url.encode("utf-8")

str_url = base64.b64encode(bytes_url) # 被编码的参数必须是二进制数据

print(str_url)

输出:

b'd3d3LmJhaWR1LmNvbQ=='

那么同样地,我们也可以对其进行解码的操作,代码如下:

url = "d3d3LmJhaWR1LmNvbQ=="

str_url = base64.b64decode(url).decode("utf-8")

print(str_url)

输出:

www.baidu.com

3. MD5加密

MD5是一种被广泛使用的线性散列算法,且加密之后产生的是一个固定长度(32位或者是16位)的数据,由字母和数字组成,大小写统一。其最后加密生成的数据是不可逆的,也就是说不能够轻易地通过加密后的数据还原到原始的字符串,除非是通过暴力破解的方式。

我们在Python当中来实现一下MD5加密:

import hashlib

str = 'this is a md5 demo.'

hl = hashlib.md5()

hl.update(str.encode(encoding='utf-8'))

print('MD5加密前为 :' + str)

print('MD5加密后为 :' + hl.hexdigest())

输出:

MD5加密前为 :this is a md5 demo.

MD5加密后为 :b2caf2a298a9254b38a2e33b75cfbe75

就像上文提到的,针对MD5加密可以通过暴力破解的方式来降低其安全性,因此在实操过程当中,我们会添加盐值(Salt)或者是双重MD5加密等方式来增加其可靠性,代码如下:

# post传入的参数

params = "123456"

# 加密后需拼接的盐值(Salt)

salt = "asdfkjalksdncxvm"

def md5_encrypt():

m = md5()

m.update(params.encode('utf8'))

sign1 = m.hexdigest()

return sign1

def md5_encrypt_with_salt():

m = md5()

m.update((md5_encrypt() + salt).encode('utf8'))

sign2 = m.hexdigest()

return sign2

4. AES/DES对称加密

首先我们来讲DES加密,全称是Data Encryption Standard,即数据加密标准,在对称性加密当中比较常见的一种,也就是加密和解密过程当中使用的密钥是相同的,因此想要破解的话,通过暴力枚举的方式,只要计算的能力足够强还是可以被破解的。

AES的全称是Advanced Encryption Standard,是DES算法的替代者,也是当今最流行的对称加密算法之一。想要弄清楚AES算法,首先就得弄明白三个基本的概念:密钥、填充和模式。

1.密钥

密钥我们之前已经说了很多了,大家可以将其想象成是一把钥匙,既可以用其来进行上锁,可以用其来进行解锁。AES支持三种长度的密钥:128位、192位以及256位。

2.填充

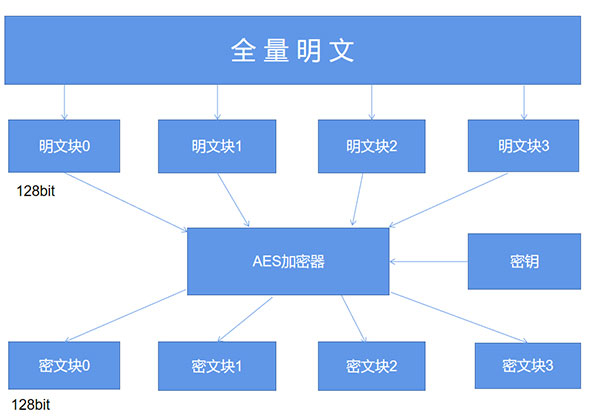

而至于填充这一概念,AES的分组加密的特性我们需要了解,具体如下图所示:

简单来说,AES算法在对明文加密的时候,并不是把整个明文一股脑儿地加密成一整段密文,而是把明文拆分成一个个独立的明文块,每一个明文块的长度为128比特。

这些明文块经过AES加密器的复杂处理之后,生成一个个独立的密文块,将这些密文块拼接到一起就是最终的AES加密的结果了。

那么这里就有一个问题了,要是有一段明文的长度是196比特,如果按照每128比特一个明文块来拆分的话,第二个明文块只有64比特了,不足128比特该怎么办呢?这个时候就轮到填充来发挥作用了,默认的填充方式是PKCS5Padding以及ISO10126Padding。

不过在AES加密的时候使用了某一种填充方式,解密的时候也必须采用同样的填充方式。

3.模式

AES的工作模式,体现在了把明文块加密成密文块的处理过程中,主要有五种不同的工作模式,分别是CBC、ECB、CTR、CFB以及OFB模式,同样地,如果在AES加密过程当中使用了某一种工作模式,解密的时候也必须采用同样地工作模式。最后我们用Python来实现一下AES加密。

import base64

from Crypto.Cipher import AES

def AES_encrypt(text, key):

pad = 16 - len(text) % 16

text = text + pad * chr(pad)

text = text.encode("utf-8")

encryptor = AES.new(key.encode('utf-8'), AES.MODE_ECB)

encrypt_text = encryptor.encrypt(text)

encrypt_text = base64.b64encode(encrypt_text)

return encrypt_text.decode('utf-8')

到此这篇关于盘点Python 爬虫中的常见加密算法的文章就介绍到这了,更多相关Python 加密算法内容请搜索我们以前的文章或继续浏览下面的相关文章希望大家以后多多支持我们!