python中文分词,使用结巴分词对python进行分词(实例讲解)

在采集美女站时,需要对关键词进行分词,最终采用的是python的结巴分词方法。

中文分词是中文文本处理的一个基础性工作,结巴分词利用进行中文分词。

其基本实现原理有三点:

1.基于Trie树结构实现高效的词图扫描,生成句子中汉字所有可能成词情况所构成的有向无环图(DAG)

2.采用了动态规划查找最大概率路径, 找出基于词频的最大切分组合

3.对于未登录词,采用了基于汉字成词能力的HMM模型,使用了Viterbi算法

安装(Linux环境)

下载工具包,解压后进入目录下,运行:python setup.py install

模式

1.默认模式,试图将句子最精确地切开,适合文本分析

2.全模式,把句子中所有的可以成词的词语都扫描出来,适合搜索引擎

接口

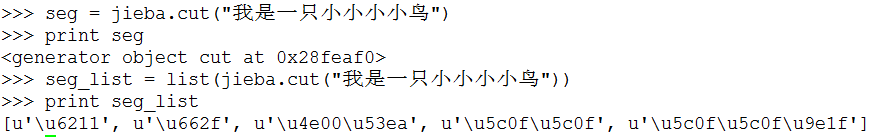

• 组件只提供jieba.cut 方法用于分词

• cut方法接受两个输入参数:

• 第一个参数为需要分词的字符串

• cut_all参数用来控制分词模式

• 待分词的字符串可以是gbk字符串、utf-8字符串或者unicode

• jieba.cut返回的结构是一个可迭代的generator,可以使用for循环来获得分词后得到的每一个词语(unicode),也可以用list(jieba.cut(...))转化为list

• seg=jieba.cut("http://www.gg4493.cn/"):

实例

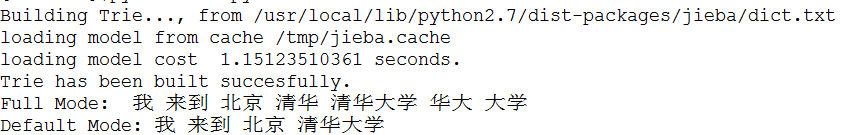

#! -*- coding:utf-8 -*-

import jieba

seg_list = jieba.cut("我来到北京清华大学", cut_all = True)

print "Full Mode:", ' '.join(seg_list)

seg_list = jieba.cut("我来到北京清华大学")

print "Default Mode:", ' '.join(seg_list)

结果

以上这篇python中文分词,使用结巴分词对python进行分词(实例讲解)就是小编分享给大家的全部内容了,希望能给大家一个参考,也希望大家多多支持我们。

相关推荐

-

python GUI实例学习

在学习本篇之前,如果你对Python下进行GUI编程基础内容还有不明白,推荐一篇相关文章:简单介绍利用TK在Python下进行GUI编程的教程 写一个简单的界面很容易,即使是什么都不了解的情况下,这个文本转载了最简单的界面编写,下个文本介绍了TK的简单但具体的应用 在python中创建一个窗口,然后显示出来. from Tkinter import * root = Tk() root.mainloop() 就3行就能够把主窗口显示出来了.root是一个变量名称,其代表了这个主窗口.以后创建控件

-

python字典操作实例详解

本文实例为大家分享了python字典操作实例的具体代码,供大家参考,具体内容如下 #!/usr/bin/env python3 # -*- coding: utf-8 -*- import turtle ##全局变量## #词频排列显示个数 count = 10 #单词频率数组-作为y轴数据 data = [] #单词数组-作为x轴数据 words = [] #y轴显示放大倍数-可以根据词频数量进行调节 yScale = 6 #x轴显示放大倍数-可以根据count数量进行调节 xScale =

-

用Pygal绘制直方图代码示例

Pygal可用来生成可缩放的矢量图形文件,对于需要在尺寸不同的屏幕上显示的图表,这很有用,可以自动缩放,自适应观看者的屏幕 1.Pygal模块安装 pygal的安装这里暂不介绍,大家可参阅<pip和pygal的安装实例教程> 2.Pygal画廊-直方图 模拟掷骰子,分析最后的结果,生成图形 创建die.py筛子类文件: from random import randint class Die(): '''扔骰子的类''' def __init__(self,num_sides=6): self

-

python下10个简单实例代码

注意:我用的python2.7,大家如果用Python3.0以上的版本,请记得在print()函数哦!如果因为版本问题评论的,不做回复哦!!! 1.题目:有1.2.3.4个数字,能组成多少个互不相同且无重复数字的三位数?都是多少? 程序分析:可填在百位.十位.个位的数字都是1.2.3.4.组成所有的排列后再去 掉不满足条件的排列. 程序源代码: # -*- coding: UTF-8 -*- for i in range(1,5): for j in range(1,5): for k in r

-

Python2与python3中 for 循环语句基础与实例分析

下面的代码中python2与python3的print使用区别,大家注意一下.python3需要加()才行. 语法: for循环的语法格式如下: for iterating_var in sequence: statements(s) 流程图: 实例: #!/usr/bin/python # -*- coding: UTF-8 -*- for letter in 'jb51.net': # 第一个实例 print '当前字母 :', letter fruits = ['banana', 'app

-

python密码错误三次锁定(实例讲解)

程序需求: 输入用户名,密码 认证成功显示欢迎信息 输入错误三次后锁定用户 流程图: 好像画的不咋地 查看代码: #!/usr/bin/env python # _*_ coding:utf-8 _*_ # File_type:一个登录接口 # Author:smelond import os username = "smelond"#用户名 password = "qweqwe"#密码 counter = 0#计数器 #读取黑名单 file = os.path.e

-

python利用有道翻译实现"语言翻译器"的功能实例

实例如下: import urllib.request import urllib.parse import json while True: content = input('请输入需要翻译的内容(退出输入Q):') if content == 'Q': break else: url = 'http://fanyi.youdao.com/translate?smartresult=dict&smartresult=rule&smartresult=ugc&sessionFrom

-

Python 将RGB图像转换为Pytho灰度图像的实例

问题: 我正尝试使用matplotlib读取RGB图像并将其转换为灰度. 在matlab中,我使用这个: img = rgb2gray(imread('image.png')); 在matplotlib tutorial中他们没有覆盖它.他们只是在图像中阅读 import matplotlib.image as mpimg img = mpimg.imread('image.png') 然后他们切片数组,但是这不是从我所了解的将RGB转换为灰度. lum_img = img[:,:,0] 编辑:

-

python pandas库中DataFrame对行和列的操作实例讲解

用pandas中的DataFrame时选取行或列: import numpy as np import pandas as pd from pandas import Sereis, DataFrame ser = Series(np.arange(3.)) data = DataFrame(np.arange(16).reshape(4,4),index=list('abcd'),columns=list('wxyz')) data['w'] #选择表格中的'w'列,使用类字典属性,返回的是S

-

对python中Matplotlib的坐标轴的坐标区间的设定实例讲解

如下所示: <span style="font-family: Arial, Helvetica, sans-serif;">>>> import numpy as np</span> >>> import matplotlib.pyplot as plt >>> x=np.arange(-5,5,0.01) >>> y=x**3 >>> plt.axis([-6,6,-1

-

Python中文分词库jieba(结巴分词)详细使用介绍

一,jieba的介绍 jieba 是目前表现较为不错的 Python 中文分词组件,它主要有以下特性: 支持四种分词模式: 精确模式 全模式 搜索引擎模式 paddle模式 支持繁体分词 支持自定义词典 MIT 授权协议 二,安装和使用 1,安装 pip3 install jieba 2,使用 import jieba 三,主要分词功能 1,jieba.cut 和jieba.lcut lcut 将返回的对象转化为list对象返回 传入参数解析: def cut(self, sentence, c

-

Python中文分词工具之结巴分词用法实例总结【经典案例】

本文实例讲述了Python中文分词工具之结巴分词用法.分享给大家供大家参考,具体如下: 结巴分词工具的安装及基本用法,前面的文章<Python结巴中文分词工具使用过程中遇到的问题及解决方法>中已经有所描述.这里要说的内容与实际应用更贴近--从文本中读取中文信息,利用结巴分词工具进行分词及词性标注. 示例代码如下: #coding=utf-8 import jieba import jieba.posseg as pseg import time t1=time.time() f=open(&q

-

python中文分词,使用结巴分词对python进行分词(实例讲解)

在采集美女站时,需要对关键词进行分词,最终采用的是python的结巴分词方法. 中文分词是中文文本处理的一个基础性工作,结巴分词利用进行中文分词. 其基本实现原理有三点: 1.基于Trie树结构实现高效的词图扫描,生成句子中汉字所有可能成词情况所构成的有向无环图(DAG) 2.采用了动态规划查找最大概率路径, 找出基于词频的最大切分组合 3.对于未登录词,采用了基于汉字成词能力的HMM模型,使用了Viterbi算法 安装(Linux环境) 下载工具包,解压后进入目录下,运行:python set

-

python中文分词+词频统计的实现步骤

目录 前言 一.文本导入 二.使用步骤 1.引入库 2.读入数据 3.取出停用词表 4.分词并去停用词(此时可以直接利用python原有的函数进行词频统计) 5. 输出分词并去停用词的有用的词到txt 6.函数调用 7.结果 附:输入一段话,统计每个字母出现的次数 总结 提示:文章写完后,目录可以自动生成,如何生成可参考右边的帮助文档 前言 本文记录了一下Python在文本处理时的一些过程+代码 一.文本导入 我准备了一个名为abstract.txt的文本文件 接着是在网上下载了stopword

-

Python中文分词实现方法(安装pymmseg)

本文实例讲述了Python中文分词实现方法.分享给大家供大家参考,具体如下: 在Python这pymmseg-cpp 还是十分方便的! 环境 ubuntu10.04 , python2.65 步骤: 1 下载mmseg-cpp的源代码 http://code.google.com/p/pymmseg-cpp/ 2 执行: tar -zxf pymmseg-cpp*.tar.gz //解压后得到pymmseg 目录 cd pymmseg\mmseg-cpp python build.py #生成

-

Python中文分词库jieba,pkusegwg性能准确度比较

中文分词(Chinese Word Segmentation),将中文语句切割成单独的词组.英文使用空格来分开每个单词的,而中文单独一个汉字跟词有时候完全不是同个含义,因此,中文分词相比英文分词难度高很多. 分词主要用于NLP 自然语言处理(Natural Language Processing),使用场景有: 搜索优化,关键词提取(百度指数) 语义分析,智能问答系统(客服系统) 非结构化文本媒体内容,如社交信息(微博热榜) 文本聚类,根据内容生成分类(行业分类) Python的中文分词 Pyt

-

python中文文本切词Kmeans聚类

目录 简介 一. 切词 二. 去除停用词 三. 构建词袋空间VSM(vector space model) 四. 将单词出现的次数转化为权值(TF-IDF) 五. 用K-means算法进行聚类 六. 总结 简介 查看百度搜索中文文本聚类我失望的发现,网上竟然没有一个完整的关于Python实现的中文文本聚类(乃至搜索关键词python 中文文本聚类也是如此),网上大部分是关于文本聚类的Kmeans聚类的原理,Java实现,R语言实现,甚至都有一个C++的实现. 正好我写的一些文章,我没能很好的分类

-

python中文分词库jieba使用方法详解

安装python中文分词库jieba 法1:Anaconda Prompt下输入conda install jieba 法2:Terminal下输入pip3 install jieba 1.分词 1.1.CUT函数简介 cut(sentence, cut_all=False, HMM=True) 返回生成器,遍历生成器即可获得分词的结果 lcut(sentence) 返回分词列表 import jieba sentence = '我爱自然语言处理' # 创建[Tokenizer.cut 生成器]

随机推荐

- 扩展方法ToJSON() and ParseJSON()

- bash脚本中if语句的使用方法

- jQuery html()等方法介绍

- BAT 参数去引号(各种去引号的奇葩方式)

- android按行读取文件内容的几个方法

- asp.net C#检查URL是否有效的方法

- TypeScript 学习笔记之基本类型

- JS 清除字符串数组中,重复元素的实现方法

- PHP Session变量不能传送到下一页的解决方法

- Ajax跨域问题的解决办法汇总(推荐)

- 一步步教你整合SSM框架(Spring MVC+Spring+MyBatis)详细教程

- 浅析nodejs实现Websocket的数据接收与发送

- 关于制作一个通用的DOS批处理段注释命令的思路介绍

- Linux本机与服务器文件互传及Linux服务器文件上传下载命令写法

- JavaScript实现的链表数据结构实例

- 深入理解Javascript动态方法调用与参数修改的问题

- 对setInterval在火狐和chrome切换标签产生奇怪的效果之探索,与解决方案!

- C#实现创建,删除,查找,配置虚拟目录实例详解

- Java异常 Exception类及其子类(实例讲解)

- python实现学生管理系统