python机器学习Logistic回归原理推导

目录

- 前言

- Logistic回归原理与推导

- sigmoid函数

- 目标函数

- 梯度上升法

- Logistic回归实践

- 数据情况

- 训练算法

- 算法优缺点

前言

Logistic回归涉及到高等数学,线性代数,概率论,优化问题。本文尽量以最简单易懂的叙述方式,以少讲公式原理,多讲形象化案例为原则,给读者讲懂Logistic回归。如对数学公式过敏,引发不适,后果自负。

Logistic回归原理与推导

Logistic回归中虽然有回归的字样,但该算法是一个分类算法,如图所示,有两类数据(红点和绿点)分布如下,如果需要对两类数据进行分类,我们可以通过一条直线进行划分(w0 * x0 + w1 * x1+w2 * x2)。当新的样本(x1,x2)需要预测时,带入直线函数中,函数值大于0,则为绿色样本(正样本),否则为红样本(负样本)。

推广到高维空间中,我们需要得到一个超平面(在二维是直线,在三维是平面,在n维是n-1的超平面)切分我们的样本数据,实际上也就是求该超平面的W参数,这很类似于回归,所以取名为Logistic回归。

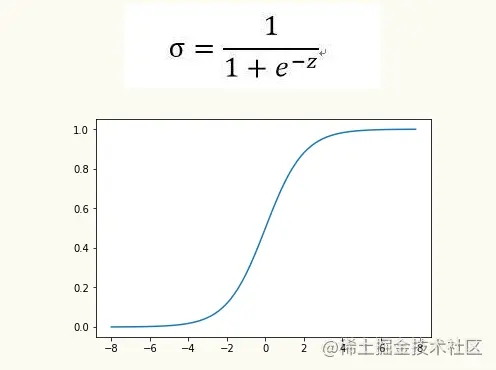

sigmoid函数

当然,我们不直接使用z函数,我们需要把z值转换到区间[0-1]之间,转换的z值就是判断新样本属于正样本的概率大小。 我们使用sigmoid函数完成这个转换过程,公式如下。通过观察sigmoid函数图,如图所示,当z值大于0时,σ值大于0.5,当z值小于0时,σ值小于于0.5。利用sigmoid函数,使得Logistic回归本质上是一个基于条件概率的判别模型。

目标函数

其实,我们现在就是求W,如何求W呢,我们先看下图,我们都能看出第二个图的直线切分的最好,换句话说,能让这些样本点离直线越远越好,这样对于新样本的到来,也具有很好的划分,那如何用公式表示并计算这个目标函数呢?

这时就需要这个目标函数的值最大,以此求出θ。

梯度上升法

在介绍梯度上升法之前,我们看一个中学知识:求下面函数在x等于多少时,取最大值。

解:求f(x)的导数:2x,令其为0,求得x=0时,取最大值为0。但在函数复杂时,求出导数也很难计算函数的极值,这时就需要使用梯度上升法,通过迭代,一步步逼近极值,公式如下,我们顺着导数的方向(梯度)一步步逼近。

利用梯度算法计算该函数的x值:

def f(x_old):

return -2*x_old

def cal():

x_old = 0

x_new = -6

eps = 0.01

presision = 0.00001

while abs(x_new-x_old)>presision:

x_old=x_new

x_new=x_old+eps*f(x_old)

return x_new

-0.0004892181072978443

Logistic回归实践

数据情况

读入数据,并绘图显示:

def loadDataSet():

dataMat = [];labelMat = []

fr = open('数据/Logistic/TestSet.txt')

for line in fr.readlines():

lineArr = line.strip().split()

dataMat.append([1.0, float(lineArr[0]), float(lineArr[1])])

labelMat.append(int(lineArr[2]))

return dataMat, labelMat

训练算法

利用梯度迭代公式,计算W:

def sigmoid(inX):

return 1.0/(1 + np.exp(-inX))

def gradAscent(dataMatIn, labelMatIn):

dataMatrix = np.mat(dataMatIn)

labelMat = np.mat(labelMatIn).transpose()

m,n = np.shape(dataMatrix)

alpha = 0.001

maxCycles = 500

weights = np.ones((n,1))

for k in range(maxCycles):

h = sigmoid(dataMatrix * weights)

error = labelMat - h

weights = weights + alpha * dataMatrix.transpose() * error

return weights

通过计算的weights绘图,查看分类结果

算法优缺点

- 优点:易于理解和计算

- 缺点:精度不高

以上就是python机器学习Logistic回归原理推导的详细内容,更多关于python机器学习Logistic回归的资料请关注我们其它相关文章!