python将类似json的数据存储到MySQL中的实例

由于之前对于爬取下来的数据都是存入MongoDB中,想起来还没有尝试存入MySQL,于是将一篇简单的文章爬取下来,存入MySQL试试

这里用到的python模块是pymysql,因为MySQLdb之前已经停止维护

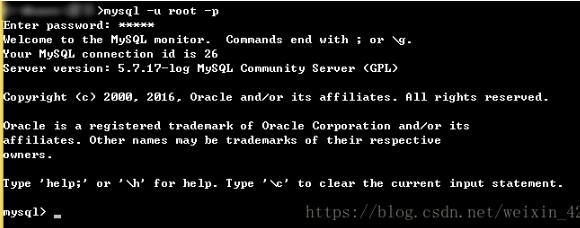

首先在cmd中连接MySQL并且创建一个数据库json

在图形化界面workbench中可以看到

接下来就要在pycharm中写代码了,在pycharm中导入pymysql后即可

#建立python与MySQL之间的连接 mysql = pymysql.connect(host="localhost",user="root",passwd="12138",db="json",charset="utf8") #新建游标 cur = mysql.cursor() #原生sql语句,创建一个名为jsondata的表,并在其中定义字段 sqlc = ''' create table if not exists jsondata( typeid int(11) not null auto_increment primary key, tagid varchar(20) not null, title varchar(100) not null, time varchar(20) not null, content mediumtext not null)DEFAULT CHARSET=utf8; ''' #执行语句 a = cur.execute(sqlc) #提交任务 mysql.commit() print 'success' #sql,插入数据 sqla = ''' insert into jsondata(typeid,tagid,title,time,content)values(%s,%s,%s,%s,%s); ''' #这里的data数据为列表,data[0]中存在的字典类型数据 b = cur.execute(sqla,(data[0]['typeid'],data[0]['tagid'],data[0]['title'],data[0]['time'],data[0]['content'])) mysql.commit() cur.close() mysql.close() print 'success'

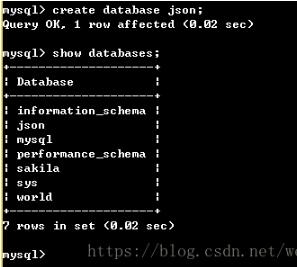

运行之后,先在cmd中看看有什么变化,使用json,并且查看table

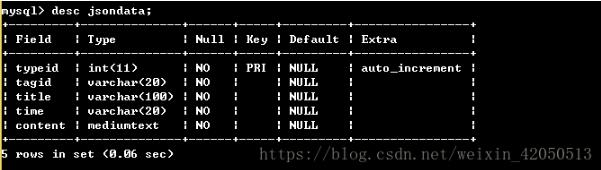

再看看表中的数据

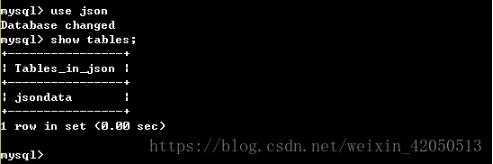

这就是之前定义的jsondata表,可是没有看到具体插入的数据

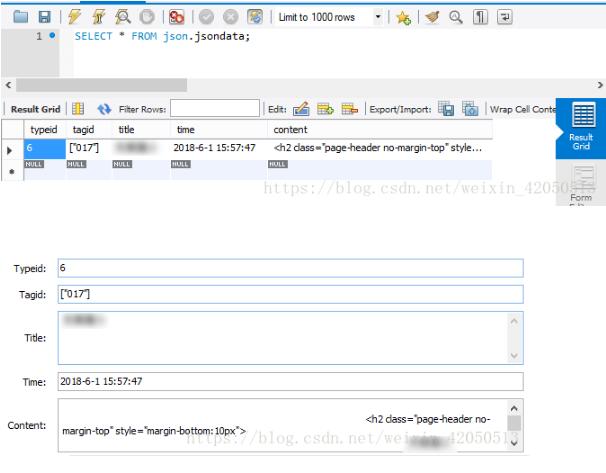

所以接下来看看workbench

可以见到数据成功存储到MySQL中了!

以上这篇python将类似json的数据存储到MySQL中的实例就是小编分享给大家的全部内容了,希望能给大家一个参考,也希望大家多多支持我们。

相关推荐

-

Python JSON格式数据的提取和保存的实现

环境:python-3.6.5 JSON JSON(JavaScript Object Notation) 是一种轻量级的数据交换格式,它使得人们很容易的进行阅读和编写.同时也方便了机器进行解析和生成.适用于进行数据交互的场景,比如网站前台与后台之间的数据交互. Python中自带了json模块,直接import json即可使用 官方文档:https://docs.python.org/3/library/json.html Json在线解析网站:https://www.json.cn/# j

-

python查询mysql,返回json的实例

如下所示: import MySQLdb import json def getSql(): try: con = MySQLdb.connect(host='localhost', user='', passwd='', db='test', charset='utf8') cursor = con.cursor() sql = "select * from user" cursor.execute(sql) results = cursor.fetchmany(5) users =

-

Python3实现将本地JSON大数据文件写入MySQL数据库的方法

本文实例讲述了Python3实现将本地JSON大数据文件写入MySQL数据库的方法.分享给大家供大家参考,具体如下: 最近导师给了一个yelp上的评论数据,数据量达到3.55个G,如果进行分析时直接使用本地文件,选择python来分析,那么效率是非常低的:另一方面使用SQL来储存文本文件最为安全,之前使用CSV,txt存储的文本文件最后莫名其妙地出现一些奇怪字符,导致读取数据分割时出现错乱.下面给出一个简单的代码,将本地JSON文件内容存入数据库. 说明:python版本为3.5,使用第三方库为

-

Python操作json数据的一个简单例子

更多的信息,可以参考python内部的json文档: python>>> help(json) 或者官方文档: http://docs.python.org/library/json.html#module-json. 下面给出一个使用python解析json的简单例子: 复制代码 代码如下: #!/usr/bin/python import json #Function:Analyze json script #Json is a script can descript data st

-

用Python将mysql数据导出成json的方法

1.相关说明 此脚本可以将Mysql的数据导出成Json格式,导出的内容可以进行select查询确定. 数据传入参数有:dbConfigName, selectSql, jsonPath, fileName. 依赖的库有:MySQLdb.json,尤其MySQLdb需要事先安装好. 2.Python脚本及测试示例 /Users/nisj/PycharmProjects/BiDataProc/oldPythonBak/mysqlData2json.py # -*- coding=utf-8 -*-

-

使用python将mysql数据库的数据转换为json数据的方法

由于产品运营部需要采用第三方个推平台,来推送消息.如果手动一个个键入字段和字段值,容易出错,且非常繁琐,需要将mysql的数据转换为json数据,直接复制即可. 本文将涉及到如何使用Python访问Mysql数据库及读取获取数据(前提需要安装MySQLdb第三方库哦),以及如何将数据转换为json数据,最后保存成文件输出. 代码如下:注释比较详细了. # coding=utf-8 ''' Created on 2016-10-26 @author: Jennifer Project:读取mysq

-

python将类似json的数据存储到MySQL中的实例

由于之前对于爬取下来的数据都是存入MongoDB中,想起来还没有尝试存入MySQL,于是将一篇简单的文章爬取下来,存入MySQL试试 这里用到的python模块是pymysql,因为MySQLdb之前已经停止维护 首先在cmd中连接MySQL并且创建一个数据库json 在图形化界面workbench中可以看到 接下来就要在pycharm中写代码了,在pycharm中导入pymysql后即可 #建立python与MySQL之间的连接 mysql = pymysql.connect(host="lo

-

Python 抓取数据存储到Redis中的操作

redis是一个key-value存储结构.和Memcached类似,它支持存储的value类型相对更多,包括string(字符串).list(链表).set(集合).zset(sorted set 有序集合)和hash(哈希类型),数据存储如下图分析 为了分别为ID存入多个键值对,此次仅对Hash数据进行操作,例子如下 import os,sys import requests import bs4 import redis #连接Redis r = redis.Redis(host='127

-

对python requests发送json格式数据的实例详解

requests是常用的请求库,不管是写爬虫脚本,还是测试接口返回数据等.都是很简单常用的工具. 这里就记录一下如何用requests发送json格式的数据,因为一般我们post参数,都是直接post,没管post的数据的类型,它默认有一个类型的,貌似是 application/x-www-form-urlencoded. 但是,我们写程序的时候,最常用的接口post数据的格式是json格式.当我们需要post json格式数据的时候,怎么办呢,只需要添加修改两处小地方即可. 详见如下代码: i

-

python实现将json多行数据传入到mysql中使用

将json多行数据传入到mysql中使用python实现 表需要提前创建,字符集utf8 如果不行换成utf8mb4 import json import pymysql def reviewdata_insert(db): with open('data.txt', encoding='utf-8') as f: i = 0 while True: i += 1 print(u'正在载入第%s行......' % i) try: lines = f.readline() # 使用逐行读取的方法

-

Python爬取数据并写入MySQL数据库的实例

首先我们来爬取 http://html-color-codes.info/color-names/ 的一些数据. 按 F12 或 ctrl+u 审查元素,结果如下: 结构很清晰简单,我们就是要爬 tr 标签里面的 style 和 tr 下几个并列的 td 标签,下面是爬取的代码: #!/usr/bin/env python # coding=utf-8 import requests from bs4 import BeautifulSoup import MySQLdb print('连接到m

-

如何把ACCESS的数据导入到Mysql中

如何把ACCESS的数据导入到Mysql中 www.Alltips.Com 2001-10-6 极限技术网 在建设网站的过程中,经常要处理一些数据的导入及导出.在Mysql数据库中,有两种方法来处理数据的导出(一般). 1. 使用select * from table_name into outfile "file_name"; 2. 使用mysqldump实用程序 下面我们来举例说明: 假设我们的数据库中有一个库为samp_db,一个表为samp_table.现在

-

PHP将数据导出Excel表中的实例(投机型)

1.简介 如何利用最简单粗糙暴力的方法将数据写入Excel文件中呢? 因为ms word和excel的文档都支持html文本格式,因此我们可以基于这个原理采用html文本格式进行数据的输出. 在html中,我们只需要将数据照着所想要的顺序放进相应的html表格中即可. 我们采用PHP进行数据获取整理以及构造相应的html文本,最后通过字节流输出下载到用户本地. 2.代码 直接上代码,这是一个很简单的程序,里面都带有注释了. ExportExcel.class.php文件 <?php class

-

python Selenium爬取内容并存储至MySQL数据库的实现代码

前面我通过一篇文章讲述了如何爬取CSDN的博客摘要等信息.通常,在使用Selenium爬虫爬取数据后,需要存储在TXT文本中,但是这是很难进行数据处理和数据分析的.这篇文章主要讲述通过Selenium爬取我的个人博客信息,然后存储在数据库MySQL中,以便对数据进行分析,比如分析哪个时间段发表的博客多.结合WordCloud分析文章的主题.文章阅读量排名等. 这是一篇基础性的文章,希望对您有所帮助,如果文章中出现错误或不足之处,还请海涵.下一篇文章会简单讲解数据分析的过程. 一. 爬取的结果 爬

-

scrapy数据存储在mysql数据库的两种方式(同步和异步)

方法一:同步操作 1.pipelines.py文件(处理数据的python文件) import pymysql class LvyouPipeline(object): def __init__(self): # connection database self.connect = pymysql.connect(host='XXX', user='root', passwd='XXX', db='scrapy_test') # 后面三个依次是数据库连接名.数据库密码.数据库名称 # get c

随机推荐

- angular动态删除ng-repaeat添加的dom节点的方法

- SQLite3中自增主键相关知识总结

- JavaScript类和继承 constructor属性

- java获取昨天日期字符串的方法

- JS实现线性表的顺序表示方法示例【经典数据结构】

- 一段非常简单的让图片自动切换js代码

- asp.net水晶报表参数字段在代码中赋值的方法

- php数值转换时间及时间转换数值用法示例

- php递归遍历删除文件的方法

- asp 实现当有新信息时播放语音提示的效果

- Android屏幕分辨率工具类使用详解

- dos或wamp下修改mysql密码的具体方法

- 浅析Yii中使用RBAC的完全指南(用户角色权限控制)

- iOS+PHP注册登录系统 PHP部分(上)

- javascript suggest效果 自动完成实现代码分享

- java 算法之快速排序实现代码

- Jquery实现鼠标移动放大图片功能实例

- 一个最简单的级联下拉菜单

- 使用Windows防火墙十大经典问题荟萃

- java中对字符串每个字符统计的方法