node-red File读取好保存实例讲解

File节点是操作文件的节点

file文件的保存

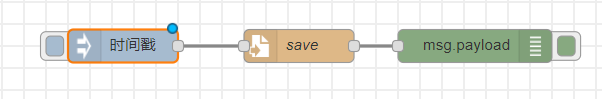

拖拽 注入节点inject file节点(writes msg.payload to a file)和 debug节点到工作区,并连线

设置file节点的文件路径

windows如果不设置路径,会保存在C:\Users\Administratordocker容器保存在根目录下

此处文件名我选择 放到data目录下,因为docker容器启动的时候我把/data目录挂载到宿主机上了,方便查看文件

行为有三种,追加至文件 复写文件 删除文件

勾选上创建目录,否则如果目录和文件不存在,需要手动创建

例子:

[{"id":"898828bc.89b418","type":"inject","z":"6c70a17b.e110f","name":"","topic":"","payload":"","payloadType":"date","repeat":"","crontab":"","once":false,"onceDelay":0.1,"x":290,"y":300,"wires":[["1e951d4f.b4d6a3"]]},{"id":"1e951d4f.b4d6a3","type":"file","z":"6c70a17b.e110f","name":"save","filename":"/data/testtimestamp.txt","appendNewline":true,"createDir":true,"overwriteFile":"false","encoding":"none","x":450,"y":300,"wires":[["c27669f0.bef7e8"]]},{"id":"c27669f0.bef7e8","type":"debug","z":"6c70a17b.e110f","name":"","active":true,"tosidebar":true,"console":false,"tostatus":false,"complete":"false","x":610,"y":300,"wires":[]}]

文件的读取

文件的读取和保存类似

把上面的file写节点换成file读节点(Reads the contents of a file...)

第一个注入节点inject只是启动发送信号作用

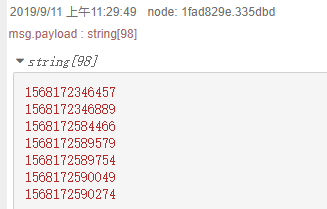

debug区域显示文件内容:

以上就是关于node-red File读取好保存的全部知识点内容,感谢大家对我们的支持。

赞 (0)