Python迅速掌握语音识别之知识储备篇

目录

- 概述

- RNN

- 计算

- RNN 存在的问题

- LSTM

- GRU

- Seq2seq

- Attention 模型

- Teacher Forcing 机制

概述

从今天开始我们将开启一个新的深度学习章节, 为大家来讲述一下深度学习在语音识别 (Speech Recognition) 的应用. 语音识别技术可以将语音转换为计算机可读的输入, 让计算机明白我们要表达什么, 实现真正的人机交互. 希望通过本专栏的学习, 大家能够对语音识别这一领域有一个基本的了解.

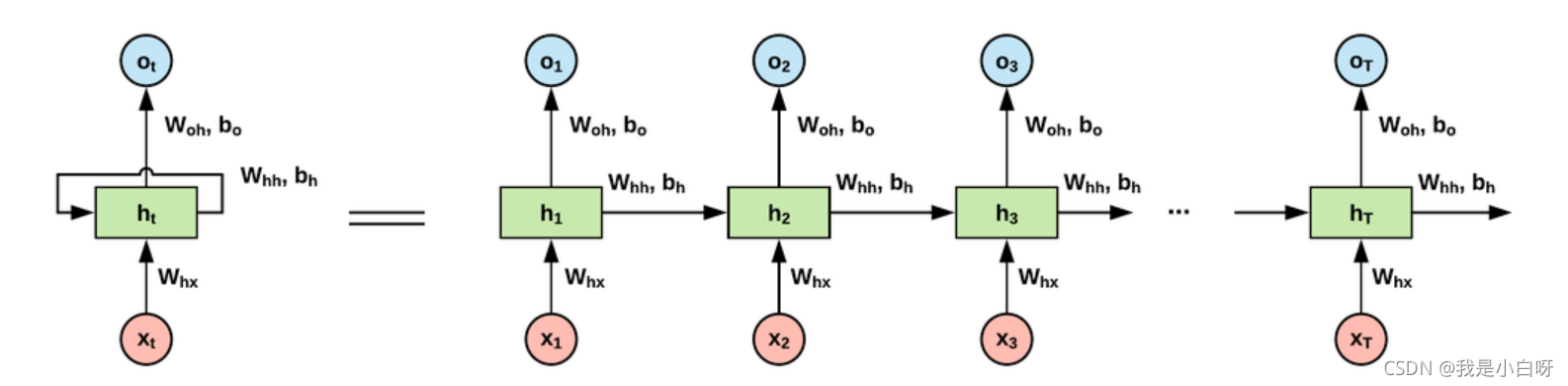

RNN

RNN (Recurrent Neural Network) 即循环神经网络, 用于处理输入有相关性的任务. RNN 网络包括一个输入层, 一个隐层, 和一个输出层组成, 如图:

计算

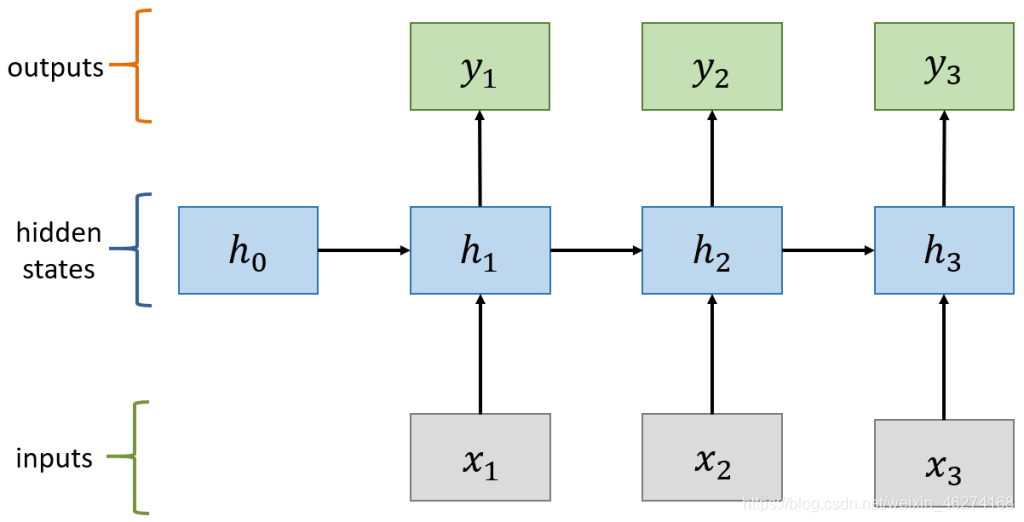

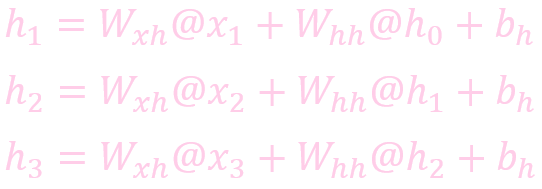

隐层 (Hidden Layer) 定义了整个网络的状态, RNN 网络的计算过程如下:

计算状态 (State)

计算输出:

RNN 存在的问题

梯度消失问题 (Vanishing gradient problem). 如果导数小于 1, 随着网络层数的增加梯度跟新会朝着指数衰减的方向前进, 这就是梯度消失, 如图:

我们可以看出, 随着时间的增加, 深层的网络对浅层的感知变得越来越微弱, 梯度接近于0.

梯度爆炸问题 (Exploding gradient problem). 如果导数大于 1, 随着网络层数的增加梯度跟新会朝着指数增加的方向前进, 这就是梯度爆炸. 当 RNN 网络导数大于 1 时就会出现时序依赖, 从而造成梯度爆炸.

LSTM

LSTM (Long Short Term Memory), 即长短期记忆模型. LSTM 是一种特殊的 RNN 模型, 解决了长序列训练过程中的梯度消失和梯度爆炸的问题. 相较于普通 RNN, LSTM 能够在更长的序列中有更好的表现. 相比 RNN 只有一个传递状态 ht, LSTM 有两个传递状态: ct (cell state) 和 ht (hidden state).

LSTM 增加了输入门, 输出门, 遗忘门 三个控制单元. LSTM 的 cell 会决定哪些信息被留下, 哪些信息被遗忘, 从而解决神经网络中长序列依赖的问题.

GRU

GRU (Gate Recurrent Unit) 和 LSTM 类似, 但是更易于计算. GRU 由重置门, 更新门, 和输出门组成. 重置门和 LSTM 的遗忘文作用一样, 用于决定信息的去留. 同理, 更新门的作用类似于 LSTM 的输入门.

Seq2seq

Seq2seq 由 Encoder 和 Decoder 两个 RNN 组成. Encoder 将变长序列输出, 编码成 encoderstate 再由 Decoder 输出变长序列.

Attention 模型

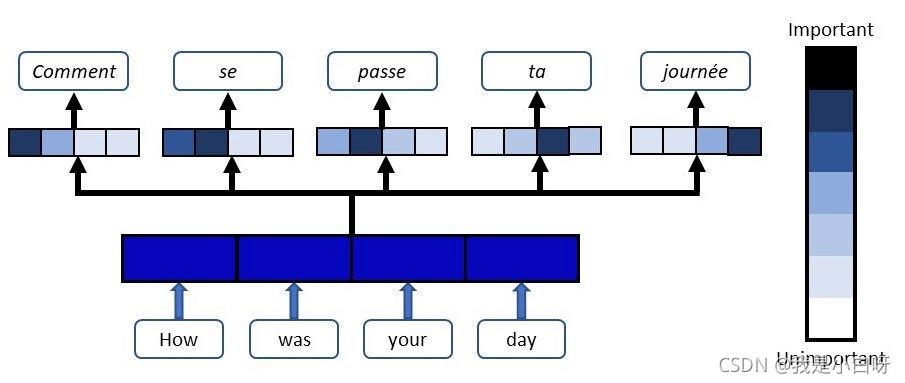

Attention 是一种用于提升 RNN 的 Encoder 和 Decoder 模型的效果的机制. 广泛应用于机器翻译, 语音识别, 图像标注等多个领域. 深度学习中的注意力机制从本质上讲和人类的选择性视觉注意力机制类似. 核心目标也是从众多信息中选择出对当前任务目标更关键的信息.

Attention 实质上是一种 content-based addressing 的机制. 即从网络中某些状态集合中选取给定状态较为相似的状态, 进而做后续的信息抽取.

首先根据 Encoder 和 Decoder 的特征计算权值, 然后对 Encoder 的特征进行加权求和, 作为 Decoder 的输入. 其作用的将 Encoder 的特征以更好的方式呈献给 Decoder. (并不是所有的 context 都对下一个状态的生成产生影响, Attention 就是选择恰当的 context 用它生成下一个状态.

Teacher Forcing 机制

早起的 RNN 在训练过程中的预测能力非常弱, 如果一个 unit 预测错了, 后面的 unit 就很难再获取对的结果. 比如我们翻译一句话:

- Life is like a box of chocolates.You never know what you're going to get

- 人生就像一盒巧克力,你永远也不知道下一块是什么味道

如果我们把 life 翻译成 “西伯利亚”, 那么后面再翻译对的可能性就几乎为 0.

Teacher Forcing 是一种网络训练的方法, 使用上一个 label 作为下一个 state 的输入. 还是用上面的例子说明: 当使用 Teacher Forcing 机制的时候, 即时我们把 life 翻译成 “西伯利亚”, 下一个 Decoder 的输入我们会使用上一个的 label 作为 state, 即 “人生”, 而不是 “西伯利亚”. 这样就大大提高了 RNN 网络的预测能力.

到此这篇关于Python迅速掌握语音识别之知识储备篇的文章就介绍到这了,更多相关Python 语音识别内容请搜索我们以前的文章或继续浏览下面的相关文章希望大家以后多多支持我们!