Python数据分析与处理(二)——处理中国地区信息

目录

- 2.1数据的爬取

- 2.2检查重复数据

- 2.3检查缺失值

- 2.4 检查异常值

2.1数据的爬取

代码:

import pandas as pd

data=pd.read_csv("example_data.csv",header=1)

print(data)

data1=pd.read_csv("北京地区信息.csv",header=1,encoding='gbk')

data2=pd.read_csv("天津地区信息.csv",encoding='gbk')

print(data1)

print(data2)

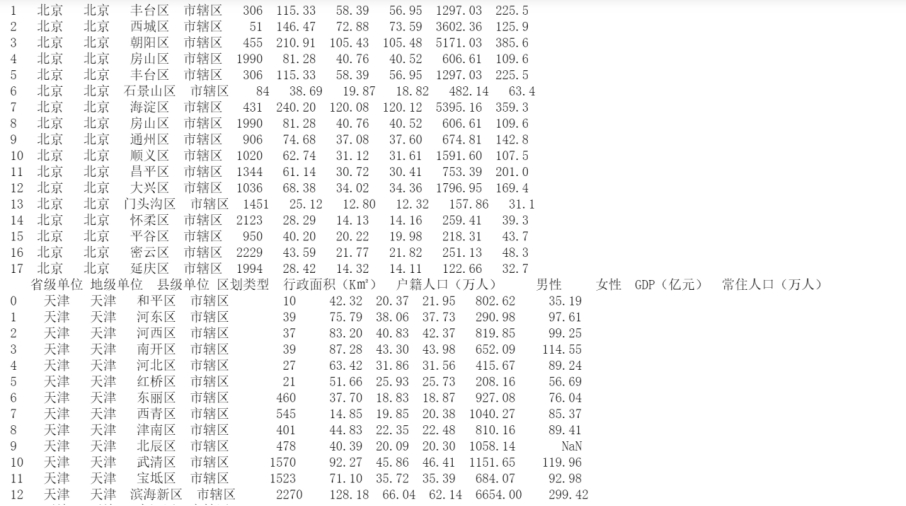

代码运行结果:

首先使用pandas的read_csv()方法进行数据的读取,然后就能够看到相应的表格信息。

2.2检查重复数据

dupnum=data.duplicated() print(dupnum) \# 对重复值进行处理 caldup=data.drop_duplicates() print(caldup)

代码运行结果:

主要是是使用这个duplicated()方法进行数据的查重,返回一个布尔序列,仅对唯一元素而言为True。如果有重复的数据就会在该数值的部分返货Flase。

然后我们就可以使用drop_duplicates()进行重复值删除。

2.3检查缺失值

代码:

from pandas import Series from numpy import NAN \# import pandas as pd series_obj=Series([1,None]) pd.notnull(series_obj) \# 上面做的是测试 pd.notnull(data) pd.notnull(data1) pd.notnull(data2)

代码运行结果:

使用pd.notnull(data1)进行非空数值的返回, 返回值是布尔型的矩阵,再取df[布尔型矩阵]返回的是id为非空的行。

2.4 检查异常值

import numpy as np \# 2.4 检查异常值 def three_sig(ser1): mean_value=ser1.mean() \# 标准差 std_value=ser1.std() \# 位于3σ范围外的都是异常值 \# 数值大于u+3σ小雨u-3σ rule=(mean_value-3*std_value>ser1)|(ser1.mean()+3*ser1.std()<ser1) index=np.arange(ser1.shape[0])[rule] outrange=ser1.iloc[index] return outrange three_sig(data2["女性"])

代码运行结果:

3σ原则又称为拉依达准则,该准则具体来说,就是先假设一组检测数据只含有随机误差,对原始数据进行计算处理得到标准差,然后按一定的概率确定一个区间,认为误差超过这个区间的就属于异常值。

通俗理解就是正态分布。

到此这篇关于Python数据分析与处理--处理中国地区信息的文章就介绍到这了,更多相关Python Python数据分析与处理内容请搜索我们以前的文章或继续浏览下面的相关文章希望大家以后多多支持我们!

相关推荐

-

Python数据分析与处理(一)--北京高考分数线统计分析

目录 1.1 数据爬取 1.2 最高分最低分统计 1.3 一本二本理科差值统计 1.4 2006-2019年近14年每科分数线的平均值统计 前言: 为了帮助广大考生和家长了解高考历年的录取情况,很多网站都汇总了各省市的录取控制分数线,为广大考生填报志愿提供参考.因受多种因素影响,每年的分数线或多或少会有一些变动.采集北京2006-2019年的信息.使用Python的Pandas库完成以下数据分析. 1.1 数据爬取 包含三部分内容:从哪里爬取,如何爬取,爬取的结果 代码: import pand

-

利用python数据分析处理进行炒股实战行情

作为一个新手,你需要以下3个步骤: 1.用户注册 > 2.获取token > 3.调取数据 数据内容: 包含股票.基金.期货.债券.外汇.行业大数据, 同时包括了数字货币行情等区块链数据的全数据品类的金融大数据平台, 为各类金融投资和研究人员提供适用的数据和工具. 1.数据采集 我们进行本地化计算,首先要做的,就是将所需的基础数据采集到本地数据库里 本篇的示例源码采用的数据库是MySQL5.5,数据源是xxx pro接口. 我们现在要取一批特定股票的日线行情 部分代码如下: # 设置xxxxx

-

30 个 Python 函数,加速数据分析处理速度

目录 1.删除列 2.选择特定列 3.nrows 4.样品 5.检查缺失值 6.使用 loc 和 iloc 添加缺失值 7.填充缺失值 8.删除缺失值 9.根据条件选择行 10.用查询描述条件 11.用 isin 描述条件 12.Groupby 函数 13.Groupby与聚合函数结合 14.对不同的群体应用不同的聚合函数 15.重置索引 16.重置并删除原索引 17.将特定列设置为索引 18.插入新列 19.where 函数 20.等级函数 21.列中的唯一值数 22.内存使用情况 23.数据

-

Python数据分析的八种处理缺失值方法详解

目录 1. 删除有缺失值的行或列 2. 删除只有缺失值的行或列 3. 根据阈值删除行或列 4. 基于特定的列子集删除 5. 填充一个常数值 6. 填充聚合值 7. 替换为上一个或下一个值 8. 使用另一个数据框填充 总结 技术交流 在本文中,我们将介绍 8 种不同的方法来解决缺失值问题,哪种方法最适合特定情况取决于数据和任务.欢迎收藏学习,喜欢点赞支持,技术交流可以文末加群,尽情畅聊. 让我们首先创建一个示例数据框并向其中添加一些缺失值. 我们有一个 10 行 6 列的数据框. 下一步是添加缺失

-

python使用dabl几行代码实现数据处理分析及ML自动化

目录 dabl 1.数据预处理 2.探索性数据分析 3.建模 结论 数据科学模型开发涉及各种组件,包括数据收集.数据处理.探索性数据分析.建模和部署.在训练机器学习或深度学习模型之前,必须清洗数据集并使其适合训练.通常这些过程是重复的,且占用了大部时间. 为了克服这个问题,今天我分享一个名为 dabl 的开源 Python 工具包,它可以自动化机器学习模型开发,包括数据预处理.特征可视化和分析.建模.欢迎收藏学习,喜欢点赞支持. dabl dabl 是一个数据分析基线库,可以让机器学习建模更容易

-

Python数据分析之缺失值检测与处理详解

目录 检测缺失值 缺失值处理 删除缺失值 填补缺失值 检测缺失值 我们先创建一个带有缺失值的数据框(DataFrame). import pandas as pd df = pd.DataFrame( {'A': [None, 2, None, 4], 'B': [10, None, None, 40], 'C': [100, 200, None, 400], 'D': [None, 2000, 3000, None]}) df 数值类缺失值在 Pandas 中被显示为 NaN (Not A N

-

Python数据分析与处理(二)——处理中国地区信息

目录 2.1数据的爬取 2.2检查重复数据 2.3检查缺失值 2.4 检查异常值 2.1数据的爬取 代码: import pandas as pd data=pd.read_csv("example_data.csv",header=1) print(data) data1=pd.read_csv("北京地区信息.csv",header=1,encoding='gbk') data2=pd.read_csv("天津地区信息.csv",encodi

-

Python数据分析之Python和Selenium爬取BOSS直聘岗位

一.数据爬取的代码 #encoding='utf-8' from selenium import webdriver import time import re import pandas as pd import os def close_windows(): #如果有登录弹窗,就关闭 try: time.sleep(0.5) if dr.find_element_by_class_name("jconfirm").find_element_by_class_name("c

-

Python数据分析之 Matplotlib 折线图绘制

目录 一.Matplotlib 绘图 简单示例 二.折线图绘制 一.Matplotlib 绘图 在数据分析中,数据可视化也非常重要,通过直观的展示过程.结果数据,可以帮助我们清晰的理解数据,进而更好的进行分析.接下来就说一下Python数据分析中的数据可视化工具 Matplotlib 库. Matplotlib 是一个非常强大的Python 2D绘图库,使用它,我们可以通过图表的形式更直观的展现数据,实现数据可视化,使用起来也非常方便,而且支持绘制折线图.柱状图.饼图.直方图.散点图等. 可以使

-

Python数据分析模块pandas用法详解

本文实例讲述了Python数据分析模块pandas用法.分享给大家供大家参考,具体如下: 一 介绍 pandas(Python Data Analysis Library)是基于numpy的数据分析模块,提供了大量标准数据模型和高效操作大型数据集所需要的工具,可以说pandas是使得Python能够成为高效且强大的数据分析环境的重要因素之一. pandas主要提供了3种数据结构: 1)Series,带标签的一维数组. 2)DataFrame,带标签且大小可变的二维表格结构. 3)Panel,带标

-

Python数据分析:手把手教你用Pandas生成可视化图表的教程

大家都知道,Matplotlib 是众多 Python 可视化包的鼻祖,也是Python最常用的标准可视化库,其功能非常强大,同时也非常复杂,想要搞明白并非易事.但自从Python进入3.0时代以后,pandas的使用变得更加普及,它的身影经常见于市场分析.爬虫.金融分析以及科学计算中. 作为数据分析工具的集大成者,pandas作者曾说,pandas中的可视化功能比plt更加简便和功能强大.实际上,如果是对图表细节有极高要求,那么建议大家使用matplotlib通过底层图表模块进行编码.当然,我

-

Python数据分析之双色球中蓝红球分析统计示例

本文实例讲述了Python数据分析之双色球中蓝红球分析统计.分享给大家供大家参考,具体如下: 这里接着上一篇Python数据分析之获取双色球历史信息收集的数据处理下, newdata.txt数据样子 ... 2005-08-21, 05,10,23,27,28,30,15 2005-08-18, 04,05,17,18,26,33,04 2005-08-16, 09,12,18,21,28,29,05 ... 一.蓝球统计: analyze_data_lan.py #!/usr/bin/pyth

-

Python数据分析pandas模块用法实例详解

本文实例讲述了Python数据分析pandas模块用法.分享给大家供大家参考,具体如下: pandas pandas10分钟入门,可以查看官网:10 minutes to pandas 也可以查看更复杂的cookbook pandas是非常强大的数据分析包,pandas 是基于 Numpy 构建的含有更高级数据结构和工具的数据分析包.就好比 Numpy的核心是 ndarray,pandas 围绕着 Series 和 DataFrame 两个核心数据结构展开 .Series和DataFrame 分

-

python数据分析工具之 matplotlib详解

不论是数据挖掘还是数学建模,都免不了数据可视化的问题.对于 Python 来说,matplotlib 是最著名的绘图库,它主要用于二维绘图,当然也可以进行简单的三维绘图.它不但提供了一整套和 Matlab 相似但更为丰富的命令,让我们可以非常快捷地用 python 可视化数据. matplotlib基础 # 安装 pip install matplotlib 两种绘图风格: MATLAB风格: 基本函数是 plot,分别取 x,y 的值,然后取到坐标(x,y)后,对不同的连续点进行连线. 面向对

-

python数据分析之公交IC卡刷卡分析

一.背景 交通大数据是由交通运行管理直接产生的数据(包括各类道路交通.公共交通.对外交通的刷卡.线圈.卡口.GPS.视频.图片等数据).交通相关行业和领域导入的数据(气象.环境.人口.规划.移动通信手机信令等数据),以及来自公众互动提供的交通状况数据(通过微博.微信.论坛.广播电台等提供的文字.图片.音视频等数据)构成的. 现在给出了一个公交刷卡样例数据集,包含有交易类型.交易时间.交易卡号.刷卡类型.线路号.车辆编号.上车站点.下车站点.驾驶员编号.运营公司编号等.试导入该数据集并做分析. 二

-

python数据分析之用sklearn预测糖尿病

一.数据集描述 本数据集内含十个属性列 Pergnancies: 怀孕次数 Glucose:血糖浓度 BloodPressure:舒张压(毫米汞柱) SkinThickness:肱三头肌皮肤褶皱厚度(毫米) Insulin:两个小时血清胰岛素(μU/毫升) BMI:身体质量指数,体重除以身高的平方 Diabets Pedigree Function: 疾病血统指数 是否和遗传相关,Height:身高(厘米) Age:年龄 Outcome:0表示不患病,1表示患病. 任务:建立机器学习模型以准确预

随机推荐

- 三种带箭头提示框总结实例

- asp.net 错误:0x8007000B 异常的解决方法

- php发送get、post请求的6种方法简明总结

- node.js中实现同步操作的3种实现方法

- Angularjs 滚动加载更多数据

- php中防止SQL注入的最佳解决方法

- Java读取txt文件和写入txt文件的简单实例

- WINDOWS下php5.2.4+mysql6.0+apache2.2.4+ZendOptimizer-3.3.0配置

- javascript下判断一个元素是否存在的代码

- Python实现小数转化为百分数的格式化输出方法示例

- C#图像对比度调整的方法

- 桑塔纳路考的注意事项小结(国内外)第1/2页

- PHP大小写问题:函数名和类名不区分,变量名区分

- 哈夫曼的c语言实现代码

- 学习Winform分组类控件(Panel、groupBox、TabControl)

- JS基于面向对象实现的放烟花效果

- 服务器禁止被ping的设置方法(图文)

- java反射简单实例

- Java微信公众平台开发(5) 文本及图文消息回复的实现

- Java日期操作方法工具类实例【包含日期比较大小,相加减,判断,验证,获取年份等】