Pytorch 扩展Tensor维度、压缩Tensor维度的方法

1. 扩展Tensor维度

相信刚接触Pytorch的宝宝们,会遇到这样一个问题,输入的数据维度和实验需要维度不一致,输入的可能是2维数据或3维数据,实验需要用到3维或4维数据,那么我们需要扩展这个维度。其实特别简单,只要对数据加一个扩展维度方法就可以了。

1.1torch.unsqueeze(self: Tensor, dim: _int)

torch.unsqueeze(self: Tensor, dim: _int)

参数说明:self:输入的tensor数据,dim:要对哪个维度扩展就输入那个维度的整数,可以输入0,1,2……

1.2Code

第一种方式,输入数据后直接加unsqueeze()

扩展第一维和第二维为1

import torch

def reset_unsqueeze1():

data = torch.rand([3, 3])

data1 = data.unsqueeze(dim=0).unsqueeze(dim=1)

print("data_size: ", data.shape)

print("data: ", data)

print("data1_size: ", data1.shape)

print("data1: ", data1)

结果显示

第二种方式,用torch.unsqueeze()

import torch

def reset_unsqueeze2():

data = torch.rand([3, 3])

data1 = torch.unsqueeze(data, dim=0)

print("data_size: ", data.shape)

print("data: ", data)

print("data1_size: ", data1.shape)

print("data1: ", data1)

结果显示

2. 压缩Tensor维度

2.1torch.squeeze(self: Tensor, dim: _int)

这个方法刚好和torch.unsqueeze()方法效果相反,压缩Tensor维度。

2.2 Code

第一种方式,输入数据后直接加squeeze()

import torch

def reset_squeeze1():

data = torch.rand([1, 1, 3, 3])

data1 = data.squeeze(dim=0).squeeze(dim=1)

print("data_size: ", data.shape)

print("data: ", data)

print("data1_size: ", data1.shape)

print("data1: ", data1)

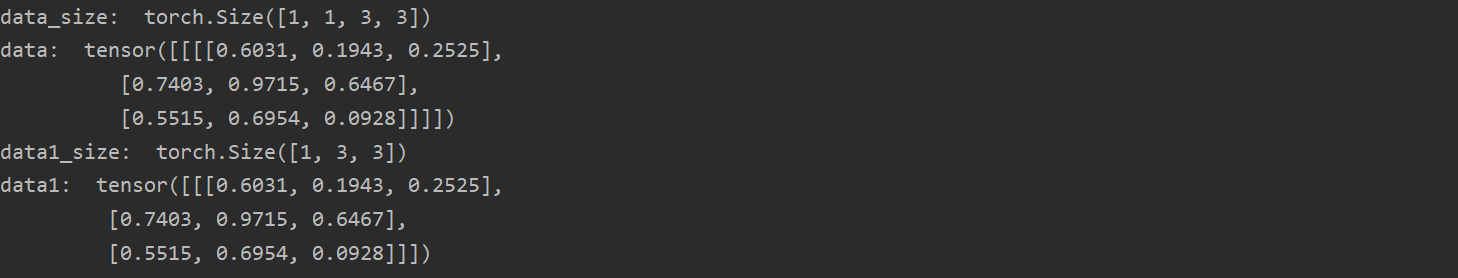

结果显示

第二种方式,用torch.squeeze()

import torch

def reset_squeeze2():

data = torch.rand([1, 1, 3, 3])

data1 = torch.squeeze(data, dim=0)

print("data_size: ", data.shape)

print("data: ", data)

print("data1_size: ", data1.shape)

print("data1: ", data1)

结果显示

到此这篇关于Pytorch 扩展Tensor维度、压缩Tensor维度的方法的文章就介绍到这了,更多相关Pytorch 扩展Tensor维度、压缩Tensor维度内容请搜索我们以前的文章或继续浏览下面的相关文章希望大家以后多多支持我们!

赞 (0)