sklearn线性逻辑回归和非线性逻辑回归的实现

线性逻辑回归

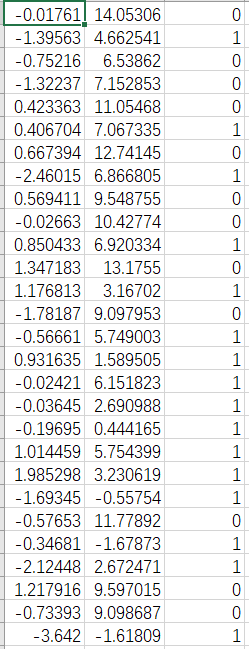

本文用代码实现怎么利用sklearn来进行线性逻辑回归的计算,下面先来看看用到的数据。

这是有两行特征的数据,然后第三行是数据的标签。

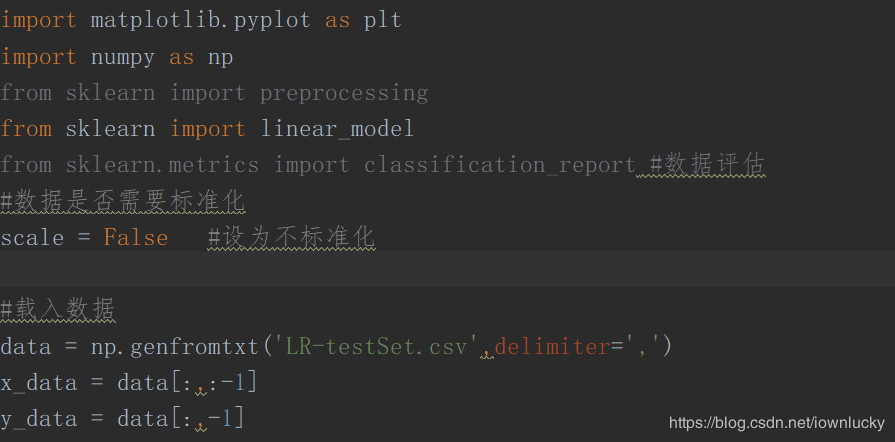

python代码

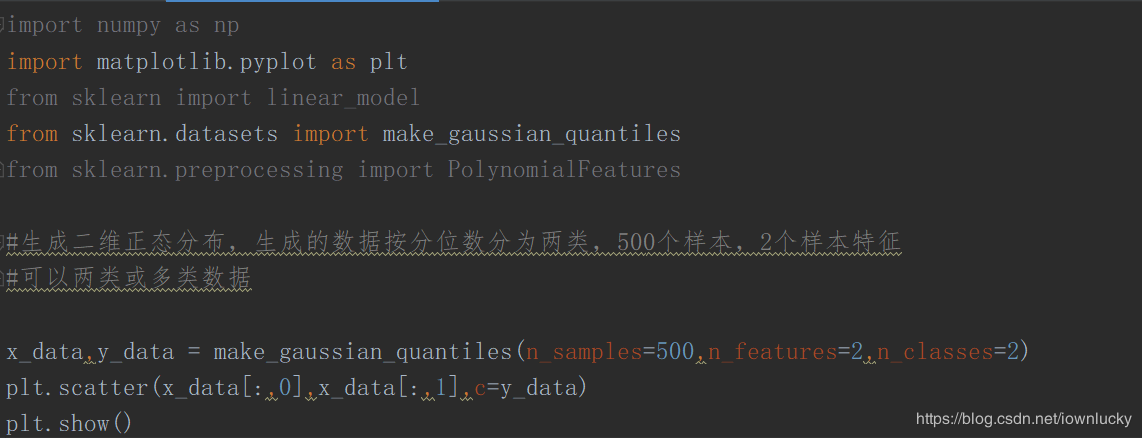

首先导入包和载入数据

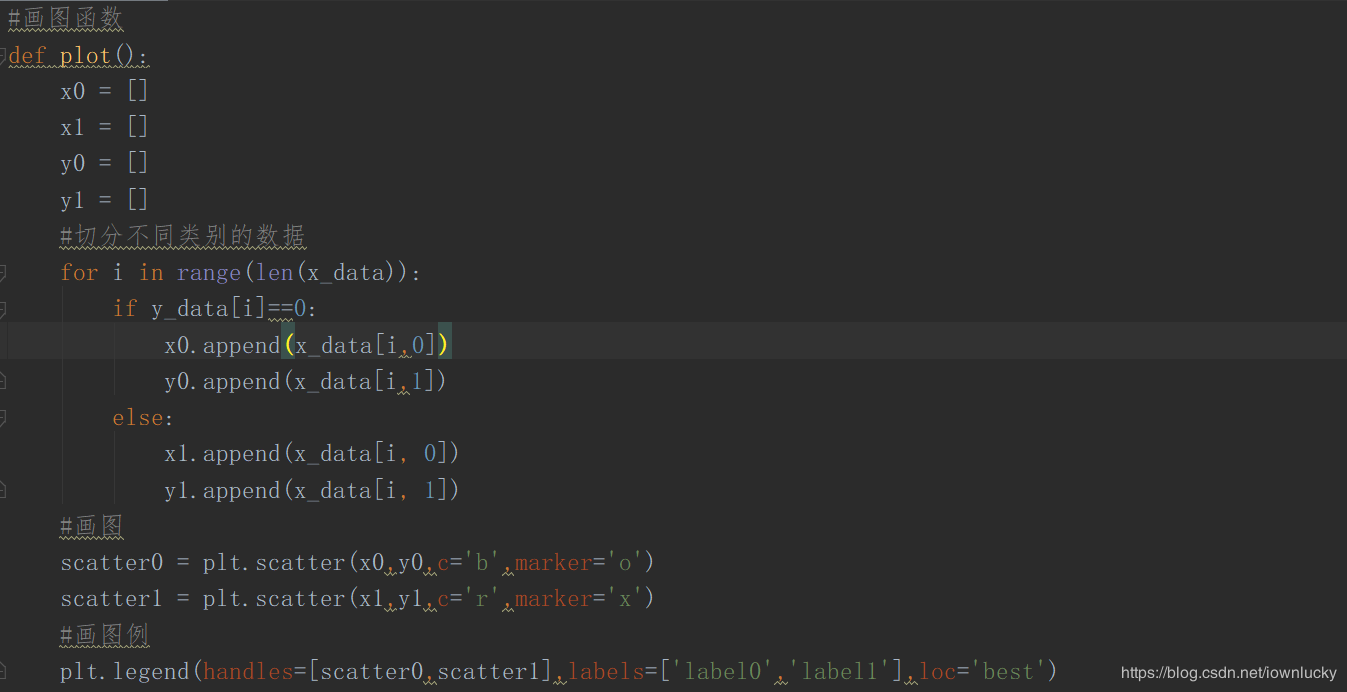

写一个画图的函数,把这些数据表示出来:

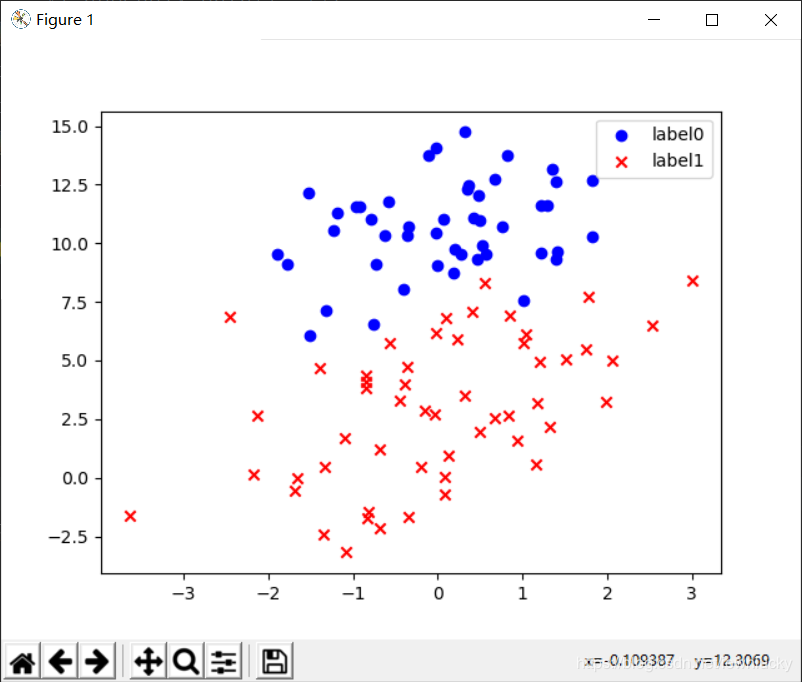

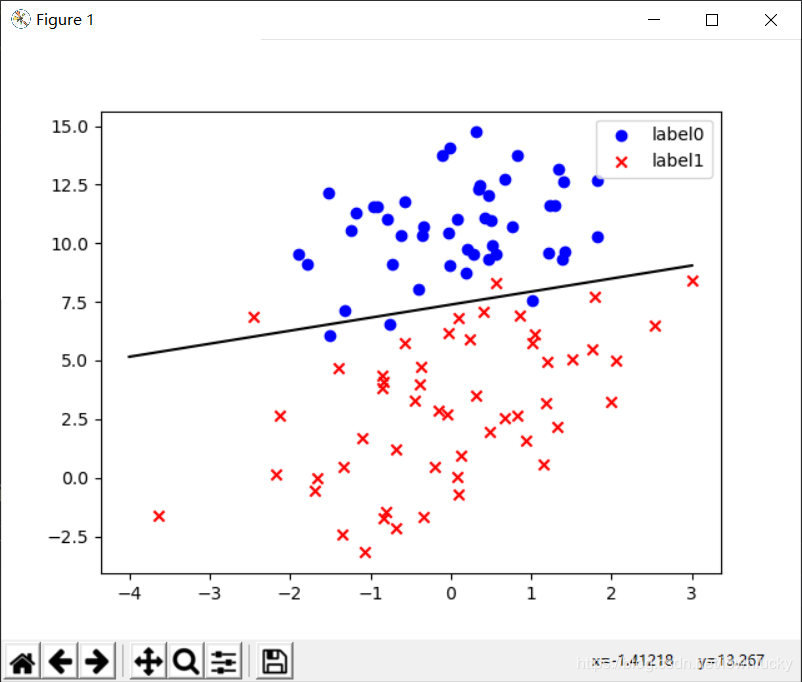

然后我们调用这个函数得到下面的图像:

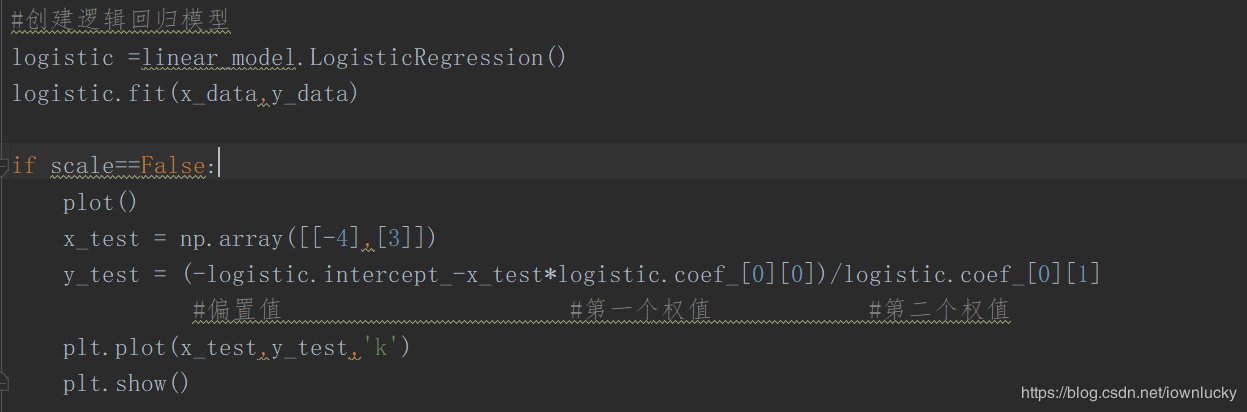

接下来开始创建模型并拟合,然后调用sklearn里面的逻辑回归方法,里面的函数可以自动帮算出权值和偏置值,非常简单,接着画出图像。

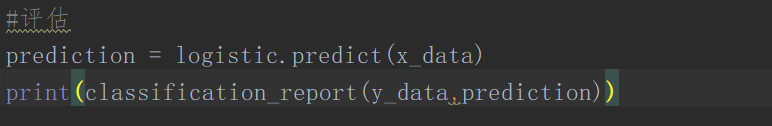

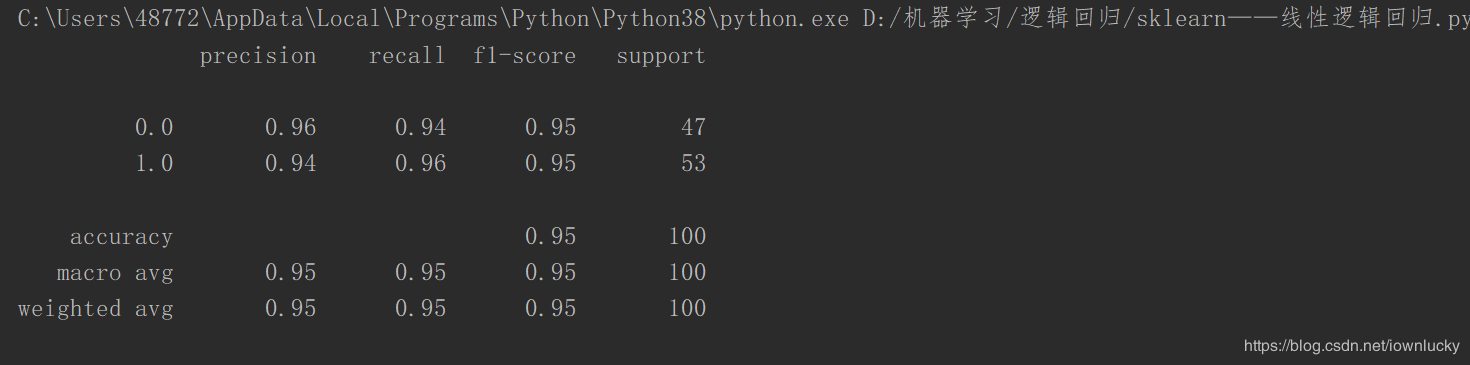

最后我们可以来看看评估值:

可以看到,正确率、召回率、F1值都达到了95%。

非线性逻辑回归

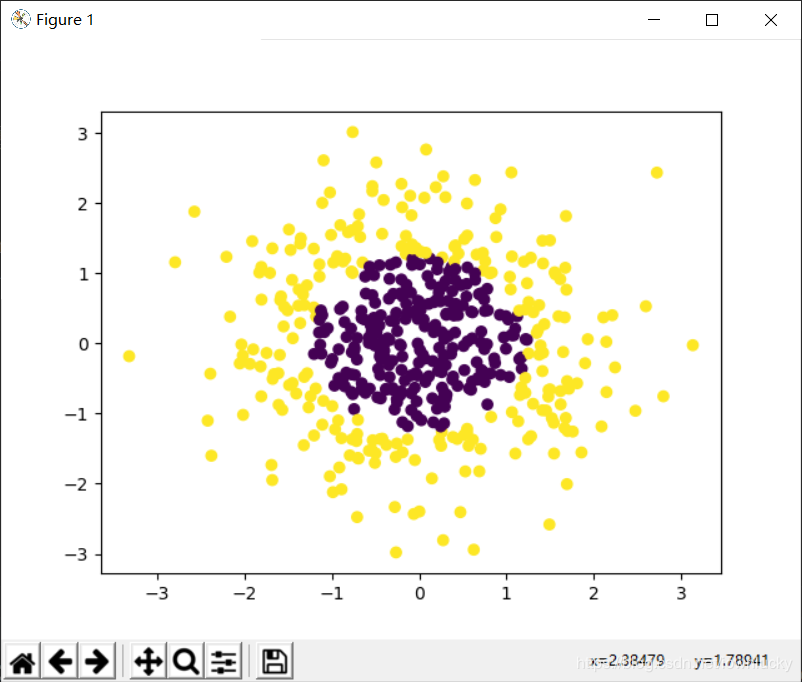

非线性逻辑回归意味着决策边界是曲线,和线性逻辑回归的原理是差不多的,这里用到的数据是datasets自动生成的,

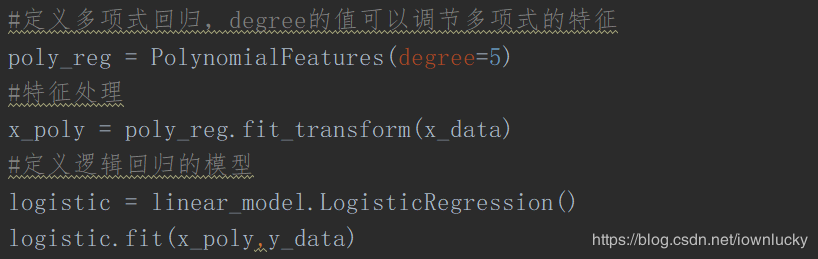

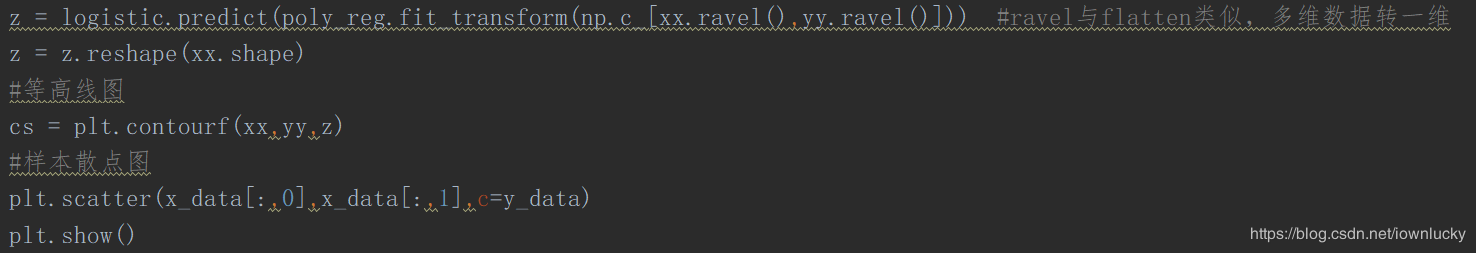

接下来要把数据进行多项式处理,简单地说就是增加数据的特征,

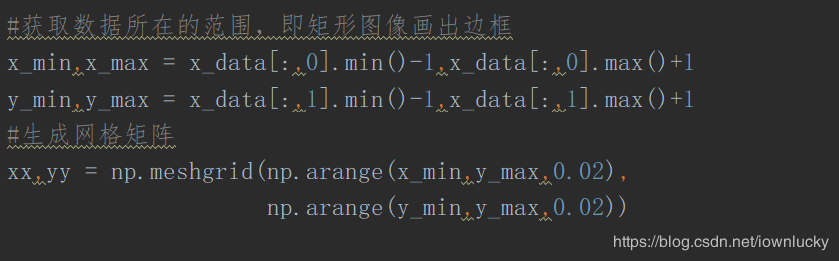

然后规定好图像的坐标值,并生成一个网格矩阵,

定义一个等高线的高,

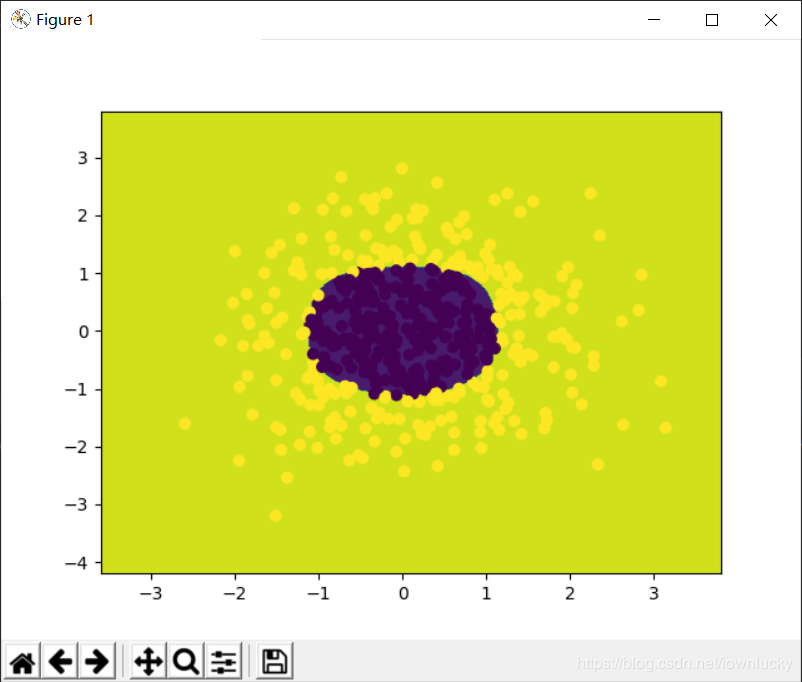

结果一目了然,很好的分成了两类:

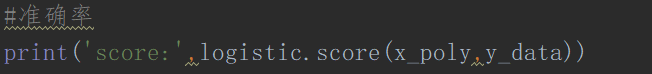

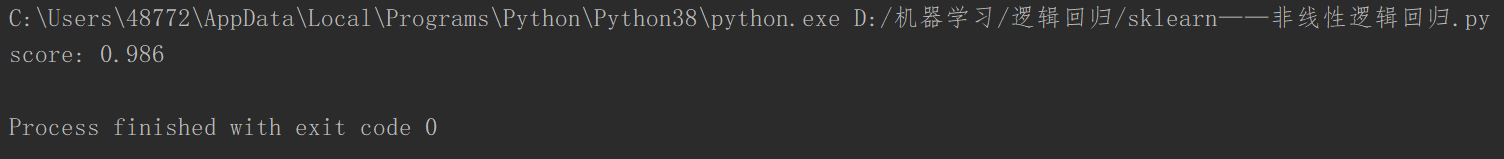

看一下准确率,98%,说明算比较成功,准确率很高。

线性逻辑回归和非线性逻辑回归用到的代价函数都是一样的,原理相同,只不过是预估函数的复杂度不一样,非线性逻辑回归要对数据进行多项式处理,增加数据的特征量。

到此这篇关于sklearn线性逻辑回归和非线性逻辑回归的实现的文章就介绍到这了,更多相关sklearn线性逻辑回归和非线性逻辑回归内容请搜索我们以前的文章或继续浏览下面的相关文章希望大家以后多多支持我们!

相关推荐

-

python sklearn库实现简单逻辑回归的实例代码

Sklearn简介 Scikit-learn(sklearn)是机器学习中常用的第三方模块,对常用的机器学习方法进行了封装,包括回归(Regression).降维(Dimensionality Reduction).分类(Classfication).聚类(Clustering)等方法.当我们面临机器学习问题时,便可根据下图来选择相应的方法. Sklearn具有以下特点: 简单高效的数据挖掘和数据分析工具 让每个人能够在复杂环境中重复使用 建立NumPy.Scipy.MatPlotLib之上 代

-

sklearn线性逻辑回归和非线性逻辑回归的实现

线性逻辑回归 本文用代码实现怎么利用sklearn来进行线性逻辑回归的计算,下面先来看看用到的数据. 这是有两行特征的数据,然后第三行是数据的标签. python代码 首先导入包和载入数据 写一个画图的函数,把这些数据表示出来: 然后我们调用这个函数得到下面的图像: 接下来开始创建模型并拟合,然后调用sklearn里面的逻辑回归方法,里面的函数可以自动帮算出权值和偏置值,非常简单,接着画出图像. 最后我们可以来看看评估值: 可以看到,正确率.召回率.F1值都达到了95%. 非线性逻辑回归 非线性

-

python机器学习理论与实战(四)逻辑回归

从这节算是开始进入"正规"的机器学习了吧,之所以"正规"因为它开始要建立价值函数(cost function),接着优化价值函数求出权重,然后测试验证.这整套的流程是机器学习必经环节.今天要学习的话题是逻辑回归,逻辑回归也是一种有监督学习方法(supervised machine learning).逻辑回归一般用来做预测,也可以用来做分类,预测是某个类别^.^!线性回归想比大家都不陌生了,y=kx+b,给定一堆数据点,拟合出k和b的值就行了,下次给定X时,就可以计

-

python人工智能深度学习入门逻辑回归限制

目录 1.逻辑回归的限制 2.深度学习的引入 3.深度学习的计算方式 4.神经网络的损失函数 1.逻辑回归的限制 逻辑回归分类的时候,是把线性的函数输入进sigmoid函数进行转换,后进行分类,会在图上画出一条分类的直线,但像下图这种情况,无论怎么画,一条直线都不可能将其完全分开. 但假如我们可以对输入的特征进行一个转换,便有可能完美分类.比如: 创造一个新的特征x1:到(0,0)的距离,另一个x2:到(1,1)的距离.这样可以计算出四个点所对应的新特征,画到坐标系上如以下右图所示.这样转换之后

-

python机器基础逻辑回归与非监督学习

目录 一.逻辑回归 1.模型的保存与加载 2.逻辑回归原理 ①逻辑回归的输入 ②sigmoid函数 ③逻辑回归的损失函数 ④逻辑回归特点 3.逻辑回归API 4.逻辑回归案例 ①案例概述 ②具体流程 5.逻辑回归总结 二.非监督学习 1.k-means聚类算法原理 2.k-means API 3.聚类性能评估 ①性能评估原理 ②性能评估API 一.逻辑回归 1.模型的保存与加载 模型训练好之后,可以直接保存,需要用到joblib库.保存的时候是pkl格式,二进制,通过dump方法保存.加载的时候

-

tensorflow实现简单逻辑回归

逻辑回归是机器学习中很简答的一个栗子,这篇文章就是要介绍如何使用tensorflow实现一个简单的逻辑回归算法. 逻辑回归可以看作只有一层网络的前向神经网络,并且参数连接的权重只是一个值,而非矩阵.公式为:y_predict=logistic(X*W+b),其中X为输入,W为输入与隐含层之间的权重,b为隐含层神经元的偏置,而logistic为激活函数,一般为sigmoid或者tanh, y_predict为最终预测结果. 逻辑回归是一种分类器模型,需要木便函数不断的优化参数,这里目标函数为y_p

-

Python使用sklearn实现的各种回归算法示例

本文实例讲述了Python使用sklearn实现的各种回归算法.分享给大家供大家参考,具体如下: 使用sklearn做各种回归 基本回归:线性.决策树.SVM.KNN 集成方法:随机森林.Adaboost.GradientBoosting.Bagging.ExtraTrees 1. 数据准备 为了实验用,我自己写了一个二元函数,y=0.5*np.sin(x1)+ 0.5*np.cos(x2)+0.1*x1+3.其中x1的取值范围是0~50,x2的取值范围是-10~10,x1和x2的训练集一共有5

-

带你学习Python如何实现回归树模型

所谓的回归树模型其实就是用树形模型来解决回归问题,树模型当中最经典的自然还是决策树模型,它也是几乎所有树模型的基础.虽然基本结构都是使用决策树,但是根据预测方法的不同也可以分为两种.第一种,树上的叶子节点就对应一个预测值和分类树对应,这一种方法称为回归树.第二种,树上的叶子节点对应一个线性模型,最后的结果由线性模型给出.这一种方法称为模型树. 今天我们先来看看其中的回归树. 回归树模型 CART算法的核心精髓就是我们每次选择特征对数据进行拆分的时候,永远对数据集进行二分.无论是离散特征还是连续性

-

python回归分析逻辑斯蒂模型之多分类任务详解

目录 逻辑斯蒂回归模型多分类任务 1.ovr策略 2.one vs one策略 3.softmax策略 逻辑斯蒂回归模型多分类案例实现 逻辑斯蒂回归模型多分类任务 上节中,我们使用逻辑斯蒂回归完成了二分类任务,针对多分类任务,我们可以采用以下措施,进行分类. 我们以三分类任务为例,类别分别为a,b,c. 1.ovr策略 我们可以训练a类别,非a类别的分类器,确认未来的样本是否为a类: 同理,可以训练b类别,非b类别的分类器,确认未来的样本是否为b类: 同理,可以训练c类别,非c类别的分类器,确认

-

用TensorFlow实现戴明回归算法的示例

如果最小二乘线性回归算法最小化到回归直线的竖直距离(即,平行于y轴方向),则戴明回归最小化到回归直线的总距离(即,垂直于回归直线).其最小化x值和y值两个方向的误差,具体的对比图如下图. 线性回归算法和戴明回归算法的区别.左边的线性回归最小化到回归直线的竖直距离:右边的戴明回归最小化到回归直线的总距离. 线性回归算法的损失函数最小化竖直距离:而这里需要最小化总距离.给定直线的斜率和截距,则求解一个点到直线的垂直距离有已知的几何公式.代入几何公式并使TensorFlow最小化距离. 损失函数是由分

-

python机器学习实战之树回归详解

本文实例为大家分享了树回归的具体代码,供大家参考,具体内容如下 #-*- coding:utf-8 -*- #!/usr/bin/python ''''' 回归树 连续值回归预测 的 回归树 ''' # 测试代码 # import regTrees as RT RT.RtTreeTest() RT.RtTreeTest('ex0.txt') RT.RtTreeTest('ex2.txt') # import regTrees as RT RT.RtTreeTest('ex2.txt',ops=(

随机推荐

- AngularJs bootstrap搭载前台框架——基础页面

- DOM XPATH获取img src值的query

- Angularjs 双向绑定时字符串的转换成数字类型的问题

- 设备管理器经典技巧三则

- Win2003下配置iis+php+mysql+zend图文 使其支持asp,.net,cgi,perl和php

- Failed to execute goal org...的解决办法

- cURL操作Openstack对象存储的ReST API详解

- c# SendMail发送邮件实例代码

- JavaScript 错误处理与调试经验总结

- Python pickle模块用法实例

- php 全文搜索和替换的实现代码

- js 获取元素在页面上的偏移量的方法汇总

- sql server代理中作业执行SSIS包失败的解决办法

- Java实现lucene搜索功能的方法(推荐)

- node.js程序作为服务并在windows下开机自启动(用forever)

- Linux下Android开发环境搭建的操作方法

- Android截取指定View为图片的实现方法

- Python GUI学习之登录系统界面篇

- 详解java构建者模式Builder

- Python Gluon参数和模块命名操作教程