TensorFlow2.X使用图片制作简单的数据集训练模型

Tensorflow内置了许多数据集,但是实际自己应用的时候还是需要使用自己的数据集,这里TensorFlow 官网也给介绍文档,官方文档。这里对整个流程做一个总结(以手势识别的数据集为例)。

1、 收集手势图片

数据集下载

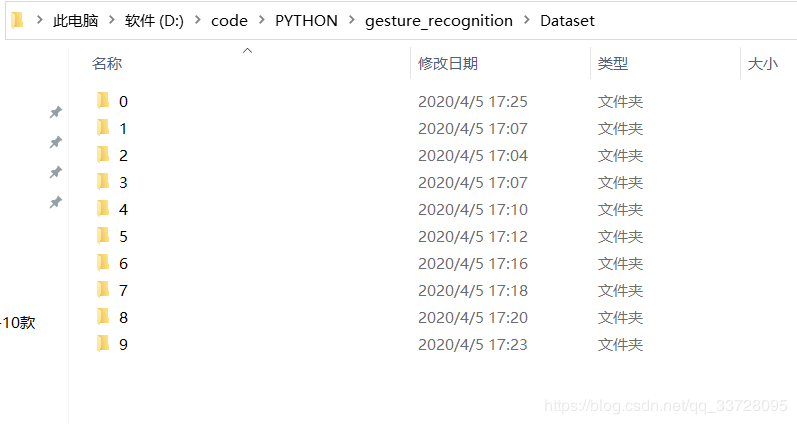

方法多种多样了。我通过摄像头自己采集了一些手势图片。保存成如下形式,

以同样的形式在建立一个测试集,当然也可以不弄,在程序里处理。

2、构建数据集

导入相关的包

import tensorflow as tf from tensorflow import keras from tensorflow.keras import datasets, layers, optimizers, Sequential, metrics from tensorflow.python.framework.convert_to_constants import convert_variables_to_constants_v2 import os import pathlib import random import matplotlib.pyplot as plt

读取文件

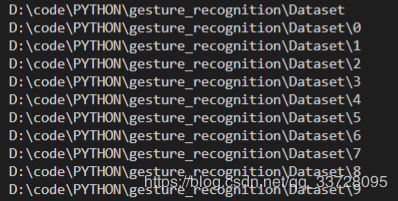

data_root = pathlib.Path('D:\code\PYTHON\gesture_recognition\Dataset')

print(data_root)

for item in data_root.iterdir():

print(item)

读取图片路径到list中

all_image_paths = list(data_root.glob('*/*'))

all_image_paths = [str(path) for path in all_image_paths]

random.shuffle(all_image_paths)

image_count = len(all_image_paths)

print(image_count) ##统计共有多少图片

for i in range(10):

print(all_image_paths[i])

label_names = sorted(item.name for item in data_root.glob('*/') if item.is_dir())

print(label_names) #其实就是文件夹的名字

label_to_index = dict((name, index) for index, name in enumerate(label_names))

print(label_to_index)

all_image_labels = [label_to_index[pathlib.Path(path).parent.name]

for path in all_image_paths]

print("First 10 labels indices: ", all_image_labels[:10])

预处理

def preprocess_image(image): image = tf.image.decode_jpeg(image, channels=3) image = tf.image.resize(image, [100, 100]) image /= 255.0 # normalize to [0,1] range # image = tf.reshape(image,[100*100*3]) return image def load_and_preprocess_image(path,label): image = tf.io.read_file(path) return preprocess_image(image),label

构建一个 tf.data.Dataset

ds = tf.data.Dataset.from_tensor_slices((all_image_paths, all_image_labels)) train_data = ds.map(load_and_preprocess_image).batch(16)

同样的方式在制作一个测试集,就可以用于模型训练和测试了。

总结

到此这篇关于TensorFlow2.X使用图片制作简单的数据集训练模型的文章就介绍到这了,更多相关TensorFlow数据集训练模型内容请搜索我们以前的文章或继续浏览下面的相关文章希望大家以后多多支持我们!

赞 (0)