用Python爬取某乎手机APP数据

目录

- 一、配置抓包工具

- 二、配置手机代理

- 三、抓取数据

- 四、总结

一、配置抓包工具

1.安装软件

本文选择的抓包工具:Fiddler

具体的下载安装这里不详细赘述!(网上搜Fiddler安装,一大堆教程),本文以实战为例,就不再这里浪费时间了!

2.配置Fiddler

安装好之后,接下来就开始配置Fiddler工具(这里是关键,仔细阅读!)

配置Connections

打开Fiddler后,点击Tools->Options

点击Connections

勾选上对应的选项

配置HTTPS

由于目前大部分APP都是https加密,包括本文实战『某乎』案例也是https加密,因此配置HTTPS,来抓取https数据包!

勾选上对应的选项

最后抓包工具Fiddler就配置好了

记得重启Fiddler!重启Fiddler!重启Fiddler!不然可能不生效

二、配置手机代理

1.设置代理

准备工作

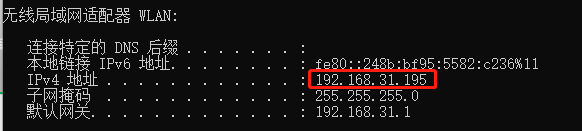

首先看一下安装Fiddler主机ip(电脑和手机必须处于同一局域网)

查看ip命令

window:ipconfig

开始配置

目标代理主机信息

ip:192.168.31.195

端口:8888

在wifi无线网处进去,点击配置代理

填写好相关代理信息

2.安装证书

在浏览器输入:

http://192.168.31.195:8888

点击下载证书后,下面就开始安装(看图操作)

ok,这样手机端就配置完成,下面开始抓取数据!!!

三、抓取数据

1.打开某乎app

2.查看数据包列表

打开app之后,Fiddler就已经抓取到数据了

这里可以看到app发送和接收了哪些数据包

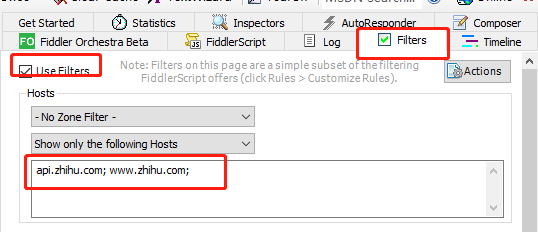

为了更加精准定位到某乎(只看目标的数据包),添加一个过滤条件

这样我们获取的数据包列表就都是过滤条件内的目标网址

3.查找数据包

比如点击热榜

对应的https加密数据包如下:

数据包中的数据如下:

提取出url链接

https://api.zhihu.com/topstory/hot-list?limit=10&reverse_order=0

拿到url之后,接着开始编程爬取保存数据。

4.编写爬虫程序

# -*- coding: utf-8 -*-

ok这样就可以将数据获取下来!

四、总结

1.配置抓包工具Fiddler(重点)。

2.ios苹果手机配置证书和设置代理(安卓手机也类似)。

3.简单使用Fiddler(过滤数据包、查看数据包等)。

4.本文以某乎为实战,实现了python爬取手机app数据

到此这篇关于用Python爬取某乎手机APP数据的文章就介绍到这了,更多相关Python爬取APP数据内容请搜索我们以前的文章或继续浏览下面的相关文章希望大家以后多多支持我们!

相关推荐

-

Python实现APP自动化发微信群消息的示例代码

目录 1. 前言 2. 爬虫及服务 3. 自动化发送群聊 4. 最后 1. 前言 但是对于很多人来说,首先编写一款 App 需要一定的移动端开发经验,其次还需要另外编写无障碍服务应用,如此显得有一定难度的本篇文章将介绍另外一种方案,即:利用前面文章介绍的 AutoJS 来实现自动给微信群发送新闻早报 2. 爬虫及服务 为了演示方便,这里以百度热搜为新闻早报数据源, 使用 Requests + BeautifulSoup 按热度,爬取热度最高的 15 条数据 import requests fr

-

如何使用Python逆向抓取APP数据

今天给大伙分享一下 Python 爬虫的教程,这次主要涉及到的是关于某 APP 的逆向分析并抓取数据,关于 APP 的反爬会麻烦一些,比如 Android 端的代码写完一般会进行打包并混淆加密加固,所以除了抓包之外,还需要对 APP 进行查壳脱壳反编译等操作. 所需设备和环境: 设备:安卓手机 抓包: fiddler+xposed+JustTrustme 查壳:ApkScan-PKID 脱壳:frida-DEXDump 反编译:jadx-gui hook:frida 抓包 手机安装app,设置好

-

Python抓取移动App数据使用mitmweb监听请求与响应

mitmproxy有3中监听请求与响应的方式: mitmproxy控制台方式 mitmdump与Python对接的方式 mitmweb可视化方式 前2种都是基于控制台的方式,尽管第2种通过与Python对接的方式可以利用Python编写一个可视化工具,但还需要进行大量的编码,如果要想直接用可视化的方式监听请求与响应数据,就需要使用第3种方式:mitmweb.这是一个Web版的可视化监听工具,执行mitmweb命令即可启动mitmweb服务,默认端口号是8081.启动mitmweb服务后,会在默认

-

用Python爬取某乎手机APP数据

目录 一.配置抓包工具 二.配置手机代理 三.抓取数据 四.总结 一.配置抓包工具 1.安装软件 本文选择的抓包工具:Fiddler 具体的下载安装这里不详细赘述!(网上搜Fiddler安装,一大堆教程),本文以实战为例,就不再这里浪费时间了! 2.配置Fiddler 安装好之后,接下来就开始配置Fiddler工具(这里是关键,仔细阅读!) 配置Connections 打开Fiddler后,点击Tools->Options 点击Connections 勾选上对应的选项 配置HTTPS 由于目

-

python爬取安居客二手房网站数据(实例讲解)

是小打小闹 哈哈,现在开始正式进行爬虫书写首先,需要分析一下要爬取的网站的结构:作为一名河南的学生,那就看看郑州的二手房信息吧! 在上面这个页面中,我们可以看到一条条的房源信息,从中我们发现了什么,发现了连郑州的二手房都是这么的贵,作为即将毕业的学生狗惹不起啊惹不起 还是正文吧!!!由上可以看到网页一条条的房源信息,点击进去后就会发现: 房源的详细信息.OK!那么我们要干嘛呢,就是把郑州这个地区的二手房房源信息都能拿到手,可以保存到数据库中,用来干嘛呢,作为一个地理人,还是有点用处的,这次就不说

-

Python爬取股票信息,并可视化数据的示例

前言 截止2019年年底我国股票投资者数量为15975.24万户, 如此多的股民热衷于炒股,首先抛开炒股技术不说, 那么多股票数据是不是非常难找, 找到之后是不是看着密密麻麻的数据是不是头都大了? 今天带大家爬取雪球平台的股票数据, 并且实现数据可视化 先看下效果图 基本环境配置 python 3.6 pycharm requests csv time 目标地址 https://xueqiu.com/hq 爬虫代码 请求网页 import requests url = 'https://xueq

-

Python爬取腾讯疫情实时数据并存储到mysql数据库的示例代码

思路: 在腾讯疫情数据网站F12解析网站结构,使用Python爬取当日疫情数据和历史疫情数据,分别存储到details和history两个mysql表. ①此方法用于爬取每日详细疫情数据 import requests import json import time def get_details(): url = 'https://view.inews.qq.com/g2/getOnsInfo?name=disease_h5&callback=jQuery3410284820553141302

-

python爬取链家二手房的数据

一.查找数据所在位置: 打开链家官网,进入二手房页面,选取某个城市,可以看到该城市房源总数以及房源列表数据. 二.确定数据存放位置: 某些网站的数据是存放在html中,而有些却api接口,甚至有些加密在js中,还好链家的房源数据是存放到html中: 三.获取html数据: 通过requests请求页面,获取每页的html数据 # 爬取的url,默认爬取的南京的链家房产信息 url = 'https://nj.lianjia.com/ershoufang/pg{}/'.format(page) #

-

单身狗福利?Python爬取某婚恋网征婚数据

目标网址https://www.csflhjw.com/zhenghun/34.html?page=1 一.打开界面 鼠标右键打开检查,方框里为你一个文小姐的征婚信息..由此判断出为同步加载 点击elements,定位图片地址,方框里为该女士的url地址及图片地址 可以看出该女士的url地址不全,之后在代码中要进行url的拼接,看一下翻页的url地址有什么变化 点击第2页 https://www.csflhjw.com/zhenghun/34.html?page=2 点击第3页 https://

-

通过抓取淘宝评论为例讲解Python爬取ajax动态生成的数据(经典)

在学习python的时候,一定会遇到网站内容是通过 ajax动态请求.异步刷新生成的json数据 的情况,并且通过python使用之前爬取静态网页内容的方式是不可以实现的,所以这篇文章将要讲述如果在python中爬取ajax动态生成的数据. 至于读取静态网页内容的方式,有兴趣的可以查看本文内容. 这里我们以爬取淘宝评论为例子讲解一下如何去做到的. 这里主要分为了四步: 一 获取淘宝评论时,ajax请求链接(url) 二 获取该ajax请求返回的json数据 三 使用python解析json数据

-

使用python爬取B站千万级数据

Python(发音:英[?pa?θ?n],美[?pa?θɑ:n]),是一种面向对象.直译式电脑编程语言,也是一种功能强大的通用型语言,已经具有近二十年的发展历史,成熟且稳定.它包含了一组完善而且容易理解的标准库,能够轻松完成很多常见的任务.它的语法非常简捷和清晰,与其它大多数程序设计语言不一样,它使用缩进来定义语句. Python支持命令式程序设计.面向对象程序设计.函数式编程.面向切面编程.泛型编程多种编程范式.与Scheme.Ruby.Perl.Tcl等动态语言一样,Python具备垃圾回收

-

python爬取各类文档方法归类汇总

HTML文档是互联网上的主要文档类型,但还存在如TXT.WORD.Excel.PDF.csv等多种类型的文档.网络爬虫不仅需要能够抓取HTML中的敏感信息,也需要有抓取其他类型文档的能力.下面简要记录一些个人已知的基于python3的抓取方法,以备查阅. 1.抓取TXT文档 在python3下,常用方法是使用urllib.request.urlopen方法直接获取.之后利用正则表达式等方式进行敏感词检索. ### Reading TXT doc ### from urllib.request i

-

python爬取股票最新数据并用excel绘制树状图的示例

大家好,最近大A的白马股们简直 跌妈不认,作为重仓了抱团白马股基金的养鸡少年,每日那是一个以泪洗面啊. 不过从金融界最近一个交易日的大盘云图来看,其实很多中小股还是红色滴,绿的都是白马股们. 以下截图来自金融界网站-大盘云图: 那么,今天我们试着用python爬取最近交易日的股票数据,并试着用excel简单绘制以下上面这个树状图.本文旨在抛砖引玉,吼吼. 1. python爬取网易财经不同板块股票数据 目标网址: http://quotes.money.163.com/old/#query=hy

随机推荐

- Python利用递归和walk()遍历目录文件的方法示例

- JS截取与分割字符串常用技巧总结

- javascript与CSS复习(《精通javascript》)

- js四舍五入数学函数round使用实例

- 详解iOS App中调用AVAudioPlayer播放音频文件的用法

- php 人员权限管理(RBAC)实例(推荐)

- Android Scroller大揭秘

- Android注解ButterKnife的基本使用

- destoon实现商铺管理主页设置增加新菜单的方法

- 用Zend Studio+PHPnow+Zend Debugger搭建PHP服务器调试环境步骤

- Sql Server中一个表2个字段关联同一个表(代码解决)

- Android开发:浅谈MVP模式应用与内存泄漏问题解决

- jQuery图片轮播(二)利用构造函数和原型创建对象以实现继承

- 一行代码告别document.getElementById

- JavaScript实现添加及删除事件的方法小结

- JavaScript面对国际化编程时的一些建议

- cnblogs csdn 代码运行框实现代码

- Android编程实现开始及停止service的方法

- C#反射应用实例

- 详解SQL Server表和索引存储结构