Filebeat 采集 Nginx 日志的方法

Nginx 日志可用于分析用户地址位置,行为画像等,如何通过 Elastic Stack 进行一站式的数据采集,数据清洗,数据落地,数据可视化,让数据发挥真正的价值呢?

架构设计

涉及到 Elastic Stack 中 Filebeat 是用于采集 Nginx 相关的日志, Elasticsearch 是用于对于数据落地存储和搜索的引擎, Kibana 是用于对数据可视化的工具。

在 Nginx 中相关的日志是存储在 /var/log/nginx 目录下的,分别是访问日志 access.log,错误日志 error.log。

如果是裸机环境下,可以直接在同一主机下安装 Filebeat 针对日志文件进行采集。

如果是 Docker 环境下,建议 Nginx 使用 Volume 的方式进行共享日志文件给 Filebeat 采集。

如果是 Kubernetes 环境下,建议在 Pod 中添加 Filebeat Container进行对 PV 采集。

针对不同场景有不同的采集方案,有些可以利用Daemonset采集宿主机上的日志,有些是以Sidecar方式进行采集,具体视业务场景而定。

实施方法

以 Docker 环境下为例

Nginx

创建存储卷,便于 Nginx 和 Filebeat 容器共同挂载

docker volume create nginx-log-volume

启动 Nginx 容器,并且将存储卷映射到日志目录

docker run -d --name nginx -p 80:80 -v nginx-log-volume:/var/log/nginx nginx:latest

进入容器修改配置

docker exec -it nginx /bin/bash

由于容器环境下,默认的日志会输入到stdout,所以取消该设置并指定文件

unlink /var/log/nginx/access.log

unlink /var/log/nginx/error.log

touch /var/log/nginx/access.log /var/log/nginx/error.log

nginx -s reload

Filebeat

启动 Filebeat 容器,并且将存储卷映射到数据目录

docker run -d --name filebeat --user=root -v nginx-log-volume:/data elastic/filebeat:7.9.2

进入容器修改配置

docker exec -it filebeat /bin/bash

修改配置,添加 Elasticsearch 和 Kibana 的主机

vi filebeat.yml

filebeat.config:

modules:

path: ${path.config}/modules.d/*.yml

reload.enabled: false

processors:

- add_cloud_metadata: ~

- add_docker_metadata: ~

output.elasticsearch:

hosts: 'elasticsearch:9200'

username: "elastic"

password: "xxx"

setup.kibana:

host: "kibana:5601"

启用 Nginx 采集模块

filebeat modules enable nginx

编辑 Nginx 采集配置

vi modules.d/nginx.yml

- module: nginx access: enabled: true var.paths: ["/data/access.log*"] error: enabled: true var.paths: ["/data/error.log*"]

设置 Filebeat 创建 Kibana上的 Index Pattern 和 Dashboard

filebeat setup

重启 Filebeat 生效配置

docker restart filebeat

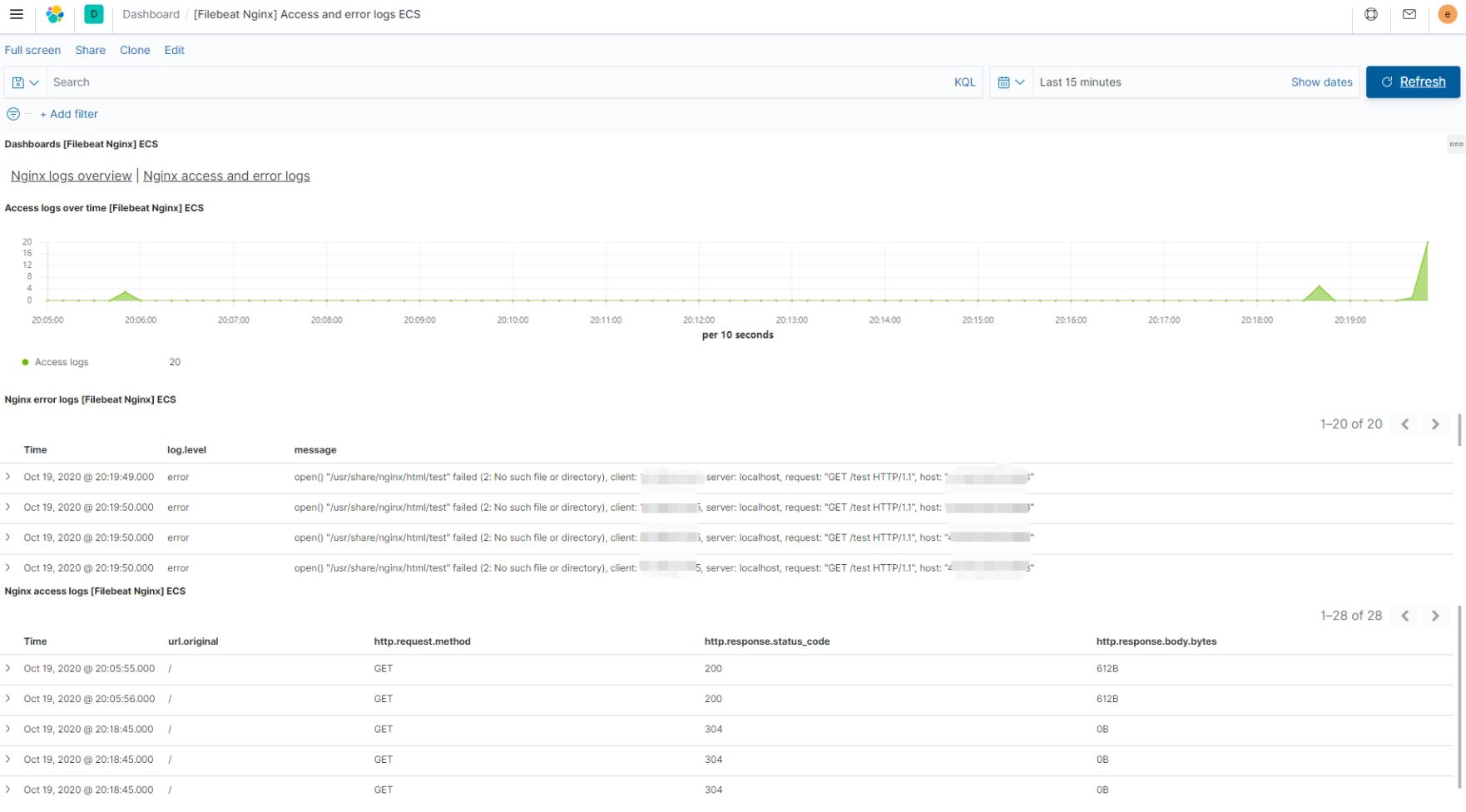

可视化展示

通过 Kibana 中的 Dashboard 功能

展示 Nginx 对于日志的访问情况及用户地址位置、浏览器信息

展示 Nginx 对于访问日志和错误日志的具体请求信息