pandas计数 value_counts()的使用

在pandas里面常用value_counts确认数据出现的频率。

1. Series 情况下:

pandas 的 value_counts() 函数可以对Series里面的每个值进行计数并且排序。

import pandas as pd

df = pd.DataFrame({'区域' : ['西安', '太原', '西安', '太原', '郑州', '太原'],

'10月份销售' : ['0.477468', '0.195046', '0.015964', '0.259654', '0.856412', '0.259644'],

'9月份销售' : ['0.347705', '0.151220', '0.895599', '0236547', '0.569841', '0.254784']})

print(df)

统计每个区域出现多少次:

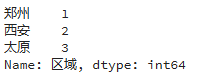

print(df['区域'].value_counts())

每个区域都被计数,并且默认从高到低排序。

如果想升序排列,设置参数 ascending = True:

print(df['区域'].value_counts(ascending=True))

如果想得出计数占比,可以加参数 normalize=True

print(df['区域'].value_counts(normalize=True))

注:空值默认剔除掉的。value_counts()返回的结果是一个Series数组,可以跟别的数组进行计算。

2. DataFrame 情况下:

import pandas as pd

df = pd.DataFrame({'区域1' : ['西安', '太原', '西安', '太原', '郑州', '太原'],

'区域2' : ['太原', '太原', '西安', '西安', '西安', '太原']})

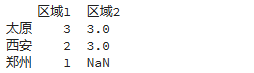

print(df.apply(pd.value_counts))

区域2中没有郑州,所以是NaN。

以上就是本文的全部内容,希望对大家的学习有所帮助,也希望大家多多支持我们。

相关推荐

-

pandas的唯一值、值计数以及成员资格的示例

1.Series唯一值判断 s = Series([3,3,1,2,4,3,4,6,5,6]) #判断Series中的值是否重复,False表示重复 print(s.is_unique) #False #输出Series中不重复的值,返回值没有排序,返回值的类型为数组 print(s.unique()) #[3 1 2 4 6 5] print(type(s.unique())) #<class 'numpy.ndarray'> #统计Series中重复值出现的次数,默认是按出现次数降序排序

-

利用pandas进行大文件计数处理的方法

Pandas读取大文件 要处理的是由探测器读出的脉冲信号,一组数据为两列,一列为时间,一列为脉冲能量,数据量在千万级,为了有一个直接的认识,先使用Pandas读取一些 import pandas as pd data = pd.read_table('filename.txt', iterator=True) chunk = data.get_chunk(5) 而输出是这样的: Out[4]: 332.977889999979 -0.0164794921875 0 332.97790 -0.02

-

pandas计数 value_counts()的使用

在pandas里面常用value_counts确认数据出现的频率. 1. Series 情况下: pandas 的 value_counts() 函数可以对Series里面的每个值进行计数并且排序. import pandas as pd df = pd.DataFrame({'区域' : ['西安', '太原', '西安', '太原', '郑州', '太原'], '10月份销售' : ['0.477468', '0.195046', '0.015964', '0.259654', '0.856

-

Pandas统计计数value_counts()的使用

value_counts()方法返回一个序列Series,该序列包含每个值的数量(对于数据框中的任何列,value_counts()方法会返回该列每个项的计数) value_counts()是Series拥有的方法,一般在DataFrame中使用时,需要指定对哪一列进行使用 语法 value_counts(values, sort=True, ascending=False, normalize=False, bins=None, dropna=True) 参数说明 sort: 是否要进行排序(

-

Python Pandas教程之series 上的转换操作

前言: 在转换操作中,我们执行各种操作,例如更改系列的数据类型,将系列更改为列表等.为了执行转换操作,我们有各种有助于转换的功能,例如.astype()等.tolist(). 代码#1: # 使用 astype 转换 series 数据类型的 Python 程序 # importing pandas module import pandas as pd # 从 url 读取 csv 文件 data = pd.read_csv("nba.csv") # 删除空值列以避免错误 data.d

-

Pandas计算元素的数量和频率的方法(出现的次数)

目录 pandas.Series.unique():返回NumPy数组ndarray中唯一元素值的列表 pandas.Series.value_counts():返回唯一元素的值及其在出现的次数. pandas.Series.nunique(), pandas.DataFrame.nunique():返回int,pandas.Series中唯一元素的数量. 唯一元素的数量(不包括重复项的) 唯一元素值列表 唯一元素的频率(出现次数) 独特元素及其出现的字典 模式及其频率 mode() descr

-

推荐一款高效的python数据框处理工具Sidetable

目录 安装 用法 1.freq() 2.Counts 3.missing() 4.subtotal() 结论 我们知道 Pandas 是数据科学社区中流行的 Python 包,它包含许多函数和方法来分析数据.尽管它的功能对于数据分析来说足够有效,但定制的库可以为 Pandas 增加更多的价值. Sidetable 就是一个开源 Python 库,它是一种可用于数据分析和探索的工具,作为 value_counts 和 crosstab 的功能组合使用的.在本文中,我们将更多地讨论和探索其功能.欢迎

-

Pandas 实现分组计数且不计重复

在对dataframe进行分析的时候会遇到需要分组计数,计数的column中属性有重复,但又需要仅对不重复的项计数(即重复N次出现的项只计1次). 函数如下: dataframe.groupby(['分组的列名']).需要计数的列名.nunique() 举例: 数组"data"如下: StoreID Sales SalesDate Channel A 100 2018/1/1 01 A 90 2018/1/1 02 A 110 2018/1/2 01 B 82.2 2018/1/1 0

-

pandas如何解决excel科学计数法问题

目录 pandas解决excel科学计数法问题 亲测两个方法有效 pandas替换科学计数法数字 pandas解决excel科学计数法问题 excel默认处理超14位的数字成科学计数法,且后面的数字默认变0. 使用pandas合表或者生成新表时这是最恶心的问题. 亲测两个方法有效 1.若数据量不大,可将to_excel替换成to_csv,csv的包容性还是极强的,但当数据量庞大时,会遇到打不开的情况. 2.万能解法,read_excel时: df = pd.read_excel("filepat

-

pandas数据清洗,排序,索引设置,数据选取方法

此教程适合有pandas基础的童鞋来看,很多知识点会一笔带过,不做详细解释 Pandas数据格式 Series DataFrame:每个column就是一个Series 基础属性shape,index,columns,values,dtypes,describe(),head(),tail() 统计属性Series: count(),value_counts(),前者是统计总数,后者统计各自value的总数 df.isnull() df的空值为True df.notnull() df的非空值为T

-

使用pandas实现连续数据的离散化处理方式(分箱操作)

Python实现连续数据的离散化处理主要基于两个函数,pandas.cut和pandas.qcut,前者根据指定分界点对连续数据进行分箱处理,后者则可以根据指定箱子的数量对连续数据进行等宽分箱处理,所谓等宽指的是每个箱子中的数据量是相同的. 下面简单介绍一下这两个函数的用法: # 导入pandas包 import pandas as pd ages = [20, 22, 25, 27, 21, 23, 37, 31, 61, 45, 41, 32] # 待分箱数据 bins = [18, 25,

随机推荐

- 使用GruntJS构建Web程序之安装篇

- JavaEE中struts2实现文件上传下载功能实例解析

- Javascript 遍历对象中的子对象

- JS组件Bootstrap Select2使用方法详解

- PHP 5.0对象模型深度探索之对象复制

- JavaScript基于正则表达式的数字判断函数

- Android 中使用 ViewPager实现屏幕页面切换和页面轮播效果

- JavaScript实现简单Tip提示框效果

- 实例展示使用Java压缩和解压缩7z文件的方法

- JSP实现从数据库导出数据到Excel下载的方法

- jQuery源码解读之removeAttr()方法分析

- JS+CSS实现精美的二级导航效果代码

- CSS鼠标悬停菜单 图片交换技术实现

- Win 2003操作系统四例精彩问答

- 详解基于java的Socket聊天程序——客户端(附demo)

- Java实现MD5消息摘要算法

- 进一步探究Python的装饰器的运用

- asp.net 编辑gridview的小例子

- PHP获取数组中某元素的位置及array_keys函数应用

- 分析JS中this引发的bug