python 使用re.search()筛选后 选取部分结果的方法

使用group()方法

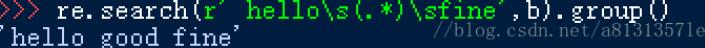

b = 'hello good fine'

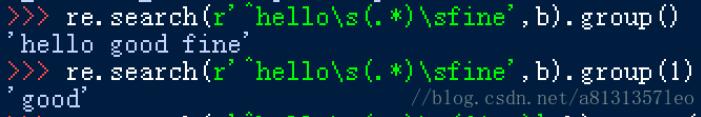

re.search(r'^hello\s(.*)\sfine',b).group()

group() 会返回匹配此正则表达式的字符串

group(1) 会返回正则表达式中第一个括号内的内容, 以此类推,group(2) 第二个括号

re.search(r'^hello\s(.*)\sfine',b).group(1)

* 如果需要筛选,则要在正则表达式里把 需要筛选的东西括上

以上这篇python 使用re.search()筛选后 选取部分结果的方法就是小编分享给大家的全部内容了,希望能给大家一个参考,也希望大家多多支持我们。

相关推荐

-

Python3中正则模块re.compile、re.match及re.search函数用法详解

本文实例讲述了Python3中正则模块re.compile.re.match及re.search函数用法.分享给大家供大家参考,具体如下: re模块 re.compile.re.match. re.search re 模块官方说明文档 正则匹配的时候,第一个字符是 r,表示 raw string 原生字符,意在声明字符串中间的特殊字符不用转义. 比如表示 '\n',可以写 r'\n',或者不适用原生字符 '\n'. 推荐使用 re.match re.compile() 函数 编译正则表达式模式,

-

Python使用re模块实现信息筛选的方法

本文实例讲述了Python使用re模块实现信息筛选的方法.分享给大家供大家参考,具体如下: 背景 平时工作中,我们经常会处理大量的元数据(Raw Data),而一般的文件编辑器只能一次查询一个关键字,这就难以连续的分析元数据,比如分析产品日志文件(log),日志可能包括很多information级别的信息,这些一般是我们不太关心的,我们主要关心的是一些特殊的调试(Debug)级别的信息,所以就有必要根据很多关键字筛选出来日志文件中我们所关系的信息,这样筛选出来的日志文件不仅具有连续性,而且易读性

-

python正则表达式match和search用法实例

本文实例讲述了python正则表达式match和search用法.分享给大家供大家参考.具体分析如下: python提供了2中主要的正则表达式操作:re.match 和 re.search. match :只从字符串的开始与正则表达式匹配,匹配成功返回matchobject,否则返回none: search :将字符串的所有字串尝试与正则表达式匹配,如果所有的字串都没有匹配成功,返回none,否则返回matchobject:(re.search相当于perl中的默认行为) import re d

-

python 使用re.search()筛选后 选取部分结果的方法

使用group()方法 b = 'hello good fine' re.search(r'^hello\s(.*)\sfine',b).group() group() 会返回匹配此正则表达式的字符串 group(1) 会返回正则表达式中第一个括号内的内容, 以此类推,group(2) 第二个括号 re.search(r'^hello\s(.*)\sfine',b).group(1) * 如果需要筛选,则要在正则表达式里把 需要筛选的东西括上 以上这篇python 使用re.search()筛选

-

python groupby函数实现分组后选取最值

现在需要将course分组,然后选择出每一组里面的最大值和最小值,并保留下来 实现下面数据结果: 直接使用groupby函数,不能直接达到此效果,需要在groupby函数上添加apply和lambda函数 代码如下: import pandas as pd data = pd.read_excel('group_apply.xlsx') data1 = data.groupby('course').apply(lambda t: t[(t['grade']==t['grade'].min())

-

python实现按关键字筛选日志文件

最近忙成了狗,五六个项目堆在一起,头疼的是测试还失惊无神的给我丢来一个几十甚至上百M的日志文件,动不动就几十上百万行,就算是搜索也看得头昏眼花的,因此自己花了点时间写了一段小脚本去过滤日志,当然这样的东西网上应该大把,但是还是想自己搞下,权当学习! #!/usr/bin/python # -*- encoding: utf-8 -*- # version 1.0 import re import time ''' 用于筛选日志文件,适用于python2.x版本 使用时将日志文件放于search.

-

Python实现查找匹配项作处理后再替换回去的方法

本文实例讲述了Python实现查找匹配项作处理后再替换回去的方法.分享给大家供大家参考,具体如下: 这里实现Python在对找到的匹配项进行适当处理后,再替换掉原来那个匹配的项. #!/usr/bin/python # coding=GBK import re # 对m作适当处理后返回结果 def fun(m): print("in: %s" %m.group(0)) ret = m.group(0).upper()[::-1] return ret src = "what

-

Python 利用Entrez库筛选下载PubMed文献摘要的示例

作者:xiaolanLin 声明 :本文版权归作者和博客园共有,来源网址:https://www.cnblogs.com/xiaolan-Lin 一个不是学生物的孩子来搞生物,当真是变成了一块废铁啊,但也是让我体会到了一把生物信息的力量. 废话不多说,开整! 任务:快速高效从PubMed上下载满足条件的文献PMID.标题(TI).摘要(AB). PubMed官网 https://pubmed.ncbi.nlm.nih.gov 此处有几种选择可以达到目的: (1)官网上匹配筛选条件(注:匹配快速,

-

python使用pandas实现筛选功能方式

目录 1 筛选出数据的指定几行数据 2 筛选出数据某列为某值的所有数据记录 3 模式匹配 4 范围区间值筛选 5 获取某一行某一列的某个值 6 获取原始的numpy二维数组 7 根据条件得到某行元素所在的位置 8 元素位置筛选 9. 删除多行/多列 10 to_datetime将字符串格式转化为日期格式 11 apply() 函数 12 map() 函数 参考 总结 1 筛选出数据的指定几行数据 data=df.loc[2:5] #这里的[2:5]表示第3行到第5行内容,[]第一个起始是0,表示

-

Python格式化压缩后的JS文件的方法

本文实例讲述了Python格式化压缩后的JS文件的方法.分享给大家供大家参考.具体分析如下: 该脚本可以把压缩后的js文件格式上进行些还原,当然不会百分百完美,暂不处理语法问题,只是为了方便阅读js代码 lines = open("unformated.js").readlines()[0].split(";") #一般压缩后的文件所有代码都在一行里 #视情况设定索引,我的情况时第0行是源代码. indent = 0 formatted = [] for line

-

Python统计文件中去重后uuid个数的方法

本文实例讲述了Python统计文件中去重后uuid个数的方法.分享给大家供大家参考.具体如下: 利用正则表达式按行获取日志文件中的的uuid,并且统计这些uuid的去重个数(去重利用set) import re pattern=re.compile(r'&uuid=.*&') uuidset=set() with open('request.log.2015-05-26','rt') as f: for line in f: all=pattern.findall(line) if len

-

修复CentOS7升级Python到3.6版本后yum不能正确使用的解决方法

之前把现有这台阿里CentOS7.2系统的Python2.7.5升级成Python3.6后,yum工具就不能不觉使用了.当时查了下说明python版本的问题,但是用网上的方法还是没解决,后面也就一直没管了.最近要弄一个Nodejs小程序,需要用yum安装一些开发工具,不得不修复这个问题. 1 yum工具报错情况 直接执行 yum 命令就会提示 /usr/bin/yum 文件第34行有错误: [root@typecodes ~]# yum File "/usr/bin/yum", lin

-

Python在groupby分组后提取指定位置记录方法

在进行数据分析.数据建模时,我们首先要做的就是对数据进行处理,提取我们需要的信息.下面为大家介绍一些groupby的用法,以便能够更加方便地进行数据处理. 我们往往在使用groupby进行信息提取时,往往是求分组后样本的一些统计量(max.min,var等).如果现在我们希望取一下分组后样本的第二条记录,倒数第三条记录,这个该如何操作呢?我们可以通过first.last来提取分组后第一条和最后一条样本.但如果我们要取指定位置的样本,就没有现成的函数.需要我们自己去写了.下面我就为大家介绍如何实现

随机推荐

- 详解删除SQL Server 2005 Compact Edition数据库

- Extjs中常用表单介绍与应用

- 详解angularJS动态生成的页面中ng-click无效解决办法

- MySQL Proxy(解决注入的另一思路)

- 快速排序和分治排序介绍

- js实现简单的获取验证码按钮效果

- asp.net连接数据库 增加,修改,删除,查询代码

- Javascript编程之继承实例汇总

- c++ 编程 几个有用的宏详解

- php判断文件上传类型及过滤不安全数据的方法

- JavaScript通过代码调用Flash显示的方法

- JS实现超精简的链接列表在固定区域内滚动效果代码

- DIV+CSS布局的网站对网站SEO的影响分析

- EasyUI 结合JS导出Excel文件的实现方法

- JavaScript高级程序设计(第3版)学习笔记12 js正则表达式

- 添加到收藏夹代码(兼容几乎所有的浏览器)

- c语言strftime时间格式化示例

- Linux下用java -jar运行可执行jar包的方法教程

- 将HTML格式的String转化为HTMLElement的实现方法

- Ubuntu 18.04 LTS中配置IP地址的完整步骤