Python中寻找数据异常值的3种方法

目录

- 1. 引言

- 2. 举个栗子

- 3. 孤立森林

- 4. 椭圆模型拟合

- 5. 局部异常因子算法

- 6. 挑选异常值检测方法

- 7. 异常值消除

- 8. 总结

1. 引言

在数据处理、机器学习等领域,我们经常需要对各式各样的数据进行处理,本文重点介绍三种非常简单的方法来检测数据集中的异常值。

2. 举个栗子

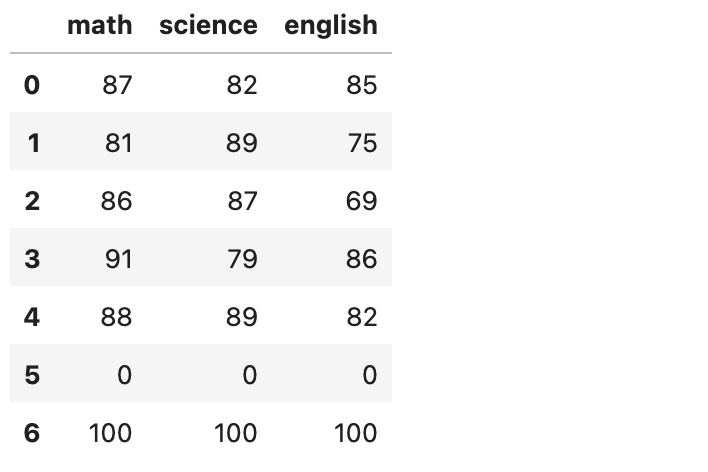

为了方便介绍,这里给出我们的测试数据集,如下:

data = pd.DataFrame([ [87, 82, 85], [81, 89, 75], [86, 87, 69], [91, 79, 86], [88, 89, 82], [0, 0, 0], # this guy missed the exam [100, 100, 100], ], columns=["math", "science", "english"])

图示如下:

假设这里我们有一堆学生的三门科目的考试成绩——英语、数学和科学。这些学生通常表现很好,但其中一人错过了所有考试,三门科目都得了0分。在我们的分析中包括这个家伙可能会把事情搞砸,所以我们需要将他视为异常。

3. 孤立森林

使用孤立森林算法来求解上述异常值分析非常简单,代码如下:

from sklearn.ensemble import IsolationForest predictions = IsolationForest().fit(data).predict(data) # predictions = array([ 1, 1, 1, 1, 1, -1, -1])

这里预测值针对每一行进行预测,预测结果为1或者-1;其中1表示该行不是异常值,而-1表示该行是异常值。在上述例子中,我们的孤立森林算法将数据中的最后2行都预测为异常值。

4. 椭圆模型拟合

使用孤椭圆模型拟合算法来求解上述异常值同样非常方便,代码如下:

from sklearn.covariance import EllipticEnvelope predictions = EllipticEnvelope().fit(data).predict(data) # predictions = array([ 1, 1, 1, 1, 1, -1, 1])

在上述代码中,我们使用了另外一种异常值检测算法来代替孤立森林算法,但是代码保持不变。相似地,在预测值中,1表示非异常值,-1表示异常值。在上述情况下,我们的椭圆模型拟合算法只将倒数第二个学生作为异常值,即所有成绩都为零的考生。

5. 局部异常因子算法

类似地,我们可以非常方便地使用局部异常因子算法来对上述数据进行分析,样例代码如下:

from sklearn.neighbors import LocalOutlierFactor predictions = LocalOutlierFactor(n_neighbors=5, novelty=True).fit(data).predict(data) # array([ 1, 1, 1, 1, 1, -1, 1])

局部异常因子算法是sklearn上可用的另一种异常检测算法,我们可以简单地在这里随插随用。同样地,这里该算法仅将最后第二个数据行预测为异常值。

6. 挑选异常值检测方法

那么,我们如何决定哪种异常检测算法更好呢? 简而言之,没有“最佳”的异常值检测算法——我们可以将它们视为做相同事情的不同方式(并获得略有不同的结果)

7. 异常值消除

在我们从上述三种异常检测算法中的任何一种获得异常预测后,我们现在可以执行异常值的删除。 这里我们只需保留异常预测为1的所有数据行,

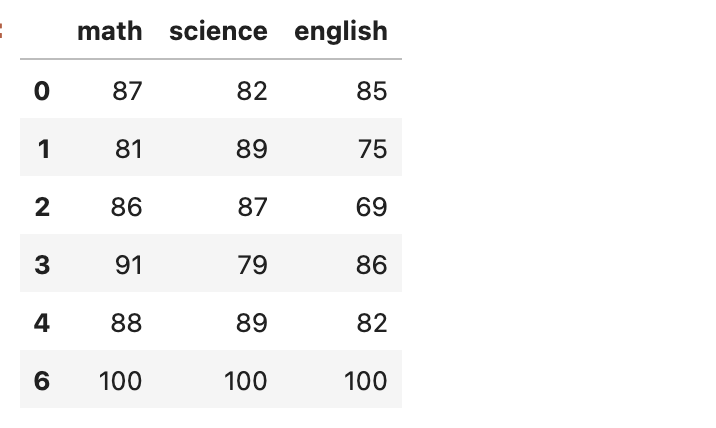

代码如下:

# predictions = array([ 1, 1, 1, 1, 1, -1, 1]) data2 = data[predictions==1]

结果如下:

8. 总结

本文重点介绍了在Python中使用sklearn机器学习库来进行异常值检测的三种方法,并给出了相应的代码示例。

到此这篇关于Python中寻找数据异常值的3种方法的文章就介绍到这了,更多相关Python寻找数据异常值内容请搜索我们以前的文章或继续浏览下面的相关文章希望大家以后多多支持我们!