手把手带你用python爬取小姐姐私房照

目录

- 如何用Python搞到小姐姐私房照

- 目标站点

- 开发环境

- 效果预览

- 正式教程

- 一、第三方库安装

- 二、爬虫的基本套路

- 分析目标站点

- 请求网站获取数据

- 解析数据

- 保存数据

- 写在最后

如何用Python搞到小姐姐私房照

本文纯技术角度出发,教你如何用Python爬虫获取百度图库海量照片——技术无罪。

学会获取小姐姐私房照同理可得也能获取其他的照片,技术原理是一致的。

目标站点

百度图片使用关键字搜索 小姐姐私房照

https://image.baidu.com/

开发环境

- 系统:Windows10 64位

- Python版本:Python3.6.5(Python3以上版本即可)

- IDE:Pycharm(非必须,其实你完全可以记事本写代码)

- 第三方库:requests、jsonpath

效果预览

网页私房照

代码爬取效果

正式教程

一、第三方库安装

在确保你正确安装了Python解释器之后,我们还需要安装几个第三方库,命令如下**[在终端中安装即可]**:

HTTP请求库:

pip3 install requests

JSON数据解析库:

pip3 install jsonpath

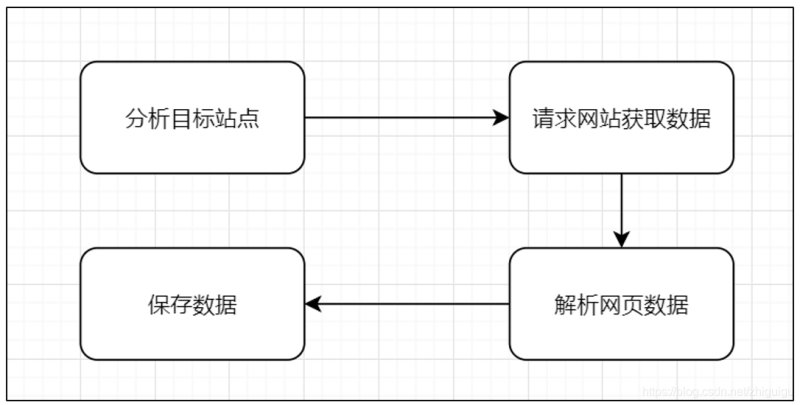

二、爬虫的基本套路

- 不管是爬取哪类网站,在爬虫中基本都遵循以下的基本套路:

请求数据 → 获取响应内容 → 解析内容 → 保存数据

- 当然,以上步骤是代码的编写思路,实际操作中应该还要添加一个前置步骤,所以完整流程如下:

分析目标站点 → 请求网站获取数据 → 解析内容 → 保存数据

分析目标站点

快速的分析目标站点就很容易发现百度图库的图片资源是通过AJAX加载的,所以我们要请求的链接并非浏览器地址栏链接,而是ajax加载的数据包的资源路径,如图:

那么问题来了,如何获取到这些数据包的地址?其实很简单,如图所示:

请求网站获取数据

编写代码请求资源,这里有一点需要注意:请求头必须携带,否则有可能请求失败导致报错。

import requests # 导包

# 构建请求头,把爬虫程序伪装成正常的浏览器用户

headers = {

'sec-fetch-dest': 'image',

'Host': 'image.baidu.com',

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/89.0.4389.82 Safari/537.36 Edg/89.0.774.50',

}

# 资源包的url链接

url = 'https://image.baidu.com/search/acjson?tn=resultjson_com&logid=10913526997707526921&ipn=rj&ct=201326592&is=&fp=result&queryWord=%E5%B0%8F%E5%A7%90%E5%A7%90%E7%A7%81%E6%88%BF%E7%85%A7&cl=2&lm=-1&ie=utf-8&oe=utf-8&adpicid=&st=-1&z=&ic=&hd=&latest=©right=&word=%E5%B0%8F%E5%A7%90%E5%A7%90%E7%A7%81%E6%88%BF%E7%85%A7&s=&se=&tab=&width=&height=&face=0&istype=2&qc=&nc=1&fr=&expermode=&force=&pn=210&rn=30&gsm=d2&1616553658252='

# 构建请求

response = requests.get(url,headers=headers)

# 查看状态码

print(response.status_code)

# 获取原始数据

response.json()

解析数据

上述代码最终获取到的数据是json数据,也就是我们Python中常说的字典,它长这样:

{

"queryEnc":"%D0%A1%BD%E3%BD%E3%CB%BD%B7%BF%D5%D5",

"queryExt":"小姐姐私房照",

"listNum":758,

"displayNum":8392,

"gsm":"f0",

"bdFmtDispNum":"约8,390",

"bdSearchTime":"",

"isNeedAsyncRequest":0,

"bdIsClustered":"1",

"data":[

Object{...}, # 没张私房照对应的详细信息,其中就有图片的URL

Object{...},

···

}

既然它是一个字典,我们当然是可以使用Python中的键值索引方式获取到想要的数据,但是此方法太笨,这里介绍一种更加高明的方式,使用jsonpath解析数据

# 这一行代码便可以获取到所有图片的URL,返回的是一个列表,遍历即可拿到每一个URL imgs = jsonpath.jsonpath(json_data, '$..middleURL')

使用requests请求图片URL,获取图片数据

image_data = requests.get(page_url).content

保存数据

使用Python中的文件对象,保存图片,图片名字使用时间戳命名,避免图片重名

with open('imgs/' + datetime.now().strftime("%Y%m%d%H%M%S%f") + '.jpg', 'wb') as f:

f.write(image_data)

写在最后

到这整个儿爬虫程序就写完了。

当然,当前的这个只能爬取一个资源包中的数据,要爬取多个资源包或者说全部资源包的数据也是很简单的,只需要分析分析资源包的URL变化规律就不难发现其中的某个关键字变化,灵活改变该关键字就可以不断爬取。

文章正文到这里已经结束了,只是想感谢一些阅读我文章的人。

我退休后一直在学习如何写文章,说实在的,每次我在后台看到一些读者的回应就会觉得很欣慰,于是我想把我收藏的一些编程干货贡献给大家,回馈每一个读者,希望能帮到你们。

到此这篇关于手把手带你用python爬取小姐姐私房照的文章就介绍到这了,更多相关python爬取图片内容请搜索我们以前的文章或继续浏览下面的相关文章希望大家以后多多支持我们!