关于python中.xpath的使用问题

在python中使用xpath定位时,有时候会先用.xpath定位到一个地点,for循环后,继续使用.xpath,但是会出现问题,比如在下面这个例子中:

根据xpath定位到了tr,注意游览器自动生成了tbody,在python中要把自动生成的tbody层级去掉。

此时我们想获取tr下面的td,请看代码

import requests

from lxml import etree

url = "https://www.w3school.com.cn/xpath/xpath_axes.asp"

res = requests.get(url).text

html = etree.HTML(res)

a = html.xpath("(//table[@class='dataintable'])[1]/tr")

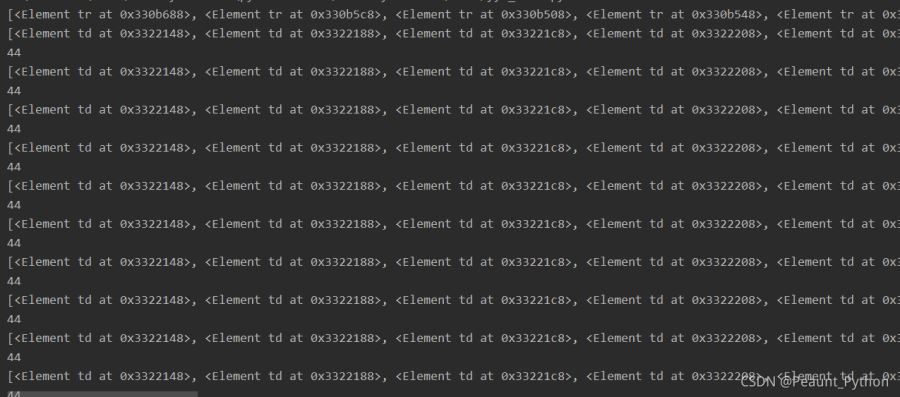

print(a)

for i in a:

s = i.xpath("//td")

print(s)

print(len(s))

for i in a下,我们想找到的是每个tr下面的td,按理来说只有两个,但是返回的却是全部的44个td,问题出在哪里呢?原来是s = i.xpath("//td")这个写法不对,虽然 i 继承了 a 的xpath路径,但是如果写成//td,等于告诉xpath重新搜索全部,必须要加上点才可以。s = i.xpath(".//td"),一个点代表当前目录,两个点代表上级目录

这次搜索正常了

总结:除非在一开始的搜索式直接写成 (//table[@class='dataintable'])[1]/tr//td,这样直接搜索td,不用带点,在复用.xpath的时候,必须加上点表明当前目录,否则搜索不到想要的结果

到此这篇关于关于python中.xpath的复用的文章就介绍到这了,更多相关python .xpath复用内容请搜索我们以前的文章或继续浏览下面的相关文章希望大家以后多多支持我们!

相关推荐

-

python爬虫之xpath的基本使用详解

一.简介 XPath 是一门在 XML 文档中查找信息的语言.XPath 可用来在 XML 文档中对元素和属性进行遍历.XPath 是 W3C XSLT 标准的主要元素,并且 XQuery 和 XPointer 都构建于 XPath 表达之上. 二.安装 pip3 install lxml 三.使用 1.导入 from lxml import etree 2.基本使用 from lxml import etree wb_data = """ <div> <u

-

python Xpath语法的使用

一.XMl简介 (一)什么是 XML XML 指可扩展标记语言(EXtensible) XML 是一种标记语言,很类似 HTML. XML 的设计宗旨是传输数据,而非显示数据. XML 的标签需要我们自行定义. XML 被设计为具有自我描述性. XML 是 W3C 的推荐标准. W3School 官方文档:http://www.w3school.com.cn/xml/index.asp (二)XML 和 HTML 的区别 他们两者都是用于操作数据或者结构数据,在结构上大致相同的,但他们在本质上却

-

python使用XPath解析数据爬取起点小说网数据

1. xpath 的介绍 xpath是一门在XML文档中查找信息的语言 优点: 可以在xml中找信息 支持HTML的查找 可以通过元素和属性进行导航 但是Xpath需要依赖xml的库,所以我们需要去安装lxml的库. 安装lxml库 我们先要安装lxml的库,直接在pycharm里安装即可: XML的树形结构: 元素-元素-属性-文本 使用XPath选取节点: nodename: 选取此节点的所有节点 /从根节点选择 // 从匹配选择的当前节点选择文档中的节点,而不考虑他们的位置 . 选择当前节

-

Python使用xpath实现图片爬取

高性能异步爬虫 目的:在爬虫中使用异步实现高性能的数据爬取操作 异步爬虫的方式: - 多线程.多进程(不建议): 好处:可以为相关阻塞的操作单独开启多线程或进程,阻塞操作就可以异步执行; 弊端:无法无限制的开启多线程或多进程. - 线程池.进程池(适当的使用): 好处:我们可以降低系统对进程或线程创建和销毁的一个频率,从而很好的降低系统的开销: 弊端:池中线程或进程的数据是有上限的. 代码如下 # _*_ coding:utf-8 _*_ """ @FileName :6.4

-

python中requests库+xpath+lxml简单使用

python的requests 它是python的一个第三方库,处理URL比urllib这个库要方便的多,并且功能也很丰富. [可以先看4,5表格形式的说明,再看前面的] 安装 直接用pip安装,anconda是自带这个库的. pip install requests 简单使用 requests的文档 1.简单访问一个url: import requests url='http://www.baidu.com' res = requests.get(url) res.text res.statu

-

python数据XPath使用案例详解

目录 XPath XPath使用方法 xpath解析原理: 安装lxml 案例-58二手房 XPath XPath即为XML路径语言(XML Path Language),它是一种用来确定XML文档中某部分位置的语言. XPath使用方法 xpath解析原理: 1.实例化一个etree的对象,且需要将被解析的页面源代码数据加载到该对象中 2.调用etree对象中的xpath方法结合着xpath表达式实现标签的定位和内容的捕获 安装lxml pip install -i https://mirro

-

python 中xpath爬虫实例详解

案例一: 某套图网站,套图以封面形式展现在页面,需要依次点击套图,点击广告盘链接,最后到达百度网盘展示页面. 这一过程通过爬虫来实现,收集百度网盘地址和提取码,采用xpath爬虫技术 1.首先分析图片列表页,该页按照更新先后顺序暂时套图封面,查看HTML结构.每一组"li"对应一组套图.属性href后面即为套图的内页地址(即广告盘链接页).所以,我们先得获取列表页内所有的内页地址(即广告盘链接页) 代码如下: import requests 倒入requests库 from lxml

-

关于python中.xpath的使用问题

在python中使用xpath定位时,有时候会先用.xpath定位到一个地点,for循环后,继续使用.xpath,但是会出现问题,比如在下面这个例子中: 根据xpath定位到了tr,注意游览器自动生成了tbody,在python中要把自动生成的tbody层级去掉. 此时我们想获取tr下面的td,请看代码 import requests from lxml import etree url = "https://www.w3school.com.cn/xpath/xpath_axes.asp&qu

-

Python中利用xpath解析HTML的方法

在进行网页抓取的时候,分析定位html节点是获取抓取信息的关键,目前我用的是lxml模块(用来分析XML文档结构的,当然也能分析html结构), 利用其lxml.html的xpath对html进行分析,获取抓取信息. 首先,我们需要安装一个支持xpath的python库.目前在libxml2的网站上被推荐的python binding是lxml,也有beautifulsoup,不嫌麻烦的话还可以自己用正则表达式去构建,本文以lxml为例讲解. 假设有如下的HTML文档: <html> <

-

关于python中的xpath解析定位

爬取的网站:http://jbk.39.net/chancegz/ 这里只针对个别属性值: #例如:'别名'下的span标签文本,'发病部位'下的span标签文本以及'挂号科室'下的span标签文本 # def disease(url): text = get_html(url) tree = etree.HTML(text) bm = tree.xpath('//ul[@class="information_ul"]/li/i[text()="别名:"]/foll

-

利用Python中的Xpath实现一个在线汇率转换器

前言 在之前的语法里面,我们记得有一个初识Python之汇率转换篇,在那个程序里面我们发现可以运用一些基础的语法写一个汇率计算,但是学到后面的小伙伴就会发现这个小程序有一定的弊端. 首先,它不可以实时的获取汇率的值,每次都需要我们自己去定义一个汇率转换值,这个就会显得不是很智能,有点机械,所以我们这一个利用爬虫爬取一个网址里面的汇率值(一直在更新的),这里我们利用Xpath来获取这个数据值 其次我们发现在之前的程序里面,我们好像只能输入两位数的货币数据,这一次我们通过正负索引的方法,只获取除了最

-

python利用xpath爬取网上数据并存储到django模型中

帮朋友制作一个网站,需要一些产品数据信息,因为是代理其他公司产品,直接爬取代理公司产品数据 1.设计数据库 from django.db import models from uuslug import slugify import uuid import os def products_directory_path(instance, filename): ext = filename.split('.')[-1] filename = '{}.{}'.format(uuid.uuid4().

-

python中selenium操作下拉滚动条的几种方法汇总

UI自动化中经常会遇到元素识别不到,找不到的问题,原因有很多,比如不在iframe里,xpath或id写错了等等:但有一种是在当前显示的页面元素不可见,拖动下拉条后元素就出来了. 比如下面这样一个网页,需要进行拖动下拉条后才能通过selenium找到密码输入框的元素, 在python中有几种方法解决这种问题,简单介绍下,给需要的人: 方法一)使用js脚本直接操作,方法如下: js="var q=document.getElementById('id').scrollTop=10000"

-

python定位xpath 节点位置的方法

chrome 右键有copy xpath地址 但是有些时候获取的可能不对 可以自己用代码验证一下 如果还是不行 可以考虑从源码当中取出来 趁热打铁,使用前一篇文章中 XPath 节点来定位HTML 页面. HTML文件如下(您可以将其拷贝,保存成html文件,跟我笔者实验): <!DOCTYPE html> <html lang="en"> <head> <meta charset="UTF-8"> <title

-

python的xpath获取div标签内html内容,实现innerhtml功能的方法

python的xpath没有获取div标签内html内容的功能,也就是获取div或a标签中的innerhtml,写了个小程序实现一下: 源代码 [webadmin@centos7 csdnd4q] #162> vim /mywork/python/csdnd4q/z040.py #去掉最外层标签,保留其内的所有html标记和文本 def getinnerhtml(data): return data[data.find(">")+1:data.rfind("<

随机推荐

- Django自定义插件实现网站登录验证码功能

- DB2 9产品说明书在线参考地址(http)

- mysql 5.7.17 64bit安装配置方法图文教程

- spring boot请求异常处理并返回对应的html页面

- Python bsddb模块操作Berkeley DB数据库介绍

- 减少访问DOM的次数提升javascript性能

- JavaScript 命名空间 使用介绍

- JS中from 表单序列化提交的代码

- JS实现图片剪裁并预览效果

- Asp.Net 网站优化系列之数据库优化 分字诀 分表(纵向拆分,横向分区)

- android开发教程之startActivityForResult使用方法

- 经常腹胀怎么办?

- 支持数组的ADDSLASHES的php函数

- jQuery ztree实现动态树形多选菜单

- 随鼠标移动的图片或文字特效代码

- xScrollStick 跟随滚动条漂浮的JS特效

- Spring Boot统一异常处理详解

- 通过HttpClient 调用ASP.NET Web API示例

- php 使用fopen函数创建、打开文件详解及实例代码

- jenkins 远程构建Android的过程详解