Sqoop的安装与使用详细教程

本文我们介绍一个非常好用的数据传输工具——Sqoop。Sqoop是一款开源的工具,主要用于在Hadoop与传统数据库间进行数据的传递,可以将一个关系型数据库(例如:MySQL,Oracle,Postgres等)中的数据导进到Hadoop的HDFS中,也可以将HDFS的数据导进到关系型数据库中。Sqoop项目开始于2009年,最早是作为Hadoop的一个第三方模块存在,后来为了让使用者能够快速部署,也为了让开发人员能够更快速的迭代开发,Sqoop独立成为一个Apache项目。关注专栏《破茧成蝶——大数据篇》,查看更多相关的内容~

一、Sqoop的安装

1.1 下载上传安装包

1、首先下载安装包,点击此处进行下载。

2、将下载的安装包上传到集群中,解压到相关目录并重命名。

tar -zxvf sqoop-1.4.6.bin__hadoop-2.0.4-alpha.tar.gz -C ../modules/ mv sqoop-1.4.6.bin__hadoop-2.0.4-alpha sqoop

1.2 修改配置文件

1、首先重命名sqoop-env-template.sh文件

[root@master conf]# mv sqoop-env-template.sh sqoop-env.sh

2、在sqoop-env.sh中添加各组件的路径

export HADOOP_COMMON_HOME=/opt/modules/hadoop-2.7.2 export HADOOP_MAPRED_HOME=/opt/modules/hadoop-2.7.2 export HIVE_HOME=/opt/modules/hive export ZOOKEEPER_HOME=/opt/modules/zookeeper-3.4.10 export ZOOCFGDIR=/opt/modules/zookeeper-3.4.10 export HBASE_HOME=/opt/modules/hbase

1.3 拷贝JDBC驱动

拷贝MySQL的驱动包到Sqoop的lib目录下:

[root@master software]# cp ./mysql-connector-java-5.1.47.jar /opt/modules/sqoop/lib/

1.4 验证Sqoop是否安装成功

bin/sqoop help

出现上图的内容说明安装成功。

二、Sqoop的导入导出

2.1 测试连接数据库

bin/sqoop list-databases --connect jdbc:mysql://master:3306/ --username root --password p@ssw0rd

2.2 MySQL导入数据到HDFS

1、首先在MySQL数据库(xzw)中新建一张people表,如下所示:

create table people(id int(4) primary key not null auto_increment, name varchar(255), sex varchar(255));

insert into people(name, sex) values('xzw', 'Male');

insert into people(name, sex) values('fq', 'FeMale');

2、全量导入

bin/sqoop import \ --connect jdbc:mysql://master:3306/xzw \ --username root \ --password p@ssw0rd \ --table people \ --target-dir /user/sqoop/people \ --delete-target-dir \ --num-mappers 1 \ --fields-terminated-by ","

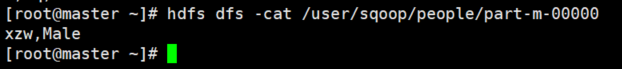

使用如下命令查看导入的结果:

3、查询导入

bin/sqoop import \ --connect jdbc:mysql://master:3306/xzw \ --username root \ --password p@ssw0rd \ --target-dir /user/sqoop/people \ --delete-target-dir \ --num-mappers 1 \ --fields-terminated-by "," \ --query 'select name,sex from people where id <=1 and $CONDITIONS;'

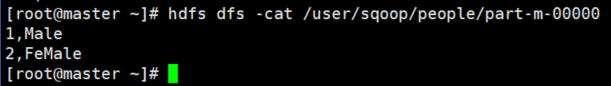

查看导入结果:

这里需要注意的是,如果query后使用的是双引号,则$CONDITIONS前必须加转义符\,防止shell识别为自己的变量。如果使用的是单引号,则不需要加。

4、导入指定列

bin/sqoop import \ --connect jdbc:mysql://master:3306/xzw \ --username root \ --password p@ssw0rd \ --target-dir /user/sqoop/people \ --delete-target-dir \ --num-mappers 1 \ --fields-terminated-by "," \ --columns id,sex \ --table people

查看结果:

这里需要注意的是,columns中如果涉及到多列,用逗号分隔,分隔时不要添加空格。

5、使用sqoop关键字筛选查询导入数据

bin/sqoop import \ --connect jdbc:mysql://master:3306/xzw \ --username root \ --password p@ssw0rd \ --target-dir /user/sqoop/people \ --delete-target-dir \ --num-mappers 1 \ --fields-terminated-by "," \ --table people \ --where "id=1"

查看结果:

2.3 MySQL导入数据到Hive

bin/sqoop import \ --connect jdbc:mysql://master:3306/xzw \ --username root \ --password p@ssw0rd \ --table people \ --num-mappers 1 \ --hive-import \ --fields-terminated-by "," \ --hive-overwrite \ --hive-table hive_people

该过程分为两步,第一步将数据导入到HDFS,第二步将导入到HDFS的数据迁移到Hive仓库。这里需要注意的是,Hive中的表不需要提前创建,Sqoop会在导数据的过程中自动创建表。

2.4 MySQL导入数据到HBase

bin/sqoop import \ --connect jdbc:mysql://master:3306/xzw \ --username root \ --password p@ssw0rd \ --table people \ --columns "id,name,sex" \ --column-family "info" \ --hbase-create-table \ --hbase-row-key "id" \ --hbase-table "hbase_people" \ --num-mappers 1 \ --split-by id

这里需要注意的是,需要提前将HBase表建好:

create 'hbase_people','info'

2.5 HDFS导出数据到MySQL

bin/sqoop export \ --connect jdbc:mysql://master:3306/xzw \ --username root \ --password p@ssw0rd \ --table people \ --num-mappers 1 \ --export-dir /user/sqoop/people \ --input-fields-terminated-by ","

这里需要注意的是,如果MySQL中不存在表,不会自动创建,简言之就是在执行导出之前需要在MySQL中创建好表。

三、Sqoop脚本打包

我们使用opt格式的文件打包Sqoop命令,然后执行,具体如下。

首先在Sqoop的安装目录新建目录opt,并编写脚本如下:

export --connect jdbc:mysql://master:3306/xzw --username root --password p@ssw0rd --table people --num-mappers 1 --export-dir /user/sqoop/people --input-fields-terminated-by ","

然后使用如下命令执行脚本:

bin/sqoop --options-file opt/HDFSToMySQL.opt

到此这篇关于Sqoop的安装与使用详细教程的文章就介绍到这了,更多相关Sqoop安装与使用内容请搜索我们以前的文章或继续浏览下面的相关文章希望大家以后多多支持我们!

到此这篇关于Sqoop的安装与使用详细教程的文章就介绍到这了,更多相关Sqoop安装与使用内容请搜索我们以前的文章或继续浏览下面的相关文章希望大家以后多多支持我们!