已安装tensorflow-gpu,但keras无法使用GPU加速的解决

问题

我们使用anoconda创建envs环境下的Tensorflow-gpu版的,但是当我们在Pycharm设置里的工程中安装Keras后,发现调用keras无法使用gpu进行加速,且使用的是cpu在运算,这就违背了我们安装Tensorflow-gpu版初衷了。

原因

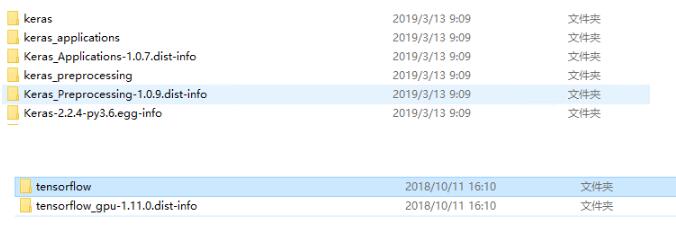

因为我们同时安装了tensorflow和tensorflow-gpu(在…Anaconda3\envs\fyy_tf\Lib\site-packages中可以找到他们的文件夹),使用keras时会默认调用tensorflow,从而无法使用GPU进行训练。

解决方法

同时卸载tensorflow、tensorflow-gpu 和 keras(可以直接去…Anaconda3\envs\fyy_tf\Lib\site-packages下删除他们的文件夹);

然后,再在Pycharm设置中使用小加号安装tensorflow-gpu 和 keras。

最后就可以使用keras进行gpu加速。

以上这篇已安装tensorflow-gpu,但keras无法使用GPU加速的解决就是小编分享给大家的全部内容了,希望能给大家一个参考,也希望大家多多支持我们。

相关推荐

-

解决TensorFlow GPU版出现OOM错误的问题

问题: 在使用mask_rcnn预测自己的数据集时,会出现下面错误: ResourceExhaustedError: OOM when allocating tensor with shape[1,512,1120,1120] and type float on /job:localhost/replica:0/task:0/device:GPU:0 by allocator GPU_0_bfc [[{{node rpn_model/rpn_conv_shared/convolution}} =

-

tensorflow指定GPU与动态分配GPU memory设置

在tensorflow中,默认指定占用所有的GPU,如需指定占用的GPU,可以在命令行中: export CUDA_VISIBLE_DEVICES=1 这样便是只占用1号GPU,通过命令 nvidia-smi 可以查看各个GPU的使用情况. 另外,也可以在python程序中指定GPU,并且动态分配memory,代码如下 import os import sys os.environ['CUDA_VISIBLE_DEVICES'] = sys.argv[1] import tensorflow a

-

检测tensorflow是否使用gpu进行计算的方式

如下所示: import tensorflow as tf sess = tf.Session(config=tf.ConfigProto(log_device_placement=True)) 查看日志信息若包含gpu信息,就是使用了gpu. 其他方法:跑计算量大的代码,通过 nvidia-smi 命令查看gpu的内存使用量. 以上这篇检测tensorflow是否使用gpu进行计算的方式就是小编分享给大家的全部内容了,希望能给大家一个参考,也希望大家多多支持我们.

-

tensorflow:指定gpu 限制使用量百分比,设置最小使用量的实现

在Python代码中指定GPU import os os.environ["CUDA_VISIBLE_DEVICES"] = "0" 设置定量的GPU使用量: config = tf.ConfigProto() config.gpu_options.per_process_gpu_memory_fraction = 0.9 # 占用GPU90%的显存 session = tf.Session(config=config) 设置最小的GPU使用量: config =

-

基于tensorflow指定GPU运行及GPU资源分配的几种方式小结

1. 在终端执行时设置使用哪些GPU(两种方式) (1) 如下(export 语句执行一次就行了,以后再运行代码不用执行) (2) 如下 2. 代码中指定(两种方式) (1) import os os.environ["CUDA_VISIBLE_DEVICES"] = "1" (2) # Creates a graph. with tf.device('/gpu:1'): a = tf.constant([1.0, 2.0, 3.0, 4.0, 5.0, 6.0],

-

基于Tensorflow使用CPU而不用GPU问题的解决

之前的文章讲过用Tensorflow的object detection api训练MobileNetV2-SSDLite,然后发现训练的时候没有利用到GPU,反而CPU占用率贼高(可能会有Could not dlopen library 'libcudart.so.10.0'之类的警告).经调查应该是Tensorflow的GPU版本跟服务器所用的cuda及cudnn版本不匹配引起的.知道问题所在之后就好办了. 检查cuda和cudnn版本 首先查看cuda版本: cat /usr/local/

-

运行tensorflow python程序,限制对GPU和CPU的占用操作

一般情况下,运行tensorflow时,默认会占用可以看见的所有GPU,那么就会导致其它用户或程序无GPU可用,那么就需要限制程序对GPU的占用.并且,一般我们的程序也用不了所有的GPU资源,只是强行霸占着,大部分资源都不会用到,也不会提升运行速度. 使用nvidia-smi可以查看本机的GPU使用情况,如下图,这里可以看出,本机的GPU型号是K80,共有两个K80,四块可用(一个K80包括两块K40). 1.如果是只需要用某一块或某几块GPU,可以在运行程序时,利用如下命令运行:CUDA_VI

-

解决Tensorflow占用GPU显存问题

我使用Pytorch进行模型训练时发现真正模型本身对于显存的占用并不明显,但是对应的转换为tensorflow后(权重也进行了转换),发现Python-tensorflow在使用时默认吃掉所有显存,并且不手动终结程序的话显存并不释放(我有两个序贯的模型,前面一个跑完后并不释放占用显存)(https://github.com/tensorflow/tensorflow/issues/1727),这一点对于后续的工作有很大的影响. 后面发现python-tensorflow限制显存有两种方法: 1.

-

tensorflow使用指定gpu的方法

TensorFlow是一个基于数据流编程(dataflow programming)的符号数学系统,被广泛应用于各类机器学习(machine learning)算法的编程实现,其前身是谷歌的神经网络算法库DistBelief [1] . Tensorflow拥有多层级结构,可部署于各类服务器.PC终端和网页并支持GPU和TPU高性能数值计算,被广泛应用于谷歌内部的产品开发和各领域的科学研究 . TensorFlow由谷歌人工智能团队谷歌大脑(Google Brain)开发和维护,拥有包括Ten

-

已安装tensorflow-gpu,但keras无法使用GPU加速的解决

问题 我们使用anoconda创建envs环境下的Tensorflow-gpu版的,但是当我们在Pycharm设置里的工程中安装Keras后,发现调用keras无法使用gpu进行加速,且使用的是cpu在运算,这就违背了我们安装Tensorflow-gpu版初衷了. 原因 因为我们同时安装了tensorflow和tensorflow-gpu(在-Anaconda3\envs\fyy_tf\Lib\site-packages中可以找到他们的文件夹),使用keras时会默认调用tensorflow,从

-

查看已安装tensorflow版本的方法示例

由于tensorflow版本不同,可能一些函数的调用也有变换,这时候可能需要查看tensorflow版本,可以在终端输入查询命令如下: import tensorflow as tf tf.__version__ 查询tensorflow安装路径为: tf.__path__ 查询结果如下: 根据自己的情况选择以下命令之一进行安装: pip install tensorflow==1.2 # Python 2.7; 仅支持CPU pip3 install tensorflow==1.2 # P

-

Keras设定GPU使用内存大小方式(Tensorflow backend)

通过设置Keras的Tensorflow后端的全局变量达到. import os import tensorflow as tf import keras.backend.tensorflow_backend as KTF def get_session(gpu_fraction=0.3): '''Assume that you have 6GB of GPU memory and want to allocate ~2GB''' num_threads = os.environ.get('OM

-

TensorFlow和keras中GPU使用的设置操作

1. 训练运行时候指定GPU 运行时候加一行代码: CUDA_VISIBLE_DEVICES=1 python train.py 2. 运行过程中按需或者定量分配GPU tensorflow直接在开启Session时候加几行代码就行,而Keras指定GPU,并限制按需用量和TensorFlow不太一样,因为keras训练是封装好的,不好对Session操作.如下是两种对应的操作. keras中的操作: import os import tensorflow as tf from keras.ba

-

解决Keras使用GPU资源耗尽的问题

我们在使用GPU资源进行训练的时候,可能会发生资源耗尽的情况,那么在在这种情况,我们需要对GPU的资源进行合理的安排,具体使用办法如下: 框架:Tensorflow和Keras 方法 import tensorflow as tf import keras.backend.tensorflow_backend as KTF config = tf.ConfigProto() config.gpu_options.allow_growth=True #不全部占满显存, 按需分配 sess = tf

-

windows安装TensorFlow和Keras遇到的问题及其解决方法

安装TensorFlow在Windows上,真是让我心力交瘁,想死的心都有了,在Windows上做开发真的让人发狂. 首先说一下我的经历,本来也就是起初,网上说python3.7不支持TensorFlow环境,而且使用Anaconda最好,所以我将我之前Windows上所有的python环境卸载掉!!!,对没错,是所有,包括Anaconda环境,python环境,pycharm环境也卸载掉了.而且我丧心病狂的在电脑上找几乎所有关于python的字眼,全部删除掉,统统不留.只是为了铁了心在Wind

-

keras 多gpu并行运行案例

一.多张gpu的卡上使用keras 有多张gpu卡时,推荐使用tensorflow 作为后端.使用多张gpu运行model,可以分为两种情况,一是数据并行,二是设备并行. 二.数据并行 数据并行将目标模型在多个设备上各复制一份,并使用每个设备上的复制品处理整个数据集的不同部分数据. 利用multi_gpu_model实现 keras.utils.multi_gpu_model(model, gpus=None, cpu_merge=True, cpu_relocation=False) 具体来说

-

win10 + anaconda3 + python3.6 安装tensorflow + keras的步骤详解

初入深度学习,就遇到了困难,一直安装不了tensorflow和keras库!!!真是让人着急!!!在经过无数次尝试,看了无数篇博客之后,终于安装上了.下面是具体的安装步骤. 首先,创建一个新的环境,这个环境适合python3.5使用: conda create -n py35 python=3.5 anaconda 如果在创建过程中出现如下错误 RemoveError: 'setuptools' is a dependency of conda and cannot be removed fro

随机推荐

- DB2 9数据服务器发展3部曲

- mysql中Load Data记录换行问题的解决方法

- asp.net注册Javascript的方法

- JS实现动态给标签控件添加事件的方法示例

- JS组件Bootstrap实现图片轮播效果

- C#使用浏览按钮获得文件路径和文件夹路径的方法

- Android开发自定义TextView省略号样式的方法

- Vue计算属性的使用

- Javascript实例教程(19) 使用HoTMetal(1)

- Chart.js在Laravel项目中的应用示例

- jQuery事件绑定方法学习总结(推荐)

- 用注册表给应用程序加口令

- linux中误删除程序包恢复实例

- PHP+FastCGI+Nginx配置PHP运行环境

- 详细分析Apache安装设置全流程

- Linux C 时间函数应用

- C#生成不重复随机字符串类

- 基于jquery的lazy loader插件实现图片的延迟加载[简单使用]

- css为图片设置背景图片

- centos7利用yum安装lnmp的教程(linux+nginx+php7.1+mysql5.7)