Python获取百度热搜的完整代码

好久没写了,就把上课做的一个小东西拿出来分享一下吧。

百度网页截图如下 ↓↓↓

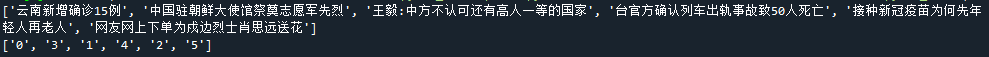

程序运行输出结果截图 ↓↓↓

上代码 ↓↓↓

from lxml import etree

from lxml import html

import requests

headers={'User-Agent':'Mozilla/5.0 (Windows NT 6.1) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/51.0.2704.63 Safari/537.36'}

page = requests.get("https://www.baidu.com",headers=headers)

html = page.text

#print(source1)

# 从字符串解析

element = etree.HTML(html)

# 元素列表,获取的方式列出了如下两种

# ps = element.xpath('//*[@id="hotsearch-content-wrapper"]/li/a/span[2]')

ps = element.xpath('//*[@class="title-content-title"]')

#热搜文本内容

text = []

if len(ps) > 0:

for p in ps:

#输出节点的文本

text1 = p.text

text.append(text1)

else:

print("空")

x = element.xpath('//*[@class="s-hotsearch-content"]/li')

#热搜文本对应的排名

index = []

for x1 in x:

#获取节点的属性

index1 = x1.get("data-index")

index.append(index1)

print(text)

print(index)

#定义一个对文本和排名进行匹配的函数,返回一个字典型数据

def PP(index_array,text_array):

x = {}

i = 0

for index_a in index_array:

#index_a = int(index_a)

x[index_a] = text_array[i]

i = i + 1

return x

re_text = PP(index,text)

#对字典性数据按key进行排序,即key=lambda re:re[0],排序完成后再转换为字典型数据

last_text = dict(sorted(re_text.items(),key=lambda re:re[0]))

到此这篇关于Python获取百度热搜的完整代码的文章就介绍到这了,更多相关Python 百度热搜内容请搜索我们以前的文章或继续浏览下面的相关文章希望大家以后多多支持我们!

相关推荐

-

Python爬虫爬取微博热搜保存为 Markdown 文件的源码

什么是爬虫? 网络爬虫(又被称为网页蜘蛛,网络机器人,在FOAF社区中间,更经常的称为网页追逐者),是一种按照一定的规则,自动地抓取万维网信息的程序或者脚本.另外一些不常使用的名字还有蚂蚁.自动索引.模拟程序或者蠕虫. 其实通俗的讲就是通过程序去获取web页面上自己想要的数据,也就是自动抓取数据 爬虫可以做什么? 你可以爬取小姐姐的图片,爬取自己有兴趣的岛国视频,或者其他任何你想要的东西,前提是,你想要的资源必须可以通过浏览器访问的到. 爬虫的本质是什么? 上面关于爬虫可以做什么,定义了一个前提

-

Python网络爬虫之爬取微博热搜

微博热搜的爬取较为简单,我只是用了lxml和requests两个库 url= https://s.weibo.com/top/summary?Refer=top_hot&topnav=1&wvr=6 1.分析网页的源代码:右键--查看网页源代码. 从网页代码中可以获取到信息 (1)热搜的名字都在<td class="td-02">的子节点<a>里 (2)热搜的排名都在<td class=td-01 ranktop>的里(注意置顶微博是

-

如何用python爬取微博热搜数据并保存

主要用到requests和bf4两个库 将获得的信息保存在d://hotsearch.txt下 import requests; import bs4 mylist=[] r = requests.get(url='https://s.weibo.com/top/summary?Refer=top_hot&topnav=1&wvr=6',timeout=10) print(r.status_code) # 获取返回状态 r.encoding=r.apparent_encoding demo

-

Python爬虫分析微博热搜关键词的实现代码

1,使用到的第三方库 requests BeautifulSoup 美味汤 worldcloud 词云 jieba 中文分词 matplotlib 绘图 2,代码实现部分 import requests import wordcloud import jieba from bs4 import BeautifulSoup from matplotlib import pyplot as plt from pylab import mpl #设置字体 mpl.rcParams['font.sans

-

python+selenium爬取微博热搜存入Mysql的实现方法

最终的效果 废话不多少,直接上图 这里可以清楚的看到,数据库里包含了日期,内容,和网站link 下面我们来分析怎么实现 使用的库 import requests from selenium.webdriver import Chrome, ChromeOptions import time from sqlalchemy import create_engine import pandas as pd 目标分析 这是微博热搜的link:点我可以到目标网页 首先我们使用selenium对目标网页进

-

Python获取百度热搜的完整代码

好久没写了,就把上课做的一个小东西拿出来分享一下吧. 百度网页截图如下 ↓↓↓ 程序运行输出结果截图 ↓↓↓ 上代码 ↓↓↓ from lxml import etree from lxml import html import requests headers={'User-Agent':'Mozilla/5.0 (Windows NT 6.1) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/51.0.2704.63 Safari/537.36'}

-

python获取百度热榜链接的实例方法

目标网址: https://www.baidu.com/ 要获取的内容: 链接分析: 从下图可以看出只需要获取关键字,再构建就可以了. 完整代码: import requests import pprint import re import urllib.parse url = 'https://www.baidu.com/' headers = { 'Host': 'www.baidu.com', 'Referer': 'https://www.baidu.com/',

-

用Python实现爬取百度热搜信息

目录 前言 库函数准备 数据爬取 网页爬取 数据解析 数据保存 总结 前言 何为爬虫,其实就是利用计算机模拟人对网页的操作 例如 模拟人类浏览购物网站 使用爬虫前一定要看目标网站可刑不可刑 :-) 可以在目标网站添加/robots.txt 查看网页具体信息 例如对天猫 可输入 https://brita.tmall.com/robots.txt 进行查看 User-agent 代表发送请求的对象 星号*代表任何搜索引擎 Disallow 代表不允许访问的部分 /代表从根目录开始 Allow代

-

python爬取热搜制作词云

环境:win10,64位,mysql5.7数据库,python3.9.7,ancod 逻辑流程: 1.首先爬取百度热搜,至少间隔1小时 2.存入文件,避免重复请求,如果本1小时有了不再请求 3.存入数据库,供词云包使用 1.爬取热搜,首先拿到url,使用的包urllib,有教程说urllib2是python2的. '''读取页面''' def readhtml(self,catchUrl): catchUrl=self.catchUrl if not catchUrl else catchUrl

-

python实现协同过滤推荐算法完整代码示例

测试数据 http://grouplens.org/datasets/movielens/ 协同过滤推荐算法主要分为: 1.基于用户.根据相邻用户,预测当前用户没有偏好的未涉及物品,计算得到一个排序的物品列表进行推荐 2.基于物品.如喜欢物品A的用户都喜欢物品C,那么可以知道物品A与物品C的相似度很高,而用户C喜欢物品A,那么可以推断出用户C也可能喜欢物品C. 不同的数据.不同的程序猿写出的协同过滤推荐算法不同,但其核心是一致的: 1.收集用户的偏好 1)不同行为分组 2)不同分组进行加权计算用

-

python连接读写操作redis的完整代码实例

python读写操作redis数据库 redis有16个逻辑数据库(编号db0到db15),每个逻辑数据库数据是隔离的,默认db0.选择第n个逻辑数据库,命令select n ,python连接时可指定数据库编号(0~15). 为python安装支持库: pip install redis 连接redis 第一种方式,直连: import redis def redis_opt(): redis_conn = redis.Redis(host='127.0.0.1', port=6379, pa

-

Python用户推荐系统曼哈顿算法实现完整代码

出租车几何或曼哈顿距离(Manhattan Distance)是由十九世纪的赫尔曼·闵可夫斯基所创词汇 ,是种使用在几何度量空间的几何学用语,用以标明两个点在标准坐标系上的绝对轴距总和. 图中红线代表曼哈顿距离,绿色代表欧氏距离,也就是直线距离,而蓝色和黄色代表等价的曼哈顿距离.曼哈顿距离--两点在南北方向上的距离加上在东西方向上的距离,即d(i,j)=|xi-xj|+|yi-yj|.对于一个具有正南正北.正东正西方向规则布局的城镇街道,从一点到达另一点的距离正是在南北方向上旅行的距离加上在东西

-

Python计算公交发车时间的完整代码

问题描述 公交车每天会按照一定间隔发车 , 由于不同时间段经过拥堵路段的用时不 - 样,所以给定路线下公交车每趟 ( 每车次 ) 行驶时间差异也很大,现在给出某路线某天各车次公交车离开始发站和到达终点站的时间,请求出该天耗时最长车次的行驶时间.输入说明 : 第 - - 行是一个整数 N, 示接下来的公交车车次的总数.之后是 N 行,每行开始是字母 S 或 Z, 表示是从始发站开出还是终点站开出.之后两个时间表示起始时间,时间给出方式为小时 + 分钟的形式,如 S 0830 1210 表示 8 点

-

python获取淘宝服务器时间的代码示例

然但是,这个只能获取到秒,没法到毫秒.我暂时不知道该咋解决 代码 import requests import time while True: class timeTaobao(object): r1 = requests.get(url='http://api.m.taobao.com/rest/api3.do?api=mtop.common.getTimestamp', headers={'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; WOW64)

-

python生成器和yield关键字(完整代码)

下列代码用于先体验普通列表推导式和生成器的差别: # def add(): # temp = ["姓名", "学号", "班级", "电话"] # dic = {} # lst = [] # for item in temp: # inp = input("请输入{}:".format(item)) # if inp == "exit

随机推荐

- [推荐]批处理的教学第1/2页

- VBS获取当前目录下所有文件夹名字的代码

- 使用shutdown命令实现远程关机和重启

- 用Python编写简单的定时器的方法

- IOS中html5上传图片方向问题解决方法

- iOS应用设计模式开发中对简单工厂和工厂方法模式的运用

- chrome下判断点击input上标签还是其余标签的实现方法

- C++学习笔记之pimpl用法详解

- 详解Bootstrap的aria-label和aria-labelledby应用

- js变量作用域及可访问性的探讨

- 如何在Ubuntu下启动Apache的Rewrite功能

- C#实现自定义FTP操作封装类实例

- Java设计模式之单例模式实例详解【懒汉式与饿汉式】

- C#与.net高级编程 C#的多态介绍

- Android实现第三方授权登录、分享以及获取用户资料

- C语言练习题:自由落体的小球简单实例

- jQuery JSON实现无刷新三级联动实例探讨

- 耗尽CPU资源的Explored病毒清除法

- SpringMVC接收复杂集合对象(参数)代码示例

- Oracle中sql语句(+)符号代表连接的使用讲解