Python实现清除文件夹中重复视频

目录

- 前言

- 1.科普

- 二进制文件

- 摘要算法(MD5)

- shutil模块

- 2.视频清除

- 视频全在一个文件夹里

- 视频在不同的文件夹里

- 3.总结

前言

在早期学Python的时候,买了一本《Python编程快速上手-让繁琐工作自动化》。

这本书里面讲得都比较基础,不过却非常的实用。

估计从书名大家伙们就应该能体会到。

本次根据书中的「读写文件」章节内容,实现一个简单又实用的小操作。

涉及到的模块有os、hashlib、shutil。

利用这三个模块实现对文件夹中的重复视频进行清除,实现文件夹中无重复文件情况发生。

1.科普

在进行代码操作前,简单对相关知识做个简单的学习。

毕竟我们不能停留在表象,要去明白它们的原理。

这样才能做到举一反三,提高学习效率。

二进制文件

二进制文件是以文本的二进制形式存储在计算机中。

用户一般不能直接读取它们,需要通过相应的软件才能将其显示出来。

二进制文件一般是可执行程序、图形、图像、声音等等。

本次实现的就是图像类型的文件,即视频!

摘要算法(MD5)

摘要算法又称哈希算法、散列算法。

它通过一个函数,把任意长度的数据转换为一个长度固定的数据串(通常用16进制的字符串表示)。

即通过摘要函数对任意长度的数据(data)计算出固定长度的摘要(digest)。

目的是为了发现原始数据是否被人篡改过。

摘要算法之所以能指出数据是否被篡改过,是因为摘要函数是一个单向函数,计算f(data)很容易,但通过digest反推data却非常困难。

而且,对原始数据做一个bit的修改,都会导致计算出的摘要完全不同。

MD5是最常见的摘要算法,速度很快,生成结果是固定的128bit字节,通常用一个32位的16进制字符串表示。

摘要算法在很多地方都有广泛的应用。

不过它并不是加密算法,不能用于加密(因为无法通过摘要反推明文),只能用于防篡改。

它的单向计算特性决定了可以在不存储明文口令的情况下验证用户口令。

其中Python的hashlib提供了常见的摘要算法,如MD5,SHA1等等。

本次文件夹中的视频就是使用MD5摘要算法,得到视频的摘要。

相当于给了视频一个ID属性,具备唯一性。

那么通过比较视频的摘要,便可以清除重复的视频。

我们知道重复视频的文件大小肯定是一样的,那么通过文件大小应该也是可以清除重复的视频。

只不过有时也会有不重复的视频大小一样的,毕竟视频大小只是个物理属性,不具备唯一性。

shutil模块

shutil是高级的文件,文件夹,压缩包处理模块。

shutil.copyfile(old, new),拷贝文件函数(就是复制的意思)。

2.视频清除

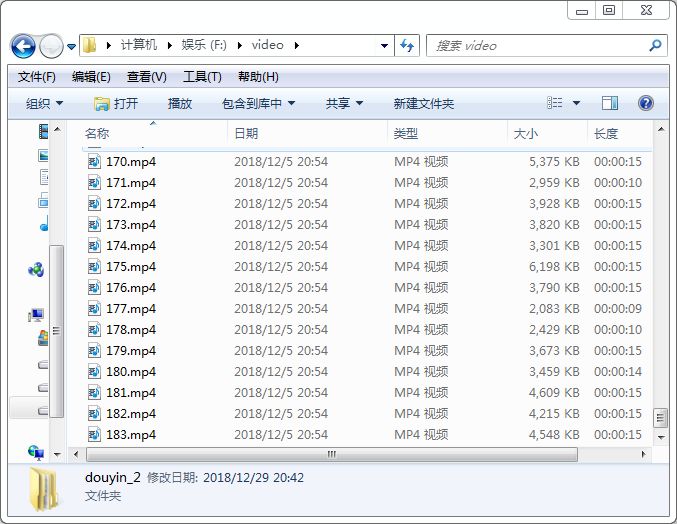

以之前自动化获取的抖音视频为例。

共183个抖音视频。

视频全在一个文件夹里

我新建了两种文件夹,一种视频全在一个文件夹里的。

这种使用视频大小作为筛选比较。

清除重复视频代码如下。

import os

import shutil

# 递归文件夹创建

folder_path = 'F:/video/douyin_11'

os.makedirs(folder_path)

# 获取文件夹里的文件名字符串列表

filenames = os.listdir('F:\\video\\douyin_1')

(size_list, name_list) = ([], [])

for name in filenames:

# 获取文件的路径

file_path = 'F:\\video\\douyin_1\\' + name

# 获取文件的大小

file_size = os.path.getsize(file_path)

# 如果不是重复视频的话,大小应该和列表中数据不一样

if file_size not in size_list:

# 获取不重复视频的大小

size_list.append(file_size)

# 获取不重复视频的路径

name_list.append(file_path)

# 使用shutil模块的copyfile函数,复制文件到新的文件夹中去

num = 0

for filename in name_list:

num += 1

oldname= filename

newname= 'F:\\video\\douyin_11\\' + str(num) + '.mp4'

shutil.copyfile(oldname, newname)

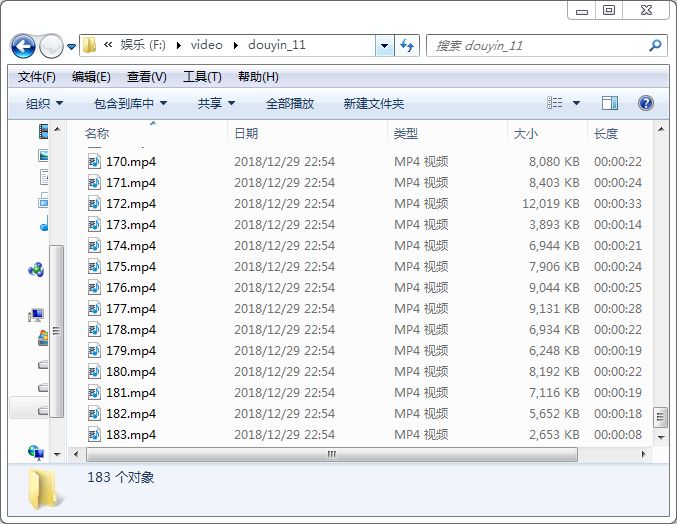

最后在新的文件夹中生成了183个视频文件。

说明成功清除了重复的视频文件。

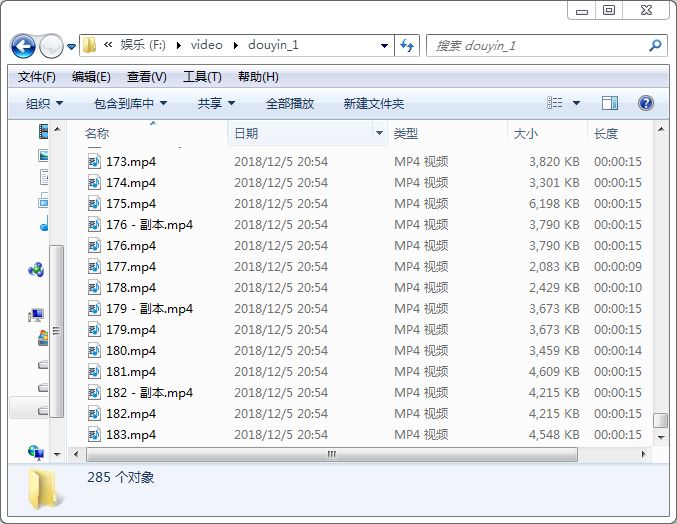

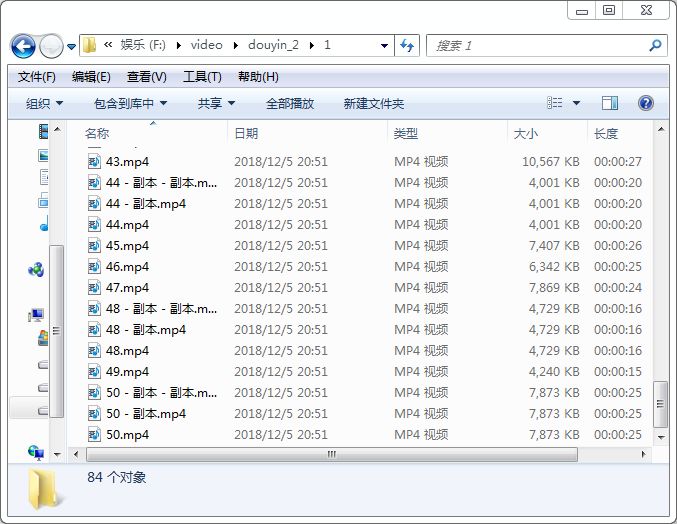

视频在不同的文件夹里

另一种视频分为几个部分,分别在不同文件夹下。

与上面不同的是,需要遍历文件夹,然后再去遍历文件夹中的文件。

另外使用摘要算法(MD5),生成视频的特有ID,以此作为标准。

清除重复视频代码如下。

import os

import shutil

import hashlib

# 摘要算法(MD5)实现视频摘要获取

def getmd5(file_path):

# 判断文件路径是否存在及文件是否为一个文件,意思应该是文件夹就会报错

if not os.path.isfile(file_path):

return

# rb,以二进制读模式打开

vediofile = open(file_path, 'rb')

md5 = hashlib.md5()

md5.update(vediofile.read())

vediofile.close()

# 返回视频文件的MD5值

return md5.hexdigest()

# 递归文件夹创建

folder_path = "F:/video/douyin_22"

os.makedirs(folder_path)

# 获取文件夹里的文件夹名字符串列表

foldernames = os.listdir('F:\\video\\douyin_2')

(value_list, name_list) = ([], [])

for folder in foldernames:

# 获取文件夹的路径

folder_name = 'F:\\video\\douyin_2\\' + folder

# 获取文件夹里的文件名字符串列表

file_names = os.listdir(folder_name)

for file_name in file_names:

# 获取文件的路径

file_path = folder_name + '\\' + file_name

# 获取文件的MD5值

value = getmd5(file_path)

# 如果不是重复视频的话,MD5值应和列表中数据不一样

if value not in value_list:

# 获取不重复视频的MD5值

value_list.append(value)

# 获取不重复视频的路径

name_list.append(file_path)

# 使用shutil模块的copyfile函数,复制文件到新的文件夹中去

num = 0

for filename in name_list:

num += 1

oldname= filename

newname= 'F:\\video\\douyin_22\\' + str(num) + '.mp4'

shutil.copyfile(oldname, newname)

最后也在新的文件夹中生成了183个视频文件。

说明也成功清除了重复的视频文件。

3.总结

试想一下如果你手动去删除这些重复的视频,该有多浪费时间。

这里也许你就能感受到了编程的乐趣了。

当然其他文件,类似文本文档、图片、音频,同样可以利用Python进行自动化操作。

到此这篇关于Python实现清除文件夹中重复视频的文章就介绍到这了,更多相关Python清除重复视频内容请搜索我们以前的文章或继续浏览下面的相关文章希望大家以后多多支持我们!