python获取整个网页源码的方法

1、Python中获取整个页面的代码:

import requests

res = requests.get('https://blog.csdn.net/yirexiao/article/details/79092355')

res.encoding = 'utf-8'

print(res.text)

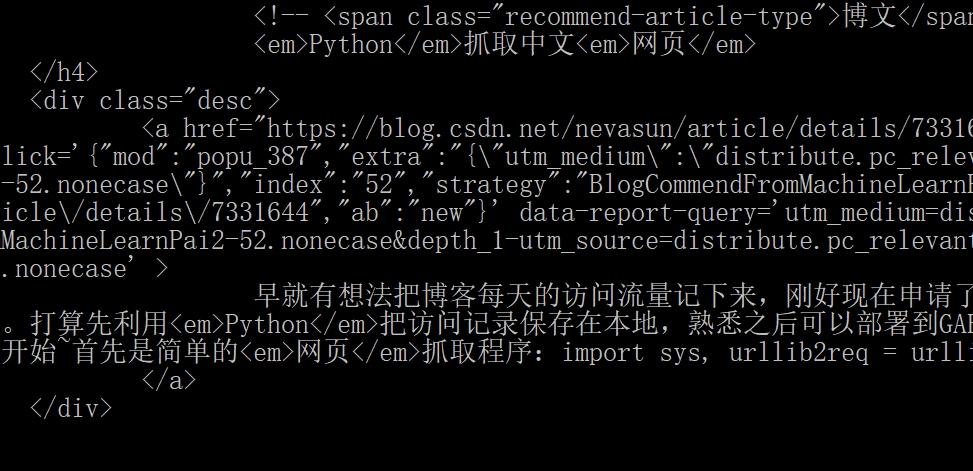

2、运行结果

实例扩展:

from bs4 import BeautifulSoup

import time,re,urllib2

t=time.time()

websiteurls={}

def scanpage(url):

websiteurl=url

t=time.time()

n=0

html=urllib2.urlopen(websiteurl).read()

soup=BeautifulSoup(html)

pageurls=[]

Upageurls={}

pageurls=soup.find_all("a",href=True)

for links in pageurls:

if websiteurl in links.get("href") and links.get("href") not in Upageurls and links.get("href") not in websiteurls:

Upageurls[links.get("href")]=0

for links in Upageurls.keys():

try:

urllib2.urlopen(links).getcode()

except:

print "connect failed"

else:

t2=time.time()

Upageurls[links]=urllib2.urlopen(links).getcode()

print n,

print links,

print Upageurls[links]

t1=time.time()

print t1-t2

n+=1

print ("total is "+repr(n)+" links")

print time.time()-t

scanpage(http://news.163.com/)

到此这篇关于python获取整个网页源码的方法的文章就介绍到这了,更多相关python如何获取整个页面内容请搜索我们以前的文章或继续浏览下面的相关文章希望大家以后多多支持我们!

相关推荐

-

python xpath获取页面注释的方法

版本信息: python 2.7.12 lxml 3.8.0 from lxml import etree html_str = """ <div id="box1">this from blog.csdn.net/lncxydjq , DO NOT COPY! <div id="box2">***** <!--can u get me, bitch?--> </div> </div

-

Python基于lxml模块解析html获取页面内所有叶子节点xpath路径功能示例

本文实例讲述了Python基于lxml模块解析html获取页面内所有叶子节点xpath路径功能.分享给大家供大家参考,具体如下: 因为需要使用叶子节点的路径来作为特征,但是原始的lxml模块解析之后得到的却是整个页面中所有节点的xpath路径,不是我们真正想要的形式,所以就要进行相关的处理才行了,差了很多网上的博客和文档也没有找到一个是关于输出html中全部叶子节点的API接口或者函数,也可能是自己没有那份耐心,没有找到合适的资源,只好放弃了寻找,但是这并不说明没有其他的方法了,在对页面全部节点

-

python 获取页面表格数据存放到csv中的方法

获取单独一个table,代码如下: #!/usr/bin/env python3 # _*_ coding=utf-8 _*_ import csv from urllib.request import urlopen from bs4 import BeautifulSoup from urllib.request import HTTPError try: html = urlopen("http://en.wikipedia.org/wiki/Comparison_of_text_edit

-

Python爬虫获取页面所有URL链接过程详解

如何获取一个页面内所有URL链接?在Python中可以使用urllib对网页进行爬取,然后利用Beautiful Soup对爬取的页面进行解析,提取出所有的URL. 什么是Beautiful Soup? Beautiful Soup提供一些简单的.python式的函数用来处理导航.搜索.修改分析树等功能.它是一个工具箱,通过解析文档为用户提供需要抓取的数据,因为简单,所以不需要多少代码就可以写出一个完整的应用程序. Beautiful Soup自动将输入文档转换为Unicode编码,输出文档转换

-

python3+selenium获取页面加载的所有静态资源文件链接操作

软件版本: python 3.7.2 selenium 3.141.0 pycharm 2018.3.5 具体实现流程如下,废话不多说,直接上代码: from selenium import webdriver from selenium.webdriver.chrome.options import Options from selenium.webdriver.common.desired_capabilities import DesiredCapabilities d = Desired

-

Python get获取页面cookie代码实例

在Python中通过GET来获取页面的COOKIE是非常简单的事情,下面的代码实例演示了如何利用Python 获取COOKIE内容 #! /usr/bin/env python #coding=utf-8 # -*-coding:utf-8 -*- #encoding=utf-8 import urllib import urllib2 import httplib cj='' header={'Host':'218.94.26.135', 'Accept-Language':'zh-CN',

-

python获取整个网页源码的方法

1.Python中获取整个页面的代码: import requests res = requests.get('https://blog.csdn.net/yirexiao/article/details/79092355') res.encoding = 'utf-8' print(res.text) 2.运行结果 实例扩展: from bs4 import BeautifulSoup import time,re,urllib2 t=time.time() websiteurls={} de

-

Python爬虫学习之获取指定网页源码

本文实例为大家分享了Python获取指定网页源码的具体代码,供大家参考,具体内容如下 1.任务简介 前段时间一直在学习Python基础知识,故未更新博客,近段时间学习了一些关于爬虫的知识,我会分为多篇博客对所学知识进行更新,今天分享的是获取指定网页源码的方法,只有将网页源码抓取下来才能从中提取我们需要的数据. 2.任务代码 Python获取指定网页源码的方法较为简单,我在Java中使用了38行代码才获取了网页源码(大概是学艺不精),而Python中只用了6行就达到了效果. Python中获取网页

-

易语言获取网页源码的方法

信息爆炸的时代,同样引领者软件产业的不断变化.目前,软件的需求已经不是从单一面向复杂,不单单考虑某一方面的需求而是多方面需求的融合.那么,易语言如何读取网页源码呢?下面,就由MovieClip给大家讲解一下吧! 1.首先,运行"易语言"主程序,弹出"新建工程对话框"选择"Windows窗口程序"然后点击"确定"按钮,进入"Windows窗口程序设计界面".如下图: 2.接下来,拖放标签组件一个.编辑框组件两

-

三种获取网页源码的方法(使用MFC/Socket实现)

第一个方法是使用MFC里面的 <afxinet.h> 复制代码 代码如下: CString GetHttpFileData(CString strUrl){ CInternetSession Session("Internet Explorer", 0); CHttpFile *pHttpFile = NULL; CString strData; CString strClip; pHttpFile = (CHttpFile*)Ses

-

Python无法用requests获取网页源码的解决方法

最近在抓取http://skell.sketchengine.eu网页时,发现用requests无法获得网页的全部内容,所以我就用selenium先模拟浏览器打开网页,再获取网页的源代码,通过BeautifulSoup解析后拿到网页中的例句,为了能让循环持续进行,我们在循环体中加了refresh(),这样当浏览器得到新网址时通过刷新再更新网页内容,注意为了更好地获取网页内容,设定刷新后停留2秒,这样可以降低抓不到网页内容的机率.为了减少被封的可能,我们还加入了Chrome,请看以下代码: fro

-

Python requests模块基础使用方法实例及高级应用(自动登陆,抓取网页源码)实例详解

1.Python requests模块说明 requests是使用Apache2 licensed 许可证的HTTP库. 用python编写. 比urllib2模块更简洁. Request支持HTTP连接保持和连接池,支持使用cookie保持会话,支持文件上传,支持自动响应内容的编码,支持国际化的URL和POST数据自动编码. 在python内置模块的基础上进行了高度的封装,从而使得python进行网络请求时,变得人性化,使用Requests可以轻而易举的完成浏览器可有的任何操作. 现代,国际化

-

asp.net 抓取网页源码三种实现方法

方法1 比较推荐 /// <summary> /// 用HttpWebRequest取得网页源码 /// 对于带BOM的网页很有效,不管是什么编码都能正确识别 /// </summary> /// <param name="url">网页地址" </param> /// <returns>返回网页源文件</returns> public static string GetHtmlSource2(strin

-

Python实现的下载网页源码功能示例

本文实例讲述了Python实现的下载网页源码功能.分享给大家供大家参考,具体如下: #!/usr/bin/python import httplib httpconn = httplib.HTTPConnection("www.baidu.com") httpconn.request("GET", "/index.html") resp = httpconn.getresponse() if resp.reason == "OK&quo

-

C#实现下载网页HTML源码的方法

本文实例讲述了C#实现下载网页HTML源码的方法.分享给大家供大家参考之用.具体方法如下: public static class DownLoad_HTML { private static int FailCount = 0; //记录下载失败的次数 public static string GetHtml(string url) //传入要下载的网址 { string str = string.Empty; try { System.Net.WebRequest request = Sys

-

python获取指定网页上所有超链接的方法

本文实例讲述了python获取指定网页上所有超链接的方法.分享给大家供大家参考.具体如下: 这段python代码通过urllib2抓取网页,然后通过简单的正则表达式分析网页上的全部url地址 import urllib2 import re #connect to a URL website = urllib2.urlopen(url) #read html code html = website.read() #use re.findall to get all the links links

随机推荐

- Java编程基础测试题分享

- JS操作Cookies包括(读取添加与删除)

- jquery实现移动端点击图片查看大图特效

- vue滚动轴插件better-scroll使用详解

- linux mount命令的用法详细解析

- iis 7.5 下站点日志开启以及默认位置设置方法

- java正则表达式简单应用

- php基于ob_start(ob_gzhandler)实现网页压缩功能的方法

- python实现FTP服务器服务的方法

- C#通过第三方组件生成二维码(QR Code)和条形码(Bar Code)

- Android学习教程之九宫格图片展示(13)

- 详细解读MySQL中COUNT函数的用法

- nodejs实现发出蜂鸣声音(系统报警声)的方法

- 利用asp.net实现生成不重复订单号

- 编写轻量ajax组件01-与webform平台上的各种实现方式比较

- 将字符串转换成gb2312或者utf-8编码的参数(js版)

- SQLServer中求两个字符串的交集

- php中http_build_query 的一个问题

- Maven 配置文件 生命周期 常用命令详解

- spring boot使用RabbitMQ实现topic 主题