完美解决因数据库一次查询数据量过大导致的内存溢出问题

刚开始接触项目的实习生,积累经验,欢迎交流

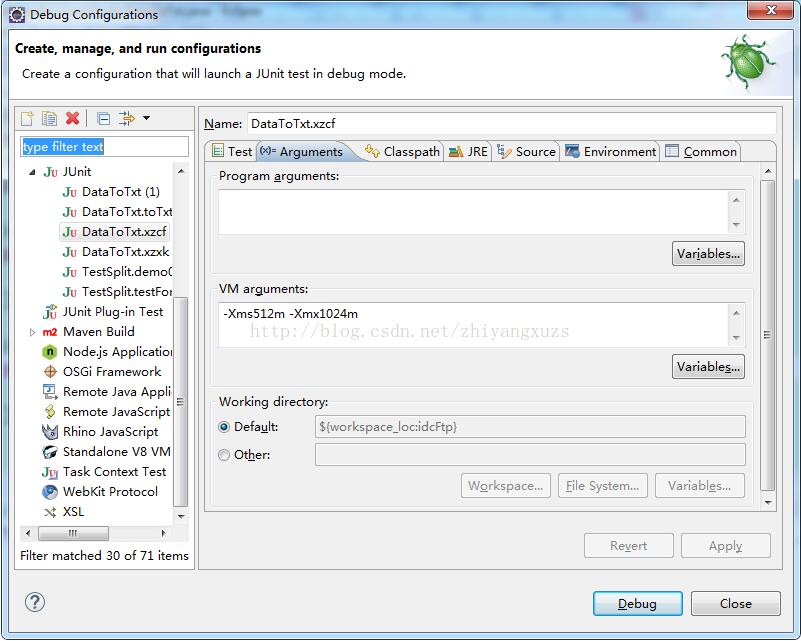

之前做项目,遇到过一次查询数据量过大而导致的内存溢出问题,找了很多办法一直未能实际解决问题,

今天又遇到了,经过前辈的指导,终于解决了问题!!

不过此方法只在DBug启动下有效

以上这篇完美解决因数据库一次查询数据量过大导致的内存溢出问题就是小编分享给大家的全部内容了,希望能给大家一个参考,也希望大家多多支持我们。

相关推荐

-

有关tomcat内存溢出的完美解决方法

tomcat内存溢出设置JAVA_OPTS 答案1 设置Tomcat启动的初始内存 其初始空间(即-Xms)是物理内存的1/64,最大空间(-Xmx)是物理内存的1/4.可以利用JVM提供的-Xmn -Xms -Xmx等选项可 进行设置 三.实例,以下给出1G内存环境下java jvm 的参数设置参考: JAVA_OPTS="-server -Xms800m -Xmx800m -XX:PermSize=64M -XX:MaxNewSize=256m -XX:MaxPermSize=128m -D

-

完美解决java读取大文件内存溢出的问题

1. 传统方式:在内存中读取文件内容 读取文件行的标准方式是在内存中读取,Guava 和Apache Commons IO都提供了如下所示快速读取文件行的方法: Files.readLines(new File(path), Charsets.UTF_8); FileUtils.readLines(new File(path)); 实际上是使用BufferedReader或者其子类LineNumberReader来读取的. 传统方式的问题: 是文件的所有行都被存放在内存中,当文件足够大时很快就会

-

完美解决因数据库一次查询数据量过大导致的内存溢出问题

刚开始接触项目的实习生,积累经验,欢迎交流 之前做项目,遇到过一次查询数据量过大而导致的内存溢出问题,找了很多办法一直未能实际解决问题, 今天又遇到了,经过前辈的指导,终于解决了问题!! 不过此方法只在DBug启动下有效 以上这篇完美解决因数据库一次查询数据量过大导致的内存溢出问题就是小编分享给大家的全部内容了,希望能给大家一个参考,也希望大家多多支持我们.

-

antd的select下拉框因为数据量太大造成卡顿的解决方式

相信用过antd的同学基本都用过select下拉框了,这个组件数据量少的时候很好用,但是当数据量大的时候,比如大几百条上千条甚至是几千条的时候就感觉一点都不好用了,卡的我怀疑人生,一点用户体验都没有了. 当然这不是我想去优化它的动力,主要是公司业务人员和后端的同事也无法忍受,于是我只能屈从于他们的淫威.... 想要优化肯定要知道为什么会卡,初步判断就是数据量过大导致渲染option组件的时间过长导致卡顿,于是想要不卡只能限制渲染的数据数量. 我的想法是这样的:任何时候都只渲染前100条数据以保证

-

完美解决Thinkphp3.2中插入相同数据的问题

问题描述 今天在使用TP3.2插入数据的时候,为了避免插入相同的数据(所谓相同的数据,其主键相同或者是唯一索引的字段相同),我创建的索引如下图,主键索引为自增字段,不可能出现重复,即唯一索引可能会出现重复,我希望的是uid,year,mounth,day 这三个字段出现相同的话,就更新当前记录. 问题解决办法 在之前面对这样的问题的时候,我们知道,MySQL提供了ON DUPLICATE KEY UPDATE或者REPLACE INTO来解决. 使用ON DUPLICATE KEY UPDATE

-

解决SpringBoot框架因post数据量过大没反应问题(踩坑)

此处网上最多的做法是需要修改tomcat的参数配置大致如下: <Connector port="8080" protocol="HTTP/1.1" connectionTimeout="2000" redirectPort="8443" URIEncoding="UTF-8" maxThreads="3000" compression="on" compress

-

解决Tensorflow sess.run导致的内存溢出问题

下面是调用模型进行批量测试的代码(出现溢出),开始以为导致溢出的原因是数据读入方式问题引起的,用了tf , PIL和cv等方式读入图片数据,发现越来越慢,内存占用飙升,调试时发现是sess.run这里出了问题(随着for循环进行速度越来越慢). # Creates graph from saved GraphDef create_graph(pb_path) # Init tf Session config = tf.ConfigProto() config.gpu_options.allow_

-

MySQL如何统计一个数据库所有表的数据量

目录 场景: 官网的解释: 补充:查询表大小 总结 场景: mysql统计一个数据库里所有表的数据量,最近在做统计想查找一个数据库里基本所有的表数据量,数据量少的通过select count再加起来也是可以的,不过表的数据有点多,不可能一个一个地查 记得在Navicat里,选择一个数据量,点击表,如图: 是可以看到所有表具体的数据行的 然后可以通过sql实现?在mysql里是可以查询information_schema.tables这张表的 SELECT table_rows,table_nam

-

PDO取Oracle lob大字段,当数据量太大无法取出的问题的解决办法

首先,创建一个存储过程 get_clob: t_name:要查询的表名:f_name:要查询的字段名:u_id:表的主键,查询条件:l_pos:截取的开始位置: l_amount :截取长度: CREATE OR REPLACE PROCEDURE get_clob(t_name in varchar2, f_name in varchar, u_id in integer, l_pos in integer, l_amount in BINARY_INTEGER, ReturnValue ou

-

解决docker数据文件过大导致根磁盘满的问题

背景: 最近在线上使用的docker主机发现根目录容量快满了,一番查找,发现是docker的data文件过大了. 我们知道docker数据默认是存放在/var/lib/docker下的,我们可以在启动时用-g --graph=""参数,把数据目录更改到其他容量大的地方去.但是对于在使用中的docker来说,直接修改这个目录路径,会导致镜像和容器都丢失了,所以修改参数这个方法适用于初始化docker的时候使用. 对于又想解决根分区容量满,又不想更改数据存储路径的我来说,我不想更改

-

window.location.href中url中数据量太大时的解决方法

先说一下今天遇到的问题 一个导出excel的处理,在按钮按下后需要传很大一个数据到后台,刚开始的做法如下: 复制代码 代码如下: var actionUrlSetData = "****Action!exportDatas.action"+ "?now=" + new Date().getTime();window.location.href= actionUrl + "&" + data; 上面的data就是一个很长的字符串. 这样在火

-

解决Mybatis 大数据量的批量insert问题

前言 通过Mybatis做7000+数据量的批量插入的时候报错了,error log如下: , ('G61010352', '610103199208291214', '学生52', 'G61010350', '610103199109920192', '学生50', '07', '01', '0104', ' ', , ' ', ' ', current_timestamp, current_timestamp ) 被中止,呼叫 getNextException 以取得原因. at org.p

随机推荐

- 利用NodeJS的子进程(child_process)调用系统命令的方法分享

- lib.utf.js

- 如何读取一个.ini文件?

- JSP隐含对象response实现文件下载的两种方法

- jQuery ajax分页插件实例代码

- 微信公众平台开发接口PHP SDK完整版

- 收藏了很久的CSS的十八般技巧

- PHP递归创建多级目录

- 推荐Sql server一些常见性能问题的解决方法

- 解决IE7不能自动完成表单的问题

- C#编程读取文档Doc、Docx及Pdf内容的方法

- java基于ConcurrentHashMap设计细粒度实现代码

- PHP生成可点击刷新的验证码简单示例

- 比较时间段一与时间段二是否有交集的php函数

- c#委托学习示例分享

- 详解pandas DataFrame的查询方法(loc,iloc,at,iat,ix的用法和区别)

- php微信分享到朋友圈、QQ、朋友、微博

- Flask框架实现给视图函数增加装饰器操作示例

- JavaWeb项目部署到服务器详细步骤详解

- Python如何爬取实时变化的WebSocket数据的方法