部署k8s集群的超详细实践步骤

目录

- 1、部署k8s的两种方式:

- 2、环境准备

- 3、初始化配置

- 3.1、安装环境准备:下面的操作需要在所有的节点上执行。

- 3.2、安装 Docker、kubeadm、kubelet【所有节点】

- 4、部署k8s-master【master执行】

- 4.1、kubeadm部署(需要等上一会)

- 4.2、拷贝k8s认证文件

- 5、配置k8s的node节点【node节点操作】

- 5.1、向集群添加新节点,执行在kubeadm init输出的kubeadm join命令

- 6、部署容器网络 (master执行)

- 7、部署Dashboard

- 总结

1、部署k8s的两种方式:

目前生产部署Kubernetes集群主要有两种方式:

- kubeadm

Kubeadm是一个K8s部署工具,提供kubeadm init和kubeadm join,用于快速部署Kubernetes集群。

- 二进制包

从github下载发行版的二进制包,手动部署每个组件,组成Kubernetes集群。

本实验采用kubeadm的方式搭建集群。

2、环境准备

服务器要求:

- 建议最小硬件配置:2核CPU、2G内存、20G硬盘

- 服务器最好可以访问外网,会有从网上拉取镜像需求,如果服务器不能上网,需要提前下载对应镜像并导入节点

软件环境:

- 操作系统:centos7.9_x64(mini)

- Docker:20-ce

- K8s:1.23

服务器规划:(本实验采用虚拟机)

- k8s-master:192.168.178.171

- k8s-node1:192.168.178.172

- k8s-node2:192.168.178.173

3、初始化配置

3.1、安装环境准备:下面的操作需要在所有的节点上执行。

# 关闭防火墙 systemctl stop firewalld systemctl disable firewalld # 关闭selinux sed -i 's/enforcing/disabled/' /etc/selinux/config # 永久 setenforce 0 # 临时 # 关闭swap swapoff -a # 临时 sed -ri 's/.*swap.*/#&/' /etc/fstab # 永久 # 根据规划设置主机名 hostnamectl set-hostname <hostname> # 在master添加hosts cat >> /etc/hosts << EOF 192.168.178.171 k8s-master 192.168.178.172 k8s-node1 192.168.178.173 k8s-node2 EOF # 将桥接的IPv4流量传递到iptables的链 cat > /etc/sysctl.d/k8s.conf << EOF net.bridge.bridge-nf-call-ip6tables = 1 net.bridge.bridge-nf-call-iptables = 1 EOF sysctl --system # 生效 # 时间同步 yum install ntpdate -y ntpdate time.windows.com 注意:虚拟机不管关机还是挂起,每次重新操作都需要更新时间进行同步。

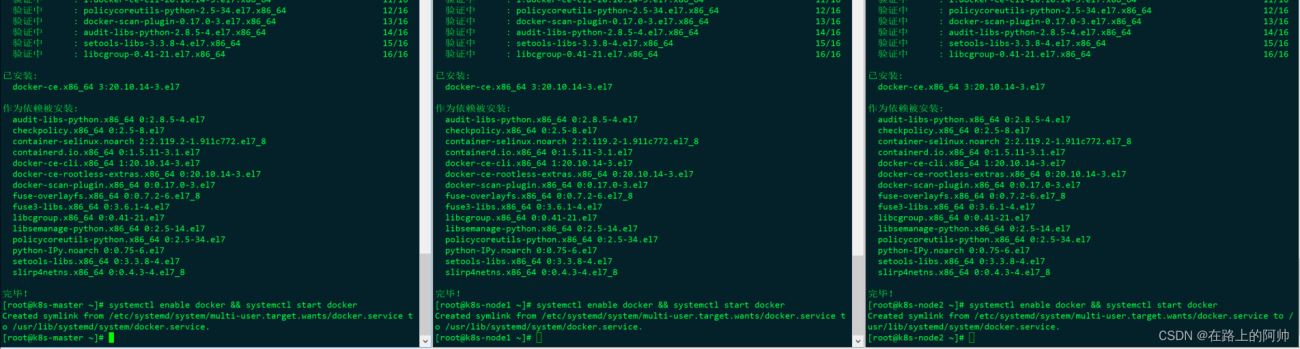

3.2、安装 Docker、kubeadm、kubelet【所有节点】

安装docker:

wget https://mirrors.aliyun.com/docker-ce/linux/centos/docker-ce.repo -O /etc/yum.repos.d/docker-ce.repo yum -y install docker-ce systemctl enable docker && systemctl start docker

配置镜像下载加速器:

vim /etc/docker/daemon.json

{

"registry-mirrors": ["https://b9pmyelo.mirror.aliyuncs.com"],

"exec-opts": ["native.cgroupdriver=systemd"]

}

systemctl restart docker

docker info #查看docker信息,进行确认

添加阿里云软件源:

cat > /etc/yum.repos.d/kubernetes.repo << EOF [kubernetes] name=Kubernetes baseurl=https://mirrors.aliyun.com/kubernetes/yum/repos/kubernetes-el7-x86_64 enabled=1 gpgcheck=0 repo_gpgcheck=0 gpgkey=https://mirrors.aliyun.com/kubernetes/yum/doc/yum-key.gpg https://mirrors.aliyun.com/kubernetes/yum/doc/rpm-package-key.gpg EOF

安装kubeadm、kubelet、kubectl:

yum install -y kubelet-1.23.0 kubeadm-1.23.0 kubectl-1.23.0 systemctl enable kubelet

4、部署k8s-master【master执行】

4.1、kubeadm部署(需要等上一会)

kubeadm init \ --apiserver-advertise-address=192.168.178.171 \ --image-repository registry.aliyuncs.com/google_containers \ --kubernetes-version v1.23.0 \ --service-cidr=10.96.0.0/12 \ --pod-network-cidr=10.244.0.0/16 \ --ignore-preflight-errors=all

- --apiserver-advertise-address 集群通告地址

- --image-repository 由于默认拉取镜像地址k8s.gcr.io国内无法访问,这里指定阿里云镜像仓库地址

- --kubernetes-version K8s版本,与上面安装的一致

- --service-cidr 集群内部虚拟网络,Pod统一访问入口

- --pod-network-cidr Pod网络,与下面部署的CNI网络组件yaml中保持一致

初始化之后,会输出一个join命令,先复制出来,node节点加入master会使用。

4.2、拷贝k8s认证文件

mkdir -p $HOME/.kube sudo cp -i /etc/kubernetes/admin.conf $HOME/.kube/config sudo chown $(id -u):$(id -g) $HOME/.kube/config

查看工作节点:

kubectl get nodes

注:由于网络插件还没有部署,还没有准备就绪 NotReady,继续操作。

5、配置k8s的node节点【node节点操作】

5.1、向集群添加新节点,执行在kubeadm init输出的kubeadm join命令

默认token有效期为24小时,当过期之后,该token就不可用了。这时就需要重新创建token,可以直接使用命令快捷生成:

kubeadm token create --print-join-command

6、部署容器网络 (master执行)

Calico是一个纯三层的数据中心网络方案,是目前Kubernetes主流的网络方案。

下载YAML:

wget https://docs.projectcalico.org/manifests/calico.yaml

下载完后还需要修改里面定义Pod网络(CALICO_IPV4POOL_CIDR),与前面kubeadm init的 --pod-network-cidr指定的一样。

修改完后文件后,进行部署:

kubectl apply -f calico.yaml kubectl get pods -n kube-system #执行结束要等上一会才全部running

等Calico Pod都Running后,节点也会准备就绪。

注:以后所有yaml文件都只在Master节点执行。

安装目录:/etc/kubernetes/

组件配置文件目录:/etc/kubernetes/manifests/

7、部署Dashboard

Dashboard是官方提供的一个UI,可用于基本管理K8s资源。

YAML下载地址:

wget https://raw.githubusercontent.com/kubernetes/dashboard/v2.4.0/aio/deploy/recommended.yaml

默认Dashboard只能集群内部访问,修改Service为NodePort类型,暴露到外部:

vi recommended.yaml

...

kind: Service

apiVersion: v1

metadata:

labels:

k8s-app: kubernetes-dashboard

name: kubernetes-dashboard

namespace: kubernetes-dashboard

spec:

ports:

- port: 443

targetPort: 8443

nodePort: 30001

selector:

k8s-app: kubernetes-dashboard

type: NodePort

...

kubectl apply -f recommended.yaml kubectl get pods -n kubernetes-dashboard

访问地址:https://NodeIP:30001

创建service account并绑定默认cluster-admin管理员集群角色:

# 创建用户

kubectl create serviceaccount dashboard-admin -n kube-system

# 用户授权

kubectl create clusterrolebinding dashboard-admin --clusterrole=cluster-admin --serviceaccount=kube-system:dashboard-admin

# 获取用户Token

kubectl describe secrets -n kube-system $(kubectl -n kube-system get secret | awk '/dashboard-admin/{print $1}')

使用输出的token登录Dashboard。

注:

以上为本人实际搭建过程中的经验总结

总结

到此这篇关于部署k8s集群的超详细实践的文章就介绍到这了,更多相关k8s集群搭建内容请搜索我们以前的文章或继续浏览下面的相关文章希望大家以后多多支持我们!