shell中的流编辑器awk工作原理

awk命令

- awk是一种处理文本文件的语言,是一个强大的文本分析工具, 用于在linux/unix下对文本和数据进行处理 。

- 而且它支持用户自定义函数和动态正则表达式等先进功能,是linux/unix下的一个强大编程工具

awk工作原理

逐行读取文本,默认以空格或tab键为分隔符进行分隔,将分隔所得的各个字段保存到内建变量中,并按模式或者条件执行编辑命令。

sed命令常用于一整行的处理,而awk比较倾向于将一行分成多个"字段"然后再进行处理。

awk信息的读入也是逐行读取的,执行结果可以通过print的功能将字段数据打印显示。在使用awk命令的过程中,可以使用逻辑操作符 "&&“表示"与”、 “II"表示"或”、 "!“表示"非”; 还可以进行简单的数学运算,如 +、一、*、/、%、^ 分别表示加、减、乘、除、取余和乘方。

awk的命令格式

awk 选项 "模式或条件 [操作]" 文件1 文件2 awk -f 脚本文件 文件1 文件2

awk常见的内建变量(可直接使用)

| 内建变量 | 说明 |

|---|---|

| FS | 列分割符,制定和每行文本的字段分割符,默认为空格或者制表符 |

| NF | 当前处理的行的字段个数 |

| NR | 当前处理行的行号(序数) |

| $0 | 当前处理行的整行内容 |

| $n | 当前处理行的第n个字段(第n列) |

| FILENAME | 被处理的文件名 |

| RS | 行分隔符,awk从文本上读取资料时,将根据RS的定义把资料切割成许多条记录,而awk一次仅读入一条,以进行处理,预设值是\n |

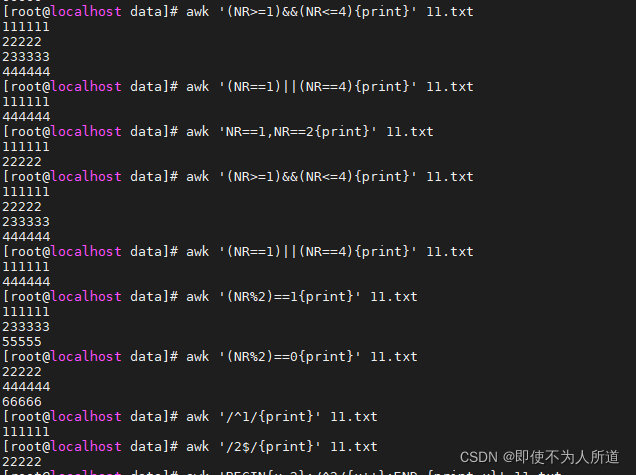

awk按行输出文本

awk '(NR>=1)&&(NR<=4){print}' 11.txt#输出第一到第四行

111111

22222

233333

444444

awk '(NR==1)||(NR==4){print}' 11.txt#输出第一和第四行

111111

444444

awk 'NR==1,NR==2{print}' 11.txt#输出第一和第二行

111111

22222

awk '(NR%2)==1{print}' 11.txt#输出奇数行

111111

233333

55555

awk '(NR%2)==0{print}' 11.txt#输出偶数行

22222

444444

66666

awk '/^1/{print}' 11.txt#输出以1为开头的行

111111

awk '/2$/{print}' 11.txt#输出以2为结尾的行

22222

awk 'BEGIN{x=0};/^2/{x++};END {print x}' 11.txt

#统计以2开头的行的行数

2

BEGIN模式表示,在处理指定文本之前,需要先执行BEGIN模式中指定的动作,awk再处理指定的文本,之后再执行END模式中指定的动作,END{}语句块中,往往会放入打印结果等语句。

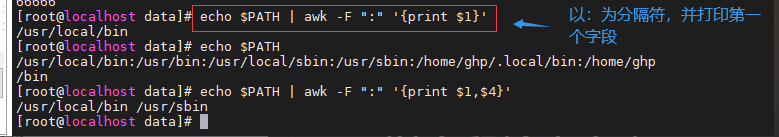

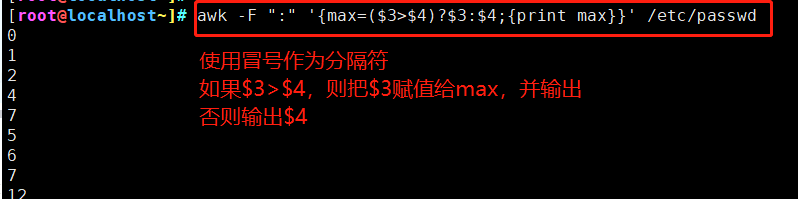

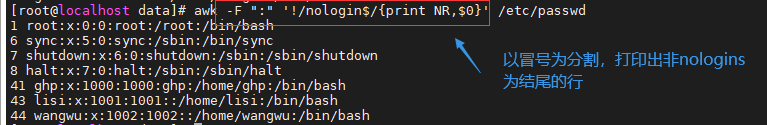

awk以字段输出文本

字段3为用户账号的UID

字段4为所属基本组账号的GID

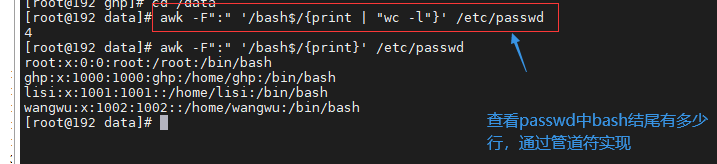

awk通过管道符,双引号调用shell命令

getline

- 当getline左右无重定向符“<”或“|”时,getline作用于当前文件,读入当前文件的第一行给其后跟的变量var或$0;应该注意到,由于awk在处理getline之前已经读入了一行,所以getline得到的返回结果是隔行的。

- 当getline左右有重定向符“<”或“|”时,getline则作用于定向输入文件,由于该文件是刚打开,并没有被awk读入一行,只是getline读入,那么getline返回的是该文件的第一行,而不是隔行。

例:获取本机ip,并转换成二进制

#!/bin/bash

#获取IP

ifconfig | awk '(NR==2) {print $2}'

#对分段后的IP地址赋值给一个变量

IP=`ifconfig |awk '(NR==2) {print $2}' | awk 'BEGIN {RS="."} ; {print} '`

#进行外层循环,四次

for a in $IP

do

#进行内循环,选用减法进行循环,如果外层循环的值比被减数大,则取余数,并输出1;反之则输出0,且不取减法结果。

for ((i=1;i<=255;i+=$i))

do

m=$[128/$i]

sum=$[$a-$m]

if [ $a -ge $m ]

then

a=$[$a-$m]

echo -n "1" #不换行输出

else

echo -n "0" #不换行输出

fi

done

echo " " #进行系统默认的空格换行操作

done > test.txt

IP1="`cat test.txt`"

echo $IP1 | sed 's/ /./g'

到此这篇关于shell中的流编辑器awk的文章就介绍到这了,更多相关shell编辑器awk内容请搜索我们以前的文章或继续浏览下面的相关文章希望大家以后多多支持我们!

赞 (0)