超简单的scrapy实现ip动态代理与更换ip的方法实现

简单实现ip代理,为了不卖广告,

请自行准备一个ip代理的平台

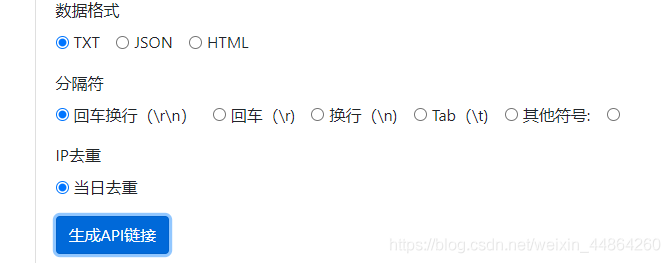

例如我用的这个平台,每次提取10个ip

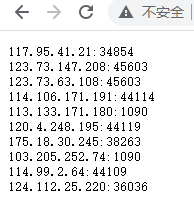

从上面可以看到数据格式是文本,换行是\r\n,访问链接之后大概就是长这样的,scrapy里面的ip需要加上前缀http://

例如:http://117.95.41.21:34854

OK,那现在已经准备好了ip了,先给你们屡一下思路。

ip池和计数器放在setting文件

第一次请求的时候要填满ip池,所以在爬虫文件的start_requests函数下手

更换ip的地方是middlewares的下载器中间件类的process_request函数,因为每个请求发起前都会经过这个函数

首先是setting文件,其实就是加两句代码

count = {'count': 0}

ipPool = []

还有就是开启下载器中间件,注意是下面那个download的类,中间件的process_request函数的时候才能生效

下载器中间件的process_request函数,进行ip代理和固定次数更还ip代理池

# 记得导包

from 你的项目.settings import ipPool, count

import random

import requests

def process_request(self, request, spider):

# 随机选中一个ip

ip = random.choice(ipPool)

print('当前ip', ip, '-----', count['count'])

# 更换request的ip----------这句是重点

request.meta['proxy'] = ip

# 如果循环大于某个值,就清理ip池,更换ip的内容

if count['count'] > 50:

print('-------------切换ip------------------')

count['count'] = 0

ipPool.clear()

ips = requests.get('你的ip获取的地址')

for ip in ips.text.split('\r\n'):

ipPool.append('http://' + ip)

# 每次访问,计数器+1

count['count'] += 1

return None

最后就是爬虫文件的start_requests函数,就是第一次发请求前要先填满ip池的ip

# 记得导包

from 你的项目.settings import ipPool

import random

import requests

def start_requests(self):

# 第一次请求发起前先填充一下ip池

ips = requests.get('你的ip获取的地址')

for ip in ips.text.split('\r\n'):

ipPool.append('http://' + ip)

简单的ip代理以及固定次数就更换ip池就完成了

到此这篇关于超简单的scrapy实现ip动态代理与更换ip的方法实现的文章就介绍到这了,更多相关scrapy ip动态代理与更换ip内容请搜索我们以前的文章或继续浏览下面的相关文章希望大家以后多多支持我们!

相关推荐

-

使用scrapy ImagesPipeline爬取图片资源的示例代码

这是一个使用scrapy的ImagesPipeline爬取下载图片的示例,生成的图片保存在爬虫的full文件夹里. scrapy startproject DoubanImgs cd DoubanImgs scrapy genspider download_douban douban.com vim spiders/download_douban.py # coding=utf-8 from scrapy.spiders import Spider import re from scrapy

-

scrapy自定义pipeline类实现将采集数据保存到mongodb的方法

本文实例讲述了scrapy自定义pipeline类实现将采集数据保存到mongodb的方法.分享给大家供大家参考.具体如下: # Standard Python library imports # 3rd party modules import pymongo from scrapy import log from scrapy.conf import settings from scrapy.exceptions import DropItem class MongoDBPipeline(o

-

详解基于Scrapy的IP代理池搭建

一.为什么要搭建爬虫代理池 在众多的网站防爬措施中,有一种是根据ip的访问频率进行限制,即在某一时间段内,当某个ip的访问次数达到一定的阀值时,该ip就会被拉黑.在一段时间内禁止访问. 应对的方法有两种: 1. 降低爬虫的爬取频率,避免IP被限制访问,缺点显而易见:会大大降低爬取的效率. 2. 搭建一个IP代理池,使用不同的IP轮流进行爬取. 二.搭建思路 1.从代理网站(如:西刺代理.快代理.云代理.无忧代理)爬取代理IP: 2.验证代理IP的可用性(使用代理IP去请求指定URL,根据响应验证

-

python3 Scrapy爬虫框架ip代理配置的方法

什么是Scrapy? Scrapy是一个为了爬取网站数据,提取结构性数据而编写的应用框架,非常出名,非常强悍.所谓的框架就是一个已经被集成了各种功能(高性能异步下载,队列,分布式,解析,持久化等)的具有很强通用性的项目模板.对于框架的学习,重点是要学习其框架的特性.各个功能的用法即可. 一.背景 在做爬虫项目的过程中遇到ip代理的问题,网上搜了一些,要么是用阿里云的ip代理,要么是搜一些网上现有的ip资源,然后配置在setting文件中.这两个方法都存在一些问题. 1.阿里云ip代理方法,网上大

-

Scrapy 配置动态代理IP的实现

应用 Scrapy框架 ,配置动态IP处理反爬. # settings 配置中间件 DOWNLOADER_MIDDLEWARES = { 'text.middlewares.TextDownloaderMiddleware': 543, # 'text.middlewares.RandomUserAgentMiddleware': 544, # 'text.middlewares.CheckUserAgentMiddleware': 545, 'text.middlewares.ProxyMid

-

Python:Scrapy框架中Item Pipeline组件使用详解

Item Pipeline简介 Item管道的主要责任是负责处理有蜘蛛从网页中抽取的Item,他的主要任务是清晰.验证和存储数据. 当页面被蜘蛛解析后,将被发送到Item管道,并经过几个特定的次序处理数据. 每个Item管道的组件都是有一个简单的方法组成的Python类. 他们获取了Item并执行他们的方法,同时他们还需要确定的是是否需要在Item管道中继续执行下一步或是直接丢弃掉不处理. Item管道通常执行的过程有 清理HTML数据 验证解析到的数据(检查Item是否包含必要的字段) 检查是

-

超简单的scrapy实现ip动态代理与更换ip的方法实现

简单实现ip代理,为了不卖广告, 请自行准备一个ip代理的平台 例如我用的这个平台,每次提取10个ip 从上面可以看到数据格式是文本,换行是\r\n,访问链接之后大概就是长这样的,scrapy里面的ip需要加上前缀http:// 例如:http://117.95.41.21:34854 OK,那现在已经准备好了ip了,先给你们屡一下思路. ip池和计数器放在setting文件 第一次请求的时候要填满ip池,所以在爬虫文件的start_requests函数下手 更换ip的地方是middleware

-

python爬虫利用代理池更换IP的方法步骤

0. 前言 周日在爬一个国外网站的时候,发现用协程并发请求,并且请求次数太快的时候,会出现对方把我的服务器IP封掉的情况.于是网上找了一下开源的python代理池,这里选择的是star数比较多的proxy_pool 1. 安装环境 # 安装python虚拟环境, python环境最好为python3.6,再往上的话,安装依赖时会报错 sudo apt update sudo apt install python3.6 pip3 install virtualenv virtualenv venv

-

深入讲解基于JDK的动态代理机制

前言 『动态代理』其实源于设计模式中的代理模式,而代理模式就是使用代理对象完成用户请求,屏蔽用户对真实对象的访问. 举个最简单的例子,比如我们想要「FQ」访问国外网站,因为我们并没有墙掉所有国外的 IP,所以你可以将你的请求数据报发送到那些没有被屏蔽的国外主机上,然后你通过配置国外主机将请求转发到目的地并在得到响应报文后转发回我们国内主机上. 这个例子中,国外主机就是一个代理对象,而那些被墙掉的主机就是真实对象,我们不能直接访问到真实对象,但可以通过一个代理间接的访问到. 代理模式的一个好处就是

-

java 代理模式及动态代理机制深入分析

java 代理模式及动态代理机制深入分析 代理设计模式 代理是一种常用的设计模式,其目的就是为其他对象提供一个代理以控制对某个对象的访问.代理类负责为委托类预处理消息,过滤消息并转发消息,以及进行消息被委托类执行后的后续处理. 代理模式的作用是:为其他对象提供一种代理以控制对这个对象的访问.在某些情况下,一个客户不想或者不能直接引用另一个对象,而代理对象可以在客户端和目标对象之间起到中介的作用. 代理模式一般涉及到的角色有: 抽象角色:声明真实对象和代理对象的共同接口: 代理角色:代理对象角色内

-

详解Java动态代理的实现机制

一.概述 代理是一种设计模式,其目的是为其他对象提供一个代理以控制对某个对象的访问,代理类负责为委托类预处理消息,过滤消息并转发消息以及进行消息被委托类执行后的后续处理.为了保持行为的一致性,代理类和委托类通常会实现相同的接口. 按照代理的创建时期,代理类可分为两种: 静态代理:由程序员创建代理类或特定工具自动生成源代码再对其编译,也就是说在程序运行前代理类的.class文件就已经存在. 动态代理:在程序运行时运用反射机制动态创建生成. 下面在将动态代理的实现机制之前先简单介绍一下静态代理. 二

-

Spring CGLlB动态代理实现过程解析

JDK 动态代理使用起来非常简单,但是它也有一定的局限性,这是因为 JDK 动态代理必须要实现一个或多个接口,如果不希望实现接口,则可以使用 CGLIB 代理. CGLIB(Code Generation Library)是一个高性能开源的代码生成包,它被许多 AOP 框架所使用,其底层是通过使用一个小而快的字节码处理框架 ASM(Java 字节码操控框架)转换字节码并生成新的类.因此 CGLIB 要依赖于 ASM 的包,解压 Spring 的核心包 spring-core-3.2.2.RELE

-

详解Java中的反射机制和动态代理

一.反射概述 反射机制指的是Java在运行时候有一种自观的能力,能够了解自身的情况为下一步做准备,其想表达的意思就是:在运行状态中,对于任意一个类,都能够获取到这个类的所有属性和方法:对于任意一个对象,都能够调用它的任意一个方法和属性(包括私有的方法和属性),这种动态获取的信息以及动态调用对象的方法的功能就称为java语言的反射机制.通俗点讲,通过反射,该类对我们来说是完全透明的,想要获取任何东西都可以,这是一种动态获取类的信息以及动态调用对象方法的能力. 想要使用反射机制,就必须要先获取到该类

-

Java动态代理四种实现方式详解

代理模式也是一种非常常见的设计模式.了解Spring框架的都知道,Spring AOP 使用的就是动态代理模式.今天就来系统的重温一遍代理模式. 在现实生活中代理是随处可见的,当事人因某些隐私不方便出面,或者当事人不具备某些相关的专业技能,而需要一个职业人员来完成一些专业的操作, 也可能由于当事人没有时间处理事务,而聘用代理人出面.而在软件设计中,使用代理模式的地方也很多,由于安全原因,屏蔽客户端直接访问真实对象, 或者为了提升系统性能,使用代理模式实现延迟加载,还有就是AOP,对委托类的功能进

-

Java JDK动态代理(AOP)的实现原理与使用详析

本文主要给大家介绍了关于Java JDK动态代理(AOP)实现原理与使用的相关内容,分享出来供大家参考学习,下面来一起看看详细的介绍: 一.什么是代理? 代理是一种常用的设计模式,其目的就是为其他对象提供一个代理以控制对某个对象的访问.代理类负责为委托类预处理消息,过滤消息并转发消息,以及进行消息被委托类执行后的后续处理. 代理模式UML图: 简单结构示意图: 为了保持行为的一致性,代理类和委托类通常会实现相同的接口,所以在访问者看来两者没有丝毫的区别.通过代理类这中间一层,能有效控制对委托类对

随机推荐

- Python的迭代器和生成器

- Golang学习笔记(四):array、slice、map

- DB2编程序技巧 (一)

- MongoDB运行状态监控、性能分析工具mongostat详解

- Android编程使WebView支持HTML5 Video全屏播放的解决方法

- 多站点IIS用户安全权限设置图解教程

- 再论局域网互访故障问题的解决方法图文教程

- 值得收藏的正则表达式大全

- java 实现 stack详解及实例代码

- JS随机打乱数组的方法小结

- asp.net利用google的api做翻译

- Python的collections模块中的OrderedDict有序字典

- Android贝塞尔曲线初步学习第二课 仿QQ未读消息气泡拖拽黏连效果

- jQuery制作网页版选项卡

- 常用原生js自定义函数总结

- windows下通过批处理快速批量更换IP方法

- javascript-TreeView父子联动效果保持节点状态一致

- 详解CentOS7.0安装与配置Tomcat-7

- “不能执行已释放的Script代码”错误的原因及解决办法

- C++实现高性能转换大小写算法示例