Python爬取新型冠状病毒“谣言”新闻进行数据分析

一、爬取数据

话不多说了,直接上代码( copy即可用 )

import requests

import pandas as pd

class SpiderRumor(object):

def __init__(self):

self.url = "https://vp.fact.qq.com/loadmore?artnum=0&page=%s"

self.header = {

"User-Agent": "Mozilla/5.0 (iPhone; CPU iPhone OS 11_0 like Mac OS X) AppleWebKit/604.1.38 (KHTML, like Gecko) Version/11.0 Mobile/15A372 Safari/604.1",

}

def spider_run(self):

df_all = list()

for url in [self.url % i for i in range(30)]:

data_list = requests.get(url, headers=self.header).json()["content"]

temp_data = [[df["title"], df["date"], df["result"], df["explain"], df["tag"]] for df in data_list]

df_all.extend(temp_data)

print(temp_data[0])

pd.DataFrame(df_all, columns=["title", "date", "result", "explain", "tag"]).to_csv("冠状病毒谣言数据.csv", encoding="utf_8_sig")

if __name__ == '__main__':

spider = SpiderRumor()

spider.spider_run()

爬虫过程

二、数据分析

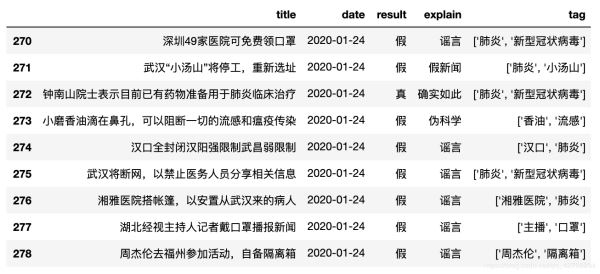

数据展示

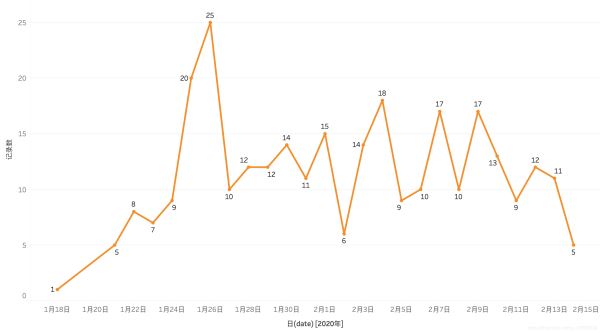

每日谣言数量

由图可得:1月24日和1月25日是谣言的高峰期,让我们来看看这两天的数据:

由上图得知 一月二十四号和二十号传播的 29 条谣言中 96.55% 都是假的

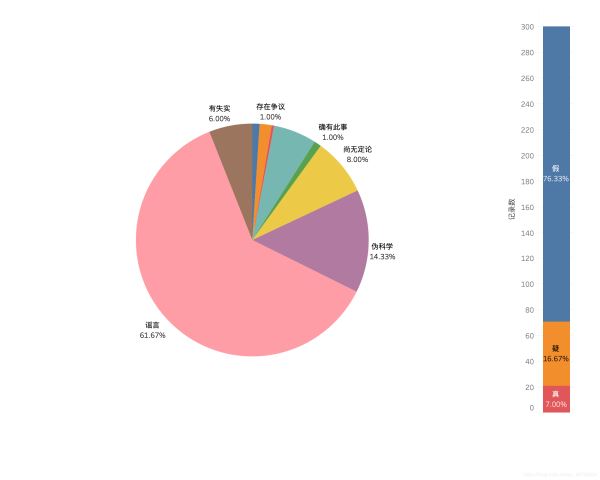

谣言是否属实占比

从1月18日到今日截止2月14日共发现了300条谣言,右上图可得:76.33% 都是假的,只要 7.00% 是属实的,其中 14.33% 的谣言属于 伪科学 而且 还有 8.00% 属于尚无定论凭空捏造出的,需要多注意⚠️

谣言的关键字展示

下面介绍 matplotlib 绘制饼图的代码

import numpy as np

import pandas as pd

import matplotlib.pyplot as plt

# Windows系统设置中文字体

plt.rcParams['font.sans-serif']=['SimHei']

plt.rcParams['axes.unicode_minus'] = False

data = pd.read_csv("/冠状病毒谣言数据.csv"")

labels = data["explain"].value_counts().index.tolist()

sizes = data["explain"].value_counts().values.tolist()

colors = ['lightgreen', 'gold', 'lightskyblue', 'lightcoral']

plt.figure(figsize=(15,8))

plt.pie(sizes, labels=labels,

colors=colors, autopct='%1.1f%%', shadow=True, startangle=50) # shadow=True 表示阴影

plt.axis('equal') # 使图居中

plt.show()

绘制谣言关键字分布图(观察 tag 这个字段)

由于 tag 这个字段内容是列表,我们取出来后是列表嵌套列表:[[a, b], [b, c], [c, d]] 我们要使用一行列表生成式快速的将所以的关键字取出来 [j for i in a for j in i]

import numpy as np

import pandas as pd

import matplotlib.pyplot as plt

# Windows系统设置中文字体

plt.rcParams['font.sans-serif']=['SimHei']

plt.rcParams['axes.unicode_minus'] = False

data = pd.read_csv("/冠状病毒谣言数据.csv"")

df = pd.Series([j for i in [eval(i) for i in data["tag"].tolist()] for j in i]).value_counts()[:20]

X = df.index.tolist()

y = df.values.tolist()

plt.figure(figsize=(15, 8)) # 设置画布

plt.bar(X, y, color="orange")

plt.tight_layout()

# plt.grid(axis="y")

plt.grid(ls='-.')

plt.show()

总结

以上所述是小编给大家介绍的Python爬取新型冠状病毒“谣言”新闻进行数据分析,希望对大家有所帮助!

赞 (0)