python3爬虫怎样构建请求header

写一个爬虫首先就是学会设置请求头header,这样才可以伪装成浏览器。下面小编我就来给大家简单分析一下python3怎样构建一个爬虫的请求头header。

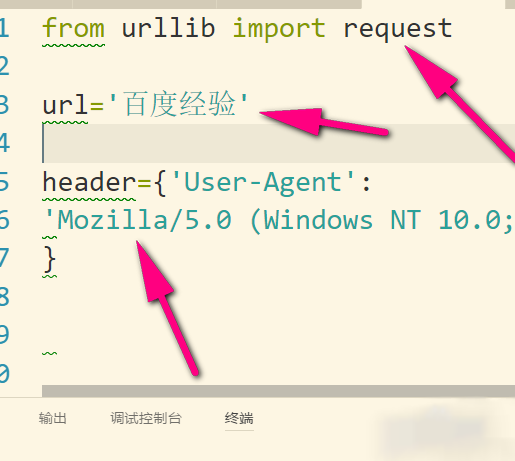

1、python3跟2有了细微差别,所以我们先要引入request,python2没有这个request哦。然后复制网址给url,然后用一个字典来保存header,这个header怎么来的?看第2步。

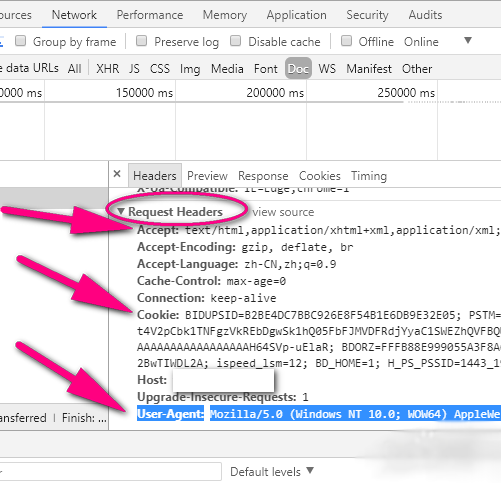

2、打开任意浏览器某一页面(要联网),按f12,然后点network,之后再按f5,然后就会看到“name”这里,我们点击name里面的任意文件即可。

3、之后右边有一个headers,点击headers找到request headers,这个就是浏览器的请求报头了。

4、然后复制其中的user-agent,其他的cookie还有Accept可以要也可以不要,主要是伪装成浏览器,所以我就用了user-agent

5、接着再用Request方法把url和headers组合在一起就可以构造一个比较简单的请求了。Request有三个参数(url,data,headers),如果有使用data就是post请求了,没有就是get请求。这里我没有data,所以我就指定headers=header,不然header就会被当成data了。

6、请求对象rq就构造好了,然后用urlopen发送这个请求对象就可以了。这就是简单的请求头设置了。

总结:以上就是关于python3爬虫怎样构建请求头的相关知识点,感谢大家的阅读和对我们的支持。

相关推荐

-

python爬虫获取百度首页内容教学

由传智播客教程整理,我们这里使用的是python2.7.x版本,就是2.7之后的版本,因为python3的改动略大,我们这里不用它.现在我们尝试一下url和网络爬虫配合的关系,爬浏览器首页信息. 1.首先我们创建一个urllib2_test01.py,然后输入以下代码: 2.最简单的获取一个url的信息代码居然只需要4行,执行写的python代码: 3.之后我们会看到一下的结果 4. 实际上,如果我们在浏览器上打开网页主页的话,右键选择"查看源代码",你会发现,跟我们刚打印出来的是一模

-

Python数据抓取爬虫代理防封IP方法

爬虫:一段自动抓取互联网信息的程序,从互联网上抓取对于我们有价值的信息,一般来说,Python爬虫程序很多时候都要使用(飞猪IP)代理的IP地址来爬取程序,但是默认的urlopen是无法使用代理的IP的,我就来分享一下Python爬虫怎样使用代理IP的经验.(推荐飞猪代理IP注册可免费使用,浏览器搜索可找到) 1.划重点,小编我用的是Python3哦,所以要导入urllib的request,然后我们调用ProxyHandler,它可以接收代理IP的参数.代理可以根据自己需要选择,当然免费的也是有

-

Python3爬虫全国地址信息

PHP方式写的一团糟所以就用python3重写了一遍,所以因为第二次写了,思路也更清晰了些. 提醒:可能会有502的错误,所以做了异常以及数据库事务处理,暂时没有想到更好的优化方法,所以就先这样吧.待更懂python再进一步优化哈 欢迎留言赐教~ #!C:\Users\12550\AppData\Local\Programs\Python\Python37\python.exe # -*- coding: utf-8 -*- from urllib.request import urlopen

-

Python反爬虫技术之防止IP地址被封杀的讲解

在使用爬虫爬取别的网站的数据的时候,如果爬取频次过快,或者因为一些别的原因,被对方网站识别出爬虫后,自己的IP地址就面临着被封杀的风险.一旦IP被封杀,那么爬虫就再也爬取不到数据了. 那么常见的更改爬虫IP的方法有哪些呢? 1,使用动态IP拨号器服务器. 动态IP拨号服务器的IP地址是可以动态修改的.其实动态IP拨号服务器并不是什么高大上的服务器,相反,属于配置很低的一种服务器.我们之所以使用动态IP拨号服务器,不是看中了它的计算能力,而是能够实现秒换IP. 动态IP拨号服务器有一个特点,就是每

-

python3.4爬虫demo

python 3.4 所写爬虫 仅仅是个demo,以百度图片首页图片为例.能跑出图片上的图片: 使用 eclipse pydev 编写: from SpiderSimple.HtmLHelper import * import imp import sys imp.reload(sys) #sys.setdefaultencoding('utf-8') html = getHtml('http://image.baidu.com/') try: getImage(html) exit() exc

-

python爬虫获取小区经纬度以及结构化地址

本文实例为大家分享了python爬虫获取小区经纬度.地址的具体代码,供大家参考,具体内容如下 通过小区名称利用百度api可以获取小区的地址以及经纬度,但是由于api返回的值中的地址形式不同,所以可以首先利用小区名称进行一轮爬虫,获取小区的经纬度,然后再利用经纬度Reverse到小区的结构化的地址.另外小区名称如果是'...号',可以在爬虫开始之前在'号'之后加一个'院',得到的精确度更高.这次写到程序更加便于二次利用,只需要给程序传递一个dataframe就可以坐等结果了.现在程序已经写好了,就

-

Python爬虫文件下载图文教程

而今天我们要说的内容是:如果在网页中存在文件资源,如:图片,电影,文档等.怎样通过Python爬虫把这些资源下载下来. 1.怎样在网上找资源: 就是百度图片为例,当你如下图在百度图片里搜索一个主题时,会为你跳出一大堆相关的图片. 还有如果你想学英语,找到一个网站有很多mp3的听力资源,这些可能都是你想获取的内容. 现在是一个互联网的时代,只要你去找,基本上能找到你想要的任何资源. 2.怎样识别网页中的资源: 以上面搜索到的百度图片为例.找到了这么多的内容,当然你可以通过手动一张张的去保存,但这样

-

python爬虫获取新浪新闻教学

一提到python,大家经常会提到爬虫,爬虫近来兴起的原因我觉得主要还是因为大数据的原因,大数据导致了我们的数据不在只存在于自己的服务器,而python语言的简便也成了爬虫工具的首要语言,我们这篇文章来讲下爬虫,爬取新浪新闻 1. 大家知道,爬虫实际上就是模拟浏览器请求,然后把请求到的数据,经过我们的分析,提取出我们想要的内容,这也就是爬虫的实现 大家知道,爬虫实际上就是模拟浏览器请求,然后把请求到的数据,经过我们的分析,提取出我们想要的内容,这也就是爬虫的实现 2.首先,我们要写爬虫,可以借鉴

-

python构建基础的爬虫教学

爬虫具有域名切换.信息收集以及信息存储功能. 这里讲述如何构建基础的爬虫架构. 1. urllib库:包含从网络请求数据.处理cookie.改变请求头和用户处理元数据的函数.是python标准库.urlopen用于打开读取一个从网络获取的远程对象.能轻松读取HTML文件.图像文件及其他文件流. 2. beautifulsoup库:通过定位HTML标签格式化和组织复杂的网络信息,用python对象展现XML结构信息.不是标准库,可用pip安装.常用的对象是BeautifulSoup对象. 1.基础

-

python爬虫超时的处理的实例

如下所示: #coding:utf-8 ''''' Created on 2014-7-24 @author: Administrator ''' import urllib2 try: url = "http://www.baidu.com" f = urllib2.urlopen(url, timeout=0) #timeout设置超时的时间 result = f.read() # print len(result) print result except Exception,e:

随机推荐

- event.srcElement 用法笔记e.target

- ASP Json Parser修正版

- Powershell实现捕获系统内置EXE程序的异常

- Windows Server 2008 R2 下配置证书服务器和HTTPS的图文教程

- c#裁剪图片后使用zxing生成二维码示例分享

- iOS App之间的通信 local socket

- JS 在数组指定位置插入/删除数据的方法

- JavaScript 读取图片实例代码

- PHP-Java-Bridge使用笔记

- Android实现淘宝选中商品尺寸的按钮组实例

- Android中使用Spinner实现下拉列表功能

- 百度 popup.js 完美修正版非常的不错 脚本之家推荐

- linux系统中使用openssl实现mysql主从复制

- php采用session实现防止页面重复刷新

- 详解vue.js之绑定class和style的示例代码

- 反向Ajax 30分钟快速掌握

- js中数组排序sort方法的原理分析

- MongoDB学习之Text Search文本搜索功能

- Mysql安装与配置调优及修改root密码的方法

- Android实现沉浸式状态栏