Portia开源可视化爬虫工具的使用学习

目录

- 背景

- 安装

- 使用Portia包

- page sample

- 启动程序

- 总结

背景

由于最近在写一个可供配置的爬虫模板,方便快速扩展新的抓取业务,并且最后目标是将其做成一个可视化的配置服务。还正在进行中,并且有点没有头绪,所以想参考网上现有的轮子,看看能不能找到点新的思路。

安装

Docker安装完成后拉去portia服务项目

# < ..FOLDER> 路径自定义即可 , 可在后面加上portia的版本 docker run -i -t --rm -v <PROJECTS_FOLDER>:/app/data/projects:rw -p 9001:9001 scrapinghub/portia # git上是如下语句 docker run -v ~/portia_projects:/app/data/projects:rw -p 9001:9001 scrapinghub/portia

具体可参考官方文档

使用Portia包

新建project

Portia安装完成以后使用浏览器打开http://localhost:9001, 在create a new project 中输入项目名

点击 New spider 创建一个新的spider

右边侧栏会提示你输入一个url,Portia会将网页的url作为一个start page。

这个start page一般被用来当做seek(种子),用来获得更多的链接。

Portia支持创建 page sample(页面样本),当你创建了一个页面样本,就可以调度后面的任务按照你设定的模板抓取元素。(所以我们需要先创建这样的模板)

page sample

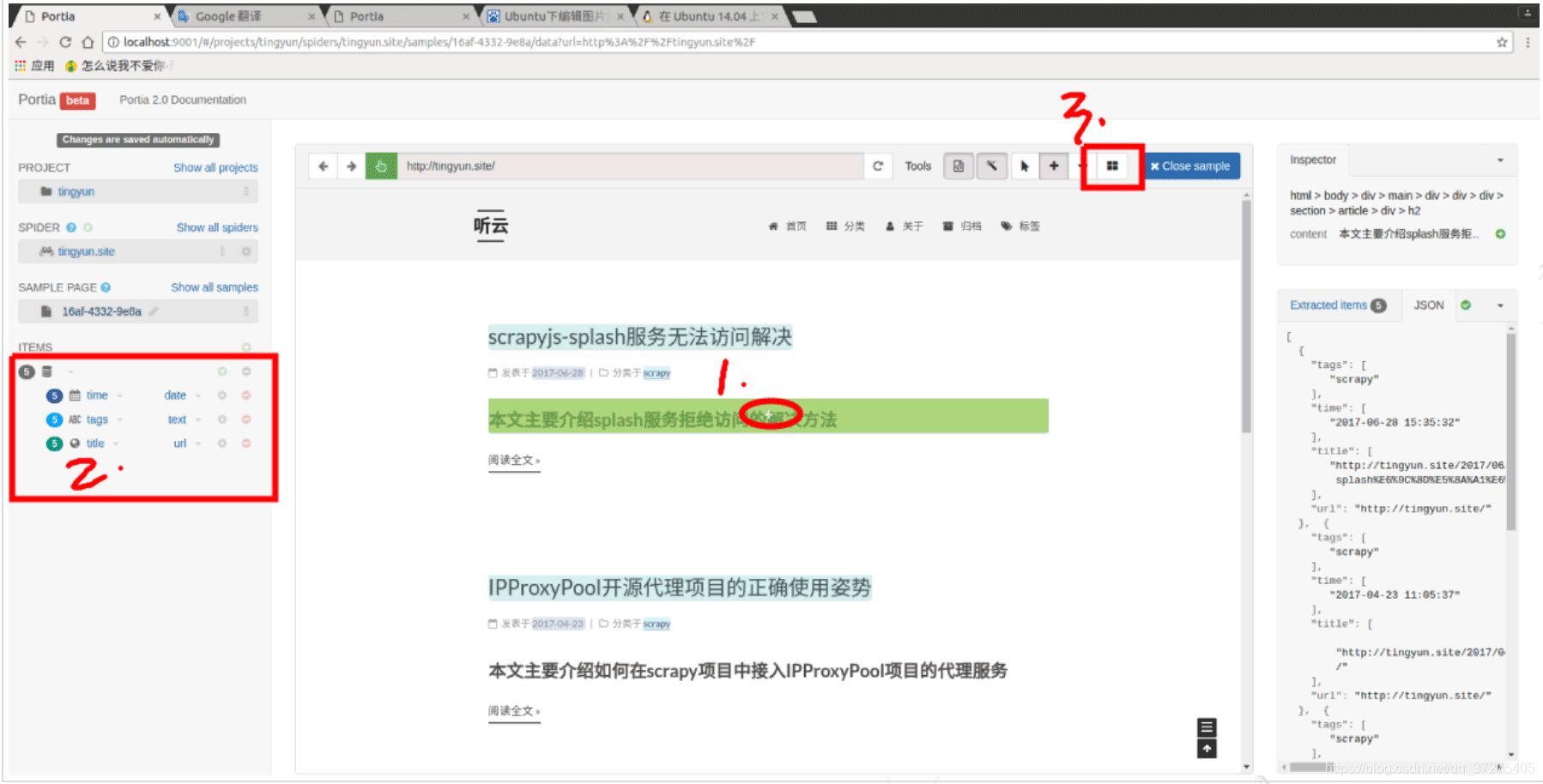

创建了sample之后,我们可以开始注释页面。注释会将页面中的一条数据链接到项目字段。这些即是我们想要提取的数据

字段命名,选择数据类型

Portia默认遵循所有域内URL。在许多情况下,您需要限制Portia将访问的页面,以便不会在不相关的页面上浪费请求。

为此,您可以分别设置跟随和排除白名单和黑名单URL的模式。可以通过将爬网策略更改为来配置这些。Configure URL patterns

到此操作结束

可以在最右侧看到我们选中的项目,将所有需要提取的items注释完之后,关闭样本。Close Sample,如果以后需要再添加其他元素,继续配置此样本,方便后续的抓取。

最后,我们可以在右边看到我们需要的数据,json如下格式

启动程序

我们配置好了sample page和start pages,那么就要开始抓取数据了,也就是将数据保存到json文件或者数据库中。这里我们保存成json文件

官方给出的代码如下

docker run -i -t --rm -v PROJECTS_FOLDER:/app/data/projects:rw -v OUPUT_FOLDER:/mnt:rw -p 9001:9001 scrapinghub/portia \ portiacrawl /app/data/projects/PROJECT_NAME SPIDER_NAME -o /mnt/RESULT.json

其中可以更改的是大写的那些部分:PROJECTS_FOLDER / OUPUT_FOLDER / PROJECT_NAME / SPIDER_NAME / RESULT.json

依次是: 项目名 / 输出目录 / project的名字 / Spider名字 / 保存结果的文件

启动程序前必须先关闭Portia的调试页面,这里我直接使用kill命令,因为我在docker启动的终端按下ctrl+c 或 crtl+z都无效,只能用进程关闭

例如,我的启动代码如下:

docker run -i -t --rm -v ~/portia_projects:/app/data/projects:rw -v ~/result:/mnt:rw -p 9001:9001 scrapinghub/portia \ portiacrawl /app/data/projects/tingyun tingyun.site -o /mnt/tingyun.json

运行成功就能看见代码在飞快地跑了,而且都是我们想要的items

总结

到此,我们就结束了这一次使用Portia的抓取之旅,通过使用Portia确实能实现很快速简易的抓取功能,能将抓取过程可视化得呈现给操作者,还有其他有趣的功能在后续的学习中遇到再次分享给大家,接下来会去考虑试着将其用到一些大规模的抓取上,看看到底效果如何,更多关于Portia开源可视化爬虫工具的资料请关注我们其它相关文章!