python机器学习高数篇之泰勒公式

不少同学一提到泰勒公式,脑海里立马浮现高大上的定义和长长的公式,令人望而生畏。

实际上,泰勒公式没有那么可怕,它是用简单的多项式来逼近一个光滑的函数,从而近似替代不熟悉的函数。由于泰勒公式具有将复杂函数近似成多个幂函数叠加形式的性质,可以用它进行比较、求极限、求导、解微分方程等。

我们先来看一下泰勒公式的发明者,布鲁克·泰勒——

布鲁克·泰勒(Brook Taylor,1685-1732),英国数学家,牛顿学派最优秀的代表人物之一,他于1712年的一封信里首次叙述了泰勒公式。

再来看一下高数书上对泰勒公式的定义:

公式3-5就称为f(x)在x0处的带有拉格朗日余项的n阶泰勒公式。

初看这个泰勒公式的定义,就觉得恢宏大气,气势磅礴。不过光从泰勒公式的定义,很难直观看出它是怎么用多项式逼近原函数的。接下来我们用图像和图表来感受一下——

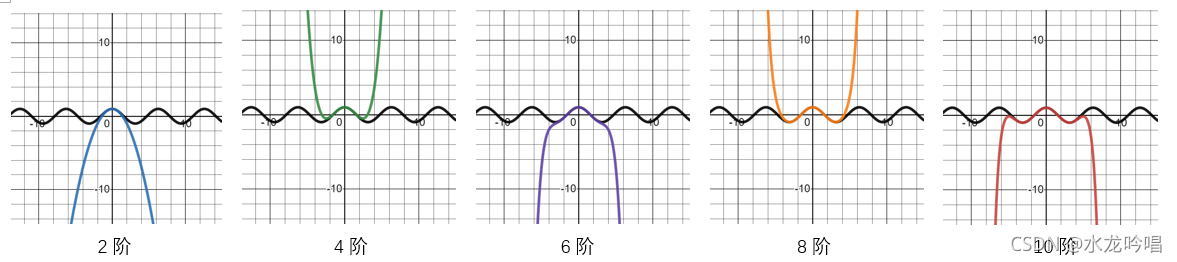

这里我们先列举出f(x) = cosx在原点的泰勒2阶、4阶、6阶、8阶、10阶的多项式,并用图像表示该函数及其泰勒n阶多项式。

对应图像如下,其中黑色线条为原函数f(x),彩色线条为多项式g(x)。可以看到随着阶数的增大,多项式在更大范围内越来越逼近原函数。

我们再用python实现函数y=cosx的泰勒n阶多项式,并与y=cosx的实际值进行比较,其中令n=40。

def f_cos(x):

m = 20+1

sum = 1.0

for i in range(1,m): #range函数取值是左闭右开

n = 2 * i

tmp1,tmp2,tmp3 = 1,1,1

for j in range(1,i+1):

tmp1 = -tmp1

for j in range(1,n+1):

tmp2 = tmp2*x

tmp3 = tmp3*j

sum = sum + tmp1*tmp2/tmp3

return sum

from numpy import *

for x in range(-20,21):

print("x = " + str(x))

print("f_cos(x) = " + str(f_cos(x)))

print("cos(x) = " + str(cos(x)))

比较自定义的f_cos(x)和numpy库的cosx的误差:

| x取值 | 自定义的f_cos(x) | numpy库的cosx | 误差(f_cos(x) - cos(x)) | 分析 |

|---|---|---|---|---|

| 20 | 2577.3069 | 0.4081 | 2576.8988 | 误差非常大 |

| 19 | 305.1701 | 0.9887 | 304.1814 | 误差较大 |

| 18 | 32.5969 | 0.6603 | 31.9366 | 存在误差 |

| 17 | 2.6676 | -0.2752 | 2.9428 | 存在误差 |

| 16 | -0.7234 | -0.9577 | 0.2343 | 存在0.1级误差 |

| 15 | -0.7439 | -0.7597 | 0.0158 | 存在0.01级误差 |

| 14 | 0.1376 | 0.1367 | 0.0009 | 存在0.0001级误差 |

| 13 | 0.9075 | 0.9074 | 0.0000 | 精度范围内一致 |

| 12 | 0.8439 | 0.8439 | 0.0000 | 精度范围内一致 |

| 11 | 0.0044 | 0.0044 | 0.0000 | 精度范围内一致 |

| 10 | -0.8391 | -0.8391 | 0.0000 | 精度范围内一致 |

| 9 | -0.9111 | -0.9111 | 0.0000 | 精度范围内一致 |

| 8 | -0.1455 | -0.1455 | 0.0000 | 精度范围内一致 |

| 7 | 0.7539 | 0.7539 | 0.0000 | 精度范围内一致 |

| 6 | 0.9602 | 0.9602 | 0.0000 | 精度范围内一致 |

| 5 | 0.2837 | 0.2837 | 0.0000 | 精度范围内一致 |

| 4 | -0.6536 | -0.6536 | 0.0000 | 精度范围内一致 |

| 3 | -0.9900 | -0.9900 | 0.0000 | 精度范围内一致 |

| 2 | -0.4161 | -0.4161 | 0.0000 | 精度范围内一致 |

| 1 | 0.5403 | 0.5403 | 0.0000 | 精度范围内一致 |

| 0 | 1.0000 | 1.0000 | 0.0000 | 精度范围内一致 |

由于f(x) = cosx函数关于y轴对称,这里只列举出了x轴右半部分[0,20]的范围,x轴左半部分的结果与右半部分结果相同。

在[0,20]范围内,当x=20时,二者的误差非常大。随着x的减小,二者的误差也在逐渐减小。在[0,13]范围内,二者在精度范围内完全一致,几乎零误差。

大家可以尝试一下,把n的值调大,这个精度一致的范围会变大。例如此例若n=30,即y=cosx的泰勒30阶多项式,则在[-20,20]范围内,二者精度都完全一致。感兴趣的同学可以运用同样的方法,分析一下其他函数。

再试着写出函数y=sinx的泰勒n阶多项式的python程序,其中n=19。

def f_sin(x):

m = 10+1

sum = 0.0

for i in range(1,m):

n = 2 * i - 1

tmp1,tmp2,tmp3 = 1,1,1

for j in range(1,i):

tmp1 = -tmp1

for j in range(1,n+1):

tmp2 = tmp2*x

tmp3 = tmp3*j

sum = sum + tmp1*tmp2/tmp3

return sum

from numpy import *

for x in range(-20,21):

print("x = " + str(x))

print("f_sin(x) = " + str(f_sin(x)))

print("sin(x) = " + str(sin(x)))

后续会继续增加一些函数的泰勒n阶多项式python程序(可能会偷懒)。

最后推荐一个比较好用的在线画函数的工具Desmos:

https://www.desmos.com/calculator?lang=zh-CN

简易教程:

https://www.ravenxrz.ink/archives/27d14722.html

还可以用著名的心形线画个爱心哦:

到此这篇关于python机器学习高数篇之泰勒公式的文章就介绍到这了,更多相关python泰勒公式内容请搜索我们以前的文章或继续浏览下面的相关文章希望大家以后多多支持我们!