解决pytorch load huge dataset(大数据加载)

问题

最近用pytorch做实验时,遇到加载大量数据的问题。实验数据大小在400Gb,而本身机器的memory只有256Gb,显然无法将数据一次全部load到memory。

解决方法

首先自定义一个MyDataset继承torch.utils.data.Dataset,然后将MyDataset的对象feed in torch.utils.data.DataLoader()即可。

MyDataset在__init__中声明一个文件对象,然后在__getitem__中缓慢读取数据,这样就不会一次把所有数据加载到内存中了。训练数据存放在train.txt中,每一行是一条数据记录。

import torch.utils.data as Data from tqdm import tqdm class MyDataset(Data.Dataset): def __init__(self,filepath): number = 0 with open(filepath,"r") as f: # 获得训练数据的总行数 for _ in tqdm(f,desc="load training dataset"): number+=1 self.number = number self.fopen = open(filepath,'r') def __len__(self): return self.number def __getitem__(self,index): line = self.fopen.__next__() # 自定义transform()对训练数据进行预处理 data = transform(line) return data train_dataset = MyDataset(filepath = "train.txt") training_data = Data.DataLoader(dataset=train_dataset, batch_size=32,num_workers=1)

注意

1、num_workers只能设置为1。因为MyDataset初始化时只有一个文件对象,在dataloader时num_workers=1只用一个线程去操作文件对象读取数据。如果num_workers>1, 会出错,多个线程同时操作同一个文件对象,得到的数据并不是你想要的。

2、每一个epoch结束以后,需要重新声明train_dataset和training_data。因为一个epoch结束以后,文件对象已经指向文件末尾,下一个epoch取数据时,什么也得不到。

3、因为这里__getitem__()只是顺序的从文件中取出一行,而与index无关,那么在DataLoader时,即使参数shuffle指定为True,得到的数据依然是顺序的,即该方法无法shuffle数据。

补充:Pytorch加载自己的数据集(使用DataLoader读取Dataset)

1. 我们经常可以看到Pytorch加载数据集会用到官方整理好的数据集

很多时候我们需要加载自己的数据集,这时候我们需要使用Dataset和DataLoader

Dataset:是被封装进DataLoader里,实现该方法封装自己的数据和标签。

DataLoader:被封装入DataLoaderIter里,实现该方法达到数据的划分。

2.Dataset

阅读源码后,我们可以指导,继承该方法必须实现两个方法:

_getitem_()

_len_()

因此,在实现过程中我们测试如下:

import torch

import numpy as np

# 定义GetLoader类,继承Dataset方法,并重写__getitem__()和__len__()方法

class GetLoader(torch.utils.data.Dataset):

# 初始化函数,得到数据

def __init__(self, data_root, data_label):

self.data = data_root

self.label = data_label

# index是根据batchsize划分数据后得到的索引,最后将data和对应的labels进行一起返回

def __getitem__(self, index):

data = self.data[index]

labels = self.label[index]

return data, labels

# 该函数返回数据大小长度,目的是DataLoader方便划分,如果不知道大小,DataLoader会一脸懵逼

def __len__(self):

return len(self.data)

# 随机生成数据,大小为10 * 20列

source_data = np.random.rand(10, 20)

# 随机生成标签,大小为10 * 1列

source_label = np.random.randint(0,2,(10, 1))

# 通过GetLoader将数据进行加载,返回Dataset对象,包含data和labels

torch_data = GetLoader(source_data, source_label)

3.DataLoader

提供对Dataset的操作,操作如下:

torch.utils.data.DataLoader(dataset,batch_size,shuffle,drop_last,num_workers)

参数含义如下:

dataset: 加载torch.utils.data.Dataset对象数据

batch_size: 每个batch的大小

shuffle:是否对数据进行打乱

drop_last:是否对无法整除的最后一个datasize进行丢弃

num_workers:表示加载的时候子进程数

因此,在实现过程中我们测试如下(紧跟上述用例):

from torch.utils.data import DataLoader # 读取数据 datas = DataLoader(torch_data, batch_size=6, shuffle=True, drop_last=False, num_workers=2)

此时,我们的数据已经加载完毕了,只需要在训练过程中使用即可。

4.查看数据

我们可以通过迭代器(enumerate)进行输出数据,测试如下:

for i, data in enumerate(datas):

# i表示第几个batch, data表示该batch对应的数据,包含data和对应的labels

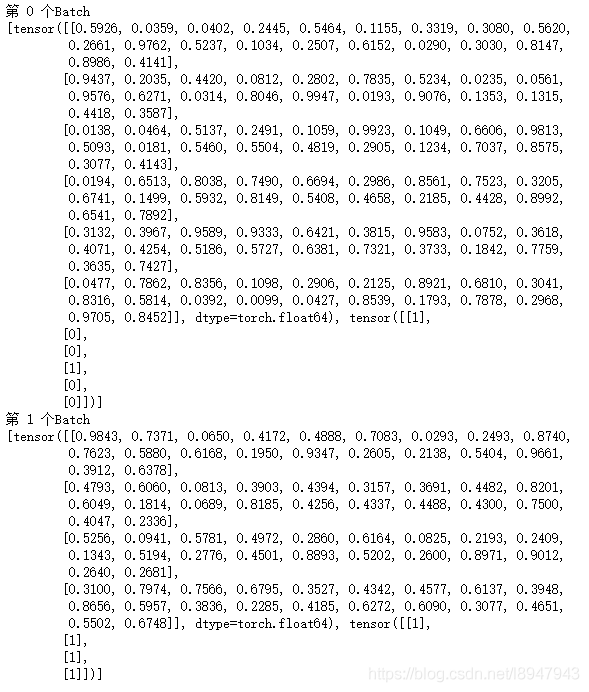

print("第 {} 个Batch \n{}".format(i, data))

输出结果如下图:

结果说明:由于数据的是10个,batchsize大小为6,且drop_last=False,因此第一个大小为6,第二个为4。每一个batch中包含data和对应的labels。

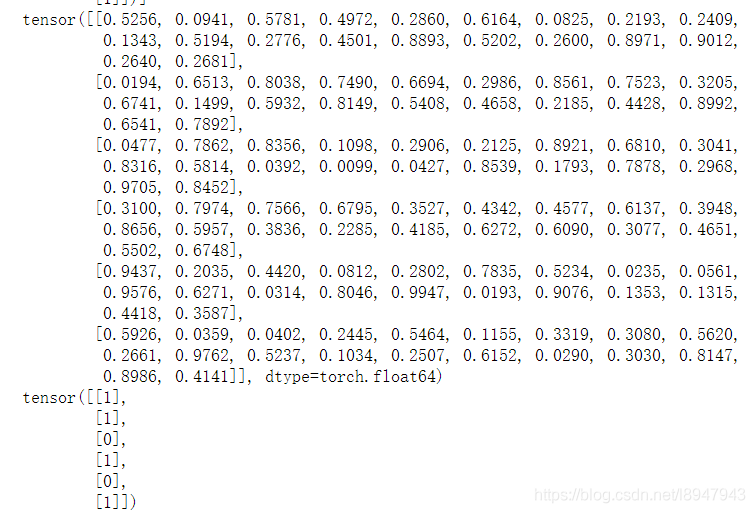

当我们想取出data和对应的labels时候,只需要用下表就可以啦,测试如下:

# 表示输出数据 print(data[0]) # 表示输出标签 print(data[1])

结果如图:

以上为个人经验,希望能给大家一个参考,也希望大家多多支持我们。