Tensorflow中使用cpu和gpu有什么区别

目录

- 使用cpu和gpu的区别

- 一些术语的比较(tensorflow和pytorch/cpu和gpu/)

- tensorflow和pytorch

- cpu和gpu

- cuda

使用cpu和gpu的区别

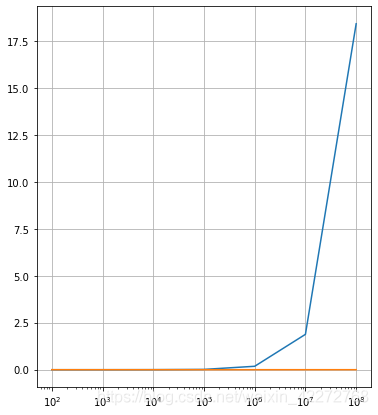

在Tensorflow中使用gpu和cpu是有很大的差别的。在小数据集的情况下,cpu和gpu的性能差别不大。

不过在大数据集的情况下,cpu的时间显著增加,而gpu变化并不明显。

不过,我的笔记本电脑的风扇终于全功率运行了。

import tensorflow as tf

import timeit

import numpy as np

import matplotlib.pyplot as plt

def cpu_run(num):

with tf.device('/cpu:0'):

cpu_a=tf.random.normal([1,num])

cpu_b=tf.random.normal([num,1])

c=tf.matmul(cpu_a,cpu_b)

return c

def gpu_run(num):

with tf.device('/gpu:0'):

gpu_a=tf.random.normal([1,num])

gpu_b=tf.random.normal([num,1])

c=tf.matmul(gpu_a,gpu_b)

return c

k=10

m=7

cpu_result=np.arange(m,dtype=np.float32)

gpu_result=np.arange(m,dtype=np.float32)

x_time=np.arange(m)

for i in range(m):

k=k*10

x_time[i]=k

cpu_str='cpu_run('+str(k)+')'

gpu_str='gpu_run('+str(k)+')'

#print(cpu_str)

cpu_time=timeit.timeit(cpu_str,'from __main__ import cpu_run',number=10)

gpu_time=timeit.timeit(gpu_str,'from __main__ import gpu_run',number=10)

# 正式计算10次,取平均时间

cpu_time=timeit.timeit(cpu_str,'from __main__ import cpu_run',number=10)

gpu_time=timeit.timeit(gpu_str,'from __main__ import gpu_run',number=10)

cpu_result[i]=cpu_time

gpu_result[i]=gpu_time

print(cpu_result)

print(gpu_result)

fig, ax = plt.subplots()

ax.set_xscale("log")

ax.set_adjustable("datalim")

ax.plot(x_time,cpu_result)

ax.plot(x_time,gpu_result)

ax.grid()

plt.draw()

plt.show()

蓝线是cpu的耗时,而红线是gpu的耗时。

一些术语的比较(tensorflow和pytorch/cpu和gpu/)

tensorflow和pytorch

- pytorch是一个动态框架,tensorflow是一个静态框架。

- tensorflow是一个静态框架体现在:需要先构建一个tensorflow的计算图,构建好之后这样的一个计算图是不能变的,然后再传入不同的数据进去进行计算。

- 这种静态框架带来的问题是:固定了计算的流程,势必带来不灵活性,如果要改变计算的逻辑或者是随着时间变化的计算逻辑,这样的动态计算tensorflow是是无法实现的。

- pytorch是一个动态框架,和python的逻辑一样,对变量做任何操作都是灵活的。

- 一个好的框架需要具备三点:(1)对大的计算图能方便的实现(2)能自动求变量的导数(3)能简单的运行在GPU上。这三点pytorch都可以达到

- tensorflow在gpu上的分布式计算更为出色,在数据量巨大的时候效率比pytorch要高。企业很多都是用的tensorflow,pytorch在学术科研上使用多些。

- pytorch包括三个层次:tensor/variable/module。tensor即张量的意思,由于是矩阵的运算,所以适合在矩阵上跑。variable就是tensor的封装,封装的目的就是为了能够保存住该variable在整个计算图中的位置,能够知道计算图中各个变量之间的相互依赖关系,这样就能够反向求梯度。module是一个更高的层次,是一个神经网络的层次,可以直接调用全连接层、卷积层等神经网络。

cpu和gpu

- cpu更少的核,但是单个核的计算能力很强

- gpu:更多的核,每个核的计算能力不如cpu,所以更适合做并行计算,如矩阵计算,深度学习就是很多的矩阵计算。

cuda

- 直接写cuda代码就类似写汇编语言

- 比cuda高级的是cudnn

- 比cudnn高级的是用框架tensorflow/caffe/pytorch

以上为个人经验,希望能给大家一个参考,也希望大家多多支持我们。

赞 (0)