PyTorch CUDA环境配置及安装的步骤(图文教程)

Pytorch版本介绍

- torch:1.6

- CUDA:10.2

- cuDNN:8.1.0

✨安装 NVIDIA 显卡驱动程序

一般 电脑出厂/装完系统 会自动安装显卡驱动

如果有 可直接进行下一步

下载链接

http://www.nvidia.cn/Download/index.aspx?lang=cn

选择和自己显卡相匹配的显卡驱动

下载安装

✨确认项目所需torch版本

# pip install -r requirements.txt # base ---------------------------------------- Cython matplotlib>=3.2.2 numpy>=1.18.5 opencv-python>=4.1.2 pillow PyYAML>=5.3 scipy>=1.4.1 tensorboard>=2.2 torch>=1.6.0 torchvision>=0.7.0 tqdm>=4.41.0 # coco ---------------------------------------- # pycocotools>=2.0 # export -------------------------------------- # packaging # for coremltools # coremltools==4.0 # onnx>=1.7.0 # scikit-learn==0.19.2 # for coreml quantization # extras -------------------------------------- # thop # FLOPS computation # seaborn # plotting

例如此项目需求torch>=1.6

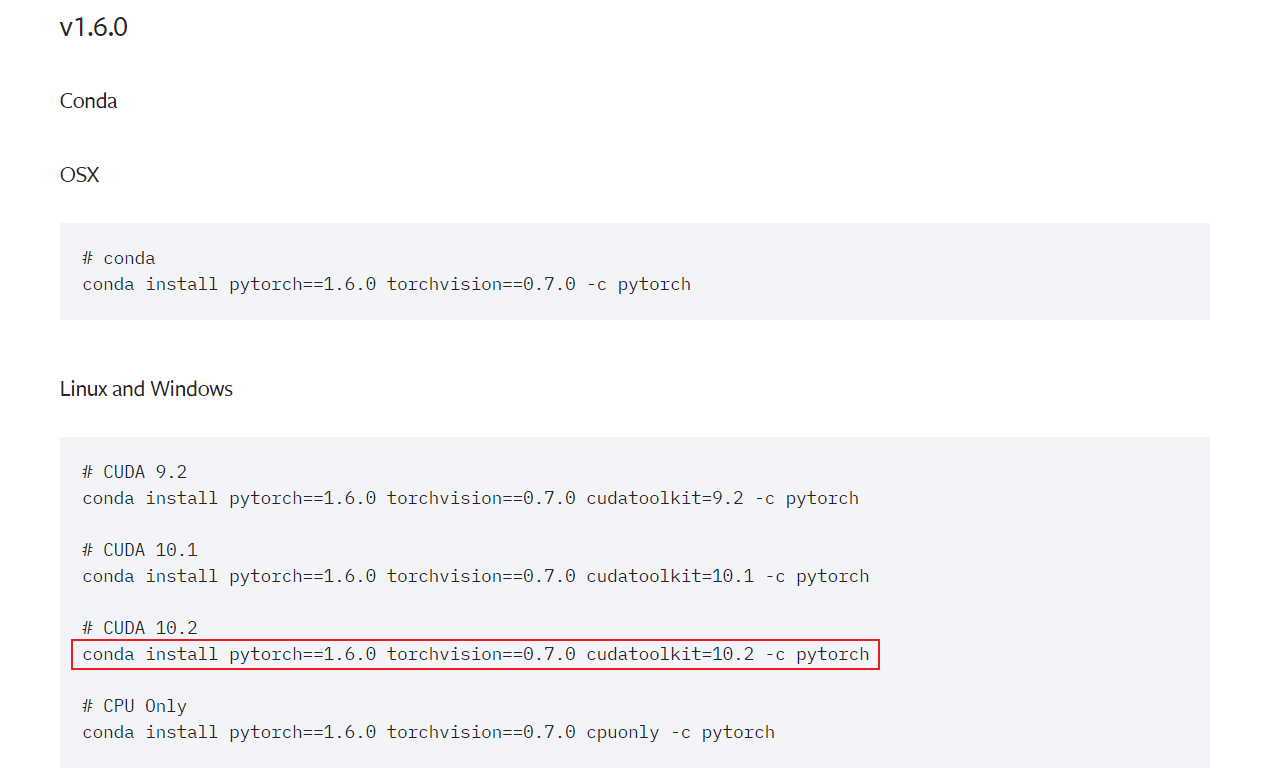

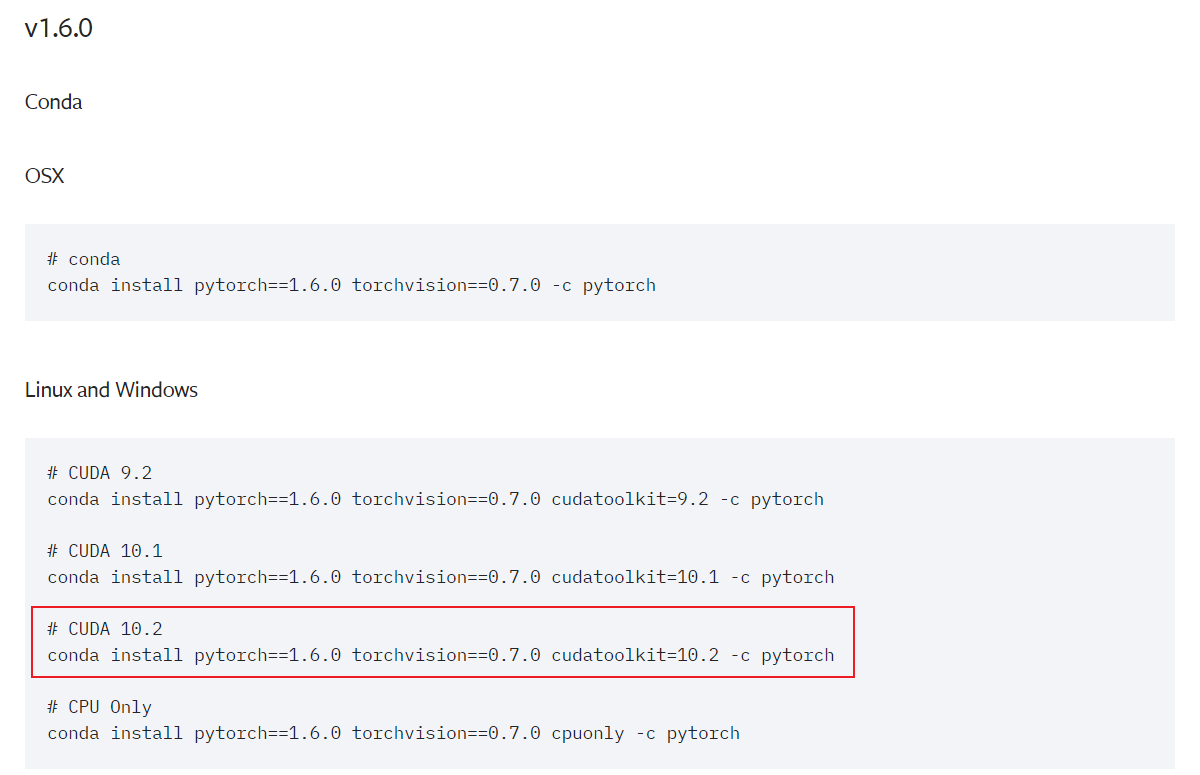

在PyTorch官网查看与之匹配的CUDA版本

https://pytorch.org/get-started/previous-versions/

这里可以从conda命令看出 torch1.6 可以安装10.2版本的CUDA

torch与CUDA版本一定要匹配!

✨安装 CUDA

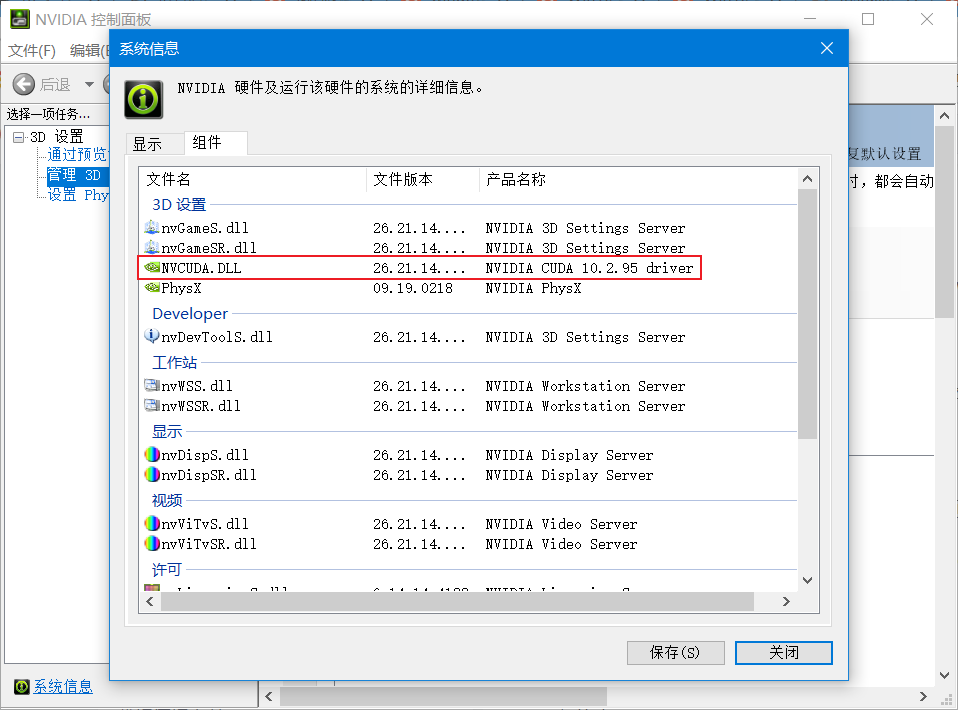

NVIDIA控制面板 -> 帮助 -> 系统信息 -> 组件

查看NVCUDA.DLL 后的参数

本机是10.2

//如果更新了显卡驱动这里参数可能会变高

下载的CUDA版本可以低于这里显示的参数 但是一定要与torch版本匹配

下载

下载链接:https://developer.nvidia.com/cuda-downloads

//上面的链接默认下载的是最新版本的CUDA

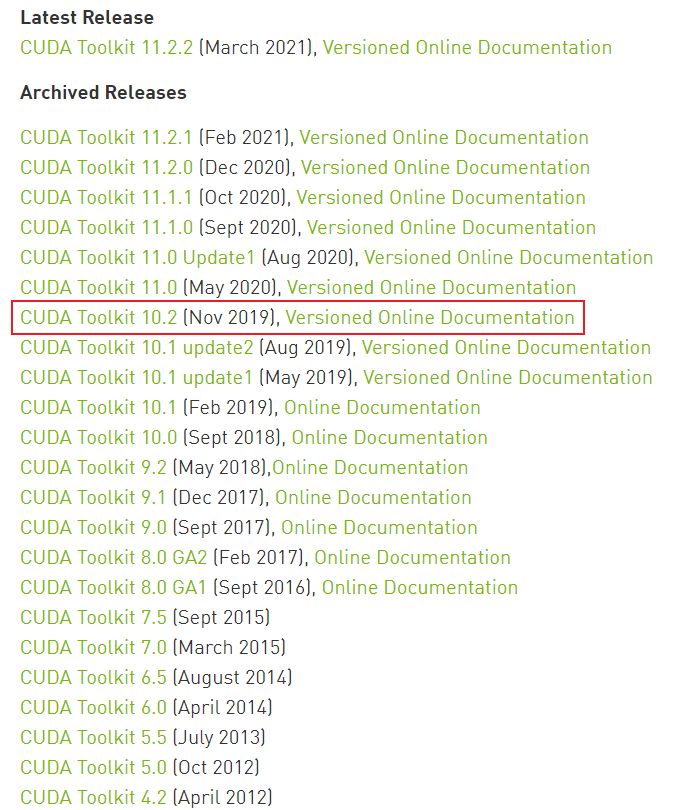

要下载之前版本的CUDA在上述下载页面下滑 然后点击 ”CUDA早期版本档案”

或者直接点击CUDA早期版本档案 跳转

选择CUDA Toolkit 10.2

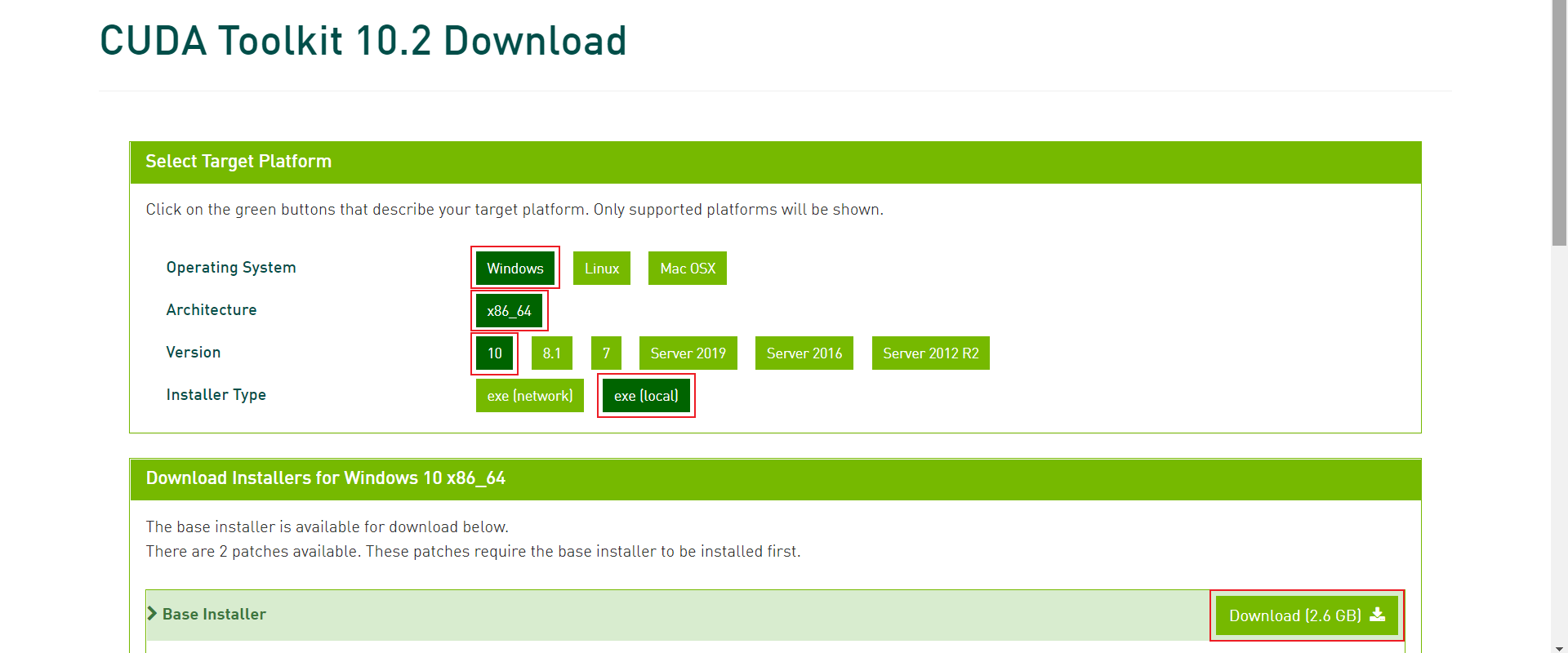

选择对应操作系统版本然后点击Download

!Installer Type一定要选exe(local)

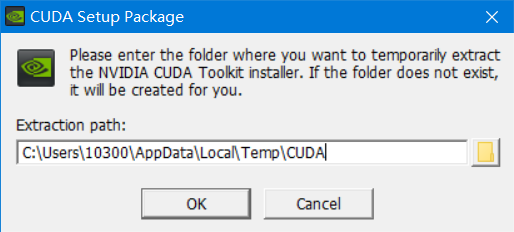

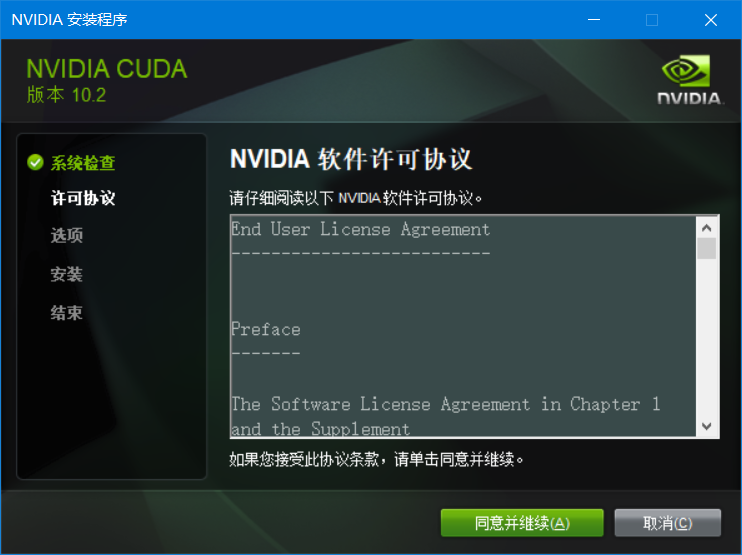

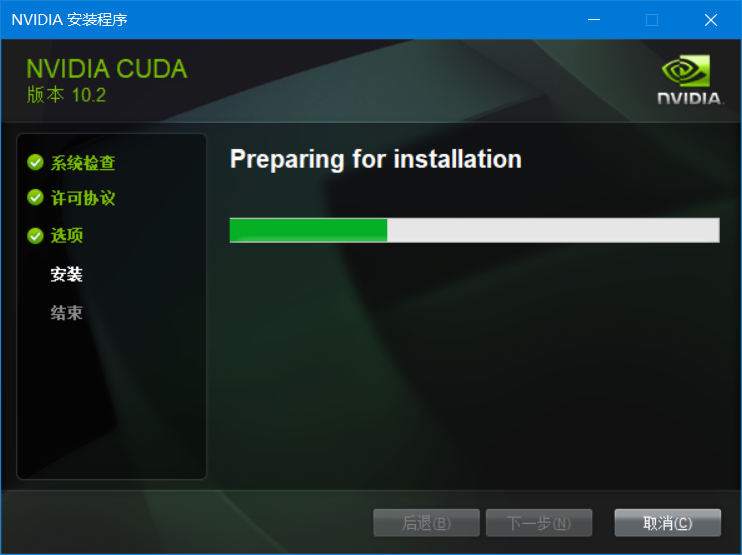

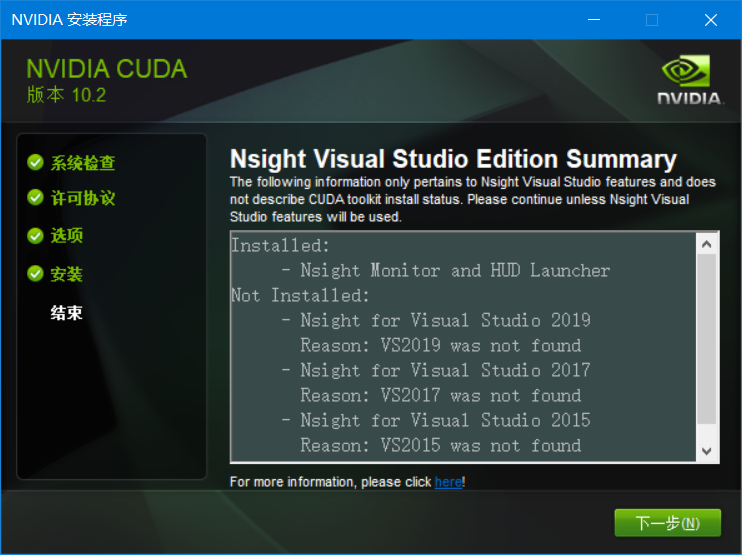

安装

安装完成

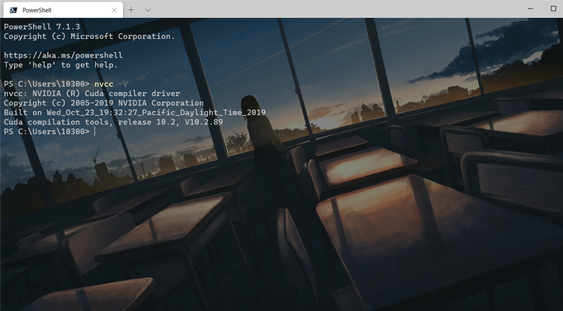

在Terminal输入以下命令

nvcc -V

显示CUDA版本则相关环境变量已经自动配置

✨安装cuDNN

下载

下载链接

https://developer.nvidia.com/rdp/cudnn-archive

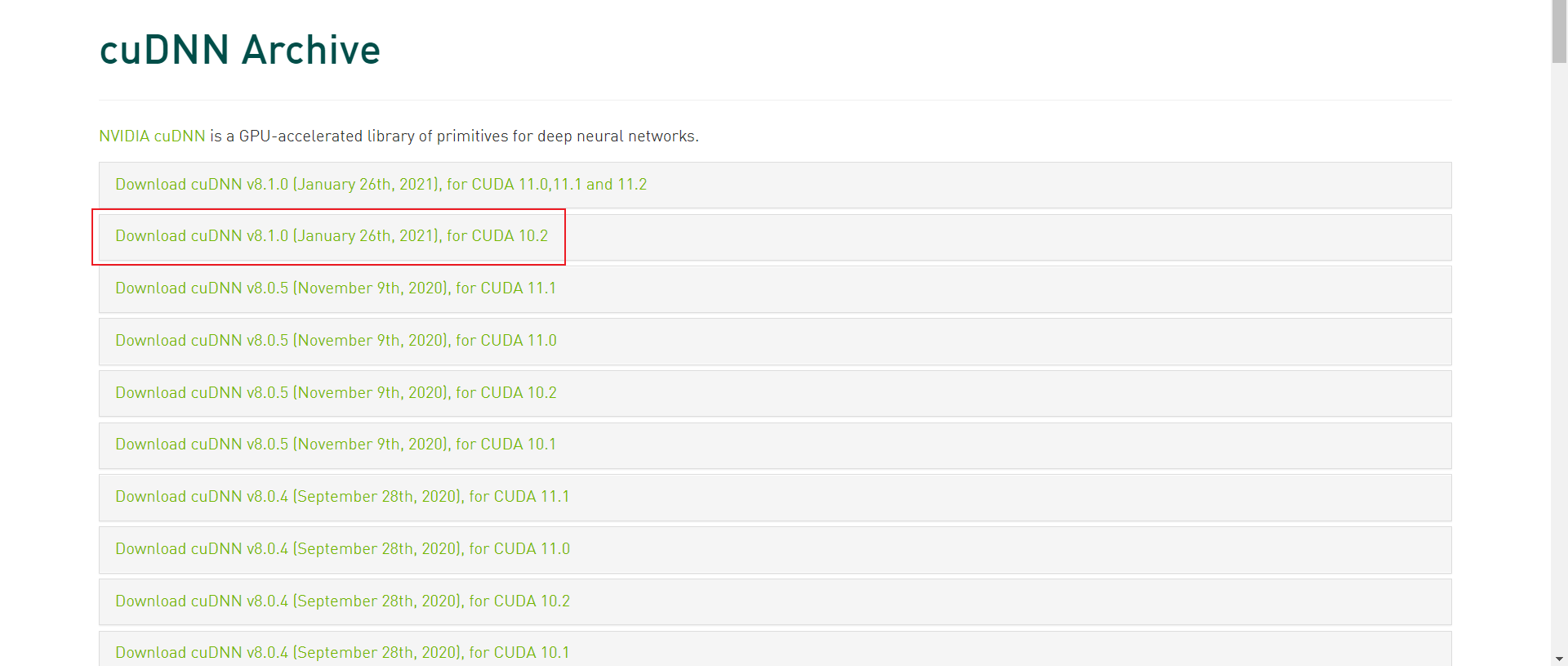

选择和操作系统以及CUDA相匹配的cuDNN版本

例如我刚才安装了CUDA10.2 这里选择Download cuDNN v8.1.0 (January 26th, 2021), for CUDA 10.2

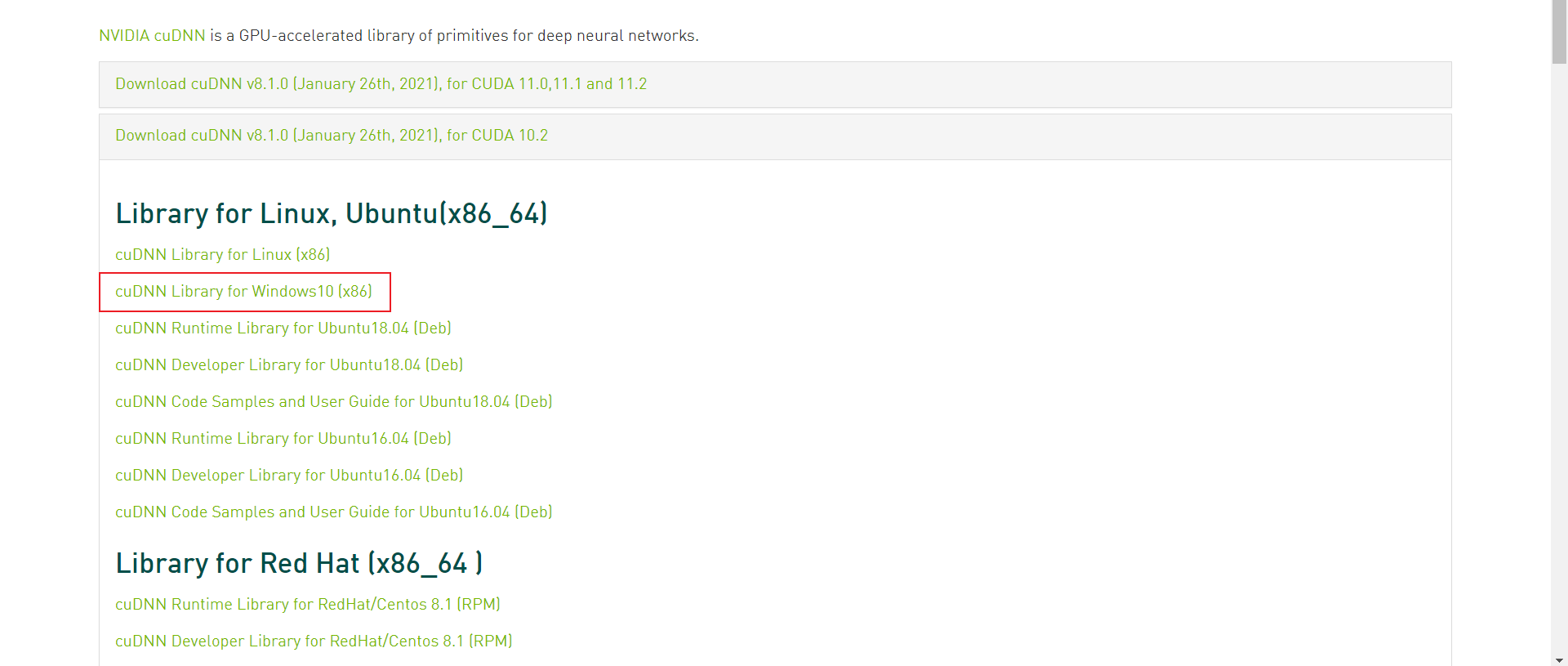

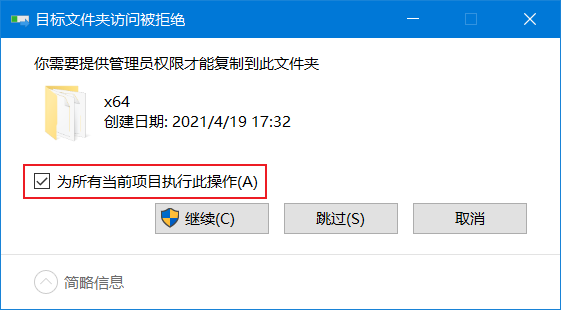

安装

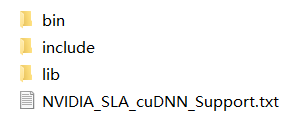

解压下载的zip

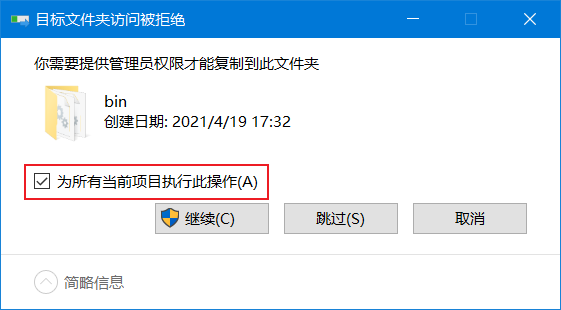

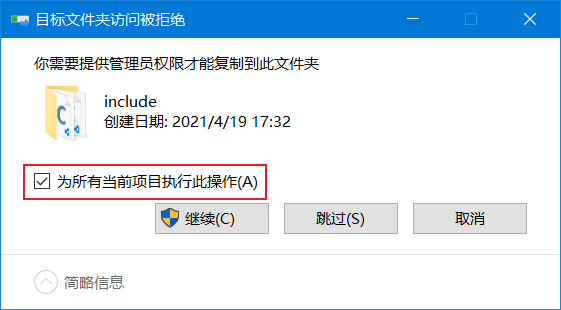

把解压得到的文件夹内的bin、include、lib目录下的dll文件与h文件分别复制到相应的CUDA的安装目录下

默认安装目录分别为

C:\Program Files\NVIDIA GPU Computing Toolkit\CUDA\v10.2\bin C:\Program Files\NVIDIA GPU Computing Toolkit\CUDA\v10.2\include C:\Program Files\NVIDIA GPU Computing Toolkit\CUDA\v10.2\lib

✨安装PyTorch

在线安装

在PyTorch官方链接上查看相应安装命令

https://pytorch.org/get-started/previous-versions/

例如我要安装CUDA10.2版本的torch1.6 对应的conda命令是

# CUDA 10.2 conda install pytorch==1.6.0 torchvision==0.7.0 cudatoolkit=10.2 -c pytorch

!在线安装速度很慢 可以选择下面离线安装的方法

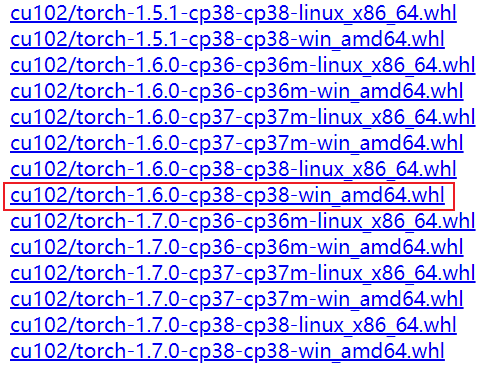

离线安装

whl下载链接

https://download.pytorch.org/whl/torch_stable.html

选择对应CUDA、Python、操作系统、torch版本的whl

例如我要安装CUDA10.2、Python3.8、torch1.6 版本的whl

应下载 cu102/torch-1.6.0-cp38-cp38-win_amd64.whl

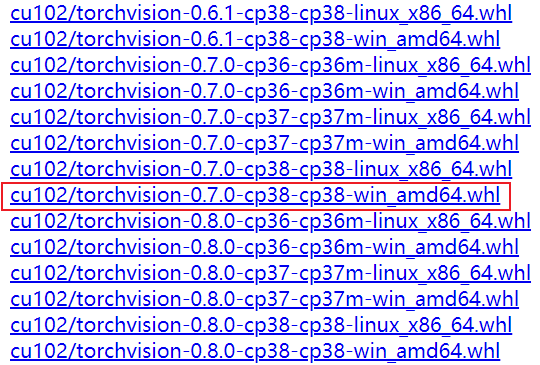

例如我要安装CUDA10.2、Python3.8、torchvision0.7 版本的whl

应下载 cu102/torchvision-0.7.0-cp38-cp38-win_amd64.whl

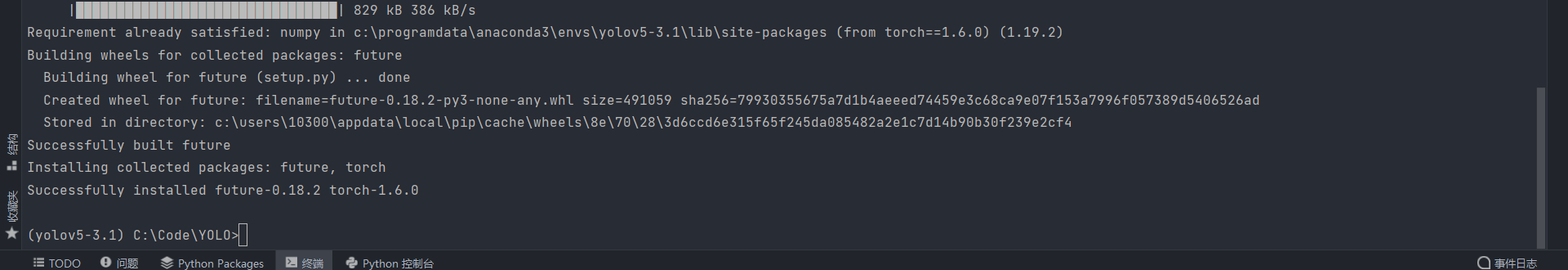

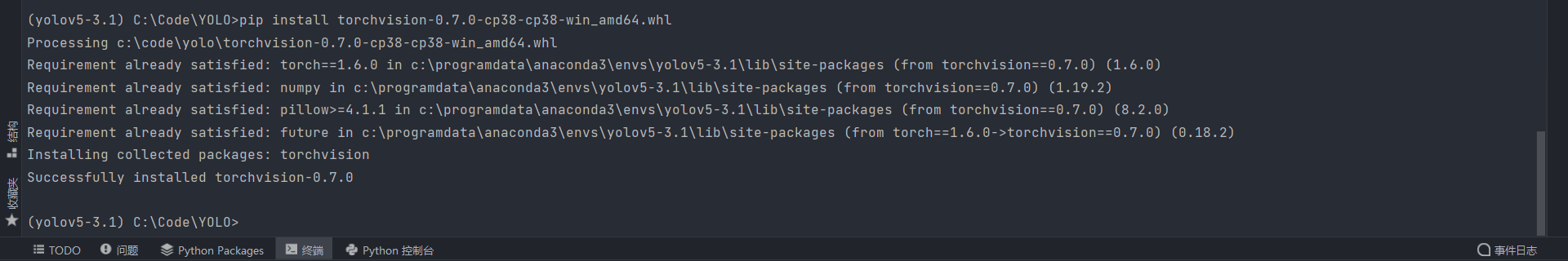

然后在conda环境中安装

pip install torch-1.6.0-cp38-cp38-win_amd64.whl

pip install torchvision-0.7.0-cp38-cp38-win_amd64.whl

安装完成

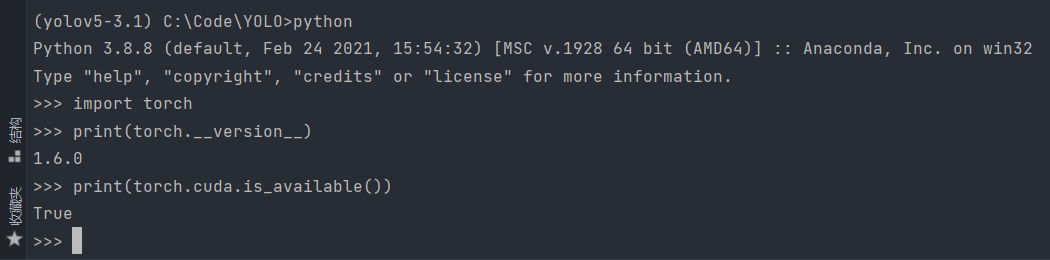

✨确认环境是否配置成功

import torch print(torch.__version__) print(torch.cuda.is_available())

如上所示环境配置成功

✨参考及引用

https://blog.csdn.net/qq_37296487/article/details/83028394

https://blog.csdn.net/maoersong/article/details/104484826

https://blog.csdn.net/qq_36653505/article/details/83932941

到此这篇关于PyTorch CUDA环境配置及安装的步骤(图文教程)的文章就介绍到这了,更多相关PyTorch CUDA配置及安装内容请搜索我们以前的文章或继续浏览下面的相关文章希望大家以后多多支持我们!