ELK监控nginx日志总结

ELK介绍

ELK即ElasticSearch + Logstash + kibana

- ES:作为存储引擎

- Logstash:用来采集日志

- Kibana可以将ES中的数据进行可视化,可以进行数据分析中常见的对属性求和、平均值、计数,按照时间戳或其他日志展示出来

整体的流程就是先把logstash启动,读取nginx日志数据存储到ES中,再用kibana进行统计以及可视化

一.nginx

第一步需要先把nginx的日志格式修改为json格式,这样方便logstash读取

找到配置文件位置,我的是在/usr/local/nginx/conf

在其中添加

log_format main_json '{"@timestamp": "$time_local", '

'"remote_addr": "$remote_addr", '

'"referer": "$http_referer", '

'"request": "$request", '

'"status": $status, '

'"bytes": $body_bytes_sent, '

'"agent": "$http_user_agent", '

'"x_forwarded": "$http_x_forwarded_for", '

'"up_addr": "$upstream_addr",'

'"up_host": "$upstream_http_host",'

'"up_resp_time": "$upstream_response_time",'

'"request_time": "$request_time"'

' }';

access_log logs/access.log main_json; # 引用日志格式名称

改完以后日志的格式就会变为json字符串,如下所示

{

"@timestamp": "25/Feb/2022:10:58:15 +0800",

"remote_addr": "192.168.2.95",

"referer": "-",

"request": "GET /api/getScreenshot?url=http://www.qhjyedu.com/0e/bd/c12a3773/page.htm&path=/data2/ncs-cyber/mirror/page_image/situation_image/gdzx20211020/ddd38417-971b-400f-b430-834022c57d97.png&errorKeyWord=中国民族伟大复兴&successKeyWord=中华民族伟大复兴 HTTP/1.1",

"status": 304,

"bytes": 0,

"agent": "Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/94.0.4606.81 Safari/537.36",

"x_forwarded": "-",

"up_addr": "192.168.3.222:9848",

"up_host": "-",

"up_resp_time": "12.193",

"request_time": "12.193"

}

二.logstash

接着便是写logstash配置文件了,自己写一个配置文件,我的名字叫做nginx-access.conf,配置如下

input {

file {

path => ["/usr/local/nginx/logs/access.log"] # 读取日志文件的路径

start_position => "beginning"

codec => json { # 这里是将json字符串转化为json,不然的话会在es中存一个<属性,json字符串>

charset => ["UTF-8"]

}

}

}

filter { # 简单处理,无过滤操作

}

output {

elasticsearch {

hosts => ["你的ip:port"] # 你的es的ip+端口

index => "logstash-nginx-access-%{+YYYY.MM.dd}" # 你的索引名

}

stdout {

codec => rubydebug

}

}

这样配置完配置文件以后,就可以执行logstash指令了,根据配置文件,读取指定的日志文件

logstash-6.7.2/bin/./logstash -f /home/xxx/nginx_access.conf --path.data=/home/xxx/logstash

之后可以在es中查看自己新建立的索引

由于我这里服务器的logstash和es都是已经部署好的,没有部署的话需要查看一下部署的教程,部署一下

另外,日志采集其实也可以使用fleatbeats,是一个更加轻量易用的日志采集工具

三.kibana

接着就可以在kibana中对es索引进行可视化了

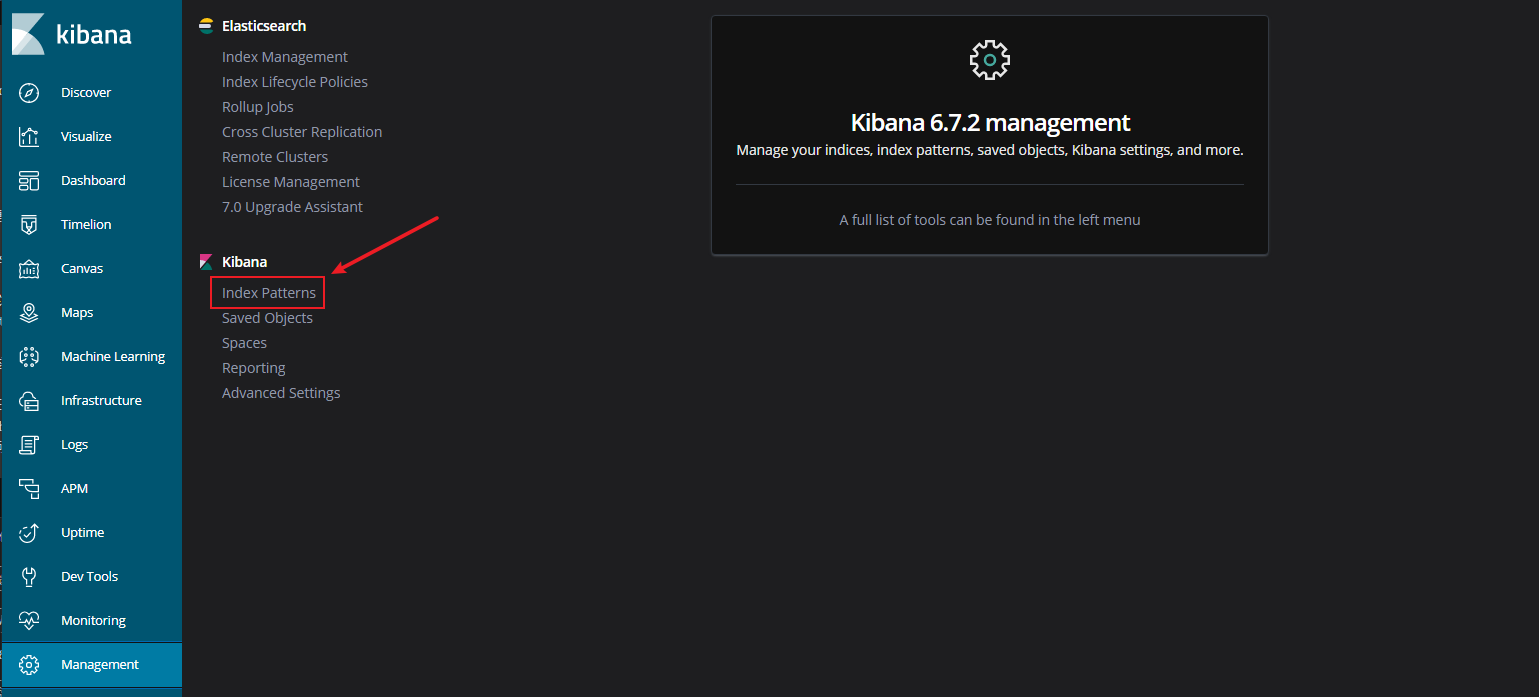

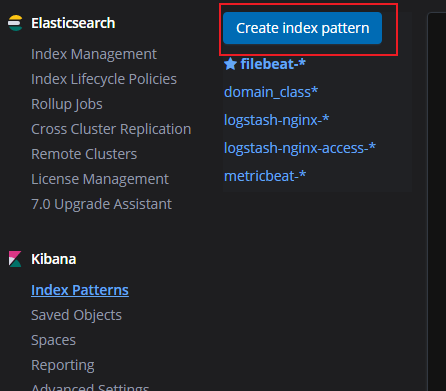

1.management添加索引

选择你在es中存储的索引,直接一路next。

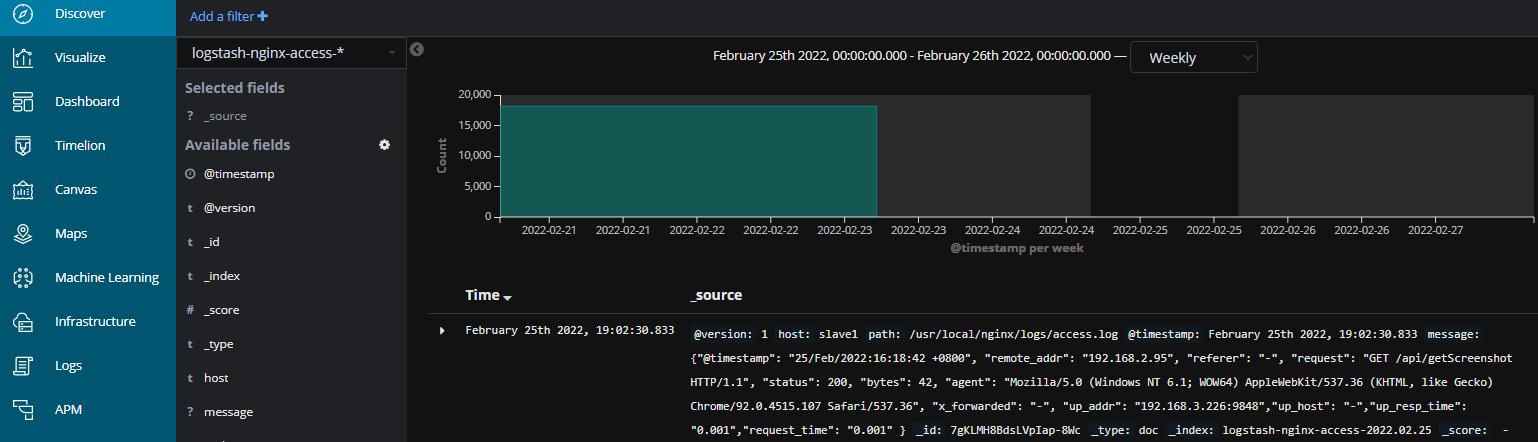

2.Discover查看索引

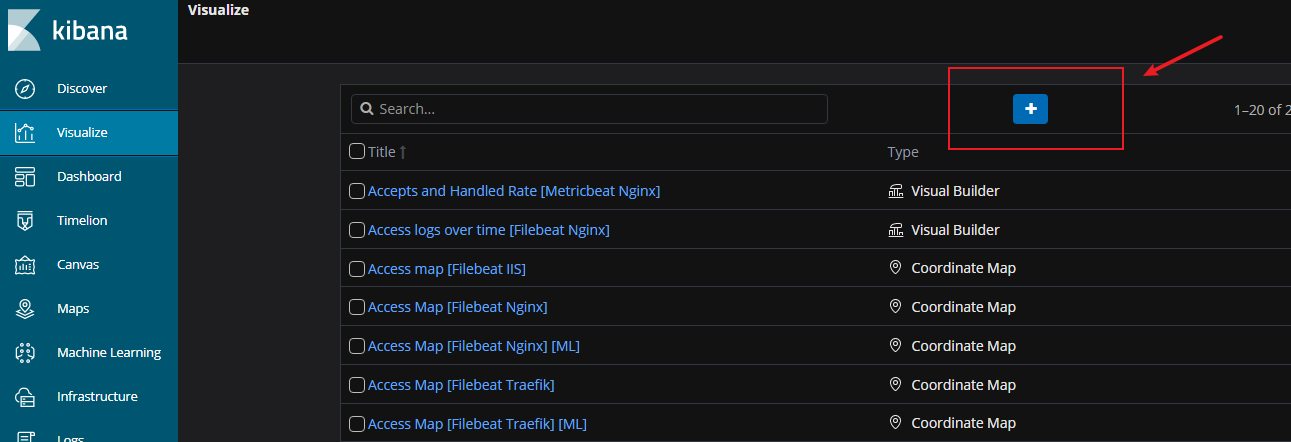

3.Visualize建立仪表盘模板

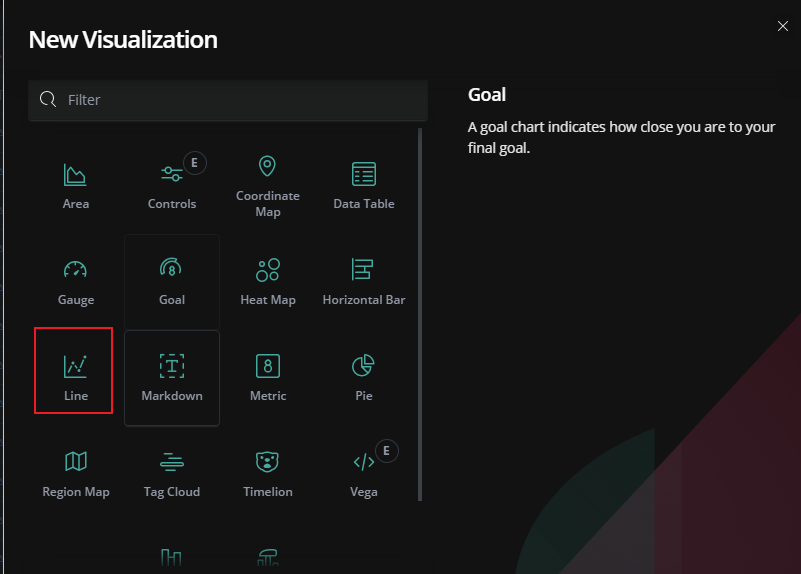

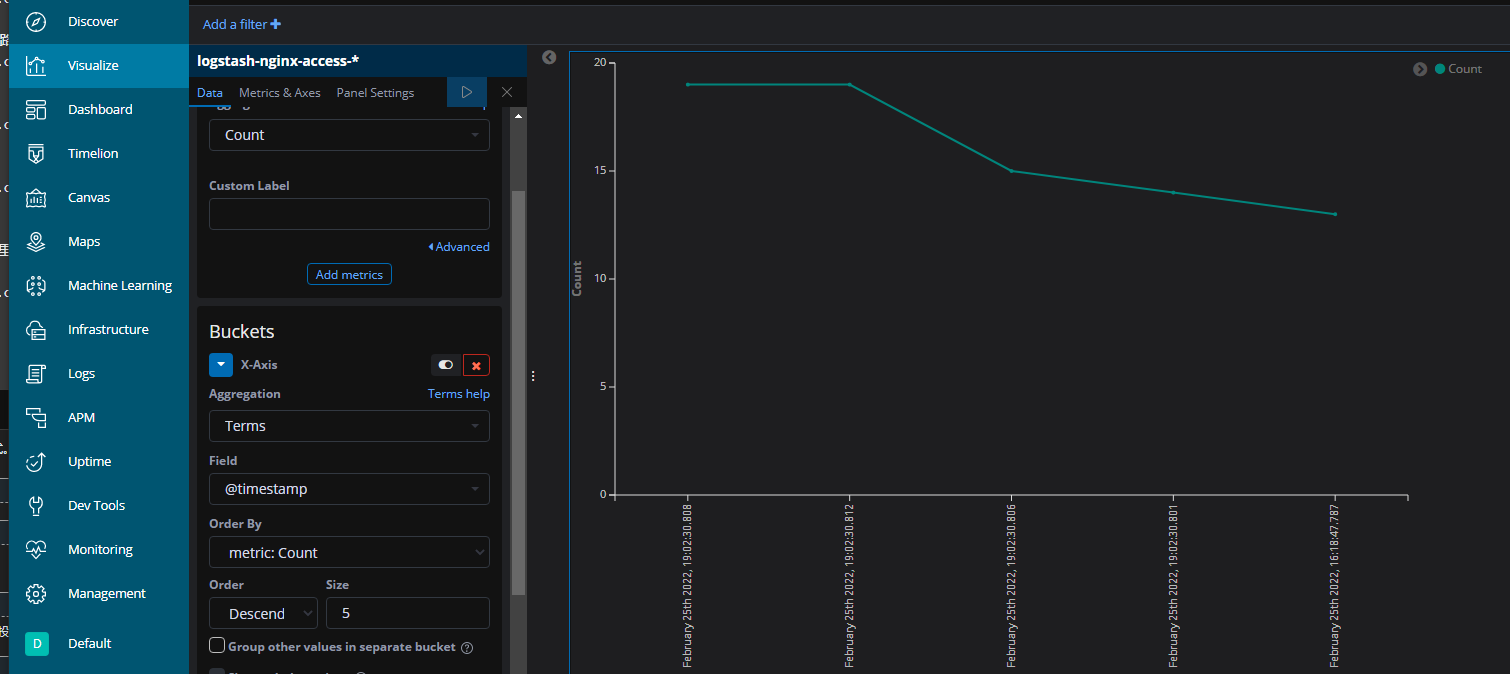

选择你想要展示的图标模式,我这里简单的测试了一下折线图,统计的同学应该对这些操作更加熟悉

纵轴选择count,横轴选择terms,执行一下,图表就出来了

点击上侧导航栏的save即可将你建立的这个视图模板保存,之后可以将其放入到dashboard持续监测

4.Dashboard

可以选择建立好的visualize,在这个地方进行展示

总结

一次关于elk的简单实践,主要的操作都在于部署、配置,不过由于我的服务器已经部署好了这些,只需要配置就行了。

另外不容易操作的点就在于visualize的配置,可能需要一些统计学知识,才能对数据进行更好的统计分析,以便公司做出更优的决策

到此这篇关于ELK监控nginx日志总结的文章就介绍到这了,更多相关ELK监控nginx日志内容请搜索我们以前的文章或继续浏览下面的相关文章希望大家以后多多支持我们!