python模拟表单提交登录图书馆

本文实例为大家分享了python模拟登录图书馆的具体代码,供大家参考,具体内容如下

模拟表单提交的原理:

我们都知道Http是无状态的,所以当我们提交的数据和浏览器中正常提交一样,那么服务器就会返回和浏览器中一样的响应。所以我们这里来模拟浏览器表单提交登录广东工业大学的图书馆 http://222.200.122.171:7771/login.aspx,获取cookie,我们接下来访问图书馆网站里的其他页面时就带上这个cookie,服务器会认为我是已经登录的用户,回正常返回数据给我。

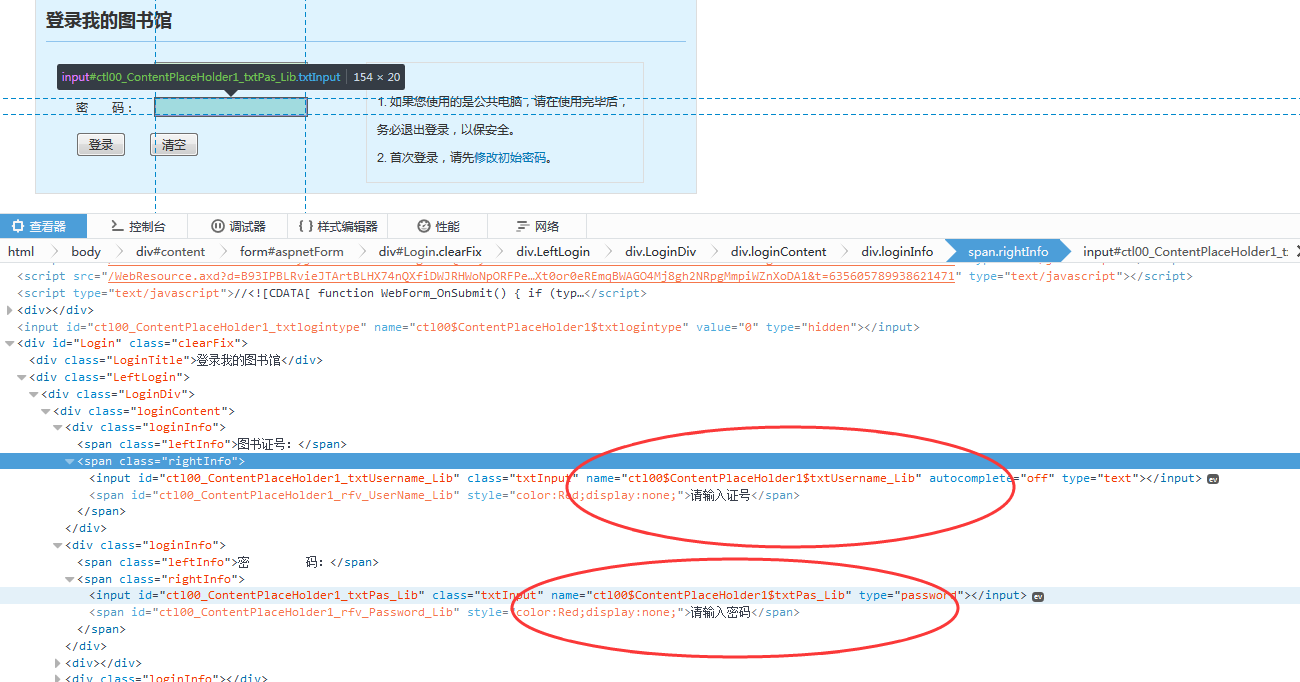

首先我们先用浏览器查看页面源代码找到要提交的form表单:

接下来我们要获取表单中的input 包括hidden,因为hidden也会跟着表单一起提交.找到账号和密码对应的name 到时候我们需要用自己的账号填写的.

获取到所有的要提交的表单内容后,将账号和密码替换成自己的账号和密码,提交请求.获取cookie并保存在cookie中。

代码如下(Python2.7版本 和Python3都其实都差不多):

# -*- coding:utf-8 -*-

import urllib

import urllib2

import cookielib

import bs4

result = urllib2.urlopen("http://222.200.122.171:7771/login.aspx")

soup = bs4.BeautifulSoup(result, "html.parser")

logindiv = soup.find("form", attrs={"name": "aspnetForm"})

Allinput = logindiv.findAll("input")

inputData = {}

for oneinput in Allinput:

if oneinput.has_attr('name'):

if oneinput.has_attr('value'):

inputData[oneinput['name']] = oneinput['value']

else:

inputData[oneinput['name']] = ""

inputData['ctl00$ContentPlaceHolder1$txtPas_Lib'] = '*****'

inputData['ctl00$ContentPlaceHolder1$txtUsername_Lib'] = '*******'

filename = 'cookie.txt'

# 声明一个MozillaCookieJar对象实例来保存cookie,之后写入文件

cookie = cookielib.MozillaCookieJar(filename)

opener = urllib2.build_opener(urllib2.HTTPCookieProcessor(cookie))

postdata = urllib.urlencode(inputData)

result2 = opener.open("http://222.200.122.171:7771/login.aspx", postdata)

cookie.save(ignore_discard=True, ignore_expires=True)

#登录后 要访问的url

bookUrl = "http://222.200.122.171:7771/user/userinfo.aspx"

result=opener.open(bookUrl)

print result.read()

以上就是本文的全部内容,希望对大家的学习有所帮助,也希望大家多多支持我们。

您可能感兴趣的文章:

- Python Requests模拟登录实现图书馆座位自动预约

- Python爬虫模拟登录带验证码网站

- python采用requests库模拟登录和抓取数据的简单示例

- Python使用Socket(Https)Post登录百度的实现代码

- python使用rsa加密算法模块模拟新浪微博登录

- 用Python实现web端用户登录和注册功能的教程

- Python实现模拟登录及表单提交的方法

- 使用Python中的cookielib模拟登录网站

- python实现网站的模拟登录

- Python的Flask框架中实现简单的登录功能的教程

赞 (0)