Spring Boot整合ELK实现日志采集与监控

目录

- Spring Boot整合ELK实现日志采集与监控

- 前言

- 架构图示

- ELK搭建

- Spring Boot工程配置

- 验证

- 查看logstash是否接收到日志

- 查看索引是否已经生效

- 日志分析

- 结语

Spring Boot整合ELK实现日志采集与监控

前言

在分布式项目中,可以采用ELK来作为日志的收集与分析系统,提供一个统一的入口来对日志进行收集,访问和管理。本文主要演示Spring Boot项目与ELK整合来实现日志的采集与监控。

架构图示

本次测试工程中,采用的架构如下图所示,微服务通过TCP协议将日志提供给Logstach,Logstach对日志数据进行采集和转换之后,将日志数据发送到Elasticsearch存储库,然后再通过Kibana对日志数据进行可视化的呈现。

当然还有很多种不同的实现方案,比如可以通过Beats替代Logstash,或者可以与消息队列集成,通过生产消费的模式来提升日志数据的可靠性等等,大家有兴趣可以自行了解一下,官方也有一些图示与讲解,具体可以参考:https://www.elastic.co/guide/en/logstash/current/deploying-and-scaling.html

ELK搭建

本次搭建使用的是docker的方式,具体使用的软件版本如下(本次用于测试,数据目录未挂载出来):

| elasticsearch | 7.14.2 |

|---|---|

| logstash | 7.14.2 |

| kibana | 7.14.2 |

| docker | 20.10.10 |

| docker-compose | 1.29.2 |

在docker中创建一个自定义网络elk,elasticsearch、logstash、kibana服务都基于该网络:

docker network create elk # 创建自定义网络

启动elasticsearch:

docker run -p 9200:9200 -p 9300:9300 -e "discovery.type=single-node" --name elasticsearch --network elk -d elasticsearch:7.14.2

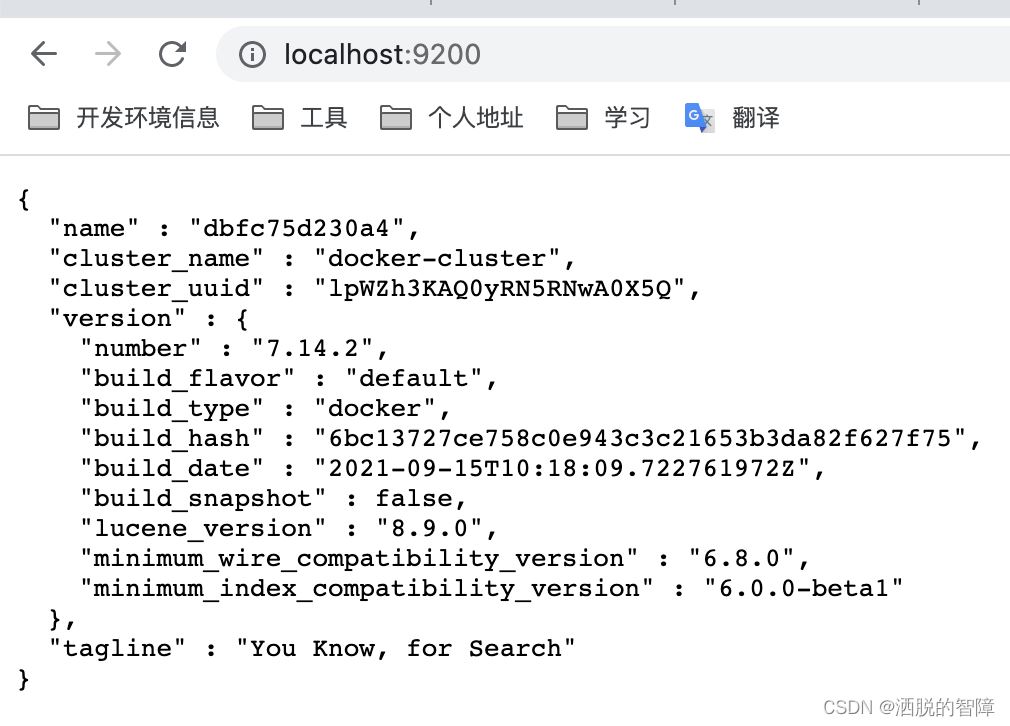

通过http://localhost:9200访问,可以看到如下信息,说明elasticsearch启动成功:

启动kibana,这边指定了elasticsearch的地址,不指定的话默认是http://elasticsearch:9200:

docker run -p 5601:5601 -e "ELASTICSEARCH_HOSTS=http://elasticsearch:9200" --name kibana --network elk -d kibana:7.14.2

启动完成之后,通过http://localhost:5601可以访问kibana:

启动logstash:

docker run -it -p 4560:4560 -p 4570:4570 -p 4580:4580 -v /Users/yuanzhihao/elk/logstash/logstash.conf:/usr/share/logstash/pipeline/logstash.conf --name logstash --network elk -d logstash:7.14.2

logstash对外开放了三个端口,这样可以将不同类型的日志投送到不同的端口,对日志进行分类管理,比如运行日志,安全日志,操作日志等等。同时还需要挂载一个logstash.conf配置文件,具体配置如下:

input {

tcp {

mode => "server" # 模式指定为server模式

host => "0.0.0.0" # server模式时 ip地址是本机

port => 4560 # 指定监听端口

codec => json_lines # 指定输入数据的解码器 使用json格式

type => info # 日志的类型

}

tcp {

mode => "server"

host => "0.0.0.0"

port => 4570

codec => json_lines

type => operation

}

tcp {

mode => "server"

host => "0.0.0.0"

port => 4580

codec => json_lines

type => security

}

}

output {

stdout {

codec => rubydebug # 可以在logstash控制台输出日志 默认就是rubydebug

}

if [type] == "info" {

elasticsearch {

hosts => "elasticsearch:9200"

index => "info-log-%{+YYYY.MM.dd}"

}

}

if [type] == "operation" {

elasticsearch {

hosts => "elasticsearch:9200"

index => "operation-log-%{+YYYY.MM.dd}"

}

}

if [type] == "security" {

elasticsearch {

hosts => "elasticsearch:9200"

index => "security-log-%{+YYYY.MM.dd}"

}

}

}

这边的input输入用到的是Logstash提供的一个TCP的一个插件,我新增了一个type表示日志的类型,有关于TCP插件的具体参数说明可以参考:https://www.elastic.co/guide/en/logstash/current/plugins-inputs-tcp.html

同时,Logstash配置文件中也是支持条件表达式的,参考:https://www.elastic.co/guide/en/logstash/current/event-dependent-configuration.html#conditionals,这边是对日志做了一个分类的处理,不同类型的日志对应不同的端口,然后在elasticsearch上面创建不同的索引。

也可以通过docker-compose的方式,启动elk,docker-compose.yml配置文件如下:

version: '2.2'

services:

elasticsearch:

image: elasticsearch:7.14.2

container_name: elasticsearch

environment:

- discovery.type=single-node

ports:

- 9200:9200

- 9300:9300

networks:

- elk

kibana:

image: kibana:7.14.2

container_name: kibana

depends_on:

- elasticsearch

environment:

- ELASTICSEARCH_HOSTS=http://elasticsearch:9200

ports:

- 5601:5601

networks:

- elk

logstash:

image: logstash:7.14.2

container_name: logstash

environment:

- node.name=es01

volumes:

- /Users/yuanzhihao/elk/logstash/logstash.conf:/usr/share/logstash/pipeline/logstash.conf

ports:

- 4560:4560

- 4570:4570

- 4580:4580

networks:

- elk

networks:

elk:

driver: bridge

通过命令启动,效果和上面docker启动一样

docker-compose -f docker-compose.yml up -d

Spring Boot工程配置

Spring Boot项目的maven的pom文件配置如下,需要添加logstash-logback-encoder依赖:

<dependency>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-starter-web</artifactId>

</dependency>

<dependency>

<groupId>org.projectlombok</groupId>

<artifactId>lombok</artifactId>

</dependency>

<dependency>

<groupId>net.logstash.logback</groupId>

<artifactId>logstash-logback-encoder</artifactId>

<version>6.6</version>

</dependency>

<dependency>

<groupId>org.springframework.cloud</groupId>

<artifactId>spring-cloud-starter-sleuth</artifactId>

</dependency>

在代码中添加日志打印:

/**

* @author yuanzhihao

* @since 2022/6/19

*/

@SpringBootApplication

@RestController

@Slf4j

public class Application {

private static final Logger operationLog = LoggerFactory.getLogger("operation");

private static final Logger securityLog = LoggerFactory.getLogger("security");

@GetMapping("/hello")

public String hello() {

log.info("hello info log");

operationLog.info("hello operation log");

securityLog.info("hello security log");

return "Hello elk demo";

}

public static void main(String[] args) {

SpringApplication.run(Application.class, args);

}

}

在resources目录下添加logback-spring.xml配置文件,根据日志类型输出到logstash开放出来的对应的端口:

<?xml version="1.0" encoding="UTF-8"?>

<configuration>

<include resource="org/springframework/boot/logging/logback/base.xml"/>

<springProperty scope="context" name="applicationName" source="spring.application.name"/>

<appender name="infoLogstash" class="net.logstash.logback.appender.LogstashTcpSocketAppender">

<destination>localhost:4560</destination>

<encoder charset="UTF-8" class="net.logstash.logback.encoder.LogstashEncoder">

<!--添加applicationName字段 -->

<customFields>{"applicationName":"${applicationName}"}</customFields>

</encoder>

</appender>

<appender name="operationLogstash" class="net.logstash.logback.appender.LogstashTcpSocketAppender">

<destination>localhost:4570</destination>

<encoder charset="UTF-8" class="net.logstash.logback.encoder.LogstashEncoder">

<customFields>{"applicationName":"${applicationName}"}</customFields>

</encoder>

</appender>

<appender name="securityLogstash" class="net.logstash.logback.appender.LogstashTcpSocketAppender">

<destination>localhost:4580</destination>

<encoder charset="UTF-8" class="net.logstash.logback.encoder.LogstashEncoder">

<customFields>{"applicationName":"${applicationName}"}</customFields>

</encoder>

</appender>

<logger name="operation" level="info">

<appender-ref ref="operationLogstash"/>

</logger>

<logger name="security" level="info">

<appender-ref ref="securityLogstash"/>

</logger>

<root level="INFO">

<appender-ref ref="infoLogstash"/>

<appender-ref ref="CONSOLE"/>

</root>

</configuration>

验证

查看logstash是否接收到日志

启动Spring Boot项目。可以看到logstash控制台会打印对应的日志,说明logstash已经接收到工程传过来的日志,logstash验证ok。

查看索引是否已经生效

访问http://localhost:9200/_cat/indices,这个可以查出来所有在elasticsearch上面创建的索引,可以看到我们的索引都已经生效了。

日志分析

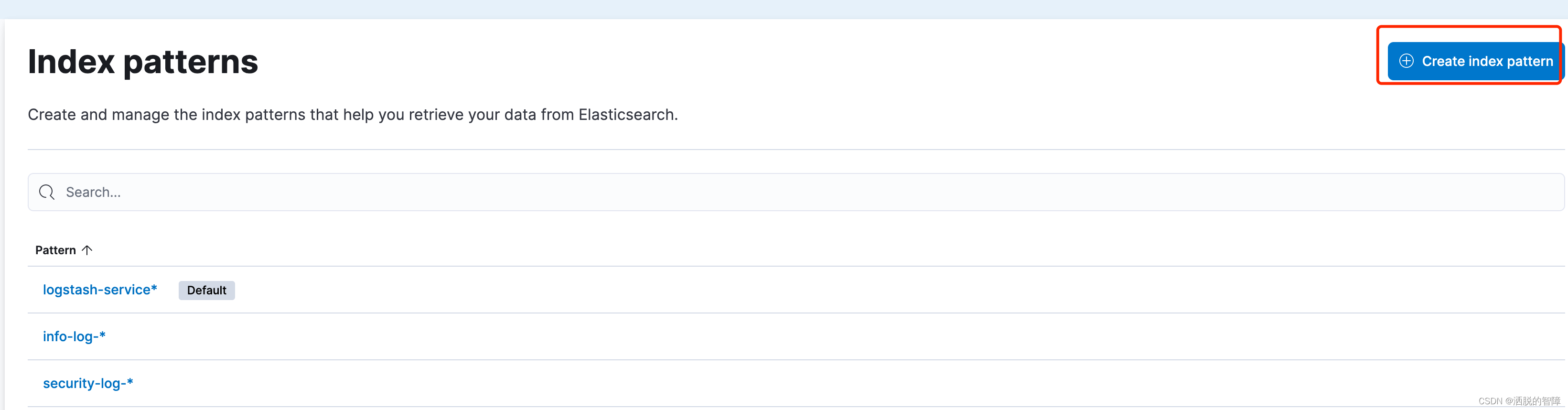

创建索引模式

访问http://localhost:5601/app/management/kibana/indexPatterns地址,选择右上角Create index pattern创建索引模式

输入索引名称,这边输入operation-log-*

之后在配置中选择@timestamp,并创建索引

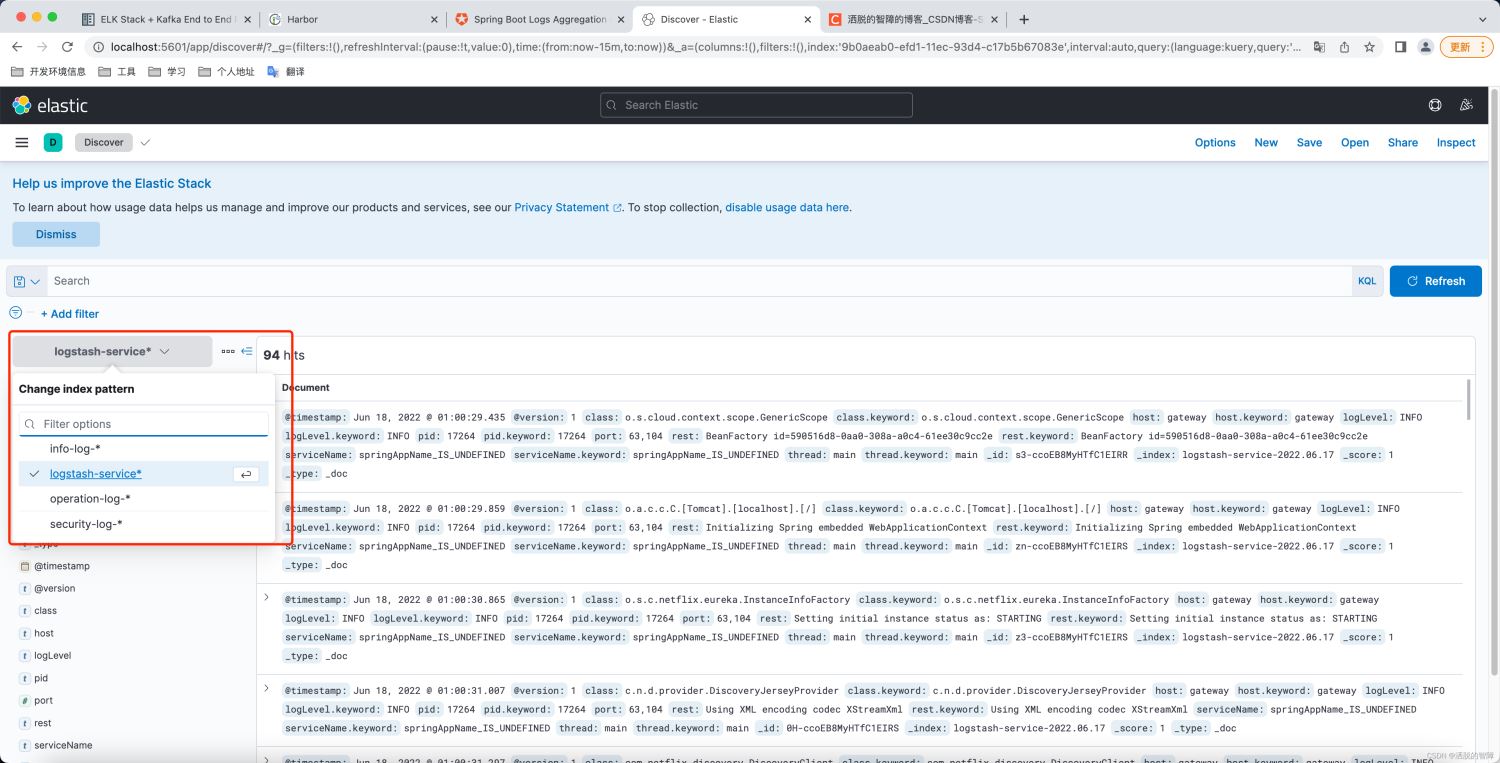

查看日志

转到http://localhost:5601/app/discover看板页面,可以看见我们创建的所有的索引,添加Filter可以对字段进行过滤,筛选出我们需要的日志信息。

结语

本次elk的整合的demo就到这边,这个也差不多是我们项目目前使用的场景了,比较简单。如果有问题可以留言。

参考地址:https://auth0.com/blog/spring-boot-logs-aggregation-and-monitoring-using-elk-stack

代码链接:https://github.com/yzh19961031/blogDemo/tree/master/elkDemo