Python的Scrapy框架解析

目录

- 一.为什么使用Scrapy框架?

- 二.Scrapy框架每个组件介绍

- 三.Scrapy框架工作原理

- 总结

一.为什么使用Scrapy框架?

Scrapy是一个快速、高层次的屏幕抓取和web抓取的框架,可用于数据挖掘、监测和自动化检测,任何人都可以根据需要去进行修改。

二.Scrapy框架每个组件介绍

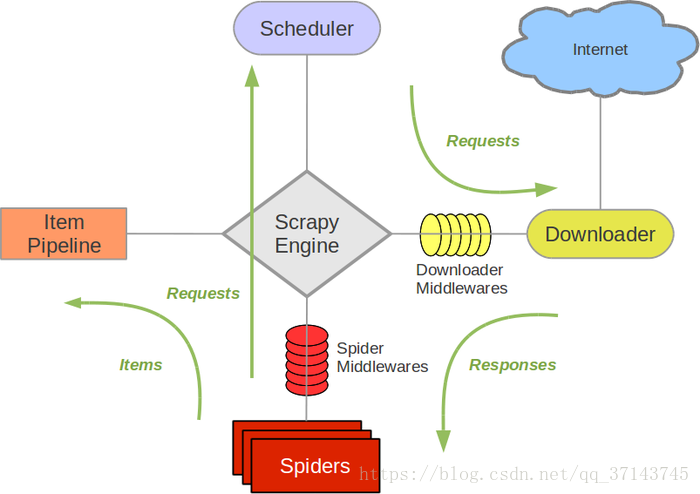

1.Scrapy引擎(Scrapy Engine):负责控制数据流在系统的所以组件中的流动,并在相应动作发生时触发事件。

2.调度器(Scheduler):从引擎接受reques并将其入队,便于以后请求它们提供给引擎。

3.下载器(Downloader):负责获取网页数据并且提供给引擎,然后提供给Spider。

4.Spiders: 指Scrapy用户编写用于分析response并且提取item或额外跟进的URL类人。每个Spider负责处理一些特定网站。

5.Item Pipeline:负责处理被Spider提取出来的item。典型的处理有清洁、验证及持久化

6.下载器中间件(Downloader Middlewares):指在引擎及下载器之间的特定钩子(specific hook),处理Downloader 传递给引擎的response。它提供一个简便的机制,通过插入自定义代码来扩展Scrapy功能。

7.Spiders中间件(Spider Middlewares):指在引擎及Spider之间的特定钩子(specific hook),处理Spider 的输入(response)和输出(items及requests)。它提供一个简便的机制,通过插入自定义代码来扩展Scrapy功能。

三.Scrapy框架工作原理

1.引擎向spider要URL

2.引擎将要爬取的URL给调度器

3.调度器会将URL生成请求对象放入指定的队列中

4.从队列中出队一个请求

5.引擎将请求交给下载器进行处理

6.下载器发送请求获取互联网数据

7.下载器将数据返回给引擎

8.引擎将数据再次给到spiders

9.spiders通过xpath解析该数据,得到数据或URL

10.spiders将数据或URL给到引擎

11.引擎判断该数据是URL还是数据,交给管道处理,URL交给调度器处理

12.当调度器里没有任何数据之后,整个程序停止

下面是我根据工作原理画的可以结合去看:

总结

本篇文章就到这里了,希望能够给你带来帮助,也希望您能够多多关注我们的更多内容!

相关推荐

-

python爬虫scrapy框架的梨视频案例解析

之前我们使用lxml对梨视频网站中的视频进行了下载,感兴趣的朋友点击查看吧. 下面我用scrapy框架对梨视频网站中的视频标题和视频页中对视频的描述进行爬取 分析:我们要爬取的内容并不在同一个页面,视频描述内容需要我们点开视频,跳转到新的url中才能获取,我们就不能在一个方法中去解析我们需要的不同内容 1.爬虫文件 这里我们可以仿照爬虫文件中的parse方法,写一个新的parse方法,可以将新的url的响应对象传给这个新的parse方法 如果需要在不同的parse方法中使用同一个item对象,可

-

python Scrapy框架原理解析

Python 爬虫包含两个重要的部分:正则表达式和Scrapy框架的运用, 正则表达式对于所有语言都是通用的,网络上可以找到各种资源. 如下是手绘Scrapy框架原理图,帮助理解 如下是一段运用Scrapy创建的spider:使用了内置的crawl模板,以利用Scrapy库的CrawlSpider.相对于简单的爬取爬虫来说,Scrapy的CrawlSpider拥有一些网络爬取时可用的特殊属性和方法: $ scrapy genspider country_or_district example.p

-

Python爬虫 scrapy框架爬取某招聘网存入mongodb解析

创建项目 scrapy startproject zhaoping 创建爬虫 cd zhaoping scrapy genspider hr zhaopingwang.com 目录结构 items.py title = scrapy.Field() position = scrapy.Field() publish_date = scrapy.Field() pipelines.py from pymongo import MongoClient mongoclient = MongoClien

-

Python的Scrapy框架解析

目录 一.为什么使用Scrapy框架? 二.Scrapy框架每个组件介绍 三.Scrapy框架工作原理 总结 一.为什么使用Scrapy框架? Scrapy是一个快速.高层次的屏幕抓取和web抓取的框架,可用于数据挖掘.监测和自动化检测,任何人都可以根据需要去进行修改. 二.Scrapy框架每个组件介绍 1.Scrapy引擎(Scrapy Engine):负责控制数据流在系统的所以组件中的流动,并在相应动作发生时触发事件. 2.调度器(Scheduler):从引擎接受reques并将其入队,便于

-

Python:Scrapy框架中Item Pipeline组件使用详解

Item Pipeline简介 Item管道的主要责任是负责处理有蜘蛛从网页中抽取的Item,他的主要任务是清晰.验证和存储数据. 当页面被蜘蛛解析后,将被发送到Item管道,并经过几个特定的次序处理数据. 每个Item管道的组件都是有一个简单的方法组成的Python类. 他们获取了Item并执行他们的方法,同时他们还需要确定的是是否需要在Item管道中继续执行下一步或是直接丢弃掉不处理. Item管道通常执行的过程有 清理HTML数据 验证解析到的数据(检查Item是否包含必要的字段) 检查是

-

Python利用Scrapy框架爬取豆瓣电影示例

本文实例讲述了Python利用Scrapy框架爬取豆瓣电影.分享给大家供大家参考,具体如下: 1.概念 Scrapy是一个为了爬取网站数据,提取结构性数据而编写的应用框架. 可以应用在包括数据挖掘,信息处理或存储历史数据等一系列的程序中. 通过Python包管理工具可以很便捷地对scrapy进行安装,如果在安装中报错提示缺少依赖的包,那就通过pip安装所缺的包 pip install scrapy scrapy的组成结构如下图所示 引擎Scrapy Engine,用于中转调度其他部分的信号和数据

-

python爬虫Scrapy框架:媒体管道原理学习分析

目录 一.媒体管道 1.1.媒体管道的特性 媒体管道实现了以下特性: 图像管道具有一些额外的图像处理功能: 1.2.媒体管道的设置 二.ImagesPipeline类简介 三.小案例:使用图片管道爬取百度图片 3.1.spider文件 3.2.items文件 3.3.settings文件 3.4.pipelines文件 一.媒体管道 1.1.媒体管道的特性 媒体管道实现了以下特性: 避免重新下载最近下载的媒体 指定存储位置(文件系统目录,Amazon S3 bucket,谷歌云存储bucket)

-

Python爬虫Scrapy框架IP代理的配置与调试

目录 代理ip的逻辑在哪里 如何配置动态的代理ip 在调试爬虫的时候,新手都会遇到关于ip的错误,好好的程序突然报错了,怎么解决,关于ip访问的错误其实很好解决,但是怎么知道解决好了呢?怎么确定是代理ip的问题呢?由于笔者主修语言是Java,所以有些解释可能和Python大佬们的解释不一样,因为我是从Java 的角度看Python.这样也便于Java开发人员阅读理解. 代理ip的逻辑在哪里 一个scrapy 的项目结构是这样的 scrapydownloadertest # 项目文件夹 │ ite

-

Python爬虫scrapy框架Cookie池(微博Cookie池)的使用

下载代码Cookie池(这里主要是微博登录,也可以自己配置置其他的站点网址) 下载代码GitHub:https://github.com/Python3WebSpider/CookiesPool 下载安装过后注意看网页下面的相关基础配置和操作!!!!!!!!!!!!! 自己的设置主要有下面几步: 1.配置其他设置 2.设置使用的浏览器 3.设置模拟登陆 源码cookies.py的修改(以下两处不修改可能会产生bug): 4.获取cookie 随机获取Cookies: http://localho

-

Python中Scrapy框架的入门教程分享

目录 前言 安装Scrapy 创建一个Scrapy项目 创建一个爬虫 运行爬虫 结论 前言 Scrapy是一个基于Python的Web爬虫框架,可以快速方便地从互联网上获取数据并进行处理.它的设计思想是基于Twisted异步网络框架,可以同时处理多个请求,并且可以使用多种处理数据的方式,如提取数据.存储数据等. 本教程将介绍如何使用Scrapy框架来编写一个简单的爬虫,从而让您了解Scrapy框架的基本使用方法. 安装Scrapy 首先,您需要在您的计算机上安装Scrapy框架.您可以使用以下命

-

在Linux系统上安装Python的Scrapy框架的教程

这是一款提取网站数据的开源工具.Scrapy框架用Python开发而成,它使抓取工作又快又简单,且可扩展.我们已经在virtual box中创建一台虚拟机(VM)并且在上面安装了Ubuntu 14.04 LTS. 安装 Scrapy Scrapy依赖于Python.开发库和pip.Python最新的版本已经在Ubuntu上预装了.因此我们在安装Scrapy之前只需安装pip和python开发库就可以了. pip是作为python包索引器easy_install的替代品,用于安装和管理Python

-

python爬虫scrapy框架之增量式爬虫的示例代码

scrapy框架之增量式爬虫 一 .增量式爬虫 什么时候使用增量式爬虫: 增量式爬虫:需求 当我们浏览一些网站会发现,某些网站定时的会在原有的基础上更新一些新的数据.如一些电影网站会实时更新最近热门的电影.那么,当我们在爬虫的过程中遇到这些情况时,我们是不是应该定期的更新程序以爬取到更新的新数据?那么,增量式爬虫就可以帮助我们来实现 二 .增量式爬虫 概念: 通过爬虫程序检测某网站数据更新的情况,这样就能爬取到该网站更新出来的数据 如何进行增量式爬取工作: 在发送请求之前判断这个URL之前是不是

随机推荐

- JS仿hao123导航页面图片轮播效果

- 六十一、NT网的无盘工作站远程登陆

- log4j2异步Logger(详解)

- asp.net 控件验证 FCKeditor

- document.designMode的功能与使用方法介绍

- asp.net访问网络路径方法(模拟用户登录)

- php接口数据加密、解密、验证签名

- 基于jquery循环map功能的代码

- win7下安装配置node.js+express开发环境

- 图片垂直居中之姊妹 DIV垂直居中

- sql2000各个版本区别总结第1/3页

- JQuery给select添加/删除节点的实现代码

- Nginx服务器搭建和基本配置详解

- C++中事件机制的简洁实现及需要放弃的特性

- C#对list列表进行随机排序的方法

- 深入探讨C++父类子类中虚函数的应用

- PHP实现的自定义数组排序函数与排序类示例

- vue-lazyload图片延迟加载插件的实例讲解

- React中使用外部样式的3种方式(小结)

- 60条Android开发注意事项与经验总结