Python编程快速上手——疯狂填词程序实现方法分析

本文实例讲述了Python疯狂填词程序实现方法。分享给大家供大家参考,具体如下:

题目如下:

- 创建一个疯狂填词程序,它将读入文件,并让用户在该文本文件中出现ADJECTIVE,NOUN,ADVERB,VERB等单词的地方,加上它们自己的文本。

- 例如源文本如下: The ADJECTIVE panda walked to the NOUN and then VERB. A nearby NOUN was unaffected by these events.

- 程序将找到这些出现的单词,提示用户取代他们

Enter an adjective:

silly

Enter a noun:

chandelier

Enter a verb:

screamed

Enter a noun:

pickup truck

思路如下:

- 程序需要做以下事情:

读入文本文件

在相应单词的地方让用户输入替换

保存修改后的文本文件,并将结果打印到屏幕 - 代码需要做以下事情:

导入模块re

编写函数,创建正则表达式对象

函数内调用Regex.findall()方法,返回匹配到的所有结果列表

打开文本文件,导入到变量

for循环控制输入

字符串replace方法进行替换

print()显示更改后的文本到屏幕

open.write()保存到新文件

代码如下:

import re

def madLibs(longStr):

madLibsRex = re.compile(r'ADJECTIVE|NOUN|ADVERB|VERB') #正则表达式对象

print(madLibsRex.findall(longStr)) #验证是否模式匹配正确

return madLibsRex.findall(longStr)

openFile = open('123.txt','r')

longStr = openFile.read() #将文本内容读入变量longStr

print("源文本如下:",longStr)

for i in madLibs(longStr): #循环遍历函数返回的匹配对象列表

print("Enter an {0}:".format(i))

longStr = longStr.replace(i,input()) #调用字符串的replace()方法输入替换,再赋值给longStr

print(longStr)

resultFile = open('new123.txt','w') #在当前工作目录创建一个新的文件

resultFile.write(longStr) #将字符串变量写入resultFile对象

openFile.close()

resultFile.close()

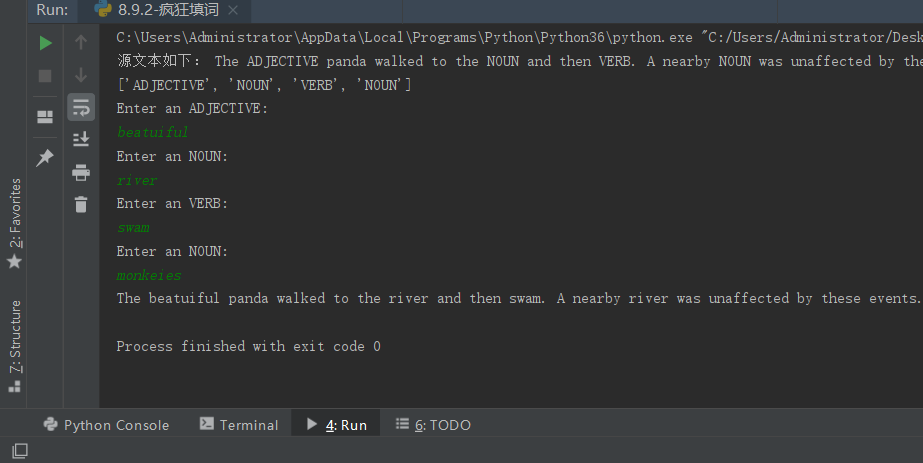

结果如下:

更多关于Python相关内容感兴趣的读者可查看本站专题:《Python数据结构与算法教程》、《Python列表(list)操作技巧总结》、《Python编码操作技巧总结》、《Python函数使用技巧总结》、《Python字符串操作技巧汇总》及《Python入门与进阶经典教程》

希望本文所述对大家Python程序设计有所帮助。

赞 (0)