分享4个最受欢迎的大数据可视化工具

想像阅读书本一样阅读数据流?这只有在电影中才有可能发生。 在现实世界中,企业必须使用数据可视化工具来读取原始数据的趋势和模式。

大数据可视化是进行各种大数据分析解决的最重要组成部分之一。 一旦原始数据流被以图像形式表示时,以此做决策就变得容易多了。 为了满足并超越客户的期望,大数据可视化工具应该具备这些特征:

· 能够处理不同种类型的传入数据

· 能够应用不同种类的过滤器来调整结果

· 能够在分析过程中与数据集进行交互

· 能够连接到其他软件来接收输入数据,或为其他软件提供输入数据

· 能够为用户提供协作选项

尽管实际上存在着无数专门用于大数据可视化的工具,且它们都是既开源又专有的,在这其中还是有一些工具表现比较突出,因为它们提供了上述所有或者很多部分功能。 我们将介绍4种最受欢迎的大数据可视化工具,帮助大家选择适合自己需求的工具。

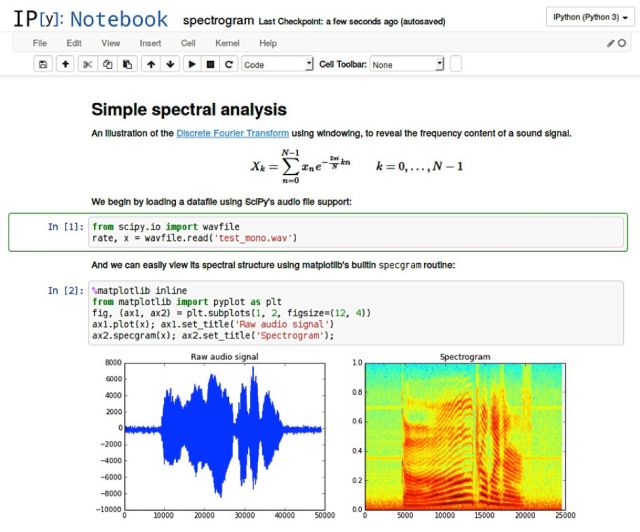

Jupyter:大数据可视化的一站式商店

JupyteR是一个开源项目,通过十多种编程语言实现大数据分析、可视化和软件开发的实时协作。 它的界面包含代码输窗口,并通过运行输入的代码以基于所选择的可视化技术提供视觉可读的图像。

但是,以上提到的功能仅仅是冰山一角。 Jupyter Notebook可以在团队中共享,以实现内部协作,并促进团队共同合作进行数据分析。 团队可以将Jupyter Notebook上传到GitHub或Gitlab,以便能共同合作影响结果。团队可以使用Kubernetes将Jupyter Notebook包含在Docker容器中,也可以在任何其他使用Jupyter的机器上运行Notebook。 在最初使用Python和R时,Jupyter Notebook正在积极地引入Java,Go,C#,Ruby等其他编程语言编码的内核。

除此以外,Jupyter还能够与Spark这样的多框架进行交互,这使得对从具有不同输入源的程序收集的大量密集的数据进行数据处理时,Jupyte能够提供一个全能的解决方案。

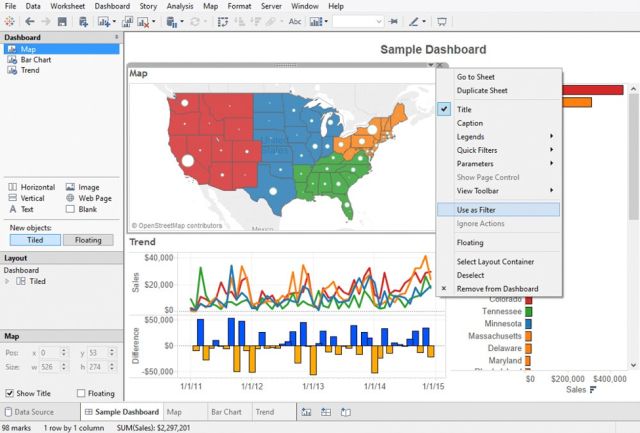

Tableau:AI,大数据和机器学习应用可视化的最佳解决方案

Tableau是大数据可视化的市场领导者之一,在为大数据操作,深度学习算法和多种类型的AI应用程序提供交互式数据可视化方面尤为高效。

Tableau可以与Amazon AWS,MySQL,Hadoop,Teradata和SAP协作,使之成为一个能够创建详细图形和展示直观数据的多功能工具。 这样高级管理人员和中间链管理人员能够基于包含大量信息且容易读懂的Tableau图形作出基础决策。

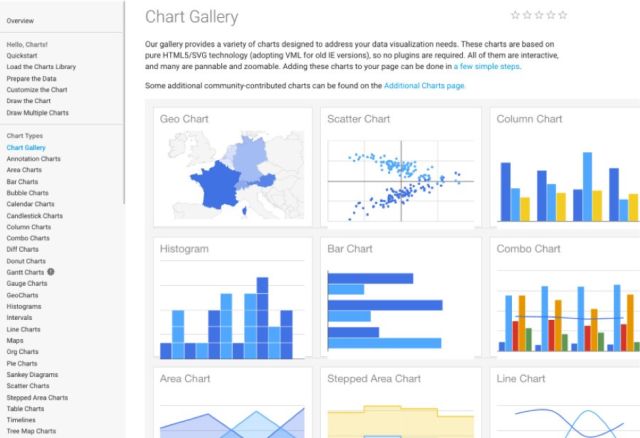

Google Chart:Google支持的免费而强大的整合功能

谷歌是当今领导力的代名词。正如谷歌浏览器是当前最流行的浏览器一样,谷歌图表也是大数据可视化的最佳解决方案之一,更不用说它是完全免费的,并得到了Google的大力技术支持。 为什么它能得到Google的支持? 因为通过Google Chart来分析的数据显然是要用于训练Google研发的AI,这样的合作对于各方来说都是双赢的。

Google Chart提供了大量的可视化类型,从简单的饼图、时间序列一直到多维交互矩阵都有。 图表可供调整的选项很多。如果需要对图表进行深度定制,可以参考详细的帮助部分。

该工具将生成的图表以HTML5 / SVG呈现,因此它们可与任何浏览器兼容。 Google Chart对VML的支持确保了其与旧版IE的兼容性,并且可以将图表移植到最新版本的Android和iOS上。 更重要的是,Google Chart结合了来自Google地图等多种Google服务的数据。 生成的交互式图表不仅可以实时输入数据,还可以使用交互式仪表板进行控制。

D3.js:以任何您需要的方式直观地显示大数据

D3.js代表Data Driven Document,一个用于实时交互式大数据可视化的JS库。 由于这不是一个工具, 所以用户在使用它来处理数据之前,需要对Javascript有一个很好的理解,并能以一种能被其他人理解的形式呈现。 除此以外,这个JS库将数据以SVG和HTML5格式呈现,所以像IE7和8这样的旧式浏览器不能利用D3.js功能。

从不同来源收集的数据如大规模数据将与实时的DOM绑定并以极快的速度生成交互式动画(2D和3D)。 D3架构允许用户通过各种附件和插件密集地重复使用代码.

最后的想法

以上提到的4种可视化工具只不过是大量在线或独立的数据可视化解决方案和工具中的一部分 。 每家公司都能够找到最适合他们的工具,并能够使用这些工具帮助他们将输入的原始数据转化为一系列清晰易懂的图像和图表。 这些数据本身没有任何价值,是借助可视化做的决策帮助它们实现驱动价值的 - -数据可视化工具有助于确定趋势和模式,从而做出有证据支持的决策。

总结

以上所述是小编给大家介绍的分享4个最受欢迎的大数据可视化工具 ,希望对大家有所帮助,如果大家有任何疑问请给我留言,小编会及时回复大家的。在此也非常感谢大家对我们网站的支持!

如果你觉得本文对你有帮助,欢迎转载,烦请注明出处,谢谢!