基于pytorch padding=SAME的解决方式

tensorflow中的conv2有padding=‘SAME'这个参数。吴恩达讲课中说到当padding=(f-1)/2(f为卷积核大小)时则是SAME策略。但是这个没有考虑到空洞卷积的情况,也没有考虑到strides的情况。

查阅资料后发现网上方法比较麻烦。

手算,实验了一个早上,终于初步解决了问题。

分为两步:

填充多少

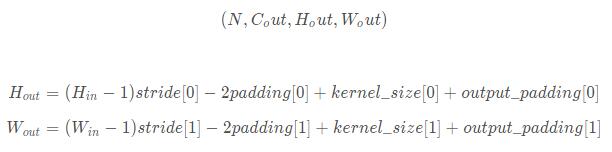

中文文档中有计算公式:

输入:

输出:

因为卷积后图片大小同卷积前,所以这里W_out=W_in, H_out=H_in。解一元一次方程即可。结果取ceil。

怎么填充

torch是先填充再卷积。conv2d的策略如此。所以我先在forward中获取上述方程需要的参数。然后使用torch.nn.functional.pad填充就好了。

然后

t2=torch.randn([1,1,4,4]) print(t2.size()) m1 = torch.nn.Conv2d(1, 1, 1, padding=(1,0)) print(m1(t2).size()) t2=F.pad(t2,(0,0,1,1)) print(t2.size())

有两个发现

pad是对称的两边都填充的,所以上述总共填充2行/列

参数中padding=(1,0)的效果,与F.pad(t2, (0,0,1,1)的效果一样。而不是与F.pad(t2,1,1,0,0)效果一样。很神奇。本来(1,0)按照解视是1是H边(左右)。0是W边(上下)。(0,0,1,1)按解释是左右不填充,上下填充。结果刚好相反。

这样应该就没什么问题了。

之后还需要看反卷积跟池化的pooling='SAME'是怎么实现的。

以上这篇基于pytorch padding=SAME的解决方式就是小编分享给大家的全部内容了,希望能给大家一个参考,也希望大家多多支持我们。

相关推荐

-

pytorch中使用cuda扩展的实现示例

以下面这个例子作为教程,实现功能是element-wise add: (pytorch中想调用cuda模块,还是用另外使用C编写接口脚本) 第一步:cuda编程的源文件和头文件 // mathutil_cuda_kernel.cu // 头文件,最后一个是cuda特有的 #include <curand.h> #include <stdio.h> #include <math.h> #include <float.h> #include "math

-

Pytorch maxpool的ceil_mode用法

pytorch里面的maxpool,有一个属性叫ceil_mode,这个属性在api里面的解释是 ceil_mode: when True, will use ceil instead of floor to compute the output shape 也就是说,在计算输出的shape的时候,如果ceil_mode的值为True,那么则用天花板模式,否则用地板模式. ??? 举两个例子就明白了. # coding:utf-8 import torch import torch.nn as

-

详解Python3中ceil()函数用法

描述 ceil(x) 函数返回一个大于或等于 x 的的最小整数. 语法 以下是 ceil() 方法的语法: import math math.ceil( x ) 注意:ceil()是不能直接访问的,需要导入 math 模块,通过静态对象调用该方法. 参数 x -- 数值表达式. 返回值 函数返回返回一个大于或等于 x 的的最小整数. 实例 以下展示了使用 ceil() 方法的实例: #!/usr/bin/python3 import math # 导入 math 模块 print ("math.

-

基于pytorch padding=SAME的解决方式

tensorflow中的conv2有padding='SAME'这个参数.吴恩达讲课中说到当padding=(f-1)/2(f为卷积核大小)时则是SAME策略.但是这个没有考虑到空洞卷积的情况,也没有考虑到strides的情况. 查阅资料后发现网上方法比较麻烦. 手算,实验了一个早上,终于初步解决了问题. 分为两步: 填充多少 中文文档中有计算公式: 输入: 输出: 因为卷积后图片大小同卷积前,所以这里W_out=W_in, H_out=H_in.解一元一次方程即可.结果取ceil. 怎么填充

-

基于IDEA2018卡死不动的解决方式(好用)

相信大多数人用IDEA开发的时候都会遇到卡顿或者直接卡死的情况,在IDEA2017.1版本之前idea启动是非常慢的,而IDEA2018版本的启动速度和内存占用以及使用流畅度都比IDEA2017好太多(本人亲测).所以版本更新是必要的.但当你更新版本后问题来了!请欣赏以下我呕心沥血的填坑过程! 当我装上IDEA2018的时候,只要打开点几下就会出现卡死的情况.于是各种换版本各种百度试了都不行,最后不得已换成IDEA2017.1的版本(我之前装的版本)才能使用,但又不甘心......(当时我的jd

-

Pytorch训练过程出现nan的解决方式

今天使用shuffleNetV2+,使用自己的数据集,遇到了loss是nan的情况,而且top1精确率出现断崖式上升,这显示是不正常的. 在网上查了下解决方案.我的问题是出在学习率上了. 我自己做的样本数据集比较小,就三类,每类大概三百多张,初始学习率是0.5.后来设置为0.1就解决了. 按照解决方案上写的.出现nan的情况还有以下几种: 学习率太大,但是样本数据集又很小.(我的情况) 自定义的loss除以了一个很小的数字,小到接近0. 数据不干净,数据本身就有nan,可以用numpy.isna

-

pytorch nn.Conv2d()中的padding以及输出大小方式

我就废话不多说了,直接上代码吧! conv1=nn.Conv2d(1,2,kernel_size=3,padding=1) conv2=nn.Conv2d(1,2,kernel_size=3) inputs=torch.Tensor([[[[1,2,3], [4,5,6], [7,8,9]]]]) print("input size: ",inputs.shape) outputs1=conv1(inputs) print("output1 size: ",outp

-

Pytorch GPU显存充足却显示out of memory的解决方式

今天在测试一个pytorch代码的时候显示显存不足,但是这个网络框架明明很简单,用CPU跑起来都没有问题,GPU却一直提示out of memory. 在网上找了很多方法都行不通,最后我想也许是pytorch版本的问题,原来我的pytorch版本是0.4.1,于是我就把这个版本卸载,然后安装了pytorch1.1.0,程序就可以神奇的运行了,不会再有OOM的提示了.虽然具体原因还不知道为何,这里还是先mark一下,具体过程如下: 卸载旧版本pytorch: conda uninstall pyt

-

基于spring boot 日志(logback)报错的解决方式

记录一次报错解决方法: No converter found capable of converting from type [java.lang.String] to type [java.util.Map<java.lang.String, java.lang.String>] org.springframework.boot.context.properties.bind.BindException: Failed to bind properties under 'logging.le

-

pytorch dataloader 取batch_size时候出现bug的解决方式

1. RuntimeError: invalid argument 0: Sizes of tensors must match except in dimension 0. Got 342 and 281 in dimension 3 at /pytorch/aten/src/TH/generic/THTensorMoreMath.cpp:1333 2. RuntimeError: invalid argument 0: Sizes of tensors must match except i

-

基于Python3.7.1无法导入Numpy的解决方式

开发环境:Pycharm 2018.3 + Anaconda3(5.3.0) + Python 3.7.1 + Numpy 1.15.4 在此环境下,我打算使用numpy模块的zeros方法创建一个空的二维List,却屡屡报错 Traceback (most recent call last): File "D:\Anaconda3\lib\site-packages\numpy\core\__init__.py", line 16, in <module> from .

-

基于SpringBoot构造器注入循环依赖及解决方式

1. 循环依赖是什么? Bean A 依赖 B,Bean B 依赖 A这种情况下出现循环依赖. Bean A → Bean B → Bean A 更复杂的间接依赖造成的循环依赖如下. Bean A → Bean B → Bean C → Bean D → Bean E → Bean A 2. 循环依赖会产生什么结果? 当Spring正在加载所有Bean时,Spring尝试以能正常创建Bean的顺序去创建Bean. 例如,有如下依赖: Bean A → Bean B → Bean C Spring

-

基于Keras 循环训练模型跑数据时内存泄漏的解决方式

在使用完模型之后,添加这两行代码即可清空之前model占用的内存: import tensorflow as tf from keras import backend as K K.clear_session() tf.reset_default_graph() 补充知识:keras 多个模型测试阶段速度越来越慢问题的解决方法 问题描述 在实际应用或比赛中,经常会用到交叉验证(10倍或5倍)来提高泛化能力,这样在预测时需要加载多个模型.常用的方法为 mods = [] from keras.ut

随机推荐

- VBS编程教程 (第5篇)

- "automation服务器不能创建对象”的问题的解决方案总结大全

- cygwin 在windows下使用linux命令的方法

- JavaScript实现的原生态Tab标签页功能【兼容IE6】

- bootstrap datepicker插件默认英文修改为中文

- php实现建立多层级目录的方法

- php采集速度探究总结(原创)

- 举例讲解Python中装饰器的用法

- MySQL中的唯一性约束与NULL详解

- node.js中的fs.linkSync方法使用说明

- Bootstrap入门书籍之(五)导航条、分页导航

- 功名看气宇

- jquery插件之easing 动态菜单

- 为jQuery添加Webkit的触摸的方法分享

- Android中实现Runnable接口简单例子

- Linux系统防CC攻击自动拉黑IP增强版(Shell脚本)

- 详解JAVA常用的时间操作【实用】

- 基于java swing实现答题系统

- JS实现的缓冲运动效果示例

- spring boot如何基于JWT实现单点登录详解